Обзор и тест Intel Arc A770 и Intel Arc A750. Сравнение с GeForce RTX 3060 и Radeon RX 6600 — i2HARD

Не переставая следить за выходцами конвейера видеокарт Intel, мы с надеждой взяли в руки новинки, именуемые ARC A750 и ARC A770. С момента обзора их младшей сестры А380 прошло 4 месяца, и нет, мы не запоздали с материалом, а дали фору intel на доработку драйверов. Не путайте.

Содержание:

- Характеристики Intel Arc A750/ A770

- Конкуренты и тестовый стенд

- Тестовый стенд

- Синтетические тесты

- Кодирование видео и кодек AV1

- Тесты в играх

- Тесты в играх с RTX

- Intel XeSS — аналог DLSS или FSR

- О системе охлаждения Arc A750 и Arc A770

- Заключение

Характеристики Intel Arc A750/ A770

Итак, что из себя представляют 700е Arc’и? По сравнению с A380 750-я имеет в 3.

Конкуренты и тестовый стенд

Позиционируются эти видеокарты как конкуренты RTX 3060. А750 в половине протестированных inel игр быстрее, но при этом дешевле, а 770-я, следовательно, производительней.

Поэтому в сравнение помимо RTX 3060 напрашивается RX 6600, как давно существующий более дешёвый конкурент из красного лагеря. Внешне новинки в исполнении intel limited edition выглядят приятно и похожи друг на друга с небольшим отличием: у старшей А770 есть подсветка — как же без неё?

В тестах за процессорную часть отвечает intel Core i5-13600K в разгоне с настроенной DDR5, остальные комплектующие перед вами. Resizable Bar включен для всех видеокарт, без него Arc’ам будет очень плохо, а остальным не повредит. Поэтому данные видеокарты подойдут не всем, а только владельцам более-менее современных систем.

Resizable Bar включен для всех видеокарт, без него Arc’ам будет очень плохо, а остальным не повредит. Поэтому данные видеокарты подойдут не всем, а только владельцам более-менее современных систем.

Тестовый стенд

- Видеокарта #1: Intel Arc A750 Limited Edition

- Видеокарта #2: Intel Arc A770 Limited Edition

- Видеокарта #3: INNO3D GeForce RTX 3060 ICHILL X3 RED

- Видеокарта #4: Gigabyte Radeon RX 6600 XT Eagle

- Процессор: Intel Core i5-13600KF

- Материнская плата: ASUS ROG Maximus Z690 Hero

- Оперативная память DDR5: A-Data XPG Caster RGB[AX5U6400C4016G-DCCARGY] 2×16 ГБ

- Система охлаждения: Arctic Cooling Liquid Freezer II-360

- Накопитель: Crucial MX500 2 TB

- Блок питания: HIGH POWER Astro GD-II 1200W

- Корпус: BC1 Open Benchtable

- Операционная система: Windows 11

Синтетические тесты

Начнём с приевшихся нам гигафлопсов в Aida GPGPU Benchmark. По ним RTX 3060 лидирует, с небольшим отставанием за ней идёт 770, затем 750 и на последнем месте RX 6600. В отличии от скорости копирования памяти, чтение и запись у Arc’ов снова далека от максимальной. 6600 имеет только восемь линий PCI, поэтому она почти в 2 раза медленней.

В отличии от скорости копирования памяти, чтение и запись у Arc’ов снова далека от максимальной. 6600 имеет только восемь линий PCI, поэтому она почти в 2 раза медленней.

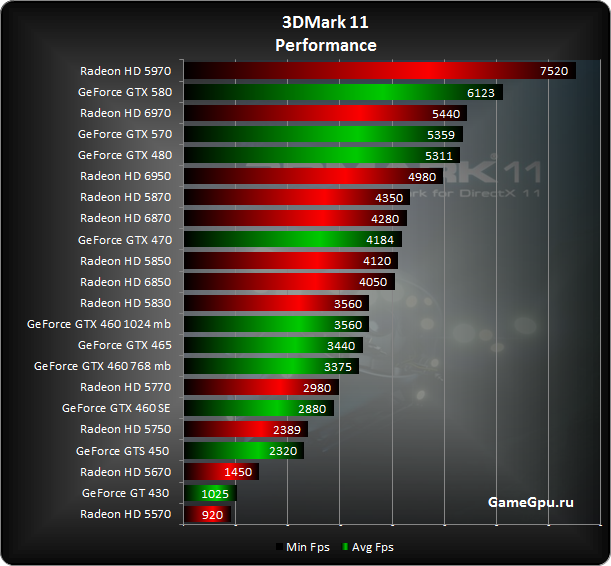

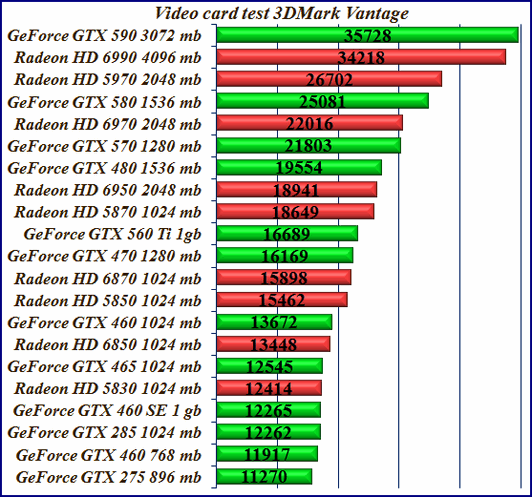

В 3DMark Firestrike intel’ы демонстрируют впечатляющие результаты, многообещающе намекая о мощностях под капотом.

В другом подтесте TimeSpy отрыв от 3060 увеличился ещё сильнее, а 6600 сильно просела, заняв последнее место.

Даже в тесте трассировки лучей 3060 не смогла сблизиться с Arc’ами, их доминирование неоспоримо. 6600 ожидаемо не может похвастаться своими результатами.

Рендер несложного проекта в Adobe Premiere Pro нас удивил. intel’ы снова на первом месте. Причём при наличии синего процессора со встроенной графикой процесс можно немного ускорить.

Однако в Davinci Resolve результат удручающий. Эти ребята явно не дружат. В то же время RX 6600 здесь себя явно лучше чувствует. Проект тот же самый, что и в премьере.

Кодирование видео и кодек AV1

И раз уж затронули тему рендера, поговорим ещё немного о кодировании видео, ведь intel первыми добавили аппаратное кодирование AV1.

И в Davinci реализована его поддержка. Премьер с таким кодеком даже не знаком, но куда интересней его реализация для стриминга. Недавно в бета версии OBS как раз добавили h365 и AV1 для QuickSync — кодировщика intel. Пока это реализовано только для записи, но наличие движения в эту сторону — уже хорошо.

Что плохо, так это реализация. Перед вами запись одного и того же футажа в Quad HD разрешении с максимальным пресетом качества и битрейтом 25 Мбит/сек. Ни h365, ни AV1 практически неотличимы от h364, разница может возникнуть из-за несинхронизированных i-кадров и невозможности отключить B-кадры в h365 и AV1 кодеках.

Маленькая разница — это лишь полбеды. Реальная проблема заключена в том, что все варианты ужасны. Для понимания достаточно заменить оригинальный футаж на кодированный тем же методом, но встроенной в процессор графикой intel. Тут даже приглядываться не нужно, чтобы найти разницу.

К слову, такая же проблема с качеством возникает, если с помощью этой встройки записывать кодеком h365. Остаётся надеяться, что в ближайшее время, а в идеале в релизной версии OBS это всё исправят. Но на данный момент Arc’и неконкурентоспособны.

Остаётся надеяться, что в ближайшее время, а в идеале в релизной версии OBS это всё исправят. Но на данный момент Arc’и неконкурентоспособны.

В свою очередь между кодировщиком красных и зелёных есть одна кардинальная разница, из-за которой возникает большая часть отличий в изображении. Заключается она в распределении битрейта. В то время как Nvenc старается равномерно распределить битрейт по всем кадрам, AMD гораздо больше выделяет его для I-кадра, а последующим P-кадрам достаётся уже сильно меньше. Из-за этого возникает большая разница при обновлении последовательности. Вот пример: перед вами последний P-кадр перед новым I-кадром. Разница в качестве существенна.

В то время как на Nvidia она не так заметна.

Что это значит? То, что в динамической сцене первые секунды будет преимущество за AMD, но далее качество будет быстро теряться, в то время как у Nvidia оно поддерживается на одном уровне.

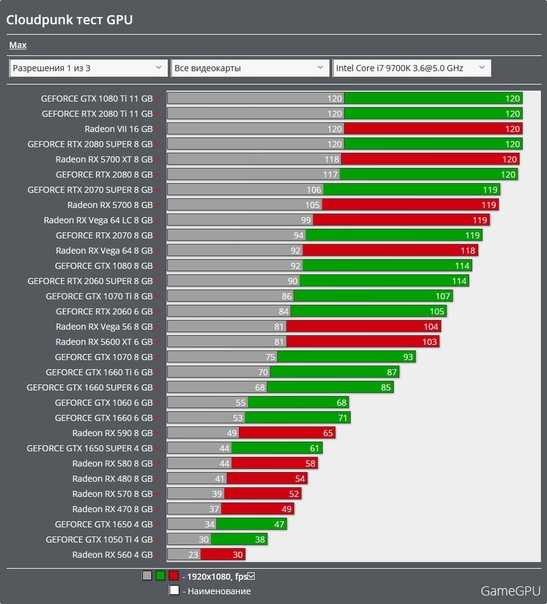

Тесты в играх

Переходим к играм. Киберпанк, пресет ультра, FSR отключен, 1080p, затем будет 1440p, а ближе к концу отдельно оценим трассировку. По тестам intel в этой игре выходило около 10% преимущества А750 над 3060, по факту она выглядит сильно слабее. RTX более чем на 20% превосходит А770, что уж там про 750 говорить. Даже RX 6600, к которой игра относится недружелюбно, быстрее.

По тестам intel в этой игре выходило около 10% преимущества А750 над 3060, по факту она выглядит сильно слабее. RTX более чем на 20% превосходит А770, что уж там про 750 говорить. Даже RX 6600, к которой игра относится недружелюбно, быстрее.

Повышаем разрешение до Quad HD. На удивление, Arc’и просели заметно слабее других видеокарт. Благодаря этому теперь А750 наравне с 3060 по среднему FPS, а отставание рыксы от соперников только увеличилось.

Far Cry 6, ультра пресет, HD-текстуры отключены, как и трассировка. Снова игра из списка тестируемых intel, и по их замерам 3060 примерно на 5% быстрее, но в нашем случае снова результаты другие: отрыв 3060 составляет 13%, а 5%-я разница как раз-таки с А770. RX 6600 лидирует, причём не столько по среднему FPS, сколько по стабильности. У 3060 часто возникают статтеры в случайное время.

В Full HD разрешении почти на 44% меньше пикселей по сравнению с Quad HD, однако FPS падает не так сильно. Опять же, на Arc’ах слабее всего, а на рыксе сильнее. И из-за статтеров, которые есть и за пределами бенчмарка, 3060 подчистую проигрывает всем в плане комфортности геймплея.

И из-за статтеров, которые есть и за пределами бенчмарка, 3060 подчистую проигрывает всем в плане комфортности геймплея.

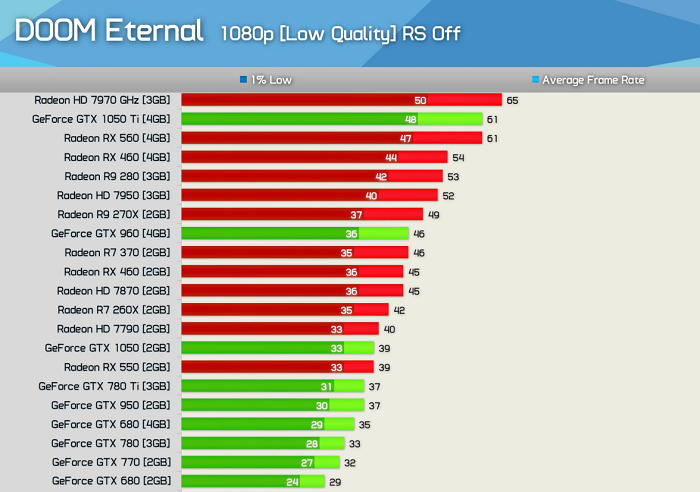

Doom Eternal, ультра кошмарный пресет, fov 120. Великолепный FPS демонстрируют все видеокарты, причём в лидерах Arc A770. При этом синие видеокарты недогружены. Понятное дело, что виноват не процессор. Это либо неточность мониторинга, либо не оптимизированность драйвера данных видеокарт. То бишь они ещё и не весь свой ресурс задействовали.

В 1440р потребление видеопамяти подошло вплотную к 8-Гбайтной границе, что может вызвать проблемы в других сценах. В первый раз мы по неосторожности не перезапустили игру после смены разрешения и получили существенную просадку по FPS. Так что даже при небольшой нехватке 8-Гбайтные видеокарты сразу окажутся в аутсайдерах, особенно рыкса с её 8-ю линиями PCI Express.

Assassins Creed Valgalla, максимальный графический пресет. По данным intel А750 на 10% отстаёт от 3060 в этой игре, но вы наблюдаете куда большую разницу. Может, у них какой-то особенный драйвер был на тот момент? Удивительно, что 3060 лидирует в асассине, ведь до выхода драйвера под 4000 серию красные видеокарты всегда были быстрее.

Может, у них какой-то особенный драйвер был на тот момент? Удивительно, что 3060 лидирует в асассине, ведь до выхода драйвера под 4000 серию красные видеокарты всегда были быстрее.

Повышение разрешения в очередной раз оказало самый негативный эффект на рыксу, однако и на А750 стали возникать непонятные всплески на фреймтайме. Является ли это попыткой игры уместить данные в 8 Гбайтах видеопаямти или очередным следствием слабой оптимизации — неясно, ведь на 6600 с таким же объёмом VRAM фреймтайм спокоен.

CS:GO, минимальные настройки, максимальное сглаживание. DirectX 9 сложно даётся Arc’ам, однако по сравнению с A380 700-е Arc’и слабее соперников не в 2 раза, а на привычные 20%. Также присутствуют участки с упором в процессор, поэтому можете пошутить, что 13600K не может раскрыть даже 3060.

Впервые понижение разрешения оказало самое негативное влияние на intel’ы. Правда причиной был частый упор в процессор с 3060 и 6600. Удивительно, что в старейшем API RX 6600 обходит 3060 по двум из трёх показателей.

Hunt Showdown, низкий пресет, качество текстур и объектов высокое, FoV 100. Снова Arc’и недогружены, причём это видно и по энергопотреблению, которому далеко до 190 Ваттного лимита. В то же время и рыкса, и 3060 упираются в свои ограничения по потреблению и имеют заметно больший FPS.

В высоком разрешении будто внутреннее распределение нагрузки у Arc’ов становится равномерней, за счёт чего они не так сильно теряют FPS и, как следствие, имеют меньшее отставание от соперников.

Halo Infinite, низкий пресет графики, высокое качество текстур, FoV 120. Взяли эту игру, потому что А380 имела непонятные периодические просадки, и похоже в этот раз мы нашли причину их возникновения. Вода либо отражения в ней убивают Arc’и. FPS на таких участках в 3 раза ниже, чем у 3060. А контрольным в голову выступают сильные статтеры, маскирующиеся под сочетания длинный-короткий кадр.

Во всём нужно искать свои плюсы! В 1440р FPS на Arc’ах упал на жалкие 5%, похоже, в 4K intel’ы будут ещё ближе к 3060 и 6600.

Call of Duty: Warzone 2.0, минимальный пресет, высокое разрешение текстур, FoV 120. Сочетания длинный-короткий кадр есть на всех видеокартах, но на Arc’ах их на порядок больше и среди них прячутся реальные статтеры. Помимо этого FPS здесь заметно ниже, чем у 3060 или 6600, являющейся безоговорочным лидером в этой игре.

Колда любит резервировать как можно больше видеопамяти, поэтому реально необходимое значение сложно понять. Вроде на А750 и RX 6600 ещё 700 МБ свободно, но отрыв А770 от младшенькой увеличился.

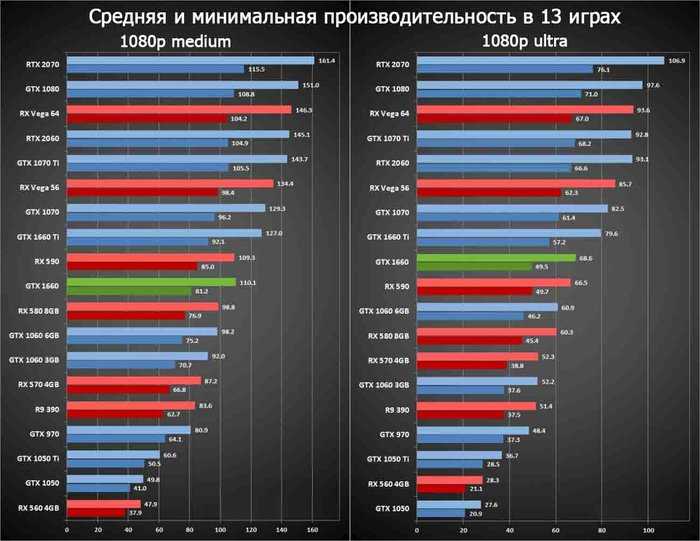

Возвращаемся к одиночным играм. Dying Light 2, пресет: высокое качество, DirectX 12. Впервые наши тесты совпали с тестами intel. По их замерам А750 немногим более 10% быстрее, чем 3060, как и у нас. А770 так и вовсе опережает её на 21%. 3060 и 6600 между собой, можно сказать, равны.

Совпадение ли? В игре, где Arc’и себя хорошо показали, повышение разрешения изображения приводит почти к той же потере FPS, что и у оппонентов. А750, похоже, потеряла больше из-за нехватки видеопамяти.

Red Dead Redemption 2, наивысший пресет, вулкан. На этот раз А750 сулят около 15% преимущества над 3060. У нас вышло меньше, но в целом схожая разница.

Все видеокарты слабо просели после перехода в Quad HD, но для Arc’ов, как и в прошлой игре, потеря FPS сопоставима с рыксой.

God of War, ультра пресет. Все видеокарты выдают ровный фреймтайм с FPS в районе 60, но можно сказать, что мощь Arc’ов не используется; это следует из их низкого энергопотребления и уступающего соперникам FPS.

Как и в ассассине, при переходе в Quad HD у А750 фремтайм превратился в рисунок сейсмографа. Геймплейно это не ощущается, но настораживает. FPS просел слабее, чем на 3060, поэтому А770 обошла её на 1-2 FPS по всем показателям.

Ведьмак 3, ультра пресет, DirectX 12. Сладкое оставили напоследок. Arc’и доминируют над 3060 и 6600. По энергопотреблению тоже видно, что они не мухлюют, а вовсю пашут. Стоит ли верить в то, что при должной оптимизации именно так должен выглядеть баланс Arc’ов на фоне соперников хотя бы в играх на DirecX12?

Как и ожидалось, повышение разрешения негативней всего повлияло на intel’овские видеокарты. Это если судить по среднему FPS. У 3060 периодически стали проскакивать статтеры, которых не было в Full HD.

Это если судить по среднему FPS. У 3060 периодически стали проскакивать статтеры, которых не было в Full HD.

Несмотря на схожий внешний вид, А750 при меньшем энергопотреблении греется сильнее, чем А770, особенно её видеопамять.

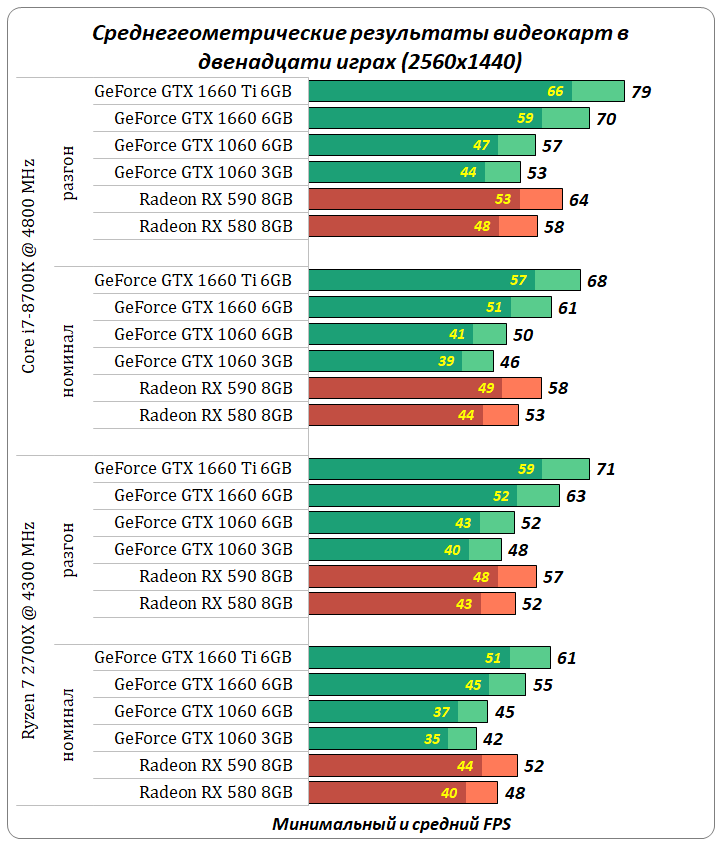

В среднем по 12 играм ни о каком равенстве и паритете между А750 и RTX 3060 речи быть не может. Даже в Quad HD 3060 на 15% быстрее.

Тесты в играх с RTX

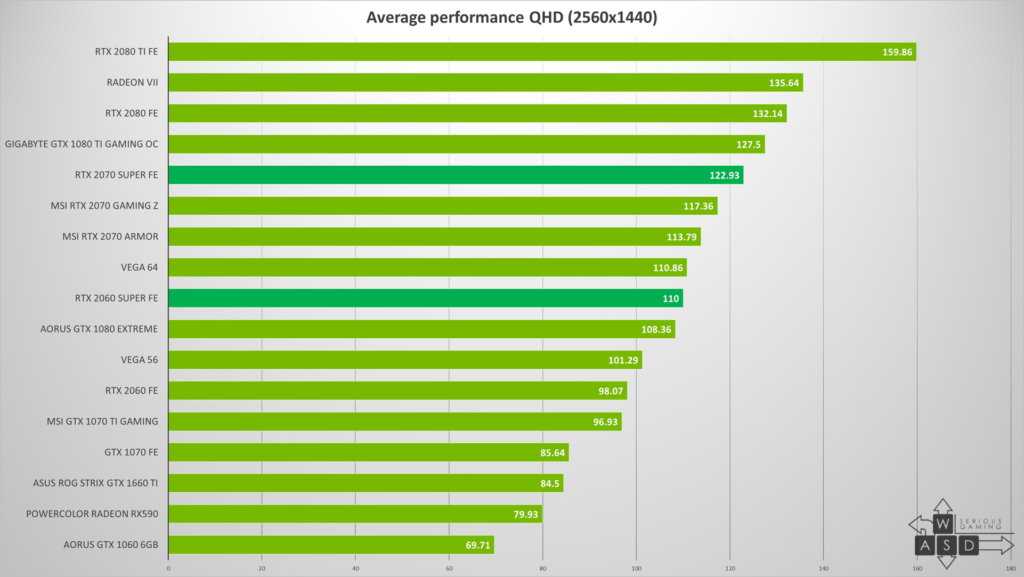

Теперь давайте рассмотрим RTX. Ограничимся Full HD разрешением.

Переключаем в киберпанке пресет на трассировка лучей ультра, FSR отключаем. Что на 3060, что на Arc’ах FPS упал немногим более чем в 2 раза, на 6600 более чем в 4 раза. Ну, вы и так знали, что это не её стихия, к тому же видеопамяти не хватает. На А750 каким-то чудом влезло.

В Far Cry 6 аналогично у Arc’ов такая же потеря FPS, как у 3060, а рыкса просела сильнее всех. Что интересно, у 3060 с лучами пропали статтеры.

В DOOM’e снова одинаковая просадка у 3060 и 700-х Arc’ов, в районе 30%, а 6600 стала отрисовывать почти в 2 раза меньше FPS.

В Dying Light 2 мы выбрали самый сложный пресет с высоким качеством трассировки, а FSR отключили. Как следствие, на Arc’ах FPS упал более чем в 2 раза, у 3060 на 58%, а 6600, как и в киберпанке, замедлилась более чем в 4 раза.

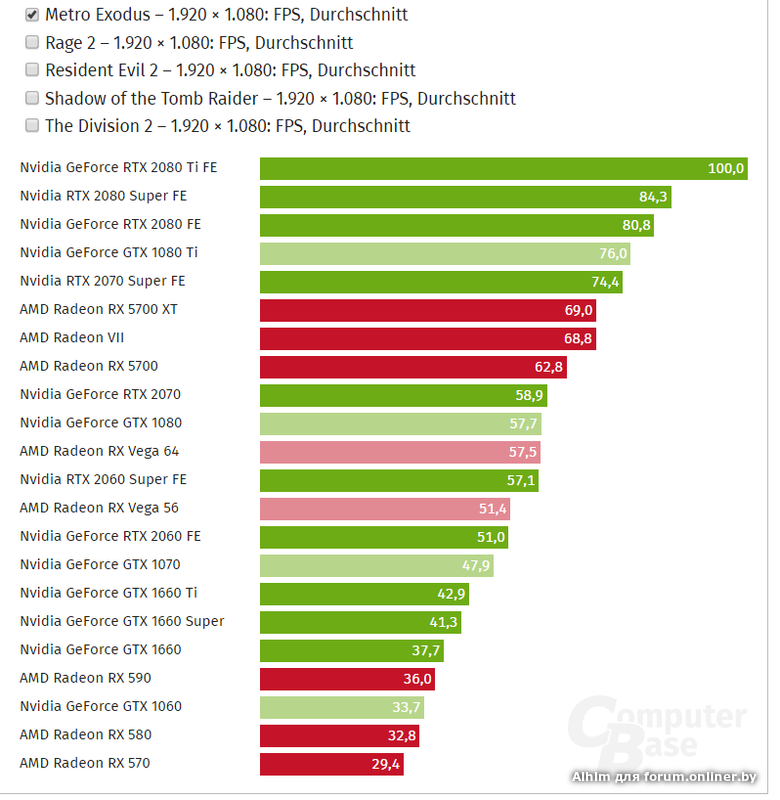

Metro Exodus, экстремальный пресет, трассировка на ультра. Внезапно А750 отрисовывает на целых 35% больше кадров в секунду, чем RTX 3060, однако не стоит воспринимать эти числа всерьёз. Если присмотреться, картинка выглядит совсем иначе и вполне возможно, что intel’овские видеокарты просто что-то не обрабатывают, за счёт чего и быстрее.

Intel XeSS — аналог DLSS или FSR

Под конец затронем Intel Xess — аналог DLSS и FSR. Его принцип очень похож на технологию зелёных, в нём также используются нейронные сети для масштабирования изображения из низкого разрешения с последующим сглаживанием с помощью TAA.

Но в отличии от DLSS он может работать на любых графических ускорителях с поддержкой инструкций DP4a. Список игр с Xess на сегодняшний день небольшой, так что особо задерживаться слишком долго не будем.

Call of duty modern warfare 2, кастомный пресет графики, 1440p. Между собой пресеты качества отличаются настолько слабо, что порой вообще не видно разницы. Без приближения она отчётливо видна только в двух местах. Первое — это асфальт возле люка. Пресеты баланс и производительность сильно смазали как сам асфальт, так и люк.

Далее также прослеживается детализация на земле. Второй сценарий — различные решётки, на которых возникает рябь, сила которой соответствует пресету.

Однако если сравнивать с другими апскейлерами, то XESS сразу же проигрывает. Тот же люк выглядит хуже всего именно с ним, уступая даже первой версии FSR. У DLSS по умолчанию сильно выкручен шарпинг, поэтому он лидирует по ощущению детализации, но это уже на любителя.

Решётка с ним не рябит, чего не добиться изменением резкости на других апскейлерах.

Но это ещё полбеды. Прирост производительности от XESS смешной. Режим ультра качества, проигрывающий FSR, не даёт прироста, и лишь в режиме производительность FPS тот же, что у FSR с ультра качеством. Поэтому подробное сравнение стоит отложить до лучших времён.

Поэтому подробное сравнение стоит отложить до лучших времён.

О системе охлаждения Arc A750 и Arc A770

Референсное исполнение системы охлаждения можно назвать своеобразным. Видеокарты выглядят стильно, при этом они небольшие и плотно укомплектованы. Радиатор занимает почти всё свободное пространство. Под ним находится немаленькая испарительная камера с четырьмя 8-мм теплотрубками, а обдувается всё это дело двумя 90 мм вентиляторами.

Видеокарту шумной не назвать, но под нагрузкой её слышно, дроссели тоже. Главным её минусом является дизайн конструкции. Вам нужно чуть ли не полностью разобрать видеокарту, чтобы заменить вентилятор. А деталей здесь очень много, причём часть из них на клею. Приятного в этом мало.

По эффективности данная система охлаждения звёзд с неба не хватает. Даже в играх при одинаковом с 3060 энергопотреблении A750 была горячее при площади кристалла в 1.5 раза больше.

Заключение

Если подытожить, то в целом, intel’ы имеют высокую потенциальную производительность как в классической растеризации, так и в трассировке, в которой они на уровне Nvidia. Имеется ввиду, сколько в процентах теряется FPS от её включения. Но без должной реализации всё это не будет работать — это самый большой камень в сторону синих. Без нормальных драйверов смешно называть A750 или A770 конкурентом RTX 3060. На её фоне в большинстве игр есть к чему придраться.

Имеется ввиду, сколько в процентах теряется FPS от её включения. Но без должной реализации всё это не будет работать — это самый большой камень в сторону синих. Без нормальных драйверов смешно называть A750 или A770 конкурентом RTX 3060. На её фоне в большинстве игр есть к чему придраться.

В киберпанке, DOOM’e, асассине и контре просто ниже FPS. Far Cry 6 сильно лагает в главное меню. На 3060 эта проблема тоже есть, но не в такой степени. В ханте постоянные статтеры и на ровном месте проседает FPS одновременно с частотой чипа. Что это такое вообще?

В варзоне статтеры, в Halo Arc’и буквально садятся в лужу. В боге войны первую минуту чрезвычайно низкий FPS. Это она так буферизируется или что? Шейдеры кэширует?

В ведьмаке вместо пламени какие-то фейерверки, и вряд ли это новогодний ивент — для других видеокарт его не завезли.

По какой-то причине может FPS вырасти на треть спустя несколько минут геймплея. Выходит, по началу видеокарта работает не на полную мощность?

В метро тоже лагает главное меню, а в самой игре трассировка работает некорректно.

Один раз мы свернули игру и по возвращению увидели как за несколько секунд она пришла к этому виду.

Хотели добавить в тесты технодемку на Unity, но в ней куча артефактов, пропадают волосы, и снова не отображается пламя.

Вечерком мы как-то решили поиграть в простенькую игрушку, и даже в ней intel вставляет палки в колёса, меняя курсор на непонятно что.

За пределами игр тоже есть проблемы. В обзоре Arc A380 мы рассказывали про их фирменное ПО Arc Control. Ничего не изменилось, всё те же баги и недоработки. Ладно, OBS не готов к intel’овским видеокартам, но почему они сами не дают возможность записать качественно? Максимальный битрейт смешной, жалкие 13 Мбит/сек, ещё и 60 FPS максимум при 1080р, AV1 выбрать можно, но записывать не записывает.

Соответственно, ни о каком высококачественном стриминге или записей для YouTube речи быть не может, а нашу карту захвата Avermedia Arc’и вообще в штыки воспринимают. Даже если она идёт в качестве второго экрана, то порой при загрузке компьютера изображения нет нигде. Количество разрешений и частота обновления тоже ограничены. Из доступных с какими-то она не передаёт изображения, а в каких-то цветовая палитра ломается. В случайный момент вся система может потухнуть и самопроизвольно перезагрузиться. Звук через HDMI не передаётся на карту захвата, а при выводе на монитор через DisplayPort после минуты тишины звук первые две секунды не воспроизводится. Причём этого не было на А380. К слову, энергопотребление на рабочем столе с одним 144 Гц монитором у Arc’ов по-прежнему высокое, оно не даёт видеокартам остыть и остановить вентиляторы.

Количество разрешений и частота обновления тоже ограничены. Из доступных с какими-то она не передаёт изображения, а в каких-то цветовая палитра ломается. В случайный момент вся система может потухнуть и самопроизвольно перезагрузиться. Звук через HDMI не передаётся на карту захвата, а при выводе на монитор через DisplayPort после минуты тишины звук первые две секунды не воспроизводится. Причём этого не было на А380. К слову, энергопотребление на рабочем столе с одним 144 Гц монитором у Arc’ов по-прежнему высокое, оно не даёт видеокартам остыть и остановить вентиляторы.

Радостная новость: intel’ы подружили видео с кодеком h365 и Media Player Classic, осталось артефакты у субтитров убрать.

И с этим всем мы столкнулись буквально за пару дней использования на обеих видеокартах. То бишь это не косяки одного экземпляра.

Разгон. Про него не сказали. Работает он чуть иначе, чем на A380. Разгон видеопамяти не завезли, а чип гонится из рук вон плохо. Максимально стабильное значение смещения буста для А750 было равно всего 25, дальше только через повышение напряжение, а с ним резко возрастает энергопотребление, и повышенный до 228 Вт лимит мощности не заставляет себя долго ждать, что делает разгон нецелесообразным. Кстати, на официальном сайте intel для А750 указан TBP в 225 Вт. Что не совпадает ни со стоковым лимитом в 190 Вт, ни с повышенным.

Кстати, на официальном сайте intel для А750 указан TBP в 225 Вт. Что не совпадает ни со стоковым лимитом в 190 Вт, ни с повышенным.

И вот кому нужна такая видеокарта? Играть не вариант, когда половина игр с проблемами. Да, она быстро рендерит видео в Adobe Premiere Pro, может тогда для бюджетного монтажного компьютера подойдёт? Но и тут тоже неясно, ведь насмотревшись на различные баги вполне ожидаешь их встретить в неподходящем месте. Да и аномально низкое качество, что мы встретили в OBS, возникло и тут. Возможно, поэтому и быстрее рендерит.

В ритейле A750 не продаётся, разве что на озоне можно заказать из-за границы, но за эти деньги вы там же 3060 можете взять.

На NewEgg она и правда дешевле на $80, но стоит ли оно тех проблем?

Так что более бюджетной альтернативой для 3060 была и будет RX 6600. Да, рендерит медленно, слаба в трассировке и мало видеопамяти с урезанной шиной, зато проблем на порядок меньше. Будем надеяться, что маленькая и бедная компания intel сможет освоить собственный продукт, ведь потенциала в нём ого-го. Только представьте, насколько другими ощущались бы эти видеокарты, будь у них хорошие драйверы. Остаётся верить и надеяться.

Только представьте, насколько другими ощущались бы эти видеокарты, будь у них хорошие драйверы. Остаётся верить и надеяться.

GeForce GTX 860M | Обзор и тестирование видеокарт NVIDIA

Игровая видеокарта для ноутбуков NVIDIA GeForce GTX 860M построена на новой архитектуре Maxwell. Новая микроархитектура носит имя известного математика и основателя современной классической электродинамики Джеймса Клерка Максвелла. Основным её преимуществом можно назвать пониженное потребление энергии при сохранении высокой производительности видеокарты. Вполне понятно, что в первую очередь это актуально для графических адаптеров игрового класса. Высокие мощности мобильных игровых видеокарт всегда были причиной сильного нагревания ноутбука. И вот, новый Maxwell призван изменить устоявшееся положение.

GeForce GTX 860M в своём основании имеет чип GM107, выполненный по 28-нм технологии и имеющий 640 шейдерных блока, который мы также встречаем у младшей GTX 850M. Но в отличие от 850-й модели GeForce GTX 860M имеет повышенную тактовую частоту ядра — 1029 МГц. Также новую серию производитель не лишил уже известной нам технологии GPU Boost 2.0, которая позволяет «разгонять» видеокарту при допустимой температуре. Максимальная возможность разгона для данной модели составляет 1085 МГц. Новый графический адаптер имеет тип памяти GDDR5 и пропускную способность шины 128 бит. Как и все модели топового класса 800-й серии, рассматриваемая видеокарта поддерживает новую технологию Battery Boost, созданную для максимального увеличения автономной работы ноутбука в игровом режиме. Также новинка поддерживает DirectX 11.2 и известные технологии NVIDIA — Optimus, Adaptive VSync, GeForce Experience, FXAA, TXAA, PhysX, Direct Compute, Blu-Ray 3D и SLI.

Также новую серию производитель не лишил уже известной нам технологии GPU Boost 2.0, которая позволяет «разгонять» видеокарту при допустимой температуре. Максимальная возможность разгона для данной модели составляет 1085 МГц. Новый графический адаптер имеет тип памяти GDDR5 и пропускную способность шины 128 бит. Как и все модели топового класса 800-й серии, рассматриваемая видеокарта поддерживает новую технологию Battery Boost, созданную для максимального увеличения автономной работы ноутбука в игровом режиме. Также новинка поддерживает DirectX 11.2 и известные технологии NVIDIA — Optimus, Adaptive VSync, GeForce Experience, FXAA, TXAA, PhysX, Direct Compute, Blu-Ray 3D и SLI.

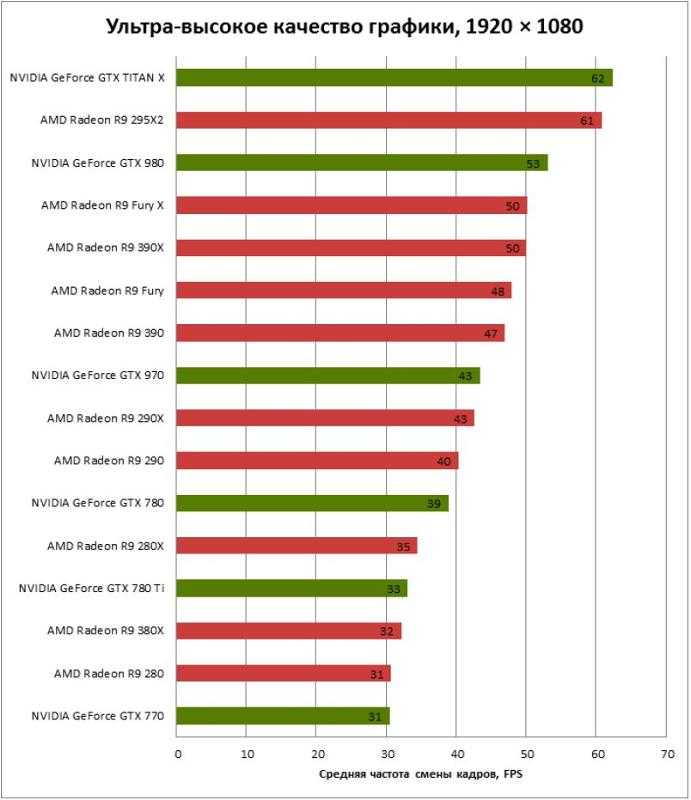

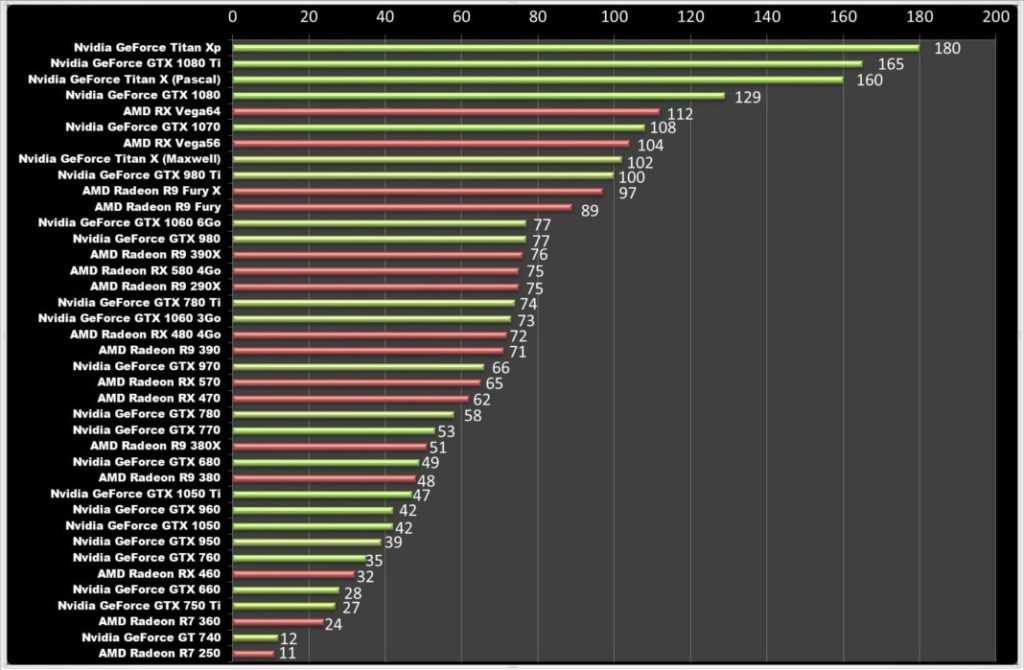

Сравнивая новинку с моделями прошлой 700-й серии, производительность GTX 860M находится на уровне GTX 770M, и может даже превосходить её. Ниже вы можете ознакомиться с игровыми тестами, из которых можно сделать вывод, что видеокарта GeForce GTX 860M займет достойное место в нише игровых ноутбуков.

Технические характеристики (могут быть изменены производителем):

| Серия | GeForce 800M |

| Архитектура | Maxwell |

| Количество шейдеров | 640 |

| Тактовая частота | 1029 МГц + boost |

| Частота памяти | 2500 MГц |

| Тип памяти | GDDR5 |

| Разрядность шины памяти | 128 бит |

| Максимум видеопамяти | 4096 Мб |

| Дата выхода | 12 марта 2014 года |

| Последняя версия драйвера | Cкачать |

Тестирование GeForce GTX 860M в играх* (среднее количество FPS)

| Игры/Настройки | Ультра 1920х1080 px | Высокие 1366х768 px | Средние 1366х768 px | Низкие 1024х768 px |

| Call of Duty: Black Ops 3 | 21 fps | 35 fps | 51 fps | 80 fps |

| Fallout 4 | 20 fps | 35 fps | 44 fps | 72 fps |

| The Witcher 3: Wild Hunt | 11 fps | 26 fps | 37 fps | 65 fps |

| GTA 5 | 15 fps | 48 fps | 110 fps | 125 fps |

| Battlefield 4 | 29 fps | 69 fps | 103 fps | 138 fps |

| Watch Dogs | 19 fps | 41 fps | 67 fps | 83 fps |

| Call of Duty: Ghosts | 28 fps | 50 fps | 82 fps | 89 fps |

| Metro: Last Light | 26 fps | 54 fps | 88 fps | 97 fps |

| Crysis 3 | 18 fps | 49 fps | 78 fps | 120 fps |

| Far Cry 3 | 21 fps | 61 fps | 91 fps | 103 fps |

| GRID 2 | 45 fps | 98 fps | 105 fps | 130 fps |

| Tomb Raider 2013 | 43 fps | 96 fps | 160 fps | 291 fps |

| Thief 2014 | 23 fps | 47 fps | 55 fps | 63 fps |

*В зависимости о модели и конфигурации ноутбука результаты тестов могут отличаться.

Рейтинг видеокарт | Overclock.net

JavaScript отключен. Для лучшего опыта, пожалуйста, включите JavaScript в вашем браузере, прежде чем продолжить.

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Реакции: 5

1 — 20 из 1170 сообщений

Вы, ребята, должны сказать мне, что нового добавить и куда это следует добавить…

Ответить

Сохранить

Нравится

Реакции: 2

Почти уверен, что 3 GTX285 лучше 2 295, также почти уверен, что Tri Fire 4890 лучше 2×4870 Кроме того, 4890×2 определенно лучше gtx295

Ответить

Сохранить

Например,

4890×2 даже не выходит, как он может победить gtx 295?

Ответить

Сохранить

Нравится

Цитата:

| Первоначально Послано Anth0789 SLI/Crossfire [*] Geforce GTX295 Quad SLI [*]Geforce GTX285 Tri SLI [*]Radeon HD4890 Tri fire [*]Geforce GTX295 SLI [*]Radeon HD4890 Crossfire [*]Radeon HD4870X2 Crossfire [*] Geforce GTX280 Tri SLI [*]Geforce GTX 275 Tri SLI |

Не совсем понимаю. Что здесь происходит?

Что здесь происходит?

Если у вас «GTX 295 Quad SLI», то GTX 295 SLI должна быть одной картой, верно?

Если да, то как он может быть выше, чем Tri-SLI 280 или 275?

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Цитата:

| Первоначально Послано DeathTyrant Я не совсем понимаю. Что здесь происходит? Если у вас «GTX 295 Quad SLI», то GTX 295 SLI должна быть одной картой, верно? Если да, то как он может быть выше, чем Tri-SLI 280 или 275? |

Моя ошибка исправлена!

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Реакции: 1

Понятия не имею, куда поместить подобную карточку, и если вы даже включите нереференс, но куда ее поместить?

http://www. newegg.com/Product/Produc…82E16814127433

newegg.com/Product/Produc…82E16814127433

Я не уверен, что MSI — единственная компания, которая их носит, но подозреваю, что они превосходят 4870 1GB при 1080p или выше. Ребята, что вы думаете? У меня нет скамеек, чтобы предоставить.

Увидеть меньше Узнать больше

Ответить

Сохранить

Например,

Я совершенно уверен, что 7300GS немного лучше, чем 6200

(Хотя мне не хватает тестов. Это две редко сравниваемые карты). к HD4830, я полагаю, что когда он выйдет , он не лучше, чем 8800GTX

РЕДАКТИРОВАТЬ: О, и вам не хватает HD4350 и HD4550. Они обычно медленнее, чем 9500GT кажется. (но обычно быстрее 9400GT)

4550 отзывов

http://www.techpowerup.com/reviews/ATI/HD_4550_passive

http://www.guru3d.com/article/ati-ra…-512mb- обзор/

http://www.legitreviews.com/article/801/

http://www.hexus.net/content/item.php?item=15658

Mixed

http://www. motherboards.org /reviews/…re/1824_9.html

motherboards.org /reviews/…re/1824_9.html

http://www.anandtech.com/video/showdoc.aspx?i=3420

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Реакции: 1

Цитата:

| Первоначально Послано slowEnd Я совершенно уверен, что 7300GS немного лучше, чем 6200 (Хотя мне не хватает тестов. Это две редко сравниваемые карты. ) 4750 еще даже не вышла, и учитывая, насколько 4770 близка к HD4830, я полагаю, что когда выйдет , она будет не лучше, чем 8800GTX РЕДАКТИРОВАТЬ: О, и вам не хватает HD4350 и HD4550. Они обычно медленнее, чем 9500GT кажется. (но обычно быстрее 9400GT) 4550 отзывов Mixed |

Ага спасибо за информацию. Зафиксированный! Если чего-то не хватает или есть ошибка, дайте мне знать.

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Реакции: 1

HD 4650 должен быть там, он выше 8600gts, но ниже 9600GSO, я думаю, что он, вероятно, будет быстрее, чем 256-мегабайтная версия 3850. так что чуть выше, я думаю. Также я думаю, что 4670 кажется немного высоким.

http://www.techspot.com/article/125-…nce/page4.html

и

http://www.techspot.com/review/134-b…dup/page3.html

Также этот сайт отлично подходит для сравнения видеокарт для COD5, Fallout3 и Far Cry 2

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Реакции: 1

Цитата:

| Первоначально Послано TF876 HD 4650 должен быть там, это выше 8600gts, но ниже 9600GSO, я думаю, что это, вероятно, будет быстрее, чем 256mb версия 3850.  так чуть выше, я думаю. Также я думаю, что 4670 кажется немного высоким. так чуть выше, я думаю. Также я думаю, что 4670 кажется немного высоким. http://www.techspot.com/article/125-…nce/page4.html Также этот сайт отлично подходит для сравнения видеокарт для COD5, Fallout3 и Far Cry 2 |

Хороший материал, спасибо, я обновил его.

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Вы уверены 4890 лучше 4850X2?

4850X2 — это, по сути, 4850 Crossfire с большим объемом оперативной памяти

Ответить

Сохранить

Нравится

Цитата:

| Первоначально Послано slowEnd Вы уверены, что 4890 лучше, чем 4850X2? 4850X2 — это, по сути, 4850 crossfire с большим объемом оперативной памяти |

4850×2 быстрее, чем 285 и 4890. gtx275 быстрее, чем gtx280.

gtx275 быстрее, чем gtx280.

3870 быстрее 9600gt, 2900xt быстрее обеих карт.

я слишком занят в школе, чтобы искать ссылки в банкомате. но выложите ссылки в ближайшее время.

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

| gerikoh 4850×2 быстрее 285 и 4890. gtx275 быстрее gtx280. 3870 быстрее 9600gt, 2900xt быстрее обеих карт. я слишком занят в школе, чтобы искать ссылки в банкомате. но выложите ссылки в ближайшее время. |

Имо 4890 по-прежнему превосходит 4850X2.

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Цитата:

| Первоначально Послано Anth0789 Имо 4890 по-прежнему превосходит 4850X2.  |

Почему ты так уверен?

Нет.

Увидеть меньше Узнать больше

Ответить

Сохранить

Нравится

Цитата:

| Первоначально Послано slowEnd Почему ты так уверен? Нет. |

Версия на 2 ГБ не…

Увидеть меньше Узнать больше

Ответить

Сохранить

Например,

Я просматривал ваши списки и, насколько я понял, верхние — это «одиночные» карты. Почему карты с двумя графическими процессорами не относятся к категории SLI/crossfire? Поскольку технически им нужен , чтобы sli или crossfire работали. Я точно знаю, что на GTX295, если SLI отключен, она работает ОЧЕНЬ плохо.

Может быть, вам стоит создать отдельную категорию для карт с двумя графическими процессорами.

Увидеть меньше Узнать больше

Ответить

Сохранить

Например,

http://www.tomshardware.co.uk/radeon…w-31554-6.html

посмотрите на таблицу, Диаграмма иерархии видеокарт. это дает вам довольно хорошее представление о том, какая карта работает лучше. также 4850×2 лучше, чем 4890 , но работает примерно так же, как gtx285. И также помните, что 4850×2 — это, по сути, две карты.

Увидеть меньше Узнать больше

Ответить

Сохранить

Как

http://service.futuremark.com/result…&resultType=19

http://service.futuremark.com/result…&resultType=14

http://service.futuremark.com/result …&resultType=12

http://service.futuremark.com/result…&resultType=10

eVGA GTS 250 1GB

855|2058|1302

Информационный пост

Увидеть меньше Узнать больше

Ответить

Сохранить

Вроде

что не так со списком 4???

Ответить

Сохранить

Нравится

1 — 20 из 1170 сообщений

Верх

Как разогнать видеокарту

Когда вы совершаете покупку по ссылкам на нашем сайте, мы можем получать партнерскую комиссию. Вот как это работает.

Вот как это работает.

Разгон видеокарты может повысить ее производительность на 5-15% (или более) в зависимости от конкретной модели карты. Конечно, как и при любом разгоне, следует соблюдать осторожность, чтобы не запускать графический процессор с небезопасными настройками. Но если у вас есть один из лучшие видеокарты и вы хотите получить немного больше производительности, мы обсудим, как мы будем разгонять и определять «безопасные» настройки.

Перед разгоном полезно провести базовые измерения производительности вашей видеокарты. В конце концов, вы хотите иметь возможность видеть, насколько быстрее работает ваш компьютер после настройки — если производительность не улучшится, вам нужно знать об этом. Ознакомьтесь с нашим руководством по , как проверить производительность видеокарты , и вы также захотите проверить температуру и тактовую частоту видеокарты.

Когда у вас есть исходные данные о производительности, пора приступать к разгону. Существует множество утилит, но мы сосредоточимся на MSI Afterburner , который является одним из самых популярных и часто используемых инструментов для разгона GPU. Тот же базовый процесс можно использовать с другими утилитами, включая EVGA Precision X1 , Asus GPU Tweak (открывается в новой вкладке) и другими утилитами поставщиков видеокарт. Также можно разгонять графические процессоры AMD и Nvidia с помощью встроенной в драйверы AMD утилиты или утилиты GeForce Experience от Nvidia, о которой мы расскажем ниже, но начнем с универсального подхода к разгону вашего графического процессора.

Существует множество утилит, но мы сосредоточимся на MSI Afterburner , который является одним из самых популярных и часто используемых инструментов для разгона GPU. Тот же базовый процесс можно использовать с другими утилитами, включая EVGA Precision X1 , Asus GPU Tweak (открывается в новой вкладке) и другими утилитами поставщиков видеокарт. Также можно разгонять графические процессоры AMD и Nvidia с помощью встроенной в драйверы AMD утилиты или утилиты GeForce Experience от Nvidia, о которой мы расскажем ниже, но начнем с универсального подхода к разгону вашего графического процессора.

Обратите внимание, что разгон очень сильно зависит от «кремниевой лотереи». Тот факт, что один человек с картой модели «HappyGPUs RTX 4090 X-Factor-Wow» (это выдуманное имя, если вы не могли понять) смог разогнать ядро на 20%, а память — на 25%, не означает, что каждая карта RTX 4090 будет работать с одинаковыми тактовыми частотами или даже с одинаковыми тактовыми частотами одной и той же модели. Показательный пример: несмотря на то, что все карты RTX 4090 (открывается в новой вкладке), которые мы видели до сих пор, используют память Micron 21 Гбит / с GDDR6X (открывается в новой вкладке) (чипы с маркировкой «D8BZC»), мы видели максимальную стабильность разгон памяти варьируется от 22,6 Гбит/с до 25 Гбит/с.

Показательный пример: несмотря на то, что все карты RTX 4090 (открывается в новой вкладке), которые мы видели до сих пор, используют память Micron 21 Гбит / с GDDR6X (открывается в новой вкладке) (чипы с маркировкой «D8BZC»), мы видели максимальную стабильность разгон памяти варьируется от 22,6 Гбит/с до 25 Гбит/с.

Разгон с помощью MSI Afterburner

(Изображение предоставлено MSI) Вот основной интерфейс для MSI Afterburner с использованием скина v3. Он показывает ползунки для напряжения ядра, предела мощности, тактовой частоты ядра, тактовой частоты памяти и скорости вращения вентилятора. По умолчанию Afterburner блокирует регулировку напряжения. Если вы хотите поиграть с этой опцией, зайдите в настройки и установите флажок «Разблокировать управление напряжением». Вы можете попробовать установить его на эталонный дизайн, стандартный MSI, расширенный MSI или сторонний — некоторые карты позволяют регулировать напряжение только в правильном режиме, а некоторые могут вообще не разрешать.

Одним из вариантов разгона является использование автоматического сканера ОС. Нажмите Ctrl + F, затем нажмите кнопку OC Scanner в правом верхнем углу и дайте ему сделать свое дело. Предполагается, что это упростит разгон, но, как и в случае с большинством утилит автонастройки, ваш пробег может отличаться. У нас были сбои, он генерировал нестабильные разгоны, а иногда он даже не соответствовал быстрому и грязному ручному разгону +150 МГц (или что-то еще). Это также ничего не делает для тактовой частоты памяти, поэтому вы, вероятно, в конечном итоге пойдете по ручному маршруту. Запуск сканера OC может занять 20 минут, и в большинстве случаев вы можете быстро и легко разогнать компьютер гораздо быстрее самостоятельно.

Мой подход заключается в том, чтобы запустить графически интенсивную игру или тест, который будет работать в окне, затем я запускаю игру в разрешении 1920×1080 или 2560×1440 (в зависимости от используемого графического процессора) и дохожу до места, где ничего не происходит. убей меня. Оттуда я переключаюсь на Afterburner и начинаю пробовать некоторые настройки. Обратите внимание, что вам понадобится игра или тест, который не останавливает рендеринг, когда вы покидаете фокус (поэтому, если он показывает меню, когда вы нажимаете Alt+Tab, это не сработает).

убей меня. Оттуда я переключаюсь на Afterburner и начинаю пробовать некоторые настройки. Обратите внимание, что вам понадобится игра или тест, который не останавливает рендеринг, когда вы покидаете фокус (поэтому, если он показывает меню, когда вы нажимаете Alt+Tab, это не сработает).

При разгоне видеокарты необходимо учитывать четыре основных момента: тактовая частота ядра графического процессора, тактовая частота памяти, напряжение графического процессора и скорость вращения вентилятора. (В некоторых случаях вы также можете отрегулировать напряжение памяти.) Я начинаю с поиска максимальной «стабильной» частоты ядра, затем нахожу максимальную «стабильную» частоту памяти, а затем пытаюсь найти сочетание этих двух параметров, которое приводит к оптимальная производительность.

Обратите внимание, что слово «стабильный» взято в кавычки, потому что даже если первоначальное тестирование работает нормально, часто будут исключения, когда некоторые игры или приложения аварийно завершат работу, а другие будут работать. Когда это произойдет, вам придется вернуться, чтобы настроить параметры и посмотреть, сможете ли вы найти такие, которые позволяют игре работать должным образом. Как вы, наверное, догадались, чем требовательнее игра (то есть, если в ней используется трассировка лучей или другие расширенные функции), тем больше вероятность того, что ей потребуется дополнительная тонкая настройка и более низкие тактовые частоты.

Когда это произойдет, вам придется вернуться, чтобы настроить параметры и посмотреть, сможете ли вы найти такие, которые позволяют игре работать должным образом. Как вы, наверное, догадались, чем требовательнее игра (то есть, если в ней используется трассировка лучей или другие расширенные функции), тем больше вероятность того, что ей потребуется дополнительная тонкая настройка и более низкие тактовые частоты.

В этом руководстве мы будем использовать Cyberpunk 2077 , работающую в окне с разрешением 2560×1440 с настройками RT-Ultra и режимом качества DLSS, чтобы найти разумный разгон для GeForce RTX. Карта 3090 Founders Edition. Это отвечает всем требованиям для требовательной игры, которая, вероятно, заставит графический процессор работать на пределе своих возможностей, а также имеет встроенный тест, который позволит нам увидеть, что происходит с производительностью после настройки.

Мы начали с разгона ядра графического процессора. После загрузки игры и применения соответствующих настроек мы максимально увеличили ограничение мощности и установили скорость вращения вентилятора на 80%, чтобы обеспечить охлаждение графического процессора и памяти. До сих пор все было хорошо, и мы применили смещение 100 МГц к ядру графического процессора. Это работало нормально, что почти всегда так и есть — если вы не можете разогнать ядро хотя бы до 100 МГц, вам, вероятно, не стоит беспокоиться о дальнейшем развитии вашей конкретной видеокарты.

После загрузки игры и применения соответствующих настроек мы максимально увеличили ограничение мощности и установили скорость вращения вентилятора на 80%, чтобы обеспечить охлаждение графического процессора и памяти. До сих пор все было хорошо, и мы применили смещение 100 МГц к ядру графического процессора. Это работало нормально, что почти всегда так и есть — если вы не можете разогнать ядро хотя бы до 100 МГц, вам, вероятно, не стоит беспокоиться о дальнейшем развитии вашей конкретной видеокарты.

С этим первоначальным приростом производительности мы попытались разогнать ядро до 150 МГц… и Cyberpunk 2077 почти сразу вылетели. Мы пытались максимально увеличить напряжение ядра после перезапуска игры, и она все равно вылетала, что означает, что смещение в 150 МГц не сработает. Мы разделили разницу и упали до 125 МГц, что также привело к краху. Он выглядел достаточно стабильным после максимального напряжения ядра до +100, но все равно зависал через несколько минут.

В конечном счете, +100 МГц на ядрах графического процессора, похоже, максимум, что мы можем получить с этой конкретной картой, хотя обратите внимание, что увеличенный предел мощности означает, что мы работаем немного быстрее, чем на стоке — GPU такты колебались около 1755 МГц на заводе, по сравнению с 1905 МГц с нашим разгоном. Большая часть этого связана с повышенным пределом мощности, поскольку даже при разгоне графического процессора на 0 МГц мы видели в наших тестах среднюю тактовую частоту 1875 МГц.

Далее мы поработали над разгоном памяти. Мы снизили тактовую частоту ядра GPU до +0 МГц, но оставили предел мощности на максимуме (114% на этой карте). Обычно запаса достаточно, поэтому мы начали со смещения +750 МГц для памяти GDDR6X. Это дает эффективную тактовую частоту памяти 21 Гбит/с, и после нескольких минут беготни в игре мы поняли, что она работает нормально. +1000 МГц (21,5 Гбит/с) также выглядел стабильно, как и +1250 МГц (22 Гбит/с), но +1500 МГц сразу же приводил к сбою нашего ПК и принудительному перезапуску системы. Мы упоминали, что разгон может быть процессом проб и ошибок?

Мы упоминали, что разгон может быть процессом проб и ошибок?

После дополнительной настройки и тестирования мы объединили разгон графического процессора и видеопамяти, чтобы получить +100 МГц на ядре графического процессора и +1000 МГц на памяти GDDR6X. Обратите внимание, что графические процессоры Nvidia RTX 30-й серии имеют функцию «обнаружение ошибок и повторная попытка» (EDR) в памяти, что иногда может скрывать пограничный нестабильный разгон, и мы решили, что 21,5 Гбит/с — это достаточно быстро.

Производительность разгона графического процессора

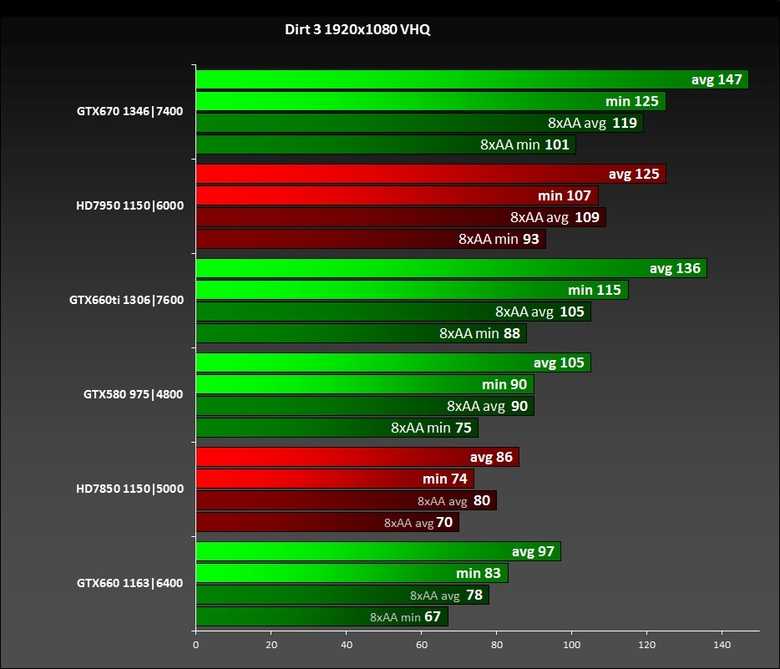

Что вышеописанное повлияло на производительность? Вот как производительность, только ядро графического процессора, только видеопамять и разгон графического процессора плюс видеопамять показали себя при разгоне 4K RT-Ultra с качеством DLSS во встроенном Киберпанк 2077 тест. Мы также протестировали вторую игру, Borderlands 3 , с настройками 4K и Badass с теми же четырьмя настройками графического процессора.

Изображение 1 из 2

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware)Мы простим вас, если это вас не впечатлило. В конечном итоге наш максимальный разгон графического процессора улучшил производительность RTX 3090 на 8,6% в Borderlands 3 и на 8,5% в Cyberpunk 2077 . Большая часть этого прироста была связана с разгоном ядра графического процессора, который повысил производительность на 7,3% за Borderlands 3 и 7,5% в Cyberpunk 2077 . Между тем, просто разгон видеопамяти улучшил производительность на 2,1% в Borderlands 3 и на 6,0% в Cyberpunk 2077 .

Ваш реальный выигрыш может варьироваться в зависимости от вашей видеокарты. Например, RTX 3090 не известна тем, что в большинстве случаев не хватает пропускной способности памяти, но эталонная модель определенно работает с ограничениями мощности на складе. Вот почему разгон ядра имел большее значение, чем разгон видеопамяти. Тем не менее, результаты, которые мы показали выше, не являются чем-то необычным для разгона видеокарты, и обычно мы видим улучшение производительности примерно на 5–10%.

Тем не менее, результаты, которые мы показали выше, не являются чем-то необычным для разгона видеокарты, и обычно мы видим улучшение производительности примерно на 5–10%.

«Встроенный» разгон AMD и Nvidia

(Изображение предоставлено Tom’s Hardware)Вы можете использовать другие утилиты для разгона графического процессора, но если вы не хотите возиться с MSI Afterburner , вам, вероятно, следует просто используйте встроенные инструменты, предоставляемые AMD и Nvidia. Nvidia предоставляет инструмент автоматической настройки, и вы можете указать пределы напряжения и мощности, целевую температуру и целевую скорость вращения вентилятора. После этого вы просто оставляете это на усмотрение драйверов, которые будут разгонять ядра графического процессора, но не видеопамять, поэтому вы потенциально упускаете приличный кусок неиспользованной производительности.

(Изображение предоставлено Tom’s Hardware) Инструменты разгона AMD, встроенные в Radeon Settings , гораздо полезнее. Вы можете делать все, что вам нужно, указывая напряжение, тактовую частоту, скорость вращения вентилятора, скорость памяти и многое другое. Вы также можете попросить драйверы разогнать видеопамять или графический процессор, но не оба сразу. Кроме того, он может автоматически понижать напряжение графического процессора, что немного снижает производительность, но также имеет тенденцию к снижению температуры и энергопотребления. По сути, вам не нужна отдельная утилита для разгона графического процессора, хотя мы все еще обычно находим MSI Afterburner , чтобы быть более знакомым и простым в использовании.

Вы можете делать все, что вам нужно, указывая напряжение, тактовую частоту, скорость вращения вентилятора, скорость памяти и многое другое. Вы также можете попросить драйверы разогнать видеопамять или графический процессор, но не оба сразу. Кроме того, он может автоматически понижать напряжение графического процессора, что немного снижает производительность, но также имеет тенденцию к снижению температуры и энергопотребления. По сути, вам не нужна отдельная утилита для разгона графического процессора, хотя мы все еще обычно находим MSI Afterburner , чтобы быть более знакомым и простым в использовании.

Одним из больших преимуществ инструментов разгона AMD является то, что вы можете указать профили разгона для каждой игры. Может быть, какая-то игра не такая интенсивная, и вы можете увеличить частоту, или, может быть, у вас есть игра, которой просто нужно больше энергии, чтобы обеспечить более плавный игровой процесс. Это может быть настолько сложно или настолько просто, насколько вы хотите, хотя в конечном итоге это часто сводится к пробам и ошибкам.

Стоит ли разгонять видеокарту? Мы могли бы быть дерзкими и сказать, что если вам нужно спросить, вам, вероятно, следует просто оставить в покое. Реальность такова, что AMD и Nvidia — и их партнеры по видеокартам — склонны убирать чипы и доводить производительность почти до предела. Разгон также увеличивает энергопотребление и часто температуру вашей видеокарты, что может привести к ее более раннему износу. Но, возможно, еще хуже то, что разгон обычно повышает производительность только на 5–10%.

Этот может быть заметным для некоторых людей без выполнения множества тестов. На практике обычно не хватает запаса по высоте, чтобы это стоило хлопот. Вы можете попробовать параметры автоматической настройки в драйверах AMD и Nvidia, и это, вероятно, даст вам как минимум половину того, что вы получите при ручной настройке. Кроме того, это просто щелчок переключателя, а не то, что требует множества проб и ошибок.

Как человек, который много лет занимался разгоном, я могу сказать, что одно из худших ощущений — это когда вы находитесь в середине игры, и она внезапно вылетает из-за ранее «стабильного» разгона. Тогда вы оказываетесь в незавидном положении, задаваясь вопросом, есть ли ошибка в игре, не зашел ли ваш разгон слишком далеко, или с вашим ПК что-то еще не так. Я потерял бесчисленное количество часов, устраняя неполадки на своих ПК, и в последнее время я просто не считаю разгон графического процессора особенно важным. Применение масштабирования в той или иной форме (DLSS, FSR2, XeSS или даже просто фильтр пространственного масштабирования) может обеспечить гораздо большее повышение производительности без увеличения энергопотребления или влияния на стабильность системы.

Однако вы можете не соглашаться со мной; возможно, ваше конкретное оборудование обеспечит больший прирост производительности после настройки. Просто следите за температурой графического процессора и видеопамяти и не забывайте регулярно чистить компьютер, чтобы поддерживать его бесперебойную работу. Кроме того, не прибегайте к разгону графического процессора, ожидая повышения производительности на 20% или более, потому что эти дни остались далеко в прошлом — если только вы не используете жидкий азот.

Кроме того, не прибегайте к разгону графического процессора, ожидая повышения производительности на 20% или более, потому что эти дни остались далеко в прошлом — если только вы не используете жидкий азот.

- БОЛЬШЕ: Лучшие видеокарты

- ДОПОЛНИТЕЛЬНО: Тесты GPU и иерархия

- ДОПОЛНИТЕЛЬНО: Весь графический контент

Получите мгновенный доступ к последним новостям, подробным обзорам и полезным советам.

Свяжитесь со мной, чтобы сообщить о новостях и предложениях других брендов Future. Получайте электронные письма от нас от имени наших надежных партнеров или спонсоров. Джарред Уолтон — старший редактор Tom’s Hardware, специализирующийся на GPU. Он работает техническим журналистом с 2004 года, пишет для AnandTech, Maximum PC и PC Gamer. От первых «3D-замедлителей» S3 Virge до современных графических процессоров — Джарред следит за всеми последними графическими тенденциями и всегда задает вопросы о производительности игр.

legitreviews.com/article/801/

legitreviews.com/article/801/

Ваш комментарий будет первым