Развитие видеокарт в 2000-х годах / Хабр

Продолжая историю развития видеокарт из предыдущей — статьи, видеоадаптеры 2000-х годов.

VSA-100 и новое поколение Voodoo

Чипсет VSA-100 (Voodoo Scalable Architecture — масштабируемая архитектура Voodoo) был выпущен компанией 3dfx в июне 2000 года. Первой видеокартой, использовавшей данный чип (VSA-100х2) стала Voodoo5 5500. Изготовленная по 250-нм техпроцессу, с 14 миллионами транзисторов. Объем памяти SDRAM доходил до 64 Мб, с 128-битной шиной. Частота графического процессора и памяти составляла 166 МГц. Впервые в видеокартах Voodoo поддерживался 32-битный цвет в 3D, а также текстуры с высоким разрешением 2048×2048 точек. Для сжатия применялись алгоритмы FXT1 и DXTC. Особенностью Voodoo5 5500 была высокая производительность при использовании сглаживания.

Видеокарта выпускалась с разными интерфейсами, такими, как AGP, PCI и т.д. Также была доступна версия под Macintosh, имеющая два разъема (DVI и VGA).

Осенью того же года 3dfx выпустила Voodoo4 4500 с объемом памяти 32 Мб, использовавшей один чип VSA-100. Модель оказалась довольно медленной и значительно уступала GeForce 2 MX и Radeon SDR.

Компания 3Dfx анонсировала выход производительной видеокарты Voodoo5 6000 на 4-х чипах VSA-100 и с 128 Мб памяти. Но окончательно реализовать проект так и не удалось — серьезные финансовые трудности обанкротили 3Dfx.

GeForce 2

В 2000-2001 годах компания NVIDIA выпустила серию видеокарт GeForce 2 (GTS, Ultra, Pro, MX и т. д.). У этих видеоадаптеров было 256-битное ядро — одно из самых производительных ядер того времени.

Базовой моделью стала GeForce 2 GTS (GigaTexel Shading), кодовое имя NV15. Данная видеокарта была изготовлена по 180-нм техпроцессу и содержала 25 миллионов транзисторов. Объем памяти DDR SGRAM составлял 32 Мб или 64 Мб с частотой 200 МГц и 128-битной шиной. У адаптера имелось 4 пиксельных конвейера. NV15 включала в себя полную поддержку DirectX 7, OpenGL 1. 2, как и аппаратную обработку геометрии и освещения (T&L).

2, как и аппаратную обработку геометрии и освещения (T&L).

Radeon DDR и SDR

Компания ATI не отставала от прогресса и в 2000 году выпустила процессор Radeon R100 (изначально назывался Rage 6). Он изготавливался по 180-нм техпроцессу и поддерживал технологию ATI HyperZ.

На основе R100 вышли видеокарты Radeon DDR и SDR.

Radeon DDR выпускался с объемом видеопамяти 32 Мб или 64 Мб. Частоты ядра и памяти составляли 183 МГц, использовалась 128-битная шина. В роли интерфейса выступал AGP 4x. У видеокарты было 2 пиксельных конвейера.

Упрощенная версия SDR отличалась от Radeon DDR типом используемой памяти и пониженными частотами (166 МГц). Объем памяти у Radeon SDR предоставлялся только на 32 Мб.

Radeon 8500 и Radeon 7500

В 2001 году на базе RV200 вышли два чипа Radeon 8500 и Radeon 7500.

В Radeon 8500 были собраны новейшие наработки ATI, он оказался очень быстрым.

Radeon 7500 изготавливался по тому же 150-нм техпроцессу, но с 30 миллионами транзисторов. Ядро работало на частоте 290 МГц, а память на 230 МГц. Пиксельных конвейеров было 2.

GeForce 3

В 2001 году вышли графические процессоры GeForce 3 с кодовым названием NV20. Процессор выпускался по 150-нм техпроцессу. Объем памяти предлагался на 64 Мб и на 128 Мб. Шина была 128-битной и состояла из четырех 32-битных контроллеров. Ядро работало на частоте 200 МГц, а память на частоте 230 МГц. Пиксельных конвейеров насчитывалось 4. Производительность составляла 800 миллиардов операций/сек. Пропускная способность памяти была 7,36 Гб/с

Устройство поддерживало nFinite FX Engine, позволяющие создавать огромное количество различных спецэффектов. Была улучшенная архитектура памяти LMA (Lightspeed Memory Architecture).

Была улучшенная архитектура памяти LMA (Lightspeed Memory Architecture).

Линейка видеокарт состояла из модификаций GeForce 3, GeForce 3 Ti 200 и Ti 500. Они отличались по тактовой частоте, производительности и пропускной способности памяти.

У GeForce 3 Ti 200: 175 МГц ядро, 200 МГц память; 700 миллиардов операций/сек; 6,4 Гб/с пропускная способность.

У GeForce 3 Ti 500: 240 МГц ядро и 250 МГц память; 960 миллиардов операций/сек; 8,0 Гб/с пропускная способность.

GeForce 4

Следующей видеокартой компании NVIDIA стала GeForce 4, которая вышла в 2002 году. C таким названием выпускались два типа графических карт: высокопроизводительные Ti (Titanium) и бюджетные MX.

Линейка GeForce 4 Ti была представлена моделями Ti 4400, Ti 4600, и Ti 4200. Видеокарты отличались тактовыми частотами ядра и памяти. Объем видеопамяти составлял 128 Мб (у Ti 4200 предлагался вариант и на 64 Мб). В Titanium использовался 128-битный 4-канальный контроллер памяти с LightSpeed Memory Architecture II, насчитывалось 4 блока рендеринга, 8 текстурных блоков, 2 T&L, имелась подсистема сглаживания Accuview и шейдерный движок nFiniteFX II, обеспечивающий полную поддержку DirectX 8.

GeForce 4 MX наследовали архитектуру GeForce 2 (с повышенным быстродействием). Они базировались на чипе NV17, изготовленного по 150-нм техпроцессу и состоящего из 27 миллионов транзисторов. Объем видеопамяти составлял 64 Мб. У графического процессора было 2 блока рендеринга, 4 текстурных, 1 блок T&L, 128-битный 2-канальный контроллер памяти с LightSpeed Memory Architecture II. Чип также обладал подсистемой сглаживания Accuview.

Radeon 9700 Pro

Летом 2002 года ATI выпустила чип R300, который изготавливался по 150-нм техпроцессу и содержал около 110 миллионов транзисторов. У него было 8 пиксельных конвейеров. Также чип поддерживал улучшенные методы сглаживания.

На базе R300 вышла видеокарта Radeon 9700 с тактовыми частотами ядра 325 МГц и памяти 310 МГц. Объем памяти составлял 128 Мб. Шина памяти была 256-битная DDR.

В начале 2003 года Radeon 9700 сменила видеокарта Radeon 9800.![]() Новые решения были построены на чипе R350, с увеличением тактовых частот и доработкой шейдерных блоков, контроллера памяти.

Новые решения были построены на чипе R350, с увеличением тактовых частот и доработкой шейдерных блоков, контроллера памяти.

GeForce FX

GeForce FX — пятое поколение графических процессоров, разработанных и выпущенных компанией NVIDIA с конца 2002 до 2004 годов. Одна из первых видеокарт серии GeForce FX обладала улучшенными методами сглаживания и анизотропной фильтрации. Она поддерживала вершинные и пиксельные шейдеры версии 2.0. Благодаря 64-битному и 128-битному представлению цвета, повысилось качество ярких изображений. Чип NV30 был изготовлен по 130-нм техпроцессу и работал с шиной на 128-бит AGP 8x, поддерживая память DDR2.

GeForce FX была представлена в разных модификациях: еntry-level (5200, 5300, 5500), mid-range (5600, 5700, 5750), high-end (5800, 5900, 5950), еnthusiast (5800 Ultra, 5900 Ultra, 5950 Ultra). Использовалась шина на 126-бит и на 256-бит.

На базе NV30 было создано топовое устройство нового поколения — видеокарта GeForce FX 5800. Объем видеопамяти достигал 256 Мб, частота ядра — 400 МГц, а памяти — 800 МГц. В 5800 Ultra частота ядра повысилась до 500 МГц, а памяти — до 1000 МГц. Первые карты на основе NV30 оснащались инновационной системой охлаждения.

Объем видеопамяти достигал 256 Мб, частота ядра — 400 МГц, а памяти — 800 МГц. В 5800 Ultra частота ядра повысилась до 500 МГц, а памяти — до 1000 МГц. Первые карты на основе NV30 оснащались инновационной системой охлаждения.

GeForce 6 Series

Развитие видеокарт активно продолжалось и в 2004 году вышел следующий продукт компании — GeForce 6 Series (кодовое название NV40).

Чип NV40 производился также по 130-нм техпроцессу, что не помешало ему стать более экономичным. Модификация пиксельных конвейеров дала возможность обрабатывать до 16 пикселей за такт. Всего было 16 пиксельных конвейеров. Видеокарты поддерживали пиксельные и вершинные шейдеры версии 3.0, технологию UltraShadow (прорисовка теней). Кроме этого, GeForce 6 Series с помощью технологии PureVideo декодировали видео форматов H.264, VC-1 и MPEG-2. NV40 работал через 256-битную шину, при этом использовались очень быстрые модули памяти типа GDDR3.

Одна из первых моделей, видеокарта GeForce 6800 была весьма производительной и тянула самые новые игры того времени. Она работала как через интерфейс AGP, так и через шину PCI Express. Частота ядра составляла 325 МГц, а частота памяти была 700 МГц. Объем памяти доходил 256 Мб или 512 Мб.

Она работала как через интерфейс AGP, так и через шину PCI Express. Частота ядра составляла 325 МГц, а частота памяти была 700 МГц. Объем памяти доходил 256 Мб или 512 Мб.

Radeon X800 XT

Компания ATI находилась в более выгодном положении. В 2004 году компания представила 130-нм чип R420 (усовершенствованная версия R300). Пиксельные конвейеры были разделены на четыре блока по четыре конвейера в каждом (в сумме 16 пиксельных конвейеров). Увеличилось до 6 количество вершинных конвейеров. Поскольку R420 не поддерживал работу шейдеров третьего поколения, он работал с обновленной технологией HyperZ HD.

Самая мощная и производительная видеокарта новой линейки Radeon была X800 XT. Карта оснащалась памятью типа GDDR3 объёмом 256 Mб и разрядностью шины 256-бит. Частота работы достигала 520 МГц по ядру и 560 МГц по памяти. Radeon X800 XT продавались в двух исполнениях: AGP и PCI Express. Помимо обычной версии существовал Radeon X800 XT Platinum Edition, обладающий более высокими частотами чипа и памяти.

GeForce 7800 GTX

В 2005 году вышел чип G70, который лег в основу видеокарт серии GeForce 7800. Количество транзисторов увеличилось до 302 миллионов.

Вдвое увеличилось количество пиксельных конвейеров — до 24 штук. В каждый конвейер были добавлены дополнительные блоки ALU, отвечающие за обработку наиболее популярных пиксельных шейдеров. Таким образом возросла производительность чипа в играх, делающих упор на производительность пиксельных процессоров.

GeForce 7800 GTX стала первой видеокартой на базе G70. Частота ядра составляла 430 МГц, памяти — 600 МГц. Использовалась быстрая GDDR3, а также 256-битная шина. Объем памяти составлял 256 Мб или 512 Мб. GeForce 7800 GTX работала исключительно через интерфейс PCI Express х16, который окончательно начал вытеснять устаревающий AGP.

GeForce 7950 GX2

Событием 2006 года для компании NVIDIA стал выпуск первой двухчиповой видеокарты GeForce 7950, созданной по 90-нм техпроцессу.Nvidia 7950 GX2 имела по одному чипу G71 на каждой из плат. Ядра видеокарты работали на частоте 500 МГц, память — на частоте 600 МГц. Объем видеопамяти типа GDDR3 составлял 1 Гб (по 512 Мб на каждый чип), шина 256-бит.

Ядра видеокарты работали на частоте 500 МГц, память — на частоте 600 МГц. Объем видеопамяти типа GDDR3 составлял 1 Гб (по 512 Мб на каждый чип), шина 256-бит.

В новой карте было оптимизировано энергопотребление и доработана система охлаждения. Выпуск 7950 GX2 стал началом развития технологии Quad SLI, позволяющей одновременно использовать мощности нескольких видеокарт для обработки трёхмерного изображения.

Radeon X1800 XT, X1900

На базе R520 была разработана видеокарта Radeon X1800 XT. Карта оснащалась памятью типа GDDR3 объемом 256 Мб или 512 Mб, работающей на частоте 750 МГц. Использовалась 256-битная шина.

Видеокарты Radeon X1800 XT недолго пробыли на рынке. Вскоре им на смену пришли адаптеры серии Radeon X1900 XTХ на базе чипа R580. Процессором полностью поддерживались на аппаратном уровне спецификации SM 3.0 (DirectX 9.0c) и HDR-блендинг в формате FP16 с возможностью совместного использования MSAA. В новом чипе было увеличено количество пиксельных конвейеров — до 48. Частоты ядра составляла 650 МГц, а памяти — 775 МГц.

Частоты ядра составляла 650 МГц, а памяти — 775 МГц.

Еще через полгода вышел чип R580+ с новым контроллером памяти, работающий со стандартом GDDR4. Частота памяти была увеличена до 2000 МГц, при этом шина оставалась 256-битной. Основные характеристики чипа остались прежними: 48 пиксельных конвейеров, 16 текстурных и 8 вершинных конвейеров. Частота ядра составляла 625 МГц, памяти было больше — 900 МГц.

GeForce 8800 GTX

В 2006 году на базе процессора G80 было выпущено несколько видеокарт, самой мощной из которых являлась GeForce 8800 GTX. G80 был одним из самых сложных существующих чипом того времени. Он выпускался по 90-нм техпроцессу и содержал 681 миллион транзисторов. Ядро работало на частоте 575 МГц, память — на частоте 900 МГц. Частота унифицированных шейдерных блоков составляла 1350 МГц. У GeForce 8800 GTX было 768 Мб видеопамяти GDDR3, а ширина шины составляла 384-бит. Поддерживались новые методы сглаживания, которые позволили блокам ROP работать с HDR-светом в режиме MSAA (Multisample anti-aliasing). Получила развитие технология PureVideo.

Получила развитие технология PureVideo.

Архитектура GeForce 8800 GTX оказалась особенно эффективной и на протяжении нескольких лет являлась одной из самых быстрых видеокарт.

Radeon HD2900 XT, HD 3870 и HD 3850

В 2007 года была представлена флагманская видеокарта Radeon HD2900 XT на базе чипа R600. Частота ядра видеокарты составляла 740 МГц, памяти GDDR4 — 825 МГц. Использовалась 512-битная шина памяти. Объем видеопамяти достигал 512 Мб и 1 Гб.

Более успешной разработкой вышел процессор RV670, выпущенный в том же году. Архитектурой он почти не отличался от предшественника, но изготавливался по 55-нм техпроцессу и с шиной памяти 256-бит. Появилась поддержка DirectX 10.1 и Shader Model 4.1. На базе процессора производились видеокарты Radeon HD 3870 (частота ядра 775 МГц, памяти 1125 МГц) и Radeon HD 3850 (частота ядра 670 МГц, памяти 828 МГц) с объемом видеопамяти 256 Мб и 512 Мб и шиной 256-бит.

GeForce 9800

Чип G92 лег в основу GeForce 9800 GTX — одной из самых быстрых и доступных видеокарт. Он изготавливался по 65-нм техпроцессу. Частота ядра составляла 675 МГц, частота памяти — 1100 МГц, а шина — 256-бит. Объем памяти предлагался в двух вариантах: на 512 Мб и на 1 Гб. Чуть позже появилась модель GTX+, которая отличалась 55-нм техпроцессом и частотой ядра — 738 МГц.

Он изготавливался по 65-нм техпроцессу. Частота ядра составляла 675 МГц, частота памяти — 1100 МГц, а шина — 256-бит. Объем памяти предлагался в двух вариантах: на 512 Мб и на 1 Гб. Чуть позже появилась модель GTX+, которая отличалась 55-нм техпроцессом и частотой ядра — 738 МГц.

В данной линейке также появилась очередная двухчиповая видеокарта GeForce 9800 GX2. Каждый из процессоров имел спецификации, как у GeForce 8800 GTS 512 Мб, только с разными частотами.

GeForce GTX 280 и GTX 260

В 2008 году компания NVIDIA выпустила чип GT200, который использовался в видеокартах GeForce GTX 280 и GTX 260. Чип производился по 65-нм техпроцессу и содержал 1,4 миллиарда транзисторов, обладал 32 ROP и 80 текстурными блоками. Шина памяти увеличилась до 512-бит. Также была добавлена поддержка физического движка PhysX и платформы CUDA. Частота ядра видеокарты составляла 602 МГц, а памяти типа GDDR3 — 1107 МГц.

В видеокарте GeForce GTX 260 использовалась шина GDDR3 448-бит. Частота ядра достигала 576 МГц, а памяти — 999 МГц.

Частота ядра достигала 576 МГц, а памяти — 999 МГц.

Radeon HD 4870

Старшая видеокарта новой линейки получила название Radeon HD 4870. Частота ядра составляла 750 МГц, а память работала на эффективной частоте 3600 МГц. С новой линейкой видеокарт компания продолжила свою новую политику выпуска устройств, которые могли успешно конкурировать в Middle-End-сегменте. Так, Radeon HD 4870 стал достойным конкурентом видеокарты GeForce GTX 260. А место лидера линейки HD 4000 вскоре заняло очередное двухчиповое решение Radeon HD 4870X2. Сама архитектура видеокарты соответствовала таковой у Radeon HD 3870X2, не считая наличия интерфейса Sideport, напрямую связывающего два ядра для наиболее быстрого обмена информацией.

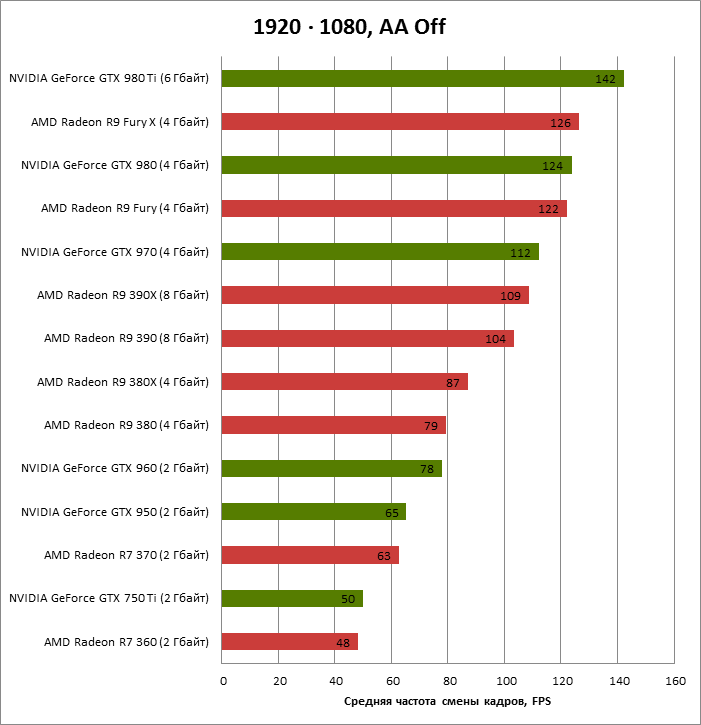

GeForce GTX 480

В 2010 году NVIDIA представила GF100 с архитектурой Fermi, который лег в основу видеокарты GeForce GTX 480. GF100 производился по 40-нм техпроцессу и получил 512 потоковых процессоров. Частота ядра была 700 МГц, а памяти — 1848 МГц. Ширина шины составила 384-бит. Объем видеопамяти GDDR5 достигал 1,5 Гб.

Ширина шины составила 384-бит. Объем видеопамяти GDDR5 достигал 1,5 Гб.

Чипом GF100 поддерживались DirectX 11 и Shader Model 5.0, а также новая технология NVIDIA Surround, позволяющая развернуть приложения на три экрана, создавая тем самым эффект полного погружения.

Чипы Cypress и Cayman

Компания AMD выпустила 40-нм чип Cypress. Разработчики компании решили поменять подход и не использовать исключительно буквенно-цифровые значения. Поколению чипов начали присваивать собственные имена. Сам принцип архитектуры Cypress продолжал идеи RV770, но дизайн был переработан. Вдвое увеличилось количество потоковых процессоров, текстурных модулей и блоков ROP. Появилась поддержка DirectX 11 и Shader Model 5.0. В Cypress появились новые методы сжатия текстур, которые позволили разработчикам использовать большие по объему текстуры. Также AMD представила новую технологию Eyefinity, полным аналогом которой позже стала технология NVIDIA Surround.

Чип Cypress был реализован в серии видеокарт Radeon HD 5000. Вскоре AMD выпустила и двухчиповое решение Radeon HD 5970. В целом Cypress оказался очень успешным.

Вскоре AMD выпустила и двухчиповое решение Radeon HD 5970. В целом Cypress оказался очень успешным.

Серия видеокарт Radeon HD 6000, выпущенная в конце 2010 года, была призвана конкурировать с акселераторами GeForce GTX 500. В основе графических адаптеров лежал чип Cayman. В нем применялась немного другая архитектура VLIW4. Количество потоковых процессоров составляло 1536 штук. Возросло количество текстурных модулей — их стало 96. Также Cayman умел работать с новым алгоритмом сглаживания Enhanced Quality AA. Ширина шины памяти чипа составляла 256-бит. Видеокарты использовали GDDR5-память.

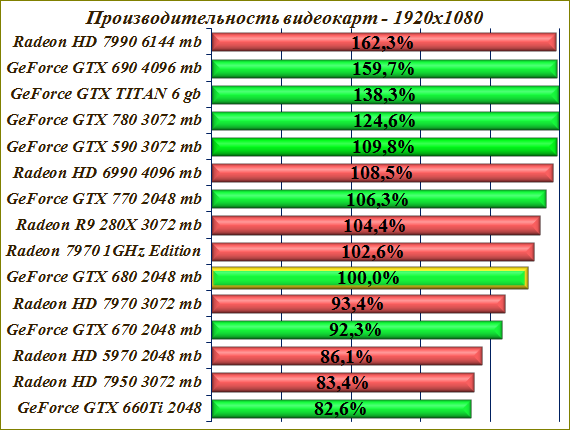

GeForce GTX 680

Начиная с 2011 года NVIDIA выпустила поколение графических ускорителей. Одной из примечательных моделей была видеокарта GeForce GTX 680, основанная на чипе GK104, производившемуся по 28-нм техпроцессу. Частота работы ядра 1006 МГц, частота работы памяти 6008 МГц, шина 256-бит GDDR5.

В 2013 года компания представила чип GK110, на котором основываются флагманские видеокарты GeForce GTX 780 и GeForce GTX Titan. Использовалась шина 384-бит GDDR5, а объем памяти повысился до 6 Гб.

Использовалась шина 384-бит GDDR5, а объем памяти повысился до 6 Гб.

по мощности и дате производства

Приветствую всех! Сегодня рассмотрим все видеокарты Nvidia GeForce по порядку — те, которые сегодня по мощности не утратили актуальности и могут представлять интерес для среднестатистического пользователя или продвинутого геймера.

Для удобства восприятия список я представил в виде таблицы, отсортировав девайсы популярных линеек по дате производства.

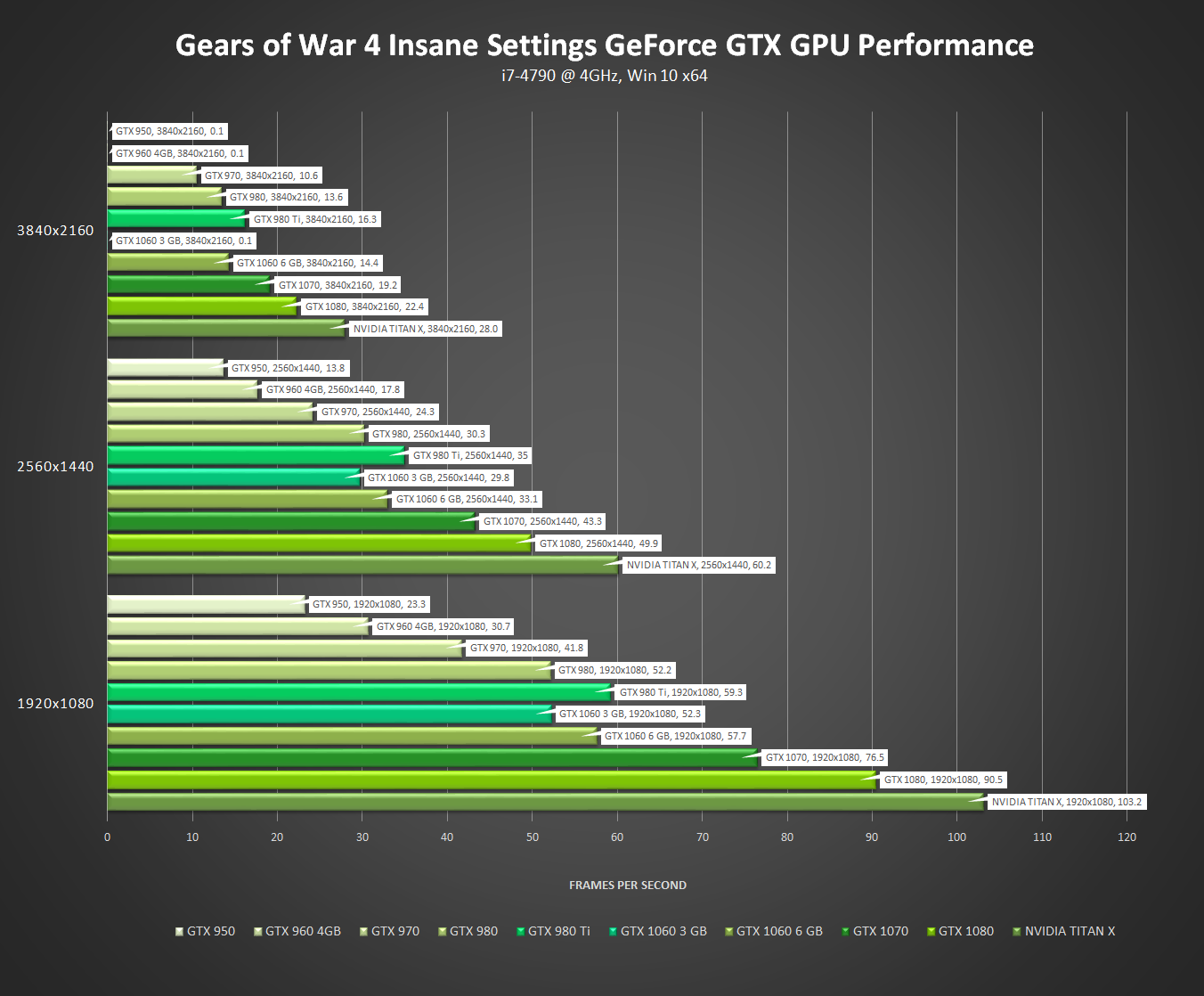

GeForce 900 Series

| Модель | Дата выхода | Объем видеопамяти, Мб | Скорость ядра, MHz | Частота памяти, МГц | Шина, бит |

| GTX950 | Август 2015 | 2048 / 4096 | 1024 | 6610 | 128 |

| GTX960 | Январь 2015 | 2048 / 4096 | 1127 | 7010 | 128 |

| GTX970 | Сентябрь 2014 | 3584 + 512 | 1050 | 7010 | 196 |

| GTX980 | Сентябрь 2014 | 4096 | 1126 | 7010 | 256 |

| GTX980 Ti | Июнь 2015 | 6144 | 1000 | 7010 | 384 |

| Titan X (Maxwell) | Март 2015 | 12288 | 1000 | 7010 | 384 |

Уже относительно старая, но еще не утратившая актуальности линейка видеоадаптеров. Современные игры потянет с небольшим напрягом, и то не на максимальных настройках качества графики. Преимущество в том, что сегодня можно по дешевке купить рабочую б/у видеокарту упомянутых выше моделей по чисто символической цене.

Современные игры потянет с небольшим напрягом, и то не на максимальных настройках качества графики. Преимущество в том, что сегодня можно по дешевке купить рабочую б/у видеокарту упомянутых выше моделей по чисто символической цене.

⇡#Двухпроцессорная платформа на Pentium III

Материнская плата Abit ST6 и разогнанный Pentium III-S — о таком компьютере большинство из нас могли только мечтать 20 лет тому назад. Но как показало время, мечтать нужно было о двухъядерной системе. Конечно, большинство программ для домашнего ПК, не говоря уже об играх, в те годы не могли задействовать два центральных процессора, но в железе такая возможность была, и сейчас мы ею воспользовались.

В планах на эту статью изначально фигурировала двухсокетная материнская плата ASUS CUV4X-DL — официально она не совместима с чипами Tualatin, но может принять два Pentium III-S после модификации разъемов (или с помощью адаптеров). Увы, наш экземпляр оказался полумертвым, но подвернулась равноценная замена в виде Intel SAI2 на чипсете ServerWorks ServerSet III LE. К тому же эта плата позволила набрать 2 Гбайт оперативной памяти за счет четырех регистровых модулей PC-133. Согласитесь, такая конфигурация уже выглядит вполне современно, особенно с накопителем SSD.

К тому же эта плата позволила набрать 2 Гбайт оперативной памяти за счет четырех регистровых модулей PC-133. Согласитесь, такая конфигурация уже выглядит вполне современно, особенно с накопителем SSD.

У этой платформы есть лишь один критический изъян — отсутствие разъема AGP, поэтому выбор графической карты для двухголового Pentium III-S существенно ограничен по сравнению с Abit ST6. К счастью, плата SAI2 несет не только стандартные 32-битные слоты PCI, но и два 64-битных разъема PCI-X, для которых существуют подходящие видеокарты. Один из них мы заняли RAID-контроллером Adaptec ASR-2230SLP/256 для шины Ultra-320 SCSI и собрали дисковый массив RAID-0 из трех винчестеров Seagate Cheetah 15K.5 со скоростью вращения шпинделя 15 тыс. об/мин. Конечно, даже массив из трех серверных 15-тысячников — не соперник SSD, но все-таки по скорости запуска ОС и установки программ RAID дает огромное преимущество по сравнению с одиночным жестким диском.

Видеокарты

Отбирая видеокарты для теста, мы ориентировались опять-таки скорее на определенный уровень технологий, нежели на строгие временные рамки. Процессор Pentium III-S с частотой 1,43 ГГц появился в 2002 году: осталось недолго до выхода GeForce 3 и Radeon 8500. Но программируемые шейдеры — это уже гигантский водораздел в истории GPU, перед которым мы решили остановиться. С другой стороны, видеокарты той поры, когда сам термин Graphics Processing Unit (а его, к слову, придумала NVIDIA специально для GeForce 256) еще не был в обиходе, тоже едва ли подходят для сборки мечты на топовом Pentium III. Лучшим спутником для такой системы — и по хронологической близости, и по исторической значимости — станет одна из ранних моделей с аппаратным T&L: либо NVIDIA GeForce 256, либо ATi Radeon DDR.

Процессор Pentium III-S с частотой 1,43 ГГц появился в 2002 году: осталось недолго до выхода GeForce 3 и Radeon 8500. Но программируемые шейдеры — это уже гигантский водораздел в истории GPU, перед которым мы решили остановиться. С другой стороны, видеокарты той поры, когда сам термин Graphics Processing Unit (а его, к слову, придумала NVIDIA специально для GeForce 256) еще не был в обиходе, тоже едва ли подходят для сборки мечты на топовом Pentium III. Лучшим спутником для такой системы — и по хронологической близости, и по исторической значимости — станет одна из ранних моделей с аппаратным T&L: либо NVIDIA GeForce 256, либо ATi Radeon DDR.

GeForce 256 не нуждается в представлении — это первенец семейства GeForce, основанный на процессоре NV10. Огромный по тем временам транзисторный бюджет (17 млн при техпроцессе 220 нм) позволил NVIDIA интегрировать в GPU геометрический блок, выполняющий трансформацию и освещение полигонов. Впрочем, потенциал этой функции в полной мере раскрылся только в следующих итерациях архитектуры, когда быстродействие центрального процессора уже не позволяло столь же эффективно обслуживать GPU, лишенный аппаратного T&L.

Creative Labs 3D Blaster Annihilator (GeForce 256)

Не менее важным событием для 3D-ускорителей стала смена оперативной памяти с устаревшего стандарта SDRAM на прогрессивный DDR SDRAM, который позволил GPU вдвое увеличить пропускную способность кадрового буфера. NVIDIA представила видеокарту на основе NV10 с чипами DDR вскоре после выхода оригинального GeForce 256, но вместо нее мы выбрали следующую модель — GeForce 2 GTS. Она отличается от GeForce 256 не только типом оперативной памяти, но и удвоенным числом блоков наложения текстур. Кроме того, в GeForce 2 GTS есть зачатки пиксельных шейдеров, которые, разумеется, игроделами того времени были начисто проигнорированы. Но в целом GeForce 2 GTS — это всего лишь продолжатель идей, заложенных в GeForce 256.

ELSA GLADIAC (GeForce 2 GTS)

Самый первый Radeon, как и GeForce 256, впоследствии стал родоначальником собственного семейства графических карт. Это устройство сделало ATi одним из ведущих игроков на рынке дискретных GPU — по крайней мере, в технологическом плане. В чипе R100 повторилось все лучшее, что на тот момент было у NVIDIA: аппаратный T&L и поддержка памяти DDR SDRAM. В силу архитектурных особенностей графического процессора Radeon DDR не отличался высоким филлрейтом на фоне GeForce 2 GTS, который был его главным соперником. Но у R100 есть важное преимущество — функция отсечения невидимых поверхностей (Z-culling) на ранних стадиях конвейера. Благодаря ей Radeon DDR эффективно использует массивную ПСП чипов DDR и способен на равных бороться с конкурентом при рендеринге в 32-битном цвете.

В чипе R100 повторилось все лучшее, что на тот момент было у NVIDIA: аппаратный T&L и поддержка памяти DDR SDRAM. В силу архитектурных особенностей графического процессора Radeon DDR не отличался высоким филлрейтом на фоне GeForce 2 GTS, который был его главным соперником. Но у R100 есть важное преимущество — функция отсечения невидимых поверхностей (Z-culling) на ранних стадиях конвейера. Благодаря ей Radeon DDR эффективно использует массивную ПСП чипов DDR и способен на равных бороться с конкурентом при рендеринге в 32-битном цвете.

ATi Radeon DDR

В то время, когда появились GeForce 256 и Radeon DDR, NVIDIA и ATi (а затем AMD) еще не успели поделить между собой рынок дискретных видеокарт. Свои последние годы доживала компания 3dfx, а ее лебединой песней стал ускоритель Voodoo5 5500. В основе лучшей видеокарты, которую 3dfx успела выпустить на рынок, лежат два чипа VSA-100, связанные интерфейсом SLI, — разработчики этой архитектуры изначально планировали наращивать быстродействие за счет распайки на одной плате нескольких дискретных GPU (вплоть до четырех штук в составе Voodoo5 6000). Одиночный процессор VSA-100 в своей основе не слишком отличается от чипа Avenger предыдущего поколения (серия Voodoo3). Главное, что сделала 3dfx, — это поддержка рендеринга в 32-битном цвете, которой были лишены все предшествующие устройства этой фирмы. Но когда два VSA-100 с оперативной памятью SDRAM работают в тандеме, в распоряжении видеокарты оказывается такая же ПСП, как у памяти DDR. Кроме того, у VSA-100 есть особенность, надолго опередившая свое время: аппаратный буфер, аккумулирующий результаты рендеринга нескольких кадров (T-Buffer). За счет T-Buffer ускорителю доступны такие эффекты, как высококачественное полноэкранное сглаживание, размытие в движении или даже имитация съемки с открытой диафрагмой за счет размытия заднего фона. А спустя много лет в неофициальных драйверах для Voodoo5 появилась функция временного сглаживания, которая оперирует данными нескольких последовательных кадров.

Одиночный процессор VSA-100 в своей основе не слишком отличается от чипа Avenger предыдущего поколения (серия Voodoo3). Главное, что сделала 3dfx, — это поддержка рендеринга в 32-битном цвете, которой были лишены все предшествующие устройства этой фирмы. Но когда два VSA-100 с оперативной памятью SDRAM работают в тандеме, в распоряжении видеокарты оказывается такая же ПСП, как у памяти DDR. Кроме того, у VSA-100 есть особенность, надолго опередившая свое время: аппаратный буфер, аккумулирующий результаты рендеринга нескольких кадров (T-Buffer). За счет T-Buffer ускорителю доступны такие эффекты, как высококачественное полноэкранное сглаживание, размытие в движении или даже имитация съемки с открытой диафрагмой за счет размытия заднего фона. А спустя много лет в неофициальных драйверах для Voodoo5 появилась функция временного сглаживания, которая оперирует данными нескольких последовательных кадров.

3dfx Voodoo5 5500

Все перечисленные видеокарты производились в конфигурации с интерфейсом AGP либо PCI. А значит, любая из них найдет место в двухпроцессорной системе на материнской плате Intel SAI2. Увы, тестовые образцы GeForce 256, GeForce 2 GTS, Radeon DDR и Voodoo5 5500, которые есть у нас в наличии, работают на шине AGP, так что для SAI2 придется искать другие варианты — например, классику в виде пары Voodoo2, объединенных мостиком SLI. А раз так, то почему бы не добавить в список участников теста плату Voodoo3 3000 — хотя бы для сравнения с Voodoo5 5500, близким к чипу Avenger по архитектуре GPU. Да и, в конце концов, Voodoo — это всегда интересно, ведь GeForce и Radeon по-прежнему с нами, а устройства 3dfx навсегда ушли в историю.

А значит, любая из них найдет место в двухпроцессорной системе на материнской плате Intel SAI2. Увы, тестовые образцы GeForce 256, GeForce 2 GTS, Radeon DDR и Voodoo5 5500, которые есть у нас в наличии, работают на шине AGP, так что для SAI2 придется искать другие варианты — например, классику в виде пары Voodoo2, объединенных мостиком SLI. А раз так, то почему бы не добавить в список участников теста плату Voodoo3 3000 — хотя бы для сравнения с Voodoo5 5500, близким к чипу Avenger по архитектуре GPU. Да и, в конце концов, Voodoo — это всегда интересно, ведь GeForce и Radeon по-прежнему с нами, а устройства 3dfx навсегда ушли в историю.

STB Systems Blackmagic 3D (Voodoo2) в режиме SLI | 3dfx Voodoo3 3000 |

Взвесив все за и против, мы внесли в список участников тестирования еще одно устройство — Matrox Parhelia с интерфейсом PCI. С одной стороны, мы договорились не трогать видеокарты с программируемыми шейдерами, а Parhelia является устройством того же периода и таких же возможностей, как GeForce 3, GeForce 4 и Radeon 8500. С другой стороны, Parhelia-512 образца 2002 года — это один из позднейших высокопроизводительных GPU, которые массово выпускали на платах с разъемом PCI, причем не абы каким, а 64-битным PCI-X. Его тестирование покажет максимум быстродействия, который можно получить на платформе Intel SAI2.

С другой стороны, Parhelia-512 образца 2002 года — это один из позднейших высокопроизводительных GPU, которые массово выпускали на платах с разъемом PCI, причем не абы каким, а 64-битным PCI-X. Его тестирование покажет максимум быстродействия, который можно получить на платформе Intel SAI2.

Matrox Parhelia DL256

GeForce 10 Series

| Модель | Дата выхода | Объем видеопамяти, Мб | Скорость ядра, MHz | Частота памяти, МГц | Шина, бит |

| GT1030 GDDR4 | Март 2018 | 2048 | 1151 | 2100 | 64 |

| GT1030 GDDR5 | Май 2017 | 2048 | 1227 | 6000 | 64 |

| GTX1050 | Октябрь 2016 | 2048 | 1354 | 7000 | 128 |

| GTX1050 3Gb | Май 2018 | 3072 | 1392 | 7000 | 96 |

| GTX1050 Ti | Октябрь 2016 | 4096 | 1290 | 7000 | 1280 |

| GTX1060 | Июль 2016 | 3072 / 6144 | 1506 | 8000 / 9000 | 192 |

| GTX1070 | Июнь 2016 | 8192 | 1506 | 8000 | 256 |

| GTX1070 Ti | Ноябрь 2017 | 8192 | 1607 | 8000 | 256 |

| GTX1080 | Май 2016 | 8192 | 1607 | 10000 / 11000 | 256 |

| GTX1080 Ti | Март 2017 | 11264 | 1480 | 11008 | 352 |

| Titan X (Pascal) | Август 2016 | 12288 | 1417 | 11008 | 384 |

| Titan XP (Pascal) | Апрель 2017 | 12288 | 1480 | 11408 | 384 |

Не самая новая линейка, однако представленные девайсы пользуются заслуженным спросом. В модельном ряду устройства любой мощности: от бюджетных до топовых. Можно брать.

В модельном ряду устройства любой мощности: от бюджетных до топовых. Можно брать.

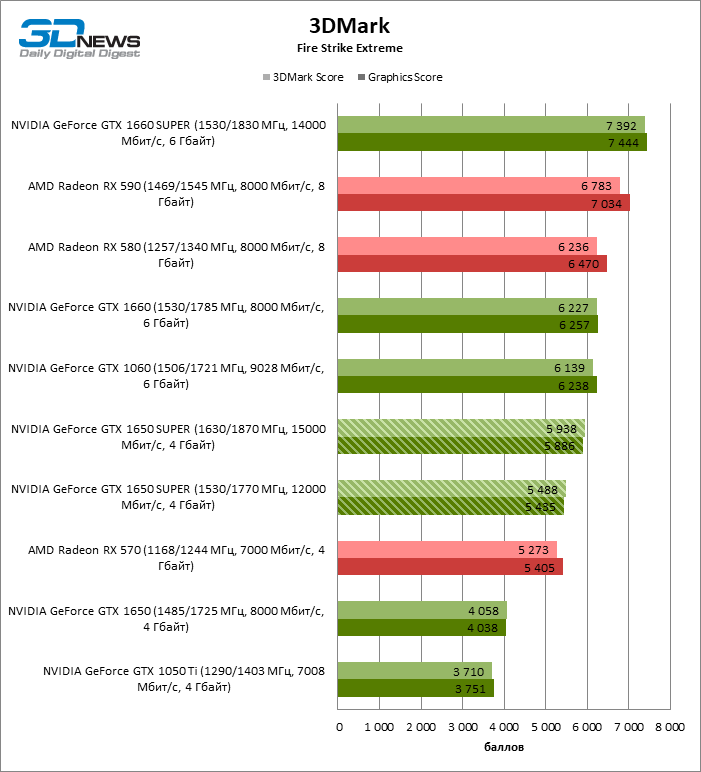

GeForce 16 Series

| Модель | Дата выхода | Объем видеопамяти, Мб | Скорость ядра, MHz | Частота памяти, МГц | Шина, бит |

| GTX1650 | Апрель 2019 | 4096 | 1485 | 8000 / 12000 | 128 |

| GTX1650 Super | Ноябрь 2019 | 4096 | 1530 | 12000 | 128 |

| GTX1660 | Март 2019 | 6144 | 1530 | 8000 | 192 |

| GTX1660 Super | Октябрь 2019 | 6144 | 1530 | 14000 | 192 |

| GTX1660 Ti | Февраль 2019 | 6144 | 1500 | 12000 | 192 |

Современная линейка, разработанная совсем недавно. Пока их мало, но, согласно анонсам Нвидиа, со временем будут добавлены устройства.

Пока их мало, но, согласно анонсам Нвидиа, со временем будут добавлены устройства.

| Модель | Дата выхода | Объем видеопамяти, Мб | Скорость ядра, MHz | Частота памяти, МГц | Шина, бит |

| RTX2060 | Январь 2019 | 6144 | 1365 | 14000 | 192 |

| RTX2060 Super | Июль 2019 | 8192 | 1400 | 14000 | 256 |

| RTX2070 | Октябрь 2018 | 8192 | 1410 | 14000 | 256 |

| RTX2080 | Сентябрь 2018 | 8192 | 1515 | 14000 | 256 |

| RTX2080 Ti | Сентябрь 2018 | 11264 | 1350 | 14000 | 352 |

| Titan RTX | Декабрь 2018 | 24576 | 1350 | 14000 | 384 |

Топовая линейка видеоадаптеров. Подходит не только для видеоигр, но и для серьезной работы с 3D графикой.

Также советую почитать «Частота или объем памяти – что важнее в видеокарте?» и «Узнаем производителя видеокарты: разные способы». Буду признателен всем, кто расшарит этот пост в социальных сетях. До завтра!

Буду признателен всем, кто расшарит этот пост в социальных сетях. До завтра!

С уважением, автор блога Андрей Андреев.

Какая видеокарта + процессор минимально нужны для проигрывания видео 1080p 30fps?ОГЛАВЛЕНИЕ

Декодирование WMV/VC-1/H.264 появилось в видеокартах, начиная с GeForce 7200 GS и Radeon HD 2000. Использование этих видеокарт означает, что центральный процессор может быть существенно разгружен, т.е. быть весьма старым. Точнее такой закон: при использовании видеокарт со встроенным H.264 декодером нужен процессор с тактовой частотой не ниже 1.5 ГГц. Например, отлично играeт 1080p-видео связка Radeon HD 2400 AGP + AMD Sempron 3000+ (1.8 GHz).

Если в видеокарте нет поддержки декодирования H.264, то нужен достаточно мощный центральный проц: 2.0-2.5 ГГц (одноядерный) для проигрывания хотя бы 720p. Для 1080p частота ЦП должна быть не менее 3.2-3.8 ГГц (зависит от того P4 это или Celeron + от мощности видеокарты).

Карты от nVIDIA, которые поддерживают третье поколение аппаратного видео декодирования и полное ускорение для MPEG-1, MPEG-2, VC-1/WMV9 и H. 264: GeForce 8400 GS — декабрь 2007 GeForce 8200, 8300 — январь 2008 GeForce 9300M GS, 9300 GS, 9300 GE GeForce 205, 210 — октябрь 2009 Серия GT, начиная с GeForce GT 220 и далее … Серия GTS, начиная с GeForce GTS 250M и далее … Серия GTX, начиная с GeForce GTX 465 (март 2010) и далее …

264: GeForce 8400 GS — декабрь 2007 GeForce 8200, 8300 — январь 2008 GeForce 9300M GS, 9300 GS, 9300 GE GeForce 205, 210 — октябрь 2009 Серия GT, начиная с GeForce GT 220 и далее … Серия GTS, начиная с GeForce GTS 250M и далее … Серия GTX, начиная с GeForce GTX 465 (март 2010) и далее …

Карты от AMD/ATI c полной поддержкой декодирования видео: Начиная с Radeon HD 2000 (июнь 2007) и далее (HD 2400, 2600, 3200, …), кроме HD 2900 (у этой нет декодирования видео совсем).

Наша история: инновации на протяжении многих лет

- Раздел

Подпишитесь на корпоративные новости, объявления и многое другое от NVIDIA.

Имя

Фамилия

Рабочий адрес электронной почты

Название организации/университета

Отрасль

Промышленность Аэрокосмическая промышленность Сельское хозяйство Архитектура / Инжиниринг / Строительство Автомобилестроение / Транспорт Облачные услуги Потребительский Интернет Энергетика Финансовые услуги Разработка игр Аппаратное обеспечение / Полупроводники Здравоохранение и науки о жизни Высшее образование / Академия HPC / Суперкомпьютеры Производство Медиа и развлечения Государственный сектор Розничная торговля Телекоммуникации Другое

Должность

Должность

Местоположение

Местонахождение Афганистан Албания Алжир Американское Самоа Андорра Ангола Ангилья Антарктида Антигуа и Барбуда Аргентина Армения Аруба Остров Вознесения Австралия Австрия Азербайджан Багамские острова Бахрейн Бангладеш Барбадос Беларусь Бельгия Белиз Бенин Бермудские острова Бутан Боливия Босния Ботсвана Остров Буве Бразилия Британская территория в Индийском океане Британские Виргинские острова Бруней Болгария Буркина-Фасо Бурунди Камбоджа Камерун Канада Канарские острова Кабо-Верде Карибские острова Нидерланды Каймановы острова Центральноафриканская Республика Сеута и Мелилья Чад Чили Китай Остров Рождества Остров Клиппертон Кокосовые острова (Килинг) Колумбия Коморские острова Конго (ДРК) Конго (Республика) Острова Кука Коста-Рика Хорватия Куба Кюрасао Кипр Чехия Дания Диего Гарсия Джибути Доминика Доминиканская Республика Восточный Тимор Эквадор Египет Сальвадор Экваториальная Гвинея Эритрея Эстония Эфиопия Европейский Союз Фолклендские острова (Мальвинские острова) Фарерские острова Фиджи Финляндия Франция Французская Гвиана Французская Полинезия Французские Южные территории Габон Гамбия Грузия Германия Гана Гибралтар Греция Гренландия Гренада Гваделупа Гуам Гватемала Гернси Гвинея Гвинея-Бисау Гайана Гаити Острова Херд и Макдональд Гондурас Гонконг Венгрия Исландия Индия Индонезия Иран Ирак Ирландия Остров Мэн Израиль Италия Берег Слоновой Кости Ямайка Япония Джерси Иордания Казахстан Кения Кирибати Косово Кувейт Кыргызстан Лаос Латвия Ливан Лесото Либерия Ливия Лихтенштейн Литва Люксембург Макао Македония (БЮРМ) Мадагаскар Малави Малайзия Мальдивы Мали Мальта Маршалловы острова Мартиника Мавритания Маврикий Майотта Мексика Микронезия Молдова Монако Монголия Монтсеррат Марокко Мозамбик Мьянма Намибия Науру Непал Нидерланды Нидерландские Антильские острова Новая Каледония Новая Зеландия Никарагуа Нигер Нигерия Ниуэ Остров Норфолк Северная Корея Северные Марианские острова Норвегия Оман Океания Океания Пакистан Палау Палестина Панама Папуа-Новая Гвинея Парагвай Перу Филиппины Острова Питкэрн Польша Португалия Пуэрто-Рико Катар Румыния Россия Руанда Реюньон Самоа Сан-Марино Саудовская Аравия Сенегал Сербия Сейшельские острова Сьерра-Леоне Сингапур Синт-Мартен Словакия Словения Соломоновы острова Сомали Южная Африка Южная Грузия и Южные Сандвичевы острова Южная Корея Южный Судан Испания Шри Ланка Сен-Бартелеми Сент-Хелена Сент-Китс и Невис Сент-Люсия Сен-Мартен Сен-Пьер и Микелон Сент-Винсент и Гренадины Судан Суринам Шпицберген и Ян-Майен Свазиленд Швеция Швейцария Сирия Сан-Томе и Принсипи Тайвань Таджикистан Танзания Таиланд Того Токелау Тонга Тринидад и Тобаго Тристан-да-Кунья Тунис Турция Туркменистан Острова Теркс и Кайкос Тувалу Отдалённые острова США Виргинские острова США Уганда Украина Объединенные Арабские Эмираты Великобритания США Уругвай Узбекистан Вануату Ватикан Венесуэла Вьетнам Уоллис и Футуна Западная Сахара Йемен Замбия Зимбабве Аландские острова

Предпочтительный язык

Предпочтительный язык Китайский (упрощенный) Китайский (традиционный) Чешский Датский Голландский Английский (Австралия) Английский (Великобритания) Английский (Индия) Английский (Малайзия) Английский (Филиппины) Английский (Сингапур) Английский (США) Финский Французский Французский (Бельгия) Немецкий Немецкий ( Австрия) Индонезийский Итальянский Японский Корейский Нидерланды (Бельгия) Норвежский Польский Португальский (Бразилия) Русский Испанский (Латинская Америка) Испанский (Испания) Шведский Тайский Турецкий Вьетнамский

Штат/провинция

Штат/область

nvid hidden field

本人知悉且同意 Корпорация NVIDIA并同意 nvidia.cn/about-nvidia/privacy-policy /» target=»_blank»>Ответ NVIDIA。

NVIDIA 内部管理和系统操作的需要,上述信息会被传输到位于美国的 NVIDIA Corporation 按照符合

История графических процессоров Nvidia: от NV1 до Turing

Когда вы покупаете по ссылкам на нашем сайте, мы можем получать партнерскую комиссию. Вот как это работает.

NV1: Nvidia выходит на рынок

Nvidia образовалась в 1993 году и сразу же начала работу над своим первым продуктом NV1. На разработку NV1 ушло два года, и в 1995 году был официально выпущен NV1. Инновационный для своего времени набор микросхем, NV1 был способен обрабатывать как 2D, так и 3D-видео вместе с включенным аппаратным обеспечением для обработки звука. После решения Sega использовать NV1 внутри своей игровой консоли Saturn, Nvidia также включила поддержку контроллера Saturn, что позволило графическим картам для настольных ПК также использовать контроллер.

Уникальным аспектом графического ускорителя NV1 является то, что он использует квадратичные поверхности в качестве основного геометрического примитива. Это создало трудности для разработчиков игр, чтобы добавить поддержку NV1 или разработать игры для него. Это стало еще более проблематичным, когда Microsoft выпустила свою первую версию игрового API DirectX, которая была разработана с использованием полигонов в качестве основного геометрического примитива.

Карты для настольных ПК использовали общий интерфейс PCI с пропускной способностью 133 МБ/с. Карты могли использовать память EDO с тактовой частотой до 75 МГц, а графический ускоритель поддерживал максимальное разрешение 1600×1200 с 16-битным цветом. Благодаря сочетанию продаж Sega Saturn и рынка настольных компьютеров Nvidia смогла остаться в бизнесе, но NV1 не имела особого успеха. Его графическая и звуковая производительность были тусклыми, а различные аппаратные компоненты делали его дорогим по сравнению с другими графическими ускорителями.

Nvidia начала работу над NV2 в качестве преемника NV1, но после ряда разногласий с Sega Sega решила использовать технологию PowerVR в своей консоли Dreamcast, и выпуск NV2 был отменен.

БОЛЬШЕ: Лучшие видеокарты

БОЛЬШЕ: Иерархическая таблица производительности GPU для настольных ПК

NV3: Riva 128

как NV3, выпущенный в 1997 году и пользовавшийся большим успехом. Он перешел от использования четырехугольников в качестве основного геометрического примитива к гораздо более распространенному многоугольнику. Это упростило добавление поддержки Riva 128 в игры. Графический процессор также использовал наложение текстур полигонов со смешанными результатами. Это позволило графическому процессору быстрее отображать кадры, но снизило качество изображения.

Графический процессор был доступен в двух основных вариантах: Riva 128 и Riva 128ZX. В графических ускорителях Riva 128ZX использовались более качественные бинарные чипы, что позволило Nvidia поднять частоту RAMDAC. В обеих моделях использовалась память SDRAM с тактовой частотой 100 МГц, доступ к которой осуществлялся по 128-битной шине, что давало графическим процессорам пропускную способность 1,6 ГБ/с. Однако чипы Riva 128ZX имели 8 МБ видеопамяти по сравнению с 4 МБ у Riva 128. Riva 128ZX также работала с более высокой тактовой частотой 250 МГц по сравнению с 206 МГц у Riva 128.

В обеих моделях использовалась память SDRAM с тактовой частотой 100 МГц, доступ к которой осуществлялся по 128-битной шине, что давало графическим процессорам пропускную способность 1,6 ГБ/с. Однако чипы Riva 128ZX имели 8 МБ видеопамяти по сравнению с 4 МБ у Riva 128. Riva 128ZX также работала с более высокой тактовой частотой 250 МГц по сравнению с 206 МГц у Riva 128.

Эти графические процессоры были довольно популярны, поскольку они были способны к ускорению как 2D-, так и 3D-графики, хотя их тактовая частота была ниже, чем у альтернатив от ведущего конкурента Nvidia, 3dfx.

NV4: Заговор с целью сбросить бомбу

В 1998 году Nvidia представила свою самую взрывоопасную карту на сегодняшний день, Riva TNT (кодовое название «NV4»). Подобно NV3, NV4 мог отображать как 2D-, так и 3D-графику. Nvidia улучшила NV3, включив поддержку 32-битного «True Color», расширив ОЗУ до 16 МБ SDR SDRAM и увеличив производительность. Хотя слот AGP становился все более популярным, в большом количестве систем его не было, поэтому Nvidia продавала NV4 в основном как графический ускоритель PCI и производила относительно небольшое количество AGP-совместимых карт..png) Начиная с Riva TNT, Nvidia приложила большие усилия для регулярного обновления своих драйверов, чтобы улучшить совместимость и производительность.

Начиная с Riva TNT, Nvidia приложила большие усилия для регулярного обновления своих драйверов, чтобы улучшить совместимость и производительность.

На момент выпуска Voodoo2 от 3dfx держал корону по производительности, но был относительно дорогим и ограничивался 16-битным цветом. Для Voodoo2 также требовалась отдельная 2D-видеокарта, что еще больше повышало стоимость владения. В 1990-х годах потребность в отдельной 2D-видеокарте была обычным явлением, но, поскольку Riva TNT могла обрабатывать как 2D-, так и 3D-видео, эта карта была значительно более экономичной, чем Voodoo2.

Nvidia планировала выпустить Riva TNT с тактовой частотой 125 МГц, пытаясь отобрать корону производительности у Voodoo2, но ядро просто перегревалось и было недостаточно стабильным. Вместо этого Nvidia была вынуждена отгрузить 90 МГц с оперативной памятью, работающей на частоте 110 МГц, в результате чего Riva TNT работает медленнее, чем Vodoo2. Riva TNT по-прежнему предлагала достойную производительность для своего времени, а после выпуска драйверов Nvidia «Detonator» производительность значительно увеличилась, что сделало его еще более конкурентоспособным.

В целом, Riva TNT был чрезвычайно успешным благодаря своим характеристикам и функциям. Увеличенная поддержка драйверов от Nvidia также помогла привлечь клиентов, поскольку любой в 1990-х может рассказать вам, каким кошмаром было раньше иметь дело с драйверами.

NV5: Еще один взрыв

В 1999 году Nvidia еще раз захватил корону производительности с Riva TNT2 (кодовое название «NV5»). Riva TNT2 был архитектурно похож на оригинальный Riva TNT, но благодаря улучшенному движку рендеринга он мог работать примерно на 10–17 процентов быстрее, чем его предшественник, при той же тактовой частоте. Nvidia также добавила поддержку слотов AGP 4X, что увеличило пропускную способность карты, и удвоила объем видеопамяти до 32 МБ. Вероятно, самым значительным улучшением стал переход на 250 нм, что позволило Nvidia разогнать Riva TNT2 до 175 МГц.

Основным конкурентом Riva TNT2 была компания 3dfx Vodoo3. Эти два продукта обменивались ударами друг с другом в течение многих лет, но ни одна из карт не была явным победителем с точки зрения производительности или возможностей.

NV10: используйте GeForce Luke!

В конце 1999 года Nvidia анонсировала GeForce 256 (кодовое название «NV10»). До GeForce 256 практически все видеокарты назывались «графическими ускорителями» или просто «видеокартами», но Nvidia решила называть GeForce 256 «графическим процессором». С этой картой Nvidia добавила несколько новых функций, включая аппаратную обработку T&L (преобразование и освещение), которая позволила графическому процессору выполнять вычисления, которые обычно выполнялись центральным процессором. Поскольку T&L Engine был аппаратным обеспечением с фиксированными функциями, разработанным специально для этой задачи, его пропускная способность была примерно в пять раз выше, чем у высокопроизводительного процессора Pentium III с тактовой частотой 550 МГц.

Дизайн также отличался от Riva TNT2 тем, что содержал четыре пиксельных конвейера вместо двух. Он не мог сравниться с тактовой частотой Riva TNT2, но из-за дополнительных конвейеров он все еще мог работать примерно на 50% быстрее, чем его предшественник. Графический процессор также был первой картой Nvidia, в которой использовалось от 32 до 64 МБ DDR SDRAM, что способствовало увеличению его производительности. Транзисторы графического процессора уменьшились до 220 нм, а само ядро работало на частоте 120 МГц, а частота оперативной памяти варьировалась от 150 до 166 МГц.

Графический процессор также был первой картой Nvidia, в которой использовалось от 32 до 64 МБ DDR SDRAM, что способствовало увеличению его производительности. Транзисторы графического процессора уменьшились до 220 нм, а само ядро работало на частоте 120 МГц, а частота оперативной памяти варьировалась от 150 до 166 МГц.

GeForce 256 также представляет собой первый раз, когда Nvidia включила аппаратное ускорение видео, но оно было ограничено ускорением движения для контента MPEG-2.

NV11, NV15, NV16: GeForce2

Вслед за NV10 GeForce 256 компания Nvidia выпустила GeForce2. Архитектура GeForce2 была похожа на ее предшественницу, но Nvidia смогла удвоить количество TMU, подключенных к каждому пиксельному конвейеру, еще больше уменьшив кристалл с помощью 180-нм транзисторов. Nvidia использовала три разных ядра под кодовыми названиями NV11, NV15 и NV16 внутри карт под маркой GeForce2. Все эти ядра использовали одинаковую архитектуру, но NV11 содержал всего два пиксельных конвейера, тогда как ядра NV15 и NV16 имели четыре, а NV16 работал на более высоких тактовых частотах, чем NV15.

GeForce2 также была первой линейкой Nvidia, поддерживающей конфигурации с несколькими мониторами. Графические процессоры GeForce2 были доступны как с памятью SDR, так и с памятью DDR.

NV20: GeForce3

В 2001 году GeForce3 (под кодовым названием «NV20») стала первой картой Nvidia, совместимой с DirectX 8. Ядро содержало 60 миллионов транзисторов, изготовленных по 150-нм техпроцессу, которые могли работать на частоте до 250 МГц. Nvidia представила новую подсистему памяти на GeForce3 под названием «Lightspeed Memory Architecture» (LMA), которая была разработана для сжатия Z-буфера и снижения общей потребности в ограниченной пропускной способности памяти. Он также был разработан для ускорения FSAA с использованием специального алгоритма под названием «Quincunx». Общая производительность была выше, чем у GeForce2, но из-за сложности графического процессора он был довольно дорогим в производстве и, следовательно, имел высокую цену по сравнению с ним.

NV2A: Nvidia и Xbox

Nvidia снова окажется на рынке домашних консолей в качестве ключевого компонента оригинальной Xbox от Microsoft в 2001 году. ПК в то время, а графический процессор, разработанный Nvidia, был, по сути, модифицированной GeForce3. Как и графический процессор NV20, NV2A внутри Xbox содержит четыре пиксельных конвейера с двумя TMU в каждом. Nvidia также создала аудиооборудование для Xbox, известное как MCPX или «SoundStorm».

ПК в то время, а графический процессор, разработанный Nvidia, был, по сути, модифицированной GeForce3. Как и графический процессор NV20, NV2A внутри Xbox содержит четыре пиксельных конвейера с двумя TMU в каждом. Nvidia также создала аудиооборудование для Xbox, известное как MCPX или «SoundStorm».

NV17: GeForce4 (часть 1)

В 2002 году Nvidia начала вносить изменения, представив несколько графических процессоров на основе разных архитектур. Все они были обозначены как GeForce4. На нижнем уровне стека GeForce4 находился NV17, который по сути представлял собой кристалл NV11 GeForce2, уменьшенный за счет использования 150-нм транзисторов и работающий на частоте от 250 до 300 МГц. Это был значительно более простой дизайн по сравнению с NV20, что делало его доступным продуктом, который Nvidia могла продвигать как на мобильные, так и на настольные рынки.

Позже Nvidia выпустила две версии ядра NV17, названные NV18 и NV19. NV18 имел модернизированную шину до AGP 8X, тогда как NV19 по сути был чипом NV18 с мостом PCIe для поддержки каналов x16. Память DDR на этих чипах работала с тактовой частотой от 166 до 667 МГц.

Память DDR на этих чипах работала с тактовой частотой от 166 до 667 МГц.

NV25: GeForce4 (Часть 2)

Поскольку NV17 охватывает нижнюю половину рынка, Nvidia выпустила NV25 для покрытия high-end. NV25 был разработан как улучшение архитектуры GeForce3 и, по сути, имел те же ресурсы с четырьмя пиксельными конвейерами, восемью TMU и четырьмя ROP. Однако в NV25 было вдвое больше вершинных шейдеров (увеличение с одного до двух), и в нем использовалась обновленная система LMA-II. В целом NV25 содержит 63 миллиона транзисторов, всего на 3 миллиона больше, чем GeForce3. Тактовая частота GeForce4 NV25 также была выше, чем у GeForce3, в диапазоне от 225 до 300 МГц. Память DDR объемом 128 МБ работала на частоте от 500 до 650 МГц.

Тесты NV25 в играх DirectX 7 показали скромный прирост производительности по сравнению с GeForce3 примерно на 10%. Однако в играх DirectX 8, использующих преимущества вершинных шейдеров, преимущество NV25 в производительности выросло до 38%.

Позже Nvidia выпустила переработанный чип NV25, названный NV28. Подобно NV18, упомянутому на последнем слайде, NV28 отличается от NV25 только поддержкой AGP 8X.

БОЛЬШЕ: Насколько хорошо видеокарты для рабочих станций играют в игры?

NV30: FX 5000 (часть 1)

В 2002 году игровой мир приветствовал появление Microsoft DirectX 9 API, который в течение нескольких лет был одним из наиболее часто используемых и влиятельных игровых API. ATI и Nvidia изо всех сил пытались разработать оборудование, совместимое с DX9, а это означало, что новые графические процессоры должны были поддерживать Pixel Shader 2.0. ATI опередила Nvidia на рынке в августе 2002 года со своими первыми картами с поддержкой DX9, но к концу 2002 года Nvidia выпустила серию FX 5000.

Хотя Nvidia выпустила свои карты DX 9 позже, чем ATI, они поставлялись с несколькими дополнительными функциями, которые Nvidia использовала для привлечения разработчиков игр.

Созданный с использованием 130-нм транзисторов, NV30 работал на частотах от 400 до 500 МГц и имел доступ к 128 или 256 МБ оперативной памяти DDR2 через 128-битную шину, работающую на частотах 800 или 1000 МГц. Сам NV30 продолжал использовать четырехконвейерную конструкцию с двумя вершинными шейдерами, восемью TMU и четырьмя ROP. Nvidia последовала за ним с более дешевыми вариантами, которые имели четыре пиксельных конвейера и только один вершинный шейдер, четыре TMU и четыре ROP и могли использовать менее дорогую память DDR.

Ваш комментарий будет первым