6 лучших графических процессоров Nvidia всех времен

Nvidia устанавливает стандарты для своих игровых видеокарт настолько высоко, что на самом деле трудно определить разницу между графическим процессором Nvidia, который просто выигрывает, и графическим процессором Nvidia, который действительно особенный.

Содержание

- GeForce 256

- GeForce 8800 GTX

- GeForce GTX 680

- GeForce GTX 980

- GeForce GTX 1080 GeForce TX 007 Что дальше?

Nvidia долгое время была доминирующим игроком на рынке видеокарт, но время от времени компания подвергалась серьезному давлению со стороны своего основного конкурента AMD, которая выпустила несколько собственных культовых графических процессоров. Однако это только подготовило Nvidia к крупному возвращению, а иногда это приводило к реальным изменениям в игре.

Было трудно выбрать, какие графические процессоры Nvidia действительно достойны называться лучшими всех времен, но я сузил список до шести карт, которые были действительно важны и вошли в историю.

GeForce 256

Самый первый

VGA MuseumХотя Nvidia часто утверждает, что GeForce 256 был первым в мире графическим процессором, это верно только в том случае, если Nvidia — единственная компания, которая определяет, что такое графический процессор. До GeForce существовала серия видеокарт RIVA, и тогда были и другие компании, производившие свои собственные конкурирующие видеокарты. Что действительно изобрела Nvidia, так это маркетинг видеокарт как GPU, потому что в 1999, когда вышел 256, такие термины, как видеокарта и графический чипсет, были более распространены.

Однако Nvidia права в том, что 256 был важен. До 256 ЦП играл очень важную роль в рендеринге графики до такой степени, что ЦП непосредственно выполнял шаги по рендерингу 3D-среды. Однако центральные процессоры были не очень эффективны для этого, и именно здесь появился 256 с аппаратным преобразованием и освещением, переложив две наиболее ресурсоемкие части рендеринга на графический процессор.

Как продукт GeForce 256 нельзя назвать легендарным: Anandtech не была впечатлена соотношением цены и производительности на момент выпуска. Частично проблема заключалась в памяти 256-го, которая имела одинарную скорость передачи данных или SDR. Из-за других достижений SDR становилось недостаточно для графических процессоров такого уровня производительности. Более быстрая двойная скорость передачи данных или DDR (та же DDR, что и в DDR5) была запущена незадолго до конца 1999 года, что, наконец, оправдало ожидания Anandtech в отношении производительности, но повышенную цену версии DDR было трудно проглотить.

GeForce 256, первое в своем названии, безусловно, является историческим, но не потому, что это был удивительный продукт. 256 важен, потому что он открыл современную эру графических процессоров. Рынок видеокарт не всегда был дуополией; еще в 90-х годах было несколько компаний, конкурирующих друг с другом, и Nvidia была лишь одной из них.

К концу 2000 года единственной графической компанией в городе была ATI. Когда AMD приобрела ATI в 2006 году, это привело к современному соперничеству Nvidia и AMD, которое мы все знаем сегодня.

GeForce 8800 GTX

Монументальный скачок вперед

VGA Museum После GeForce 256 Nvidia и ATI попытались превзойти друг друга, выпустив более новые графические процессоры с более высокой производительностью. Однако в 2002 году ATI бросила перчатку, выпустив серию Radeon 9000 и флагманский Radeon 9 с квадратным размером кристалла 200 мм.800 XT был самым большим графическим процессором за всю историю. У флагмана Nvidia GeForce4 Ti 4600 на 100 мм не было никакой надежды победить даже средний 9700 Pro, который нанес Nvidia сокрушительное поражение.

В течение следующих четырех лет размер флагманских GPU продолжал увеличиваться, и к 2005 году обе компании выпустили GPU размером около 300 мм. Хотя за это время Nvidia вернула себе преимущество, ATI никогда не отставала, и ее серия Radeon X1000 была довольно конкурентоспособной. Однако размер графического процессора в 300 мм был далеко не пределом возможностей Nvidia. В 2006 году Nvidia выпустила серию GeForce 8 во главе с флагманской 8800 GTX. Его графический процессор под кодовым названием G80 был почти 500 мм, а количество транзисторов было почти в три раза больше, чем у последнего флагмана GeForce.

8800 GTX сделала с ATI то же, что Radeon 9700 Pro и остальная часть серии 9000 сделали с Nvidia, при этом Anandtech назвал этот момент «подобным 9700 Pro». Одиночный 8800 GTX был почти в два раза быстрее, чем топовый X1950 XTX от ATI, не говоря уже о том, что он намного эффективнее. При цене 599 долларов 8800 GTX была дороже своих предшественников, но ее высокая производительность и поддержка DirectX 10 компенсировали это.

При цене 599 долларов 8800 GTX была дороже своих предшественников, но ее высокая производительность и поддержка DirectX 10 компенсировали это.

Но в основном это был конец большой гонки вооружений на GPU, которая характеризовала начало 2000-х годов по двум основным причинам. Во-первых, 500 мм приближались к пределу размера графического процессора, и даже сегодня 500 мм — это относительно много для процессора. Даже если бы Nvidia захотела, сделать GPU большего размера было просто невозможно. Во-вторых, ATI в любом случае не работала над собственным 500-миллиметровым графическим процессором, поэтому Nvidia не торопилась выводить на рынок еще более крупный графический процессор. Nvidia фактически выиграла гонку вооружений, обойдя ATI.

В том же году AMD приобрела ATI, что было завершено непосредственно перед выпуском 8800 GTX. Хотя у ATI теперь была поддержка AMD, действительно казалось, что у Nvidia такое огромное преимущество, что Radeon не сможет бросить вызов GeForce в течение долгого времени, возможно, никогда больше.

GeForce GTX 680

Победить AMD в собственной игре

NvidiaСледующий знаменательный релиз Nvidia состоялся в 2008 году, когда она выпустила серию GTX 200, начиная с GTX 280 и GTX 260. Имея площадь почти 600 мм в квадрате, 280 была достойным чудовищным преемником 8800 GTX. Тем временем AMD и ATI дали понять, что они больше не будут выпускать высокопроизводительные графические процессоры с большими кристаллами, чтобы конкурировать, а сосредоточатся на создании меньших графических процессоров в гамбите, известном как стратегия малых кристаллов. В своем обзоре Anandtech заявила, что «Nvidia останется наедине с максимальной производительностью в обозримом будущем». Как оказалось, следующие четыре года были довольно тяжелыми для Nvidia.

Начиная с серии HD 4000 в 2008 году, AMD атаковала Nvidia небольшими графическими процессорами, которые имели высокую стоимость и почти флагманский уровень производительности, и эта динамика сохранялась на протяжении нескольких следующих поколений. GTX 280 от Nvidia была недостаточно рентабельна, затем серия GTX 400 была отложена, а серия 500 была слишком горячей и прожорливой.

GTX 280 от Nvidia была недостаточно рентабельна, затем серия GTX 400 была отложена, а серия 500 была слишком горячей и прожорливой.

Одной из традиционных слабых сторон Nvidia был ее недостаток, когда речь шла об обработке, способе производства процессоров. Nvidia обычно отставала от AMD, но, наконец, догнала ее, использовав 40-нм техпроцесс для серии 400. AMD, однако, хотела быстро вернуть лидерство в технологическом процессе и решила, что ее следующее поколение будет на новом 28-нм узле, и Nvidia решила последовать ее примеру.

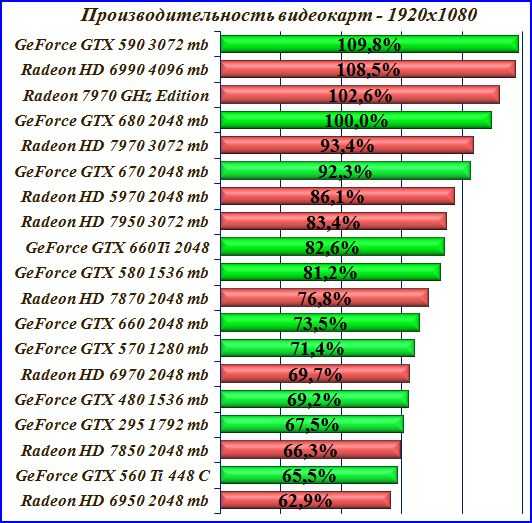

AMD выиграла гонку за 28-нм техпроцесс со своей серией HD 7000, а ее флагманский HD 7970 вернул AMD на первое место по производительности. Однако GTX 680 была выпущена всего двумя месяцами позже и превзошла 7970 не только по производительности, но и по энергоэффективности и даже по размеру кристалла. Как выразилась Anandtech, Nvidia «получила техническую тройку», и это полностью изменило ситуацию с AMD. AMD снова вернула себе корону производительности, выпустив позже в 2012 году HD 7970 GHz Edition (известную как первый графический процессор с частотой 1 ГГц), но лидерство в эффективности и производительности на миллиметр было хорошим знаком для Nvidia.

Битва между Nvidia и AMD была довольно захватывающей после того, как разочаровывали серии GTX 400 и 500, и хотя 680 не была GTX 8800, это сигнализировало о возвращении Nvidia к действительной конкурентоспособности с AMD. Возможно, важнее всего то, что Nvidia больше не тяготила проблема традиционного процесса, и это в конечном итоге окупилось с лихвой.

GeForce GTX 980

Начало доминирования Nvidia

Билл Роберсон/Digital Trends Nvidia оказалась в очень хорошем положении с серией GTX 600 благодаря 28-нм техпроцессу TSMC. При нормальных обстоятельствах AMD просто обратилась бы к очередному процессу TSMC, чтобы вернуть себе традиционное преимущество, но такой возможности больше не было. TSMC и все другие производители в мире (кроме Intel) столкнулись с огромными трудностями при выходе за пределы 28-нм узла. Для дальнейшего прогресса требовались новые технологии, а это означало, что Nvidia не нужно было беспокоиться о том, что AMD в ближайшее время вернет лидерство в технологическом процессе.

После нескольких лет метаний взад-вперед, когда AMD боролась с ограниченными средствами, Nvidia выпустила серию GTX 900 в 2014 году, открытую GTX 980. Основанная на новой архитектуре Maxwell, это был невероятный шаг вперед по сравнению с сериями GTX 600 и 700. несмотря на то, что он находится на одном узле. 980 был на 30-40% быстрее, чем 780, потребляя при этом меньше энергии, и даже немного быстрее, чем топовый 780 Ti. Конечно, 980 также превзошел R9 290X, снова получив тройное преимущество производительности, энергоэффективности и размера кристалла. В своем обзоре Anandtech сообщила, что 980 была «очень, очень близка к тому, чтобы сделать с Radeon 290X то, что GTX 680 сделала с Radeon HD 7970».

драм не смог ответить. В 2014 году у нее не было графического процессора следующего поколения, готового к выпуску. Фактически, AMD даже не работала над полной линейкой совершенно новых графических процессоров, чтобы сравняться с Nvidia. Вместо этого AMD планировала переименовать серию Radeon 200 в серию Radeon 300 и разработать один новый графический процессор, который станет флагманом. Все эти графические процессоры должны были быть запущены в середине 2015 года, что почти на целый год отдало весь рынок графических процессоров Nvidia. Конечно, Nvidia захотела выбить почву из-под ног AMD и подготовила новенький флагман.

Все эти графические процессоры должны были быть запущены в середине 2015 года, что почти на целый год отдало весь рынок графических процессоров Nvidia. Конечно, Nvidia захотела выбить почву из-под ног AMD и подготовила новенький флагман.

Выпущенная в середине 2015 года видеокарта GTX 980 Ti была примерно на 30 % быстрее, чем GTX 980, благодаря значительно более высокому энергопотреблению и большему размеру кристалла (чуть более 600 мм в квадрате). Он превзошел совершенно новый AMD R9 Fury X за месяц до его запуска. Хотя Fury X был неплох, у него была более низкая производительность, чем у 980 Ti, более высокое энергопотребление и гораздо меньше видеопамяти. Это была демонстрация того, насколько далеко Nvidia ушла вперед с серией 900; в то время как AMD поспешно пыталась выпустить Fury X, Nvidia могла выпустить 980 Ti в любое время.

Anandtech очень хорошо выразился: «Тот факт, что они подходят так близко только для того, чтобы Nvidia снова переиграла их, делает текущую ситуацию еще более болезненной; одно дело проигрывать Nvidia в футах, но проигрывать в дюймах только напоминает вам о том, как близко они подобрались, как они почти расстроили Nvidia».

Nvidia фактически на год опережала AMD в технологическом отношении, и хотя то, что они сделали с серией GTX 900, было впечатляющим, это также было немного удручающим. Люди хотели увидеть противостояние Nvidia и AMD, как это было в 2012 и 2013 годах, но казалось, что все это осталось в прошлом. Следующий графический процессор Nvidia, безусловно, подтвердит это чувство.

GeForce GTX 1080

Графический процессор без конкурентов, кроме самого себя

Nvidia В 2015 году TSMC, наконец, завершила 16-нм техпроцесс, который позволил достичь тактовой частоты на 40% выше, чем 28-нм, при той же мощности или в два раза меньше, чем 28-нм, при той же тактовой частоте. Однако Nvidia планировала перейти на 16-нанометровый техпроцесс в 2016 году, когда узел станет более зрелым. Между тем, у AMD не было абсолютно никаких планов использовать 16-нм техпроцесс TSMC, а вместо этого перешла к выпуску новых графических процессоров и процессоров на 14-нм техпроцессе GlobalFoundries. Но не верьте названиям: 16-нм техпроцесс TSMC был и остается лучше, чем 14-нанометровый техпроцесс GlobalFoundries. После 28 нм номенклатура процессов стала основываться на маркетинге, а не на научных измерениях. Это означало, что впервые в современной истории графических процессоров у Nvidia было технологическое преимущество перед AMD.

Но не верьте названиям: 16-нм техпроцесс TSMC был и остается лучше, чем 14-нанометровый техпроцесс GlobalFoundries. После 28 нм номенклатура процессов стала основываться на маркетинге, а не на научных измерениях. Это означало, что впервые в современной истории графических процессоров у Nvidia было технологическое преимущество перед AMD.

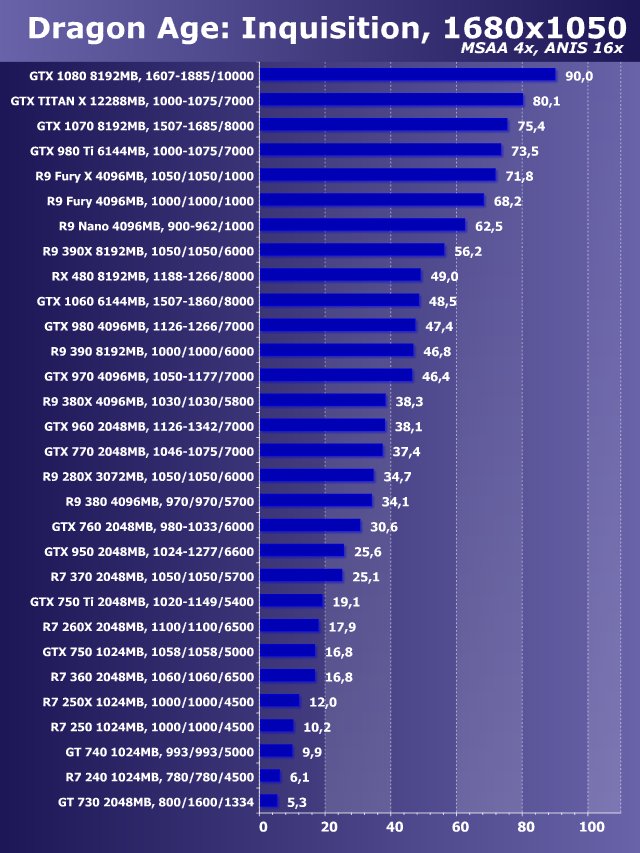

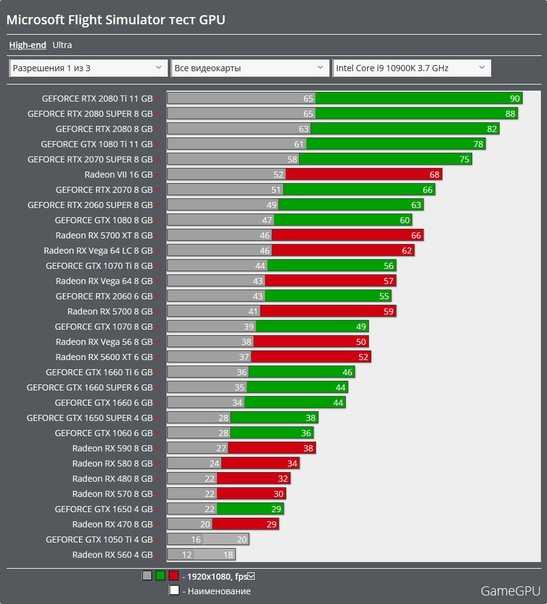

Серия GTX 10, выпущенная в середине 2016 года, основана на новой архитектуре Pascal и 16-нм узле TSMC. Паскаль на самом деле не сильно отличался от Максвелла, но скачок с 28 нм на 16 нм был огромным, как Intel перешла с 14 нм на Skylake на 10 нм на Alder Lake. GTX 1080 была новым флагманом, и трудно переоценить ее скорость. Когда GTX 980 вышла, она была немного быстрее, чем GTX 780 Ti. В отличие от этого, GTX 1080 была более чем на 30% быстрее, чем GTX 980 Ti, а также на 50 долларов дешевле. Размер кристалла 1080 также был чрезвычайно впечатляющим, чуть более 300 мм в квадрате, что почти вдвое меньше размера 9.80 Ти.

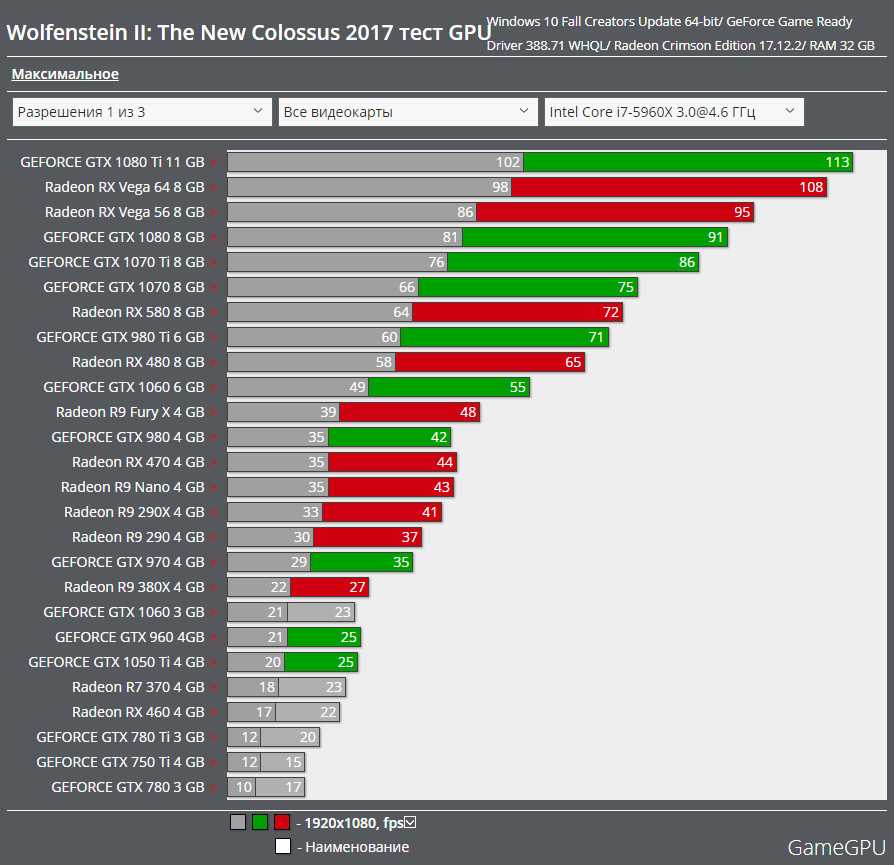

Выпустив 1080 и остальную часть линейки 10-й серии, Nvidia фактически захватила весь рынок графических процессоров для настольных ПК. Серия AMD 300 и Fury X просто не могли сравниться. В среднем диапазоне AMD выпустила серию RX 400, но это были всего три графических процессора низкого и среднего уровня, которые были возвратом к стратегии малых кристаллов, за исключением той части, где флагман Nvidia был на расстоянии удара, как с GTX 280 и HD. 4870. На самом деле, 1080 была почти в два раза быстрее, чем RX 480. Единственным графическим процессором, который AMD действительно могла превзойти, была GTX 1060 среднего уровня, так как слегка урезанная GTX 1070 была слишком быстрой, чтобы проигрывать Fury. Х.

Серия AMD 300 и Fury X просто не могли сравниться. В среднем диапазоне AMD выпустила серию RX 400, но это были всего три графических процессора низкого и среднего уровня, которые были возвратом к стратегии малых кристаллов, за исключением той части, где флагман Nvidia был на расстоянии удара, как с GTX 280 и HD. 4870. На самом деле, 1080 была почти в два раза быстрее, чем RX 480. Единственным графическим процессором, который AMD действительно могла превзойти, была GTX 1060 среднего уровня, так как слегка урезанная GTX 1070 была слишком быстрой, чтобы проигрывать Fury. Х.

AMD в конечном итоге выпустила новые высокопроизводительные графические процессоры в форме RX Vega, спустя целый год после выхода 1080. При гораздо более высоком энергопотреблении и той же продажной цене флагманская видеокарта RX Vega 64 превосходила GTX 1080 на волосок, но была не очень конкурентоспособной. Однако GTX 1080 больше не была флагманом Nvidia; имея относительно небольшой размер кристалла и целый год на подготовку, Nvidia выпустила совершенно новый флагман за целых три месяца до запуска RX Vega; это было повторение 980 Ti. Новая GTX 1080 Ti была даже быстрее, чем GTX 1080, обеспечив еще 30-процентное повышение производительности. По словам Anandtech, 1080 Ti «еще больше укрепит [d] доминирование Nvidia на рынке высококачественных видеокарт».

Новая GTX 1080 Ti была даже быстрее, чем GTX 1080, обеспечив еще 30-процентное повышение производительности. По словам Anandtech, 1080 Ti «еще больше укрепит [d] доминирование Nvidia на рынке высококачественных видеокарт».

Неспособность AMD создать действительно конкурентоспособный высококачественный графический процессор означала, что единственным реальным конкурентом 1080 была собственная GTX 1080 Ti от Nvidia. С 1080 и 1080 Ti Nvidia добилась, пожалуй, самой полной победы, которую мы когда-либо видели в современной истории графических процессоров. За последние 4 года Nvidia продолжала наращивать свое технологическое преимущество над AMD, и было сложно представить, как Nvidia может когда-либо проиграть.

GeForce RTX 3080

Коррекция курса

После такой долгой и невероятной серии побед, возможно, было неизбежно, что Nvidia поддастся высокомерию и упустит из виду то, что сделало великие графические процессоры Nvidia такими великими. Nvidia не последовала за серией GTX 10 с еще одним графическим процессором с потрясающим увеличением производительности, а выпустила печально известную серию RTX 20. Возможно, стремясь вытеснить AMD с рынка графических процессоров, Nvidia сосредоточилась на внедрении аппаратного ускорения трассировки лучей и искусственного интеллекта. апскейлинг вместо повышения производительности в целом. В случае успеха Nvidia может сделать графические процессоры AMD неактуальными, пока компания, наконец, не выпустит графические процессоры Radeon со встроенной трассировкой лучей.

Возможно, стремясь вытеснить AMD с рынка графических процессоров, Nvidia сосредоточилась на внедрении аппаратного ускорения трассировки лучей и искусственного интеллекта. апскейлинг вместо повышения производительности в целом. В случае успеха Nvidia может сделать графические процессоры AMD неактуальными, пока компания, наконец, не выпустит графические процессоры Radeon со встроенной трассировкой лучей.

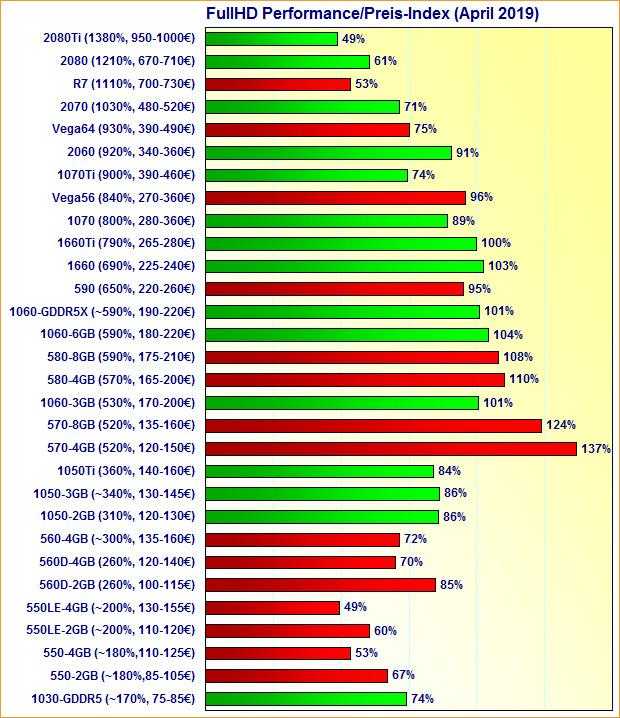

RTX 20-й серии был чем-то вроде провала. Когда в конце 2018 года были выпущены RTX 2080 и 2080 Ti, не было даже игр, поддерживающих трассировку лучей или суперсэмплинг глубокого обучения (DLSS). Но Nvidia оценивала карты RTX 20-й серии так, как будто эти функции имели значение. При цене 699 долларов у 2080 была бессмысленная цена, а цена 2080 Ti в 1199 долларов была еще более безумной. Nvidia больше не конкурировала даже сама с собой.

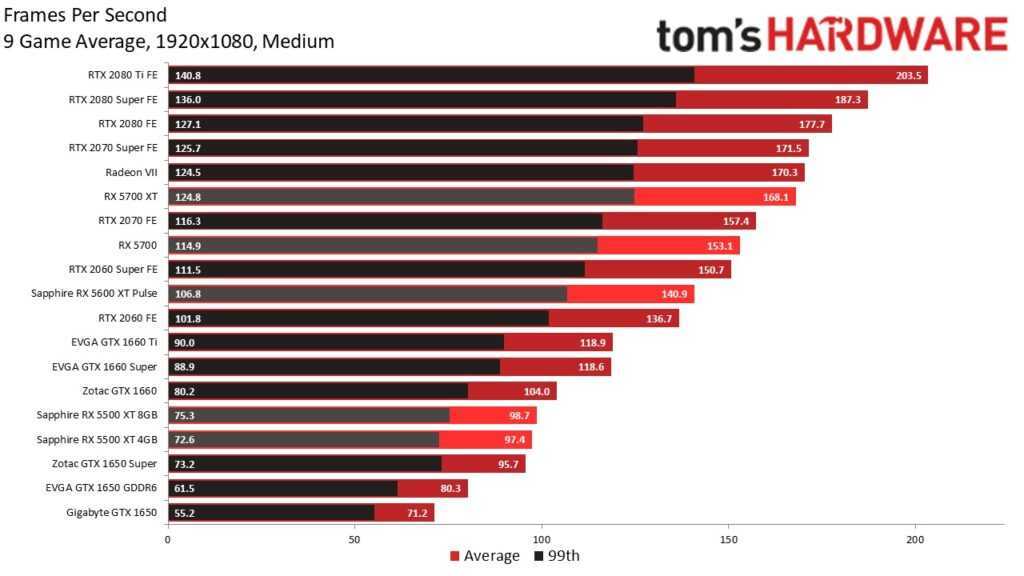

Повышение производительности в существующих играх тоже крайне разочаровало; RTX 2080 была всего на 11% быстрее, чем GTX 1080, хотя, по крайней мере, RTX 2080 Ti была примерно на 30% быстрее, чем GTX 1080 Ti.

Следующие два года были коррекцией курса для Nvidia. Угроза со стороны AMD начала становиться довольно серьезной; компания, наконец, восстановила технологическое преимущество, перейдя на 7-нм техпроцесс TSMC, и в середине 2019 года компания выпустила RX 5700 XT. Nvidia снова смогла предотвратить это, выпустив новые графические процессоры, на этот раз серию RTX 20 Super с упором на стоимость, но 5700 XT, должно быть, обеспокоил Nvidia. RTX 2080 Ti была в три раза больше, но всего на 50% быстрее, а это означает, что AMD достигла гораздо более высокой производительности на миллиметр. Если бы AMD сделала более крупный графический процессор, его было бы трудно превзойти.

И Nvidia, и AMD запланировали крупное противостояние в 2020 году. Nvidia осознала потенциал AMD и сделала все возможное: новый 8-нм процесс от Samsung, новую архитектуру Ampere и упор на большие графические процессоры. Тем временем AMD осталась на 7-нм техпроцессе TSMC, но представила новую архитектуру RDNA 2, а также запустит большой графический процессор, первый после RX Vega в 2017 году. В последний раз обе компании выпускали совершенно новые флагманы в одном и том же году в 2013 году, почти десятилетие назад. Хотя пандемия угрожала разрушить планы обеих компаний, ни одна из них не хотела откладывать выпуск следующего поколения и запускала его, как и планировалось.

В последний раз обе компании выпускали совершенно новые флагманы в одном и том же году в 2013 году, почти десятилетие назад. Хотя пандемия угрожала разрушить планы обеих компаний, ни одна из них не хотела откладывать выпуск следующего поколения и запускала его, как и планировалось.

Nvidia первой выпустила серию RTX 30, во главе с флагманской RTX 3090, но основное внимание было уделено RTX 3080, поскольку при цене 699 долларов она была намного доступнее, чем 3090 за 1499 долларов. Вместо того, чтобы быть повторением RTX 20. -series, 3080 обеспечил значительный прирост производительности на 30% при разрешении 4K по сравнению с RTX 2080 Ti, хотя энергопотребление было немного выше. При более низких разрешениях прирост производительности 3080 был несколько меньше, но поскольку 3080 был очень хорош в 4K, это было легко не заметить. 3080 также выиграл от более широкого спектра игр, поддерживающих трассировку лучей и DLSS, что дает ценность графическому процессору Nvidia с этими функциями.

Конечно, это не имело бы значения, если бы 3080 и остальная часть серии RTX 30 не могли противостоять новой серии AMD RX 6000, которая была запущена двумя месяцами позже. RX 6800 XT за 649 долларов был ответом AMD на RTX 3080. При почти одинаковой производительности в большинстве игр и большинстве разрешений битва между 3080 и 6800 XT напоминала GTX 680 и HD 7970. его преимущества и недостатки: AMD лидирует по энергоэффективности и производительности, в то время как Nvidia имеет лучшую производительность в трассировке лучей и поддержке других функций, таких как искусственный интеллект. масштабирование.

Ажиотаж по поводу нового эпизода войны за GPU быстро угас, потому что быстро стало очевидно, что никто не может купить ни RTX 30, ни RX 6000, ни вообще какие-либо GPU. Пандемия серьезно сократила предложение, в то время как криптовалюты увеличили спрос, и спекулянты схватили столько графических процессоров, сколько могли. На момент написания статьи дефицит в основном закончился, но большинство графических процессоров Nvidia по-прежнему продаются обычно по цене 100 долларов или более по сравнению с MSRP. К счастью, более дорогие графические процессоры, такие как RTX 3080, можно найти ближе к MSRP, чем более дешевые карты серии 30, что делает 3080 жизнеспособным вариантом.

К счастью, более дорогие графические процессоры, такие как RTX 3080, можно найти ближе к MSRP, чем более дешевые карты серии 30, что делает 3080 жизнеспособным вариантом.

В целом, RTX 3080 была столь необходимой поправкой от Nvidia. Хотя 3080 ознаменовал конец почти полного доминирования Nvidia на рынке графических процессоров для настольных ПК, трудно не отдать должное компании за то, что она не проиграла AMD. В конце концов, серия RX 6000 использует гораздо лучший процесс, и последние несколько лет AMD была чрезвычайно агрессивной. Кроме того, приятно наконец-то увидеть напряженную гонку между Nvidia и AMD, в которой обе стороны очень стараются победить.

Что дальше?

В отличие от AMD, Nvidia всегда держит свои карты при себе и редко раскрывает информацию о предстоящих продуктах. Мы можем быть уверены, что грядущая серия RTX 40 выйдет где-то в этом году, но все остальное остается неопределенным. Один из наиболее интересных слухов заключается в том, что Nvidia будет использовать 5-нм техпроцесс TSMC для графических процессоров RTX 40, и если это правда, то это означает, что Nvidia снова будет иметь паритет с AMD.

Но я думаю, что пока RTX 40 не является еще одной RTX 20 и предлагает больше вариантов нижнего и среднего уровня, чем RTX 30, у Nvidia должен быть достаточно хороший продукт следующего поколения. Я бы очень хотел, чтобы он был настолько хорош, чтобы попасть в список лучших графических процессоров Nvidia всех времен, но нам придется подождать и посмотреть.

Рекомендации редакции

- RTX 4060 Ti от Nvidia может быть более доступным, но будет ли это хорошей ценой?

- К сожалению, Nvidia только что случайно показала новый графический процессор.

- Хорошие новости — RTX 4070 от Nvidia может быть не безнадежным делом.

- Будьте осторожны — Diablo IV может сломать ваш графический процессор Nvidia

- Возмутительная ценовая стратегия Nvidia — именно то, почему нам нужны AMD и Intel.

Анализ памяти графических карт Nvidia Geforce и AMD Radeon

Память всегда была одним из наиболее важных компонентов графической карты. Его важность в последнее время стала еще более заметной, особенно благодаря появлению технологии HBM. В то время как внимание отрасли сместилось на максимальное увеличение пропускной способности при сохранении приемлемой физической площади, в тени скрывается угроза, которая может иметь далеко идущие последствия: энергопотребление памяти. Я подумал, что пришло время сделать короткую редакционную статью о влиянии пропускной способности и энергопотребления.

Его важность в последнее время стала еще более заметной, особенно благодаря появлению технологии HBM. В то время как внимание отрасли сместилось на максимальное увеличение пропускной способности при сохранении приемлемой физической площади, в тени скрывается угроза, которая может иметь далеко идущие последствия: энергопотребление памяти. Я подумал, что пришло время сделать короткую редакционную статью о влиянии пропускной способности и энергопотребления.

Как известно большинству из вас, стандартом памяти для графических карт прошлого поколения является GDDR5, и хотя многие будущие предложения, несомненно, сохранят этот тип памяти, в городе появился новый игрок: память с высокой пропускной способностью. HBM или многослойная DRAM (у которой есть много разных названий и разновидностей) — это недавняя инновация со значительно увеличенной пропускной способностью, но резко сниженным энергопотреблением. Весь смысл HBM заключался в том, чтобы довести высокую пропускную способность до доступного уровня (с точки зрения затрат на электроэнергию). И хотя им в значительной степени удалось это сделать в ближайшем будущем, проблема остается, когда речь идет о долгосрочной перспективе. Некоторое время назад Nvidia провела конференцию GPU Technology Theater на SC15, и доктор Стивен В. Кеклер, старший директор по архитектурным исследованиям (в Nvidia) , упомянул, что проблема энергопотребления памяти остается нерешенной — даже с HBM.

И хотя им в значительной степени удалось это сделать в ближайшем будущем, проблема остается, когда речь идет о долгосрочной перспективе. Некоторое время назад Nvidia провела конференцию GPU Technology Theater на SC15, и доктор Стивен В. Кеклер, старший директор по архитектурным исследованиям (в Nvidia) , упомянул, что проблема энергопотребления памяти остается нерешенной — даже с HBM.

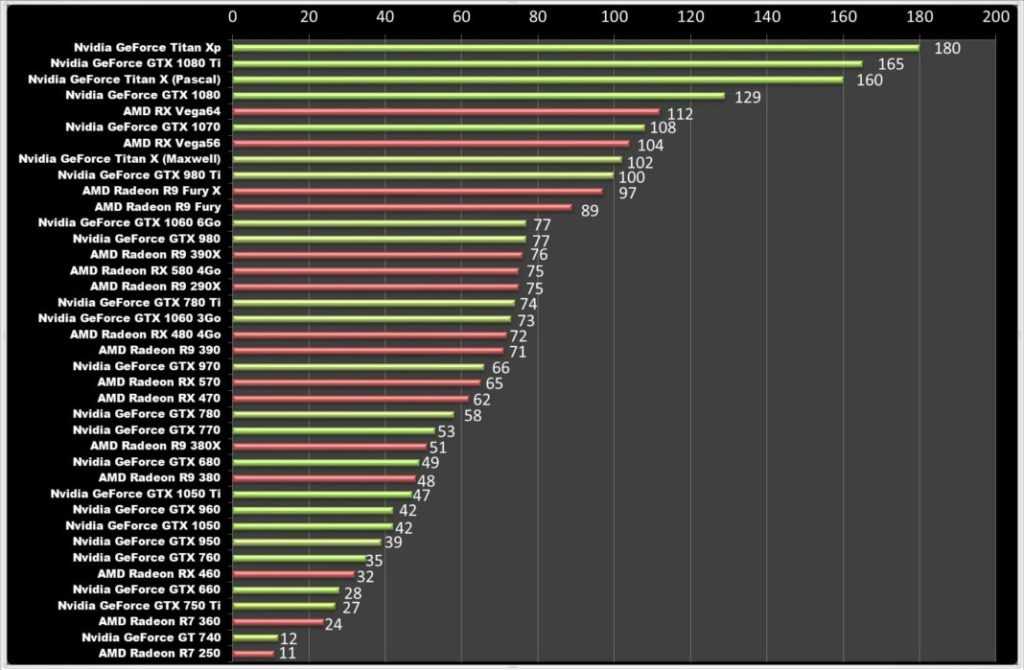

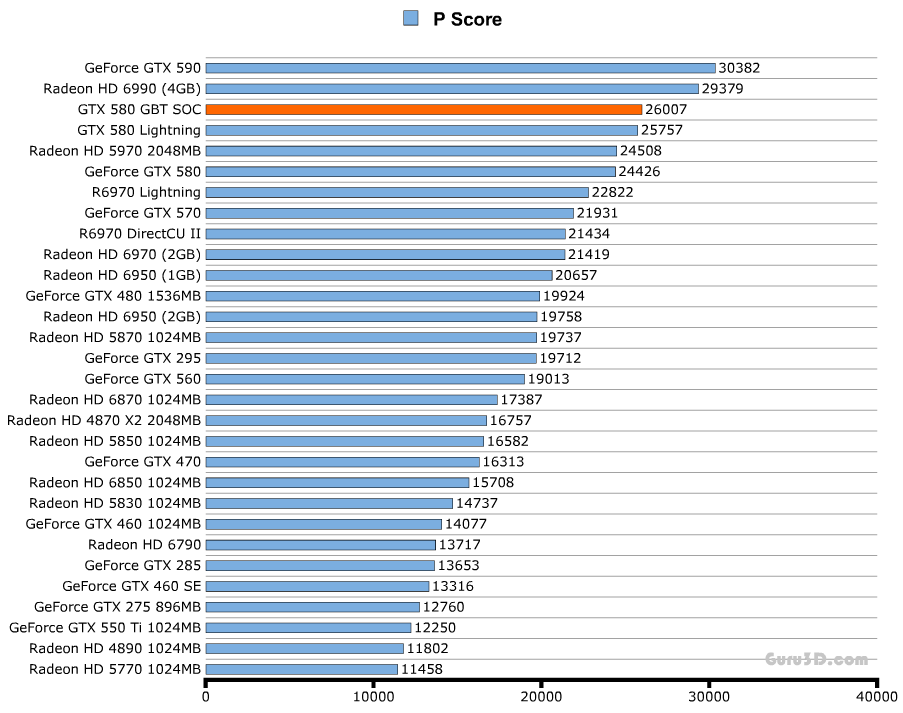

На графике показан экспоненциальный рост энергопотребления двух типов памяти по мере увеличения пропускной способности. Мы видим структурный разрыв на графике, где отрасль переходит с GDDR5 на HBM, но конечный результат остается прежним, хотя и с задержкой. Теперь, почему это проблема? можно спросить. С точки зрения TDP, к которому привыкли энтузиасты, эти цифры находятся в допустимых пределах. Но вы должны понимать, что графический процессор, которому требуется такая большая пропускная способность, сам по себе также будет потреблять довольно много — и комбинированный TDP не будет в допустимых пределах. Энергия, потребляемая графическим процессором, является очень важным числом, и если только память требует такого большого количества энергии, то общее число будет довольно огромным.

Энергия, потребляемая графическим процессором, является очень важным числом, и если только память требует такого большого количества энергии, то общее число будет довольно огромным.

Мощность графических карт растет неумолимыми темпами, а это означает, что еще через несколько лет нам потребуется пропускная способность в районе нескольких тысяч ГБ/с, а это означает, что даже с учетом энергоэффективности, обеспечиваемой многослойной памятью DRAM, Потребляемая мощность памяти превысит отметку в 100 Вт, что, учитывая тот факт, что сами графические процессоры будут потреблять довольно много энергии, означает, что общая мощность превысит отметку в 250 Вт, которую в настоящее время используют высокопроизводительные карты.

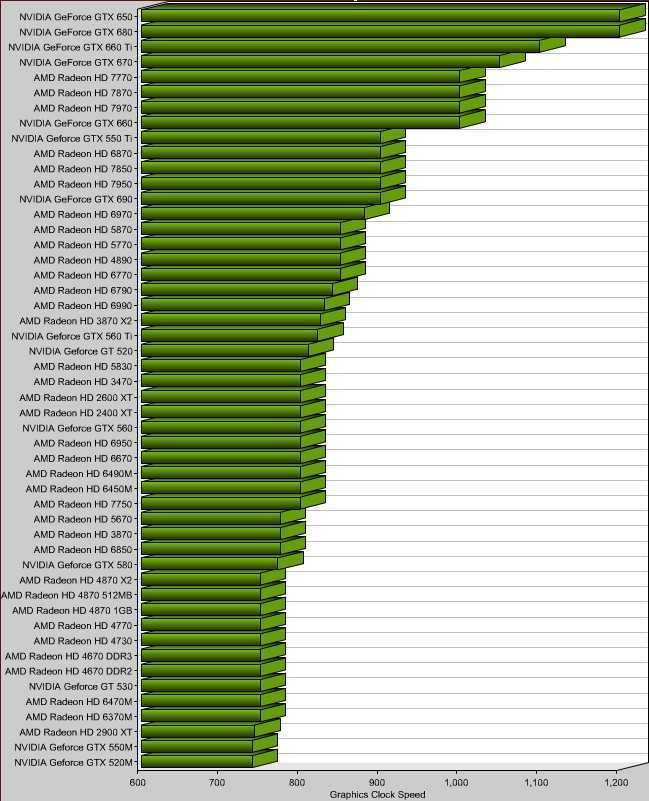

Некоторые из наших читателей, читающие это, вероятно, зададутся вопросом, зачем нам пропускная способность в тысячи ГБ/с. Ну, вы должны помнить тот факт, что графические карты на самом деле являются процессорами с огромными кластерами невероятно маленьких ядер. Вы можете называть их ядрами CUDA или потоковыми процессорами — в любом случае именно этим крошечным процессорам требуется пропускная способность. Теперь , в то время как количество этих ядер растет с очень стабильной скоростью, предоставляемая им пропускная способность не успевает за ними. Чтобы уточнить утверждение, мы рассчитали пропускную способность, доступную для каждого ядра последних графических карт Nvidia и AMD. Сразу видна очень четкая тенденция.

Вы можете называть их ядрами CUDA или потоковыми процессорами — в любом случае именно этим крошечным процессорам требуется пропускная способность. Теперь , в то время как количество этих ядер растет с очень стабильной скоростью, предоставляемая им пропускная способность не успевает за ними. Чтобы уточнить утверждение, мы рассчитали пропускную способность, доступную для каждого ядра последних графических карт Nvidia и AMD. Сразу видна очень четкая тенденция.

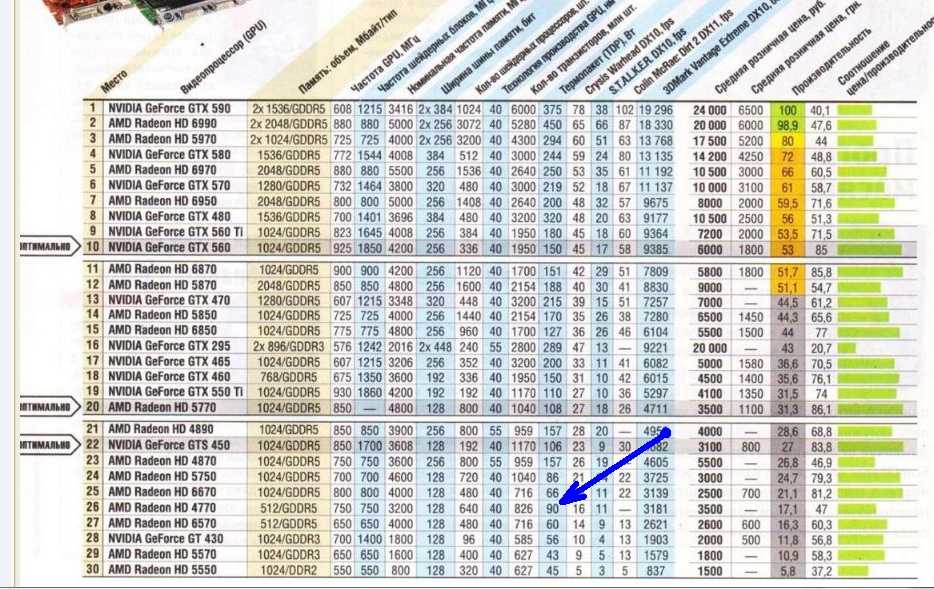

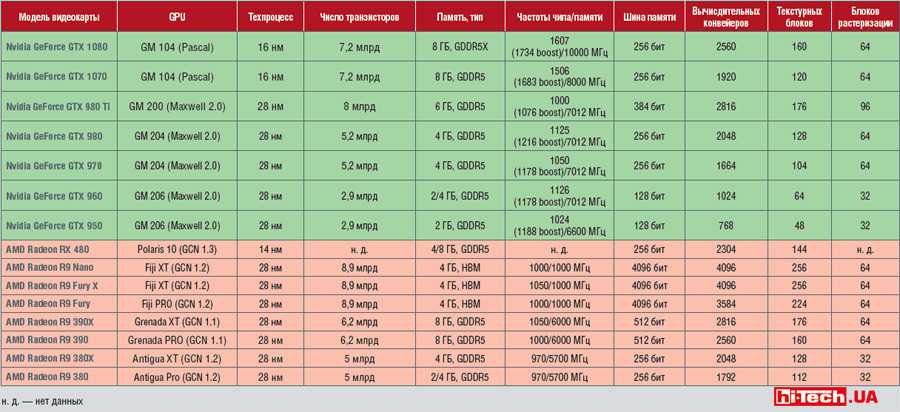

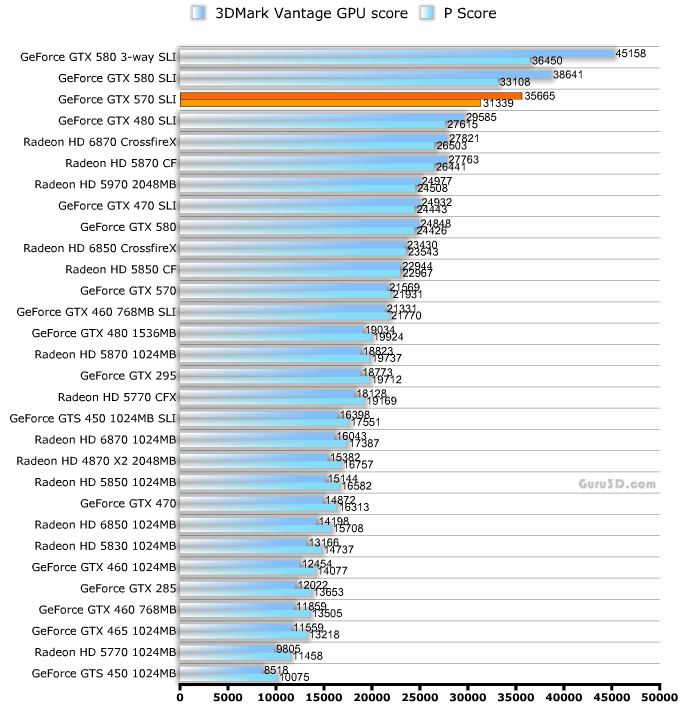

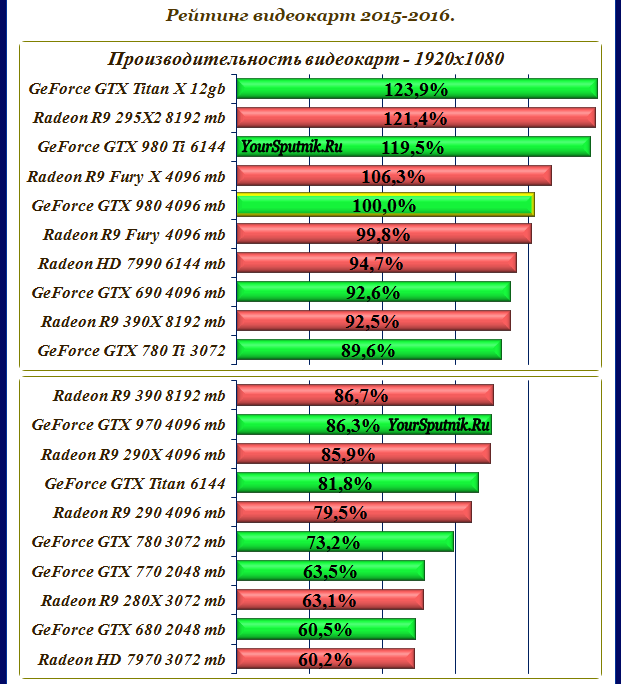

Анализ пропускной способности на ядро графических карт Nvidia и AMD

Пропускная способность на ядро различных Radeon, с количеством потоковых процессоров в порядке возрастания.

Пропускная способность на ядро различных карт Geforce с числом ядер CUDA, отсортированным по возрастанию.

Вы заметите, что пропускная способность, доступная для каждого ядра, уменьшается по мере того, как GPU становится более мощным. Это связано с изначально медленным темпом развития современной технологии памяти. Интересно, что мы видим, что AMD удалось сохранить градиент пропускной способности на ядро относительно постоянным, в то время как Nvidia имеет лишь немного более крутой градиент. Диапазон карт Nvidia находится в диапазоне от 107 МБ/с до 120 МБ/с на ядро, достигая 160 МБ/с на ядро на GTX 760. пропускную способность своих графических карт, чем Nvidia, которая использует технологию оптимизации цвета, чтобы компенсировать нехватку пропускной способности. Карты AMD имеют скорость от 110 МБ/с до 140 МБ/с на ядро, достигая 175 МБ/с на ядро для R9 370. Интересно, что это единственная карта в наших расчетах, которая упала ниже 100 МБ/с на ядро. маркой является R9 285, который имеет число 98 МБ/с на ядро.

Интересно, что мы видим, что AMD удалось сохранить градиент пропускной способности на ядро относительно постоянным, в то время как Nvidia имеет лишь немного более крутой градиент. Диапазон карт Nvidia находится в диапазоне от 107 МБ/с до 120 МБ/с на ядро, достигая 160 МБ/с на ядро на GTX 760. пропускную способность своих графических карт, чем Nvidia, которая использует технологию оптимизации цвета, чтобы компенсировать нехватку пропускной способности. Карты AMD имеют скорость от 110 МБ/с до 140 МБ/с на ядро, достигая 175 МБ/с на ядро для R9 370. Интересно, что это единственная карта в наших расчетах, которая упала ниже 100 МБ/с на ядро. маркой является R9 285, который имеет число 98 МБ/с на ядро.

Давайте подробнее рассмотрим дилемму мощности. Энергопотребление энергозависимой памяти зависит от тактовой частоты и ширины шины (она же пропускная способность). Согласно заявлению AMD, последняя версия GDDR5 (в среднем) потребляет около 1 Вт на пропускную способность 10,66 ГБ/с, в то время как HBM обеспечивает около 35 ГБ/с на ватт. Это феноменальное увеличение энергоэффективности почти в 3,5 раза, но достаточно ли этого? Мы подсчитали приблизительное энергопотребление различных графических карт и пришли к очень интересным выводам.

Это феноменальное увеличение энергоэффективности почти в 3,5 раза, но достаточно ли этого? Мы подсчитали приблизительное энергопотребление различных графических карт и пришли к очень интересным выводам.

Тенденция энергопотребления памяти графических карт AMD и Nvidia

Как и ожидалось для Nvidia, мощность, потребляемая памятью, увеличивается примерно пропорционально средней мощности графической карты. Имейте в виду, что ядра разных поколений не полностью сопоставимы (в среднем ядро Maxwell на 15-32% мощнее в зависимости от карты), поэтому фактическое число (после поправки на разницу в производительности) будет немного выше. Мы видим, что в среднем карта AMD потребляет от 15 Вт до 36 Вт для питания своего стандарта памяти GDDR5, в то время как карты Nvidia потребляют около 18–32 Вт в зависимости от конкретной карты. С GDDR5 — максимальная мощность на данный момент близка к отметке 40 Вт (с учетом реальных потерь в линии). Однако с HBM все принимает совершенно другой оборот. 9Память 0147 HBM потребляет всего 15 Вт и обеспечивает большую пропускную способность, чем GDDR5 с самой высокой тактовой частотой. На самом деле, если вы посмотрите на график, вы заметите, что в случае линейки Fury кривая отклоняется от ожидаемого пути и фактически наклоняется вниз, что указывает на структурный сдвиг в тренде, о котором мы говорили.

Однако с HBM все принимает совершенно другой оборот. 9Память 0147 HBM потребляет всего 15 Вт и обеспечивает большую пропускную способность, чем GDDR5 с самой высокой тактовой частотой. На самом деле, если вы посмотрите на график, вы заметите, что в случае линейки Fury кривая отклоняется от ожидаемого пути и фактически наклоняется вниз, что указывает на структурный сдвиг в тренде, о котором мы говорили.

Придерживаясь стандарта HBM, мы можем рассчитать, какой будет пропускная способность при уровнях мощности, заявленных Nvidia. При 120 Вт HBM (при сегодняшней эффективности) сможет выдавать 4200 ГБ/с — это просто огромное число. Однако, к сожалению, эффективность не зависит от линейного масштаба, и мы могли бы также рассчитывать на коэффициент 20-25 ГБ/с на ватт при таких высоких нагрузках. Это дает нам число около 2400 ГБ/с — гораздо более разумное число, которое мы можем ожидать в ближайшем будущем. В настоящее время энергопотребление памяти колеблется в пределах 8-15% от общего TDP графического процессора, но по мере увеличения пропускной способности это число также будет расти.

Ваш комментарий будет первым