Обзор и тестирование видеокарты для ноутбуков NVIDIA GeForce RTX 3070

В этом обзоре мы рассмотрим видеокарту Nvidia GeForce RTX 3070 для ноутбуков, которая на данный момент обладает большим запасом производительности и предназначена для игр в разрешении 2К на максимальных настройках графики. Очевидно, что графические процессоры новой серии RTX 30 являются монстрами на сегодняшний день с точки зрения игровой производительности, и мы ожидаем, что они будут работать лучше в реальных играх, когда Nvidia оптимизирует драйвера для 3000 своих видеокарт.

Линейка мобильных устройств серии RTX 30 заменит существующую линейку устройств серии RTX 20, которая основана на архитектуре графического процессора Turing и предложит улучшенную производительность. Основу NVIDIA GeForce RTX 3070 составляет новый графический процессор на архитектуре Ampere с кодовым обозначением GN20-E5 GA104 выполненный по 8 н.м. литографии. В графическом процессоре мобильной GeForce RTX 3070 активно 5120 потоковых процессора, 160 текстурных блоков и 80 POPs, настольный вариант этой видеокарты задействует 5888 CUDA-ядер, 184 тензорных ядра и 46 RT-ядра.

Что касается собственной видеопамяти памяти, то у новинки в наличии 8 ГБ стандарта GDDR6, известной нам по предыдущим поколениям GPU, к сожалению новым стандартом GDDR6X мобильная NVIDIA GeForce RTX 3070 не оснащается. Память у RTX 3070 подключена по полной 256-битной шине, что дает чуть менее полутерабайта пропускной способности. Некоторым может показаться, что RTX 3070 будет не хватать 8 ГБ памяти. Но пока что игры даже в 4K-разрешении при максимальных настройках действительно не требуют большего объема памяти. Они могут занимать его и даже как-то использовать, но ускорения при увеличении объема от 8 до 16 ГБ никакого не будет. Что интересно на сайте Nvidia нет упоминания видеокарт серии RTX 30 с пониженным TDP max-Q 80 — 90 Вт, скорее всего производитель решил отказаться от данного названия в наименовании видеокарт, вместо этого TGP видеокарты GeForce RTX 3070 может составлять минимам 80 Вт максимум 125+ Вт, от данного показателя напрямую будет зависеть производительность видеокарты, то есть производитель ноутбуков сам будет решать ограничивать TGP (Общая графическая мощность графического процессора) видеокарты или нет.

Технические характеристики

| Производитель | |

| Nvidia | |

| Техпроцесс | |

| 8 н.м | |

| GN20-E5 GA104 (Ampere) | |

| Частота GPU | |

| 780 — 1620 МГц | |

| Потоковые процессоры (Shading Units) | |

| 5120 | |

| Текстурные блоки(TMUs) | |

| 160 | |

| Конвейеры растровых операций (ROPs) | |

| 80 | |

| Ядра Tensor | |

| 160 | |

| Ядра RT | |

| 40 | |

| Тип памяти | |

| GDDR6 | |

| Ширина шины памяти | |

| 256 Бит | |

| Частота памяти | |

| 1500/1750 МГц | |

| Объем памяти | |

| 8ГБ | |

| Потребляемая мощность(TDP) | |

| 80-125+ max140 Вт | |

Синтетические тесты

3DMark

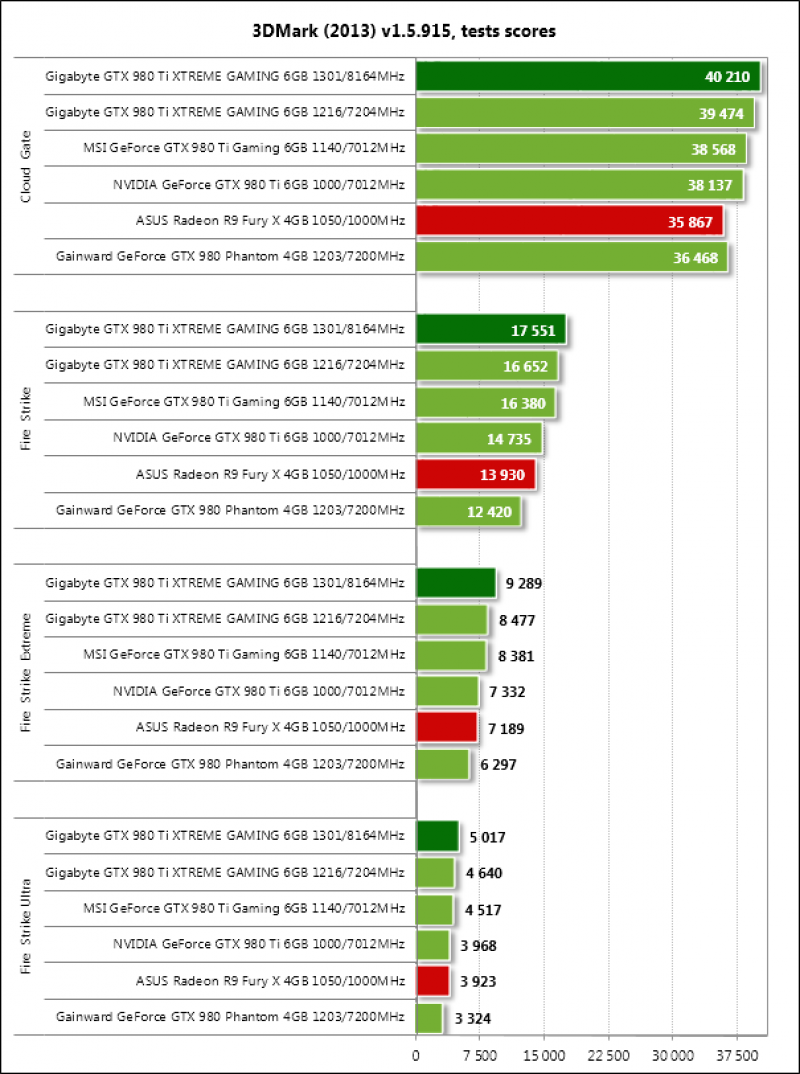

3DMark Fire Strike — это красивое популярное приложение с поддержкой API DirectX 11 для тестирования компьютеров с высокопроизводительными игровыми видеокартами в среде Windows. Результаты 3DMark Fire Strike помогают оценить сравнительную производительность видеокарты и её пригодность для работы в самых требовательных компьютерных играх.

Результаты 3DMark Fire Strike помогают оценить сравнительную производительность видеокарты и её пригодность для работы в самых требовательных компьютерных играх.

3DMark — Fire Strike Graphics 1920×1080

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

27968

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

25339

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

21820

Игровые тесты

Менее 30FPS

30-60FPS

Средний Фреймрейт

Более 60FPS

Высокий Фреймрейт

Тестирование в играх

Cyberpunk 2077 — приключенческая ролевая игра, действие которой происходит в мегаполисе Найт-Сити, где власть, роскошь и модификации тела ценятся выше всего. Вы играете за V, наёмника в поисках устройства, позволяющего обрести бессмертие. Cyberpunk 2077 получил четвертую версию игрового движка REDengine, который представляет собой улучшенную и усовершенствованную версию «родного» движка компании CD Projekt RED. Улучшенный движок на самом деле позволяет игре отображать удивительную детализацию лиц, немного превосходя в этом плане такие вещи в Horizon Zero Dawn. Продуманный самобытный дизайн и высокое внимание к мелким деталям — вот два столпа визуальной красоты Cyberpunk 2077. Что немаловажно CD Projekt не стали гнаться за новыми высотами полигональной детализации объектов или введением каких-то принципиально новых графических технологий, как любит поступать Crytek, а сосредоточились на кропотливой и творческой проработке проверенных временем старых элементов, возведя их на принципиально новый уровень.

Вы играете за V, наёмника в поисках устройства, позволяющего обрести бессмертие. Cyberpunk 2077 получил четвертую версию игрового движка REDengine, который представляет собой улучшенную и усовершенствованную версию «родного» движка компании CD Projekt RED. Улучшенный движок на самом деле позволяет игре отображать удивительную детализацию лиц, немного превосходя в этом плане такие вещи в Horizon Zero Dawn. Продуманный самобытный дизайн и высокое внимание к мелким деталям — вот два столпа визуальной красоты Cyberpunk 2077. Что немаловажно CD Projekt не стали гнаться за новыми высотами полигональной детализации объектов или введением каких-то принципиально новых графических технологий, как любит поступать Crytek, а сосредоточились на кропотливой и творческой проработке проверенных временем старых элементов, возведя их на принципиально новый уровень.

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: High, (Ray Tracing нет), (DLSS нет)

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

97FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

89FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

81FPS100%

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: Ultra, (Ray Tracing нет), (DLSS нет)

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

83FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

76FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

72FPS100%

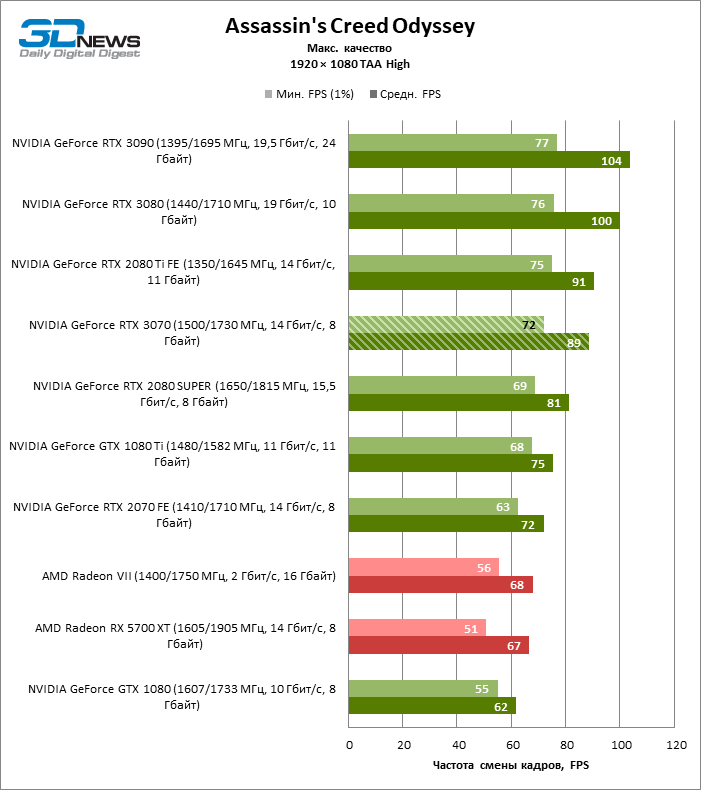

Assassin’s Creed Valhalla — мультиплатформенная компьютерная игра в жанре action/RPG, разработанная студией Ubisoft Montreal под издательством компании Ubisoft. Assassin’s Creed Valhalla рассказывает сагу об Эйворе по прозвищу Брат (или Сестра!) Волка — викинге, в раннем детстве потерявшем семью из-за предательства. Новая Assassin’s Creed работает на движке AnvilNext 2.

Настройки: дисплей разрешение 1920 x180 пикселей, детализация: High

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

84FPS100%

80FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

78FPS100%

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: Ultra,

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

75FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

71FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

68FPS100%

Crysis: Remastered. Классический шутер от первого лица от Crytek возвращается с динамическим игровым процессом, режимом «песочницы» и захватывающими эпическими битвами. В игре вас ждет обновленная графика, оптимизированная для оборудования нового поколения. Скорость, сила, броня и маскировка нанокостюма помогут победить в любом бою, а благодаря огромному арсеналу вы сможете сами выбирать свой стиль игры для достижения невероятных результатов. В постоянно меняющихся условиях адаптируйте свою тактику и снаряжение, чтобы побеждать своих врагов в огромном мире. Crysis: Remastered основан на модифицированном CryEngine 2, который написан так же как и его предшественник на С++. CryEngine 2 на момент своего выхода является самым технологически продвинутым и фотореалистичным движком по сравнению с конкурентами.

Настройки: дисплей разрешение 1920 x180 пикселей, детализация: High

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

86FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

79FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

63FPS100%

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: Very High

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

61FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

57FPS95%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

52FPS86%

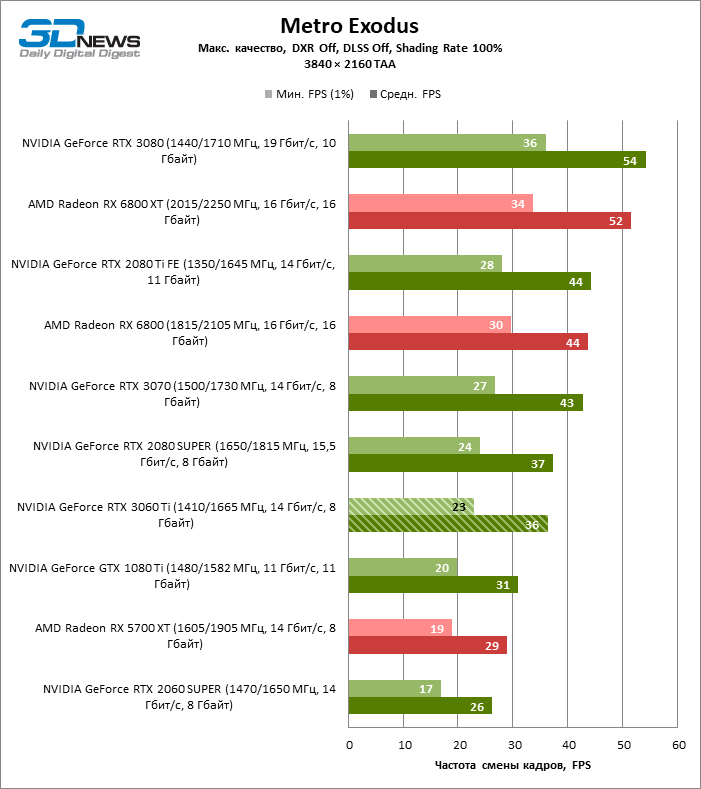

Metro: EXODUS — шутер от первого лица сработанный студией 4A Engine по роману Дмитрия Глуховского, скорее всего последняя часть и вероятный финал сериала франшизы Metro 2033. Сюжет разворачивается на территории постапокалиптической Российской Федерации, где выжившие после ядерной войны сумели укрыться в большом московском метро и пытаются выжить под натиском атак злобных хищников-мутантов, а также враждующих фракций. 4A Engine — игровой движок, разработанный украинской компанией 4A Games для использования в своей компьютерной игре «Metro 2033», изданной THQ 16 марта 2010 года. Игра не содержит предустановленных режимов детализации изображения, хотя они есть в утилите, запускающей встроенный бенчмарк, — от низкой до ультравысокой. Среди индивидуальных настроек можно отрегулировать только общее «качество» изображения, размер выборки пикселов для анизотропной фильтрации, интенсивность размытия движущихся объектов, а также глубину тесселяции геометрических примитивов. В качестве основного метода полноэкранного сглаживания игра использует собственную разновидность временного алгоритма (TAA — Temporal Anti-Aliasing) — его нельзя отключить, но, судя по сведениям от NVIDIA, TAA здесь работает очень мягко и наверняка мало влияет на общее быстродействие. Как и в большинстве игр такого калибра, как Metro Exodus, движок позволяет масштабировать качество изображения в широких пределах, причем разница между низким, средним и ультравысоким профилями детализации выражена чрезвычайно сильно.

В качестве основного метода полноэкранного сглаживания игра использует собственную разновидность временного алгоритма (TAA — Temporal Anti-Aliasing) — его нельзя отключить, но, судя по сведениям от NVIDIA, TAA здесь работает очень мягко и наверняка мало влияет на общее быстродействие. Как и в большинстве игр такого калибра, как Metro Exodus, движок позволяет масштабировать качество изображения в широких пределах, причем разница между низким, средним и ультравысоким профилями детализации выражена чрезвычайно сильно.

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация High

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

89FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

85FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

80FPS100%

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация Extreme

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

52FPS

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

47FPS

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

44FPS73%

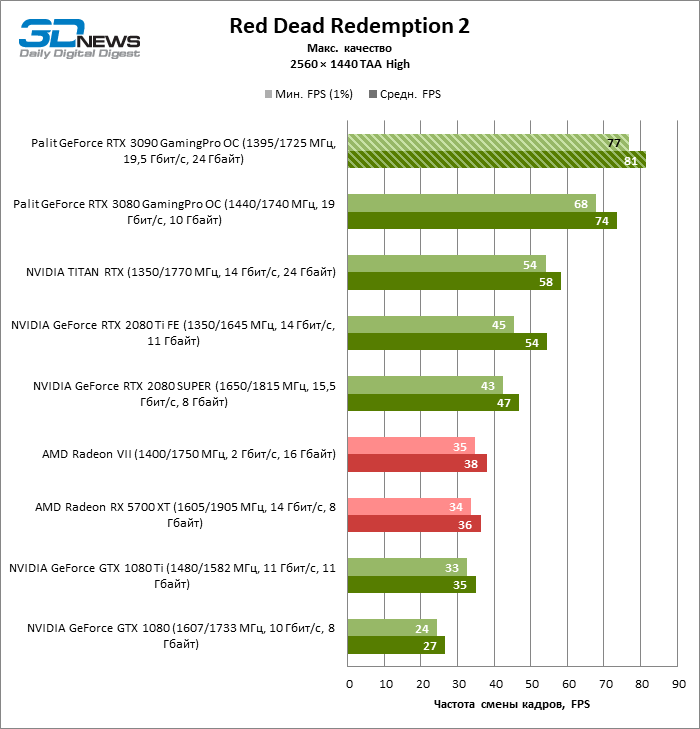

Red Dead Redemption 2 — компьютерная игра в жанрах action-adventure и шутера от третьего лица с открытым миром, разработанная и выпущенная Rockstar Games. Действие Red Dead Redemption 2, оформленной в духе вестерна, происходит в 1899 году на Диком Западе, на территории нескольких вымышленных штатов США. Сюжет игры построен вокруг приключений банды Датча Ван дер Линде; под управлением игрока находится Артур Морган, один из членов банды. После неудачного ограбления парома бандиты вынуждены скрываться в глуши от федеральных агентов и охотников за головами. Red Dead Redemption 2 использует в своей основе Rockstar Advanced Game Engine. «Rockstar Advanced Game Engine» является полнофункциональным игровым движком, который содержит графический движок, физический движок, звуковой движок, анимационный движок, игровой искусственный интеллект, работу с сетью, скриптовый язык и другие компоненты. Так как движок ориентировался на использования в играх, которые имеют «открытый бесшовный мир», то основным преимуществом движка является его способность эффективно обрабатывать большие игровые пространства.

Так как движок ориентировался на использования в играх, которые имеют «открытый бесшовный мир», то основным преимуществом движка является его способность эффективно обрабатывать большие игровые пространства.

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: High

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

67FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

64FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

62FPS100%

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: Maximum

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

40FPS66%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

38FPS63%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

34FPS56%

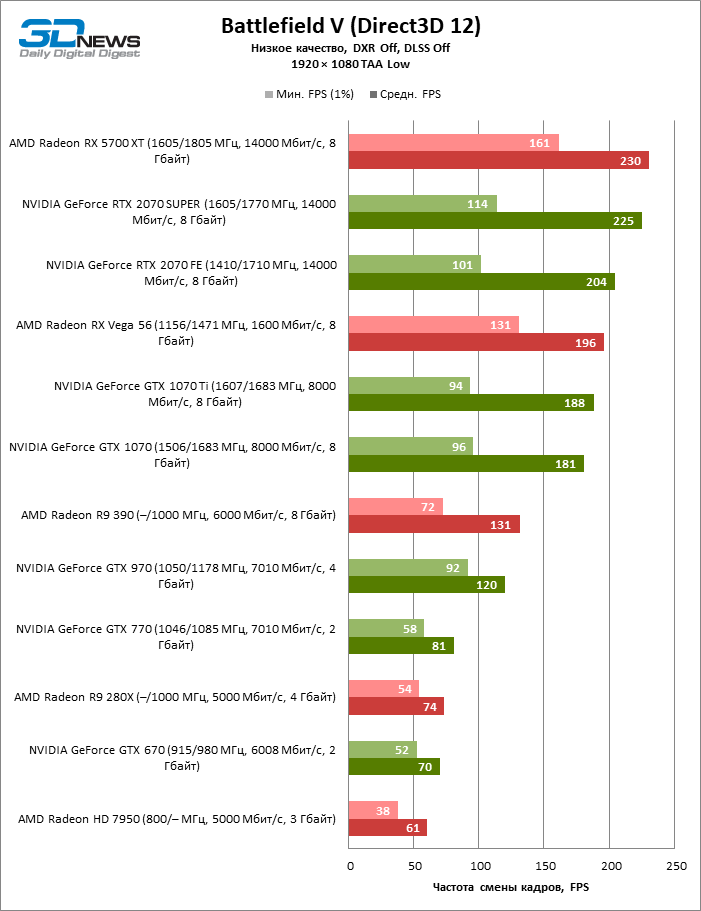

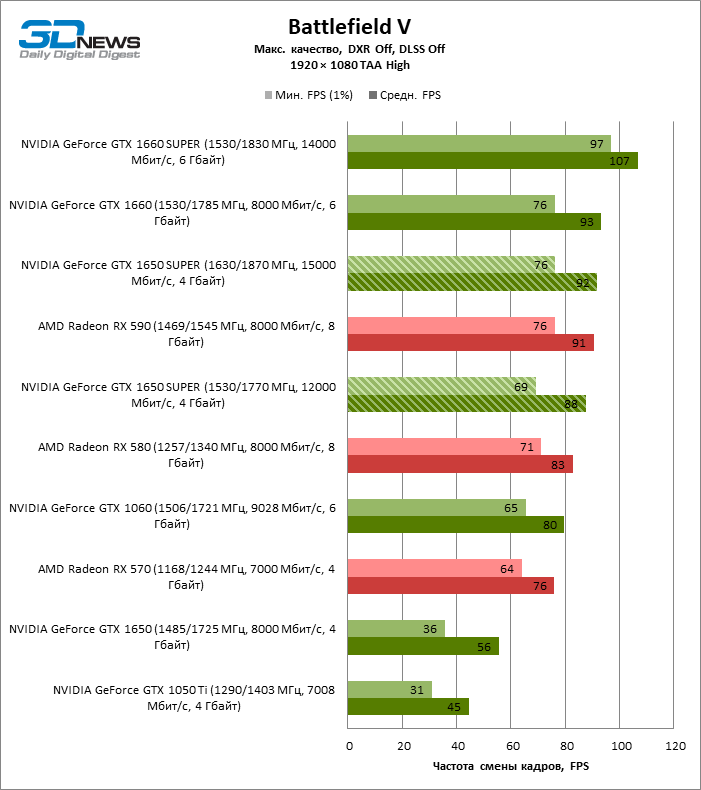

Battlefield V представляет из себя шутер от первого лица, в котором геймеру предстоит побывать в различных уголках земного шара во времена Второй мировой войны. Геймплей является крайне разнообразным и интересным, в связи с чем данная игра полюбилась миллионам людей. Игра использует в своей основе Frostbite Engine 3.5. Frostbite Engine — игровой движок, разработанный компанией EA Digital Illusions CE; применяется как в собственных разработках, так и проектах других филиалов Electronic Arts. Что касается визуального ряда, Battlefield V ставит новые стандарты качества картинки для шутера на основе улучшенного движка Frostbite. Вряд ли можно найти другой столь красивый военный шутер, как бы ни банально это звучало. Приятно выделяется и однопользовательская кампания, поскольку для многопользовательского режима EA и DICE выбрали компромисс между производительностью и внешним видом. Нельзя сказать, что картинка сильно хуже, но все же разработчики уделили основное внимание производительности. Единственный негативный момент касается уровня детализации в зависимости от дистанции обзора. Независимо от выбранного уровня качества графики, объекты всегда прорисовываются на определенной дистанции — хотя могли бы появляться намного раньше/дальше.

Единственный негативный момент касается уровня детализации в зависимости от дистанции обзора. Независимо от выбранного уровня качества графики, объекты всегда прорисовываются на определенной дистанции — хотя могли бы появляться намного раньше/дальше.

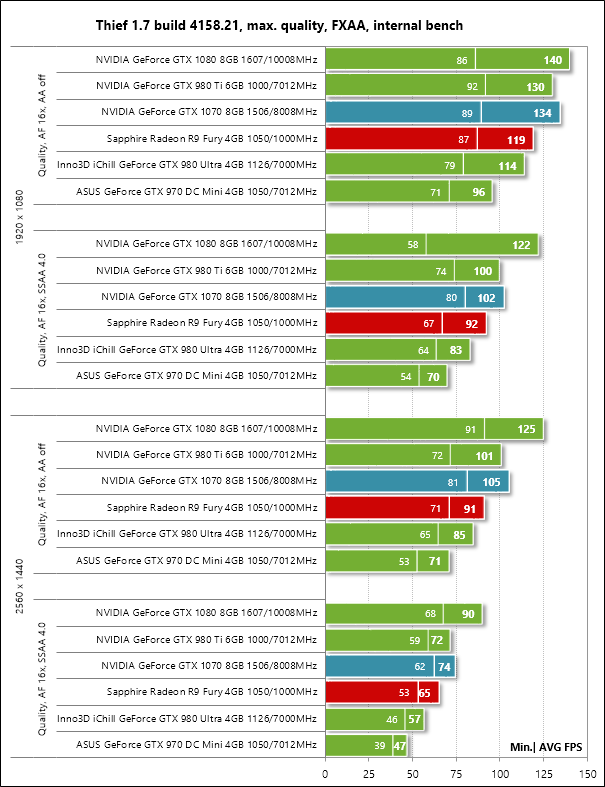

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: Ultra, DXR нет

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

138FPS100%

NVIDIA GeForce RTX 3080 Laptop, TGP 100Вт.

125FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

106FPS100%

Настройки: дисплей разрешение 1920 x1080 пикселей, детализация: Ultra, DXR да

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

79FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

78FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

64FPS100%

Borderlands 3 всеми любимый шутер с горами лута возвращается, приготовив тонны стволов и безбашенные приключения! Вас ждут ураганные бои в неизведанных мирах с новыми противниками. Borderlands 3, как и все предыдущие эпизоды франшизы, основана на графическом движке Unreal Engine, в этот раз — на его четвертой, самой современной версии. В игровой индустрии последних лет это одна из наиболее востребованных и заслуженных софтверных платформ — наряду с Unity и CryEngine. Движок Borderlands 3 интегрированы библиотеки FidelityFX, созданные AMD, которые выполняют функции постобработки изображения, в данном случае — усиливают четкость за счет локального контраста. Для игры, стилизованной под комикс, эта опция подходит идеально, а главное, сама технология не привязана к железу того или иного производителя и вполне может работать на видеокартах NVIDIA.

Настройки: разрешение 1920 x1080 пикселей, детализация: High

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

98FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

94FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

88FPS100%

Настройки: разрешение 1920 x1080 пикселей, детализация :Badass

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

82FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

81FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

77FPS100%

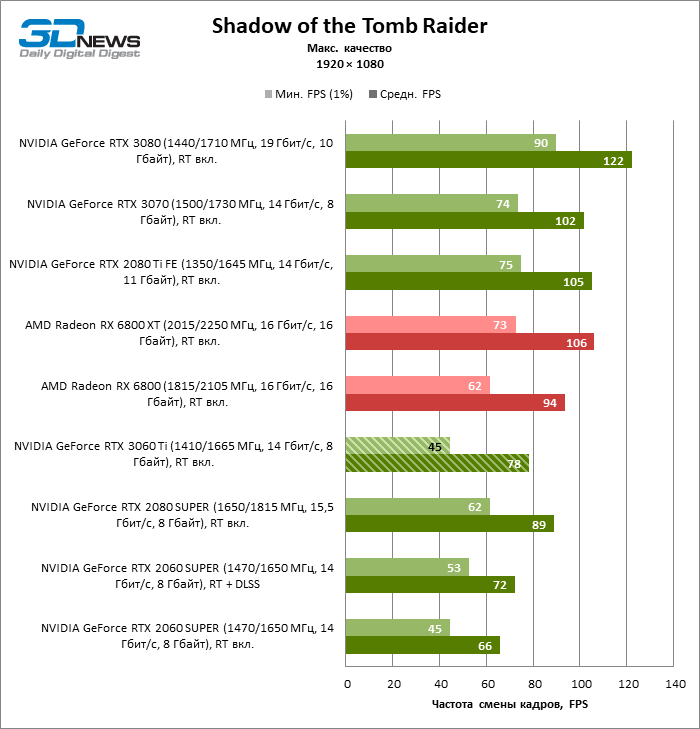

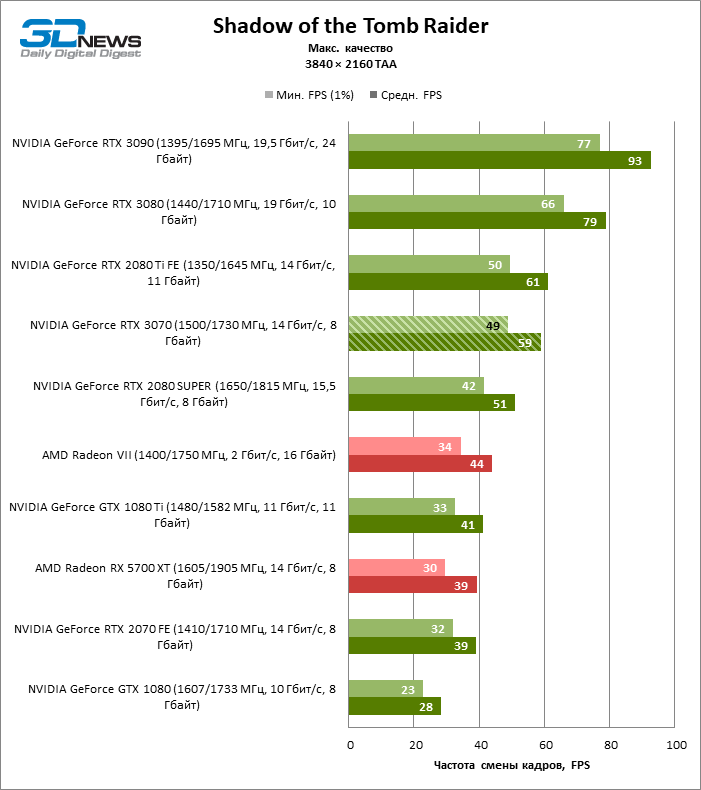

Shadow of the Tomb Raider. Действие игры Shadow of the Tomb Raider происходит после событий, изображенных в RISE OF THE TOMB RAIDER. На этот раз мисс Крофт отправляется в Латинскую Америку, где она путешествует по развалинам древней цивилизации (включая пирамиды майя и ацтеков), обнаруживает тайны Ордена Троицы и узнает больше об исследованиях, проведенных ее отцом. История более зрелая, чем в предыдущих играх. Чтобы изобразить Лару как более продвинутого авантюриста, разработчики намеревались заставить ее столкнуться с последствиями решений, которые она приняла. Для Rise of the Shadow of the Tomb Raider использует новый игровой движок под названием Foundation Engine. Shadow of the Tomb Raider включает улучшенное подповерхностное рассеивание на Ларе, объемное освещение и лучи света, пробивающиеся через листву. Также новая игра использует продвинутое сглаживание — TAA, вместо SMAA. Кроме того улучшились эффекты воды и волны от движения теперь имеют трехмерную форму, да и в целом взаимодействие с водой лучше. Тесселяция присутствует в обеих играх, однако используется для разных целей.

Чтобы изобразить Лару как более продвинутого авантюриста, разработчики намеревались заставить ее столкнуться с последствиями решений, которые она приняла. Для Rise of the Shadow of the Tomb Raider использует новый игровой движок под названием Foundation Engine. Shadow of the Tomb Raider включает улучшенное подповерхностное рассеивание на Ларе, объемное освещение и лучи света, пробивающиеся через листву. Также новая игра использует продвинутое сглаживание — TAA, вместо SMAA. Кроме того улучшились эффекты воды и волны от движения теперь имеют трехмерную форму, да и в целом взаимодействие с водой лучше. Тесселяция присутствует в обеих играх, однако используется для разных целей.

Настройки: дисплей 1920 x1080 пикселей, детализация: High Preset

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

119FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

108FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

102FPS100%

Настройки: дисплей 1920 x1080 пикселей, детализация: Highest Preset

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

109FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

100FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

97FPS100%

The Witcher 3: Wild Hunt — мультиплатформенная компьютерная ролевая игра, разработанная польской студией CD Projekt RED по мотивам серии романов «Ведьмак» польского писателя Анджея Сапковского, продолжение компьютерных игр «Ведьмак» и «Ведьмак 2: Убийцы королей». Заключительная часть трилогии. По заявлениям разработчиков, третья часть серии будет сочетать в себе нелинейный сюжет и мультирегиональный открытый игровой мир, который будет в тридцать раз больше, чем мир Ведьмака 2: Убийцы королей. Для передвижения можно будет использовать различный транспорт, например лошадь или корабль. Прохождение основной сюжетной линии будет занимать порядка 50 часов игры. Побочные задания займут примерно столько же. Ведьмак 3: Дикая Охота разрабатывался на игровом движке RedEngine 3, который ориентирован на платформы будущего поколения и в конечном счете разрушат границы между игровой графикой и CGI-роликами. Принципиальная разница RedEngine 3 по сравнению со своим предшественником заключается в том, что REDengine 3 создан для поддержки игр с открытым миром. RED Engine 3 фокусируется не только на графике и физике, но и на построении нелинейной системы квестов, позволяя сделать игровой процесс еще более приближённый к реальной жизни. RED Engine поддерживает динамические тени, normal mapping и parallax. The Witcher 3: Wild Hunt имеет как базовые, так и расширенные графические установки. Любой пользователь сможет настроить игру по своему усмотрению, опираясь на производительность имеющийся системы.

Для передвижения можно будет использовать различный транспорт, например лошадь или корабль. Прохождение основной сюжетной линии будет занимать порядка 50 часов игры. Побочные задания займут примерно столько же. Ведьмак 3: Дикая Охота разрабатывался на игровом движке RedEngine 3, который ориентирован на платформы будущего поколения и в конечном счете разрушат границы между игровой графикой и CGI-роликами. Принципиальная разница RedEngine 3 по сравнению со своим предшественником заключается в том, что REDengine 3 создан для поддержки игр с открытым миром. RED Engine 3 фокусируется не только на графике и физике, но и на построении нелинейной системы квестов, позволяя сделать игровой процесс еще более приближённый к реальной жизни. RED Engine поддерживает динамические тени, normal mapping и parallax. The Witcher 3: Wild Hunt имеет как базовые, так и расширенные графические установки. Любой пользователь сможет настроить игру по своему усмотрению, опираясь на производительность имеющийся системы.

Настройки: дисплей 1920 x1080 пикселей, детализация: High Preset

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

187FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

170FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

164FPS100%

Настройки: дисплей 1920 x1080 пикселей, детализация: Ultra Preset

FPS- среднее количество кадров в секунду

NVIDIA GeForce RTX 3070 Laptop, TGP 140Вт.

132FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 100Вт.

122FPS100%

NVIDIA GeForce RTX 3070 Laptop, TGP 85Вт.

116FPS

Заключение

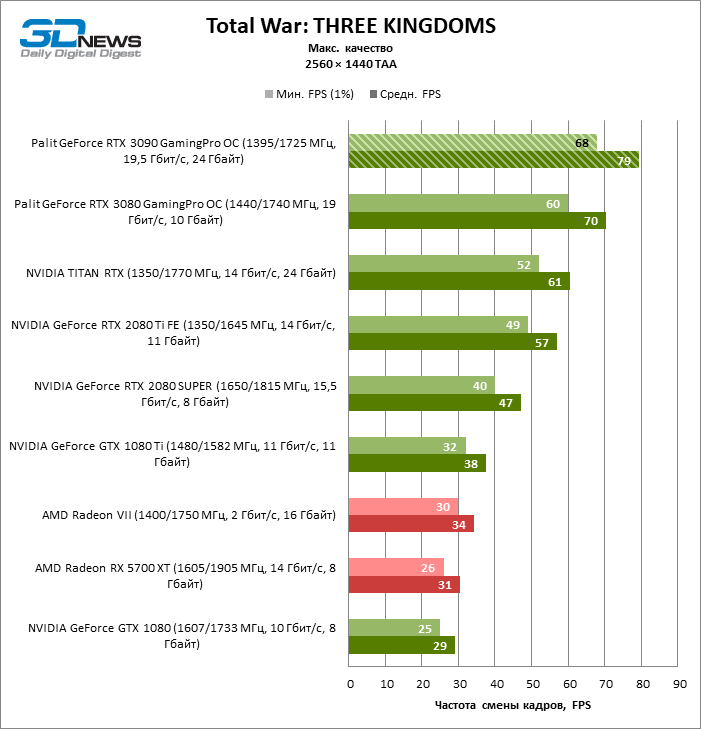

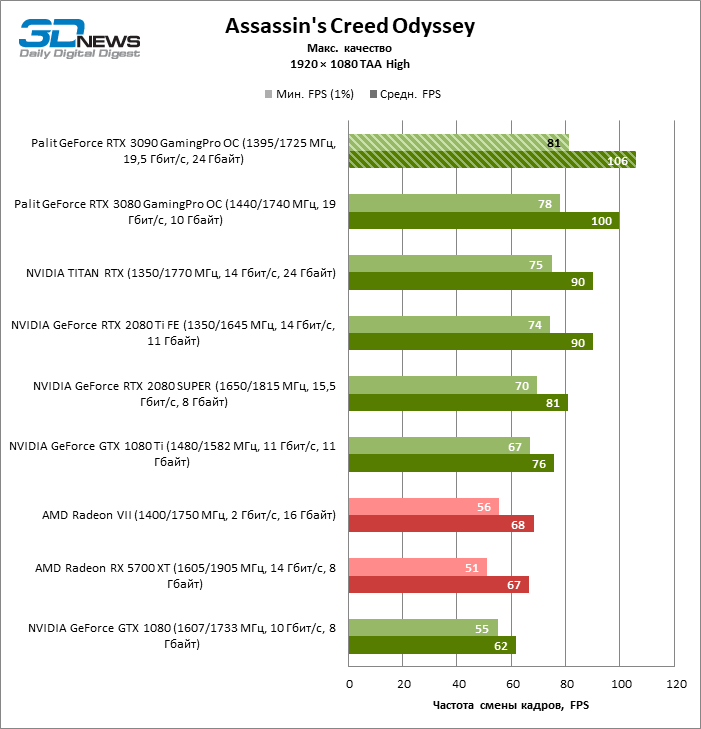

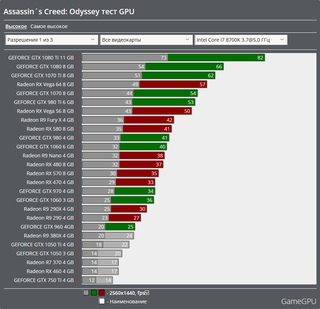

Графические процессоры NVidia 3000-й серии для ноутбуков существенно прибавили в производительности, в том числе и с включенной функцией трассировки лучей. Теперь вполне можно играть и в 4K разрешении, только вот где найти ноутбук с таким высоким разрешением дисплея, вопрос риторический. На наш взгляд целесообразность покупки нового ноутбука с GeForce RTX 3070 кажется нам не совсем оправданной, тем более если у Вас есть уже игровой ноутбук с видеокартой серии RTX 2000, если игровой ноутбук приобретается Вами впервые, то игровой мобильный компьютер с мощной видеокартой RTX 3070 может стать мэйнстримом, балансируя между избыточной мощностью и желаемой стоимостью. Особенно это актуально для тех, кто вполне удовлетворен разрешением Full HD, ну или максимум 2K. Что касается производительности GeForce RTX 3070 Mobile, то она будет на 30- 40% быстрее, чем RTX 2070 Max-Q и судя по тестам так оно скорее всего и есть, потому что обычная GeForce RTX 3070 для ноутбуков с TGP 140 Вт быстрее RTX 2070 с TGP 115Вт. Если взять GeForce RTX 3070 с минимально возможным TGP в 85 Вт, то получается, что уровень ее производительности в играх примерно такой же как и у обычной мобильной GeForce RTX 2070, а вот от GeForce RTX 2070 Super, мобильная RTX 3070 с TGP 85Вт отстает, что хорошо заметно в тесте Assassin’s Creed Valhalla и Borderlands 3.

Теперь вполне можно играть и в 4K разрешении, только вот где найти ноутбук с таким высоким разрешением дисплея, вопрос риторический. На наш взгляд целесообразность покупки нового ноутбука с GeForce RTX 3070 кажется нам не совсем оправданной, тем более если у Вас есть уже игровой ноутбук с видеокартой серии RTX 2000, если игровой ноутбук приобретается Вами впервые, то игровой мобильный компьютер с мощной видеокартой RTX 3070 может стать мэйнстримом, балансируя между избыточной мощностью и желаемой стоимостью. Особенно это актуально для тех, кто вполне удовлетворен разрешением Full HD, ну или максимум 2K. Что касается производительности GeForce RTX 3070 Mobile, то она будет на 30- 40% быстрее, чем RTX 2070 Max-Q и судя по тестам так оно скорее всего и есть, потому что обычная GeForce RTX 3070 для ноутбуков с TGP 140 Вт быстрее RTX 2070 с TGP 115Вт. Если взять GeForce RTX 3070 с минимально возможным TGP в 85 Вт, то получается, что уровень ее производительности в играх примерно такой же как и у обычной мобильной GeForce RTX 2070, а вот от GeForce RTX 2070 Super, мобильная RTX 3070 с TGP 85Вт отстает, что хорошо заметно в тесте Assassin’s Creed Valhalla и Borderlands 3.

Обзор и сравнение видеокарт на базе NVIDIA RTX 2070 от ASUS, Gigabyte, Inno3D и MSI

16.01.19

Смотрите в этой статье:

Сравнение референсных характеристик видеокарт NVIDIA GeForce RTX 2070, RTX 2080 Ti, RTX 2080, GTX 1080 Ti, GTX 1080 и GTX 1070

Сводная таблица характеристик представленных в тесте видеокарт на базе NVIDIA GeForce RTX 2070

Видеокарта ASUS ROG Strix GeForce RTX 2070 OC edition

Видеокарта MSI GeForce RTX 2070 GAMING Z 8G

Видеокарта Gigabyte AORUS GeForce RTX 2070 XTREME 8G

Видеокарта Inno3D GeForce RTX 2070 Gaming OC X2

Описание тестового стенда и методики тестирования

Гистограммы с результатами тестов и выводы

Видеокарты на базе NVIDIA GeForce RTX 2070, которым посвящен данный материал, являются младшими моделями из уже представленных на данных момент графических адаптеров нового поколения с архитектурой NVIDIA Turing.

Если не брать во внимание очень специфическую NVIDIA Titan RTX стоимостью $2500, то пользовательские видеокарты с архитектурой NVIDIA Turing представлены семейством NVIDIA GeForce RTX 2080 Ti, RTX 2080 и RTX 2070. Это видеокарты высокого класса, а через некоторое время планируется появление и более простых устройств типа RTX 2060.

Это видеокарты высокого класса, а через некоторое время планируется появление и более простых устройств типа RTX 2060.

Смотрим на характеристики

Графические процессоры для новых видеокарт Turing выполняются по более «тонкому» 12-нанометровому техпроцессу. Но, по слухам, этот техпроцесс не является чем-то принципиально новым, а представляет собой лишь чуть доработанную версию 16-нанометрового техпроцесса, который используется в предшественниках.

Для удобства сравнения характеристики новых GeForce RTX 2080 Ti, RTX 2080 и RTX 2070 и предшественников GeForce GTX 1080 Ti, GTX 1080 и GTX 1070 мы свели их в одну таблицу.

Сравнение референсных характеристик видеокарт NVIDIA GeForce RTX 2070, RTX 2080 Ti, RTX 2080, GTX 1080 Ti, GTX 1080 и GTX 1070

От поколения к поколению видеокарт NVIDIA можно наблюдать рост стоимости видеокарт. Но если ранее он был довольно плавным, то в данном случае адаптеры NVIDIA Turing значительно превзошли предшественников по цене.

За что платим?

Отчасти такое повышение можно объяснить увеличившейся сложностью новых GPU. Обратите внимание, что они имеют сильно возросшее количество транзисторов и значительно более высокую площадь кристалла. Соответственно, можно предположить, что себестоимость таких кристаллов оказывается выше.

Есть некоторые девиации по значениям частот GPU. Память теперь новая. Вместо GDDR5X и GDDR5 видеокарты RTX получили GDDR6.

Но примечательно, что объем памяти в новом поколение видеокарт остался на том же уровне, что и у предшественников.

Очень важно, что появились совершенно новые ядра RT и тензорные ядра. Именно этим обусловлен такой рост числа транзисторов и площади кристалла GPU.

Трассировка лучей

Поколение видеокарт RTX 2080 Ti, RTX 2080, RTX 2070 на базе архитектуры Turing сама NVIDIA называет революционной и связывает это с аппаратной поддержкой трассировки лучей в реальном времени.

Для этого внедрены упоминаемые выше RT-ядра. NVIDIA считает это настолько важным, что привычную приставку GTX в новых видеокартах даже заменили на RTX, где RT — Ray Tracing (трассировка лучей).

Данной технологии на презентации видеокарт нового поколения было уделено чуть ли не главное внимание.

Если упрощенно, то с Ray Tracing связаны новые эффекты отражений на объектах (в том числе взаимных), отражений света и прохождения лучей сквозь объекты. При этом лучи могут иметь реалистичное преломление, наложение и т. д. Ray Tracing также позволяет использовать более реалистичные смягченные тени и формировать правдоподобное освещение.

Это действительно очень важное нововведение для индустрии, но, как ни парадоксально, именно с технологией Ray Tracing и связывают довольно холодный прием новых видеокарт пользователями.

Новые RT-ядра сделали кристалл более крупным и дорогим, а что пользователи получают взамен?

На момент выхода видеокарт RTX не было ни единой игры, которая бы обладала поддержкой Ray Tracing. Сейчас ситуация меняется, но очень медленно.

Сейчас ситуация меняется, но очень медленно.

К примеру, попробовать Ray Tracing вообще в какой-либо игре стало возможно совсем недавно с выходом Battlefield V.

Как оказалось, картинка в Battlefield V с эффектами меняется не так и кардинально. Улучшения есть, но совсем не скажешь, что получаешь принципиально новый уровень восприятия.

А вот вычислительные ресурсы Ray Tracing «подъедает» существенно. При активации трассировки лучей производительность может падаем более чем вдвое.

В результате, даже с дорогущей топовой NVIDIA GeForce RTX 2080 Ti, уровень FPS при Full HD-разрешении, максимальных настройках качества с использованием Ray Tracing не всегда сможет удовлетворить требовательного геймера.

А что тогда говорить о более простых RTX 2080, RTX 2070 и более высоких разрешениях?

Получается, что на данный момент игр с Ray Tracing практически нет, визуально разница в изображении с эффектами RT не такая кардинальная, а активация трассировки приводит к большому падению уровня FPS.

Для пользователей Ray Tracing в реальном времени пока является лишь потенциально перспективной технологией. Посмотрим, как будет развиваться ситуация.

DLSS-сглаживание, тензорные ядра и искусственный интеллект

Вдобавок к совершенно новым RT-ядрам в видеокартах RTX появились и тензорные ядра, предназначенные для рассчетов ИИ и нейросетей. Они работают в связке c RT-ядрами, но тензорные ядра могут использоваться и для других функций.

На базе их работы реализован новый метод сглаживания — DLSS (Deep Learning Super Sampling). Используется сниженное разрешение рендеринга, но за счет ИИ и тензорных ядер видеокарта преобразовывает изображение в более качественное, «додумывая» новые детали.

В зависимости от особенностей реализации за счет этого можно добиться увеличения производительности, повышения качества изображения или того и другого одновременно.

Опять-таки, как и в случае с Ray Tracing, для работы DLSS необходима поддержка со стороны игр. Указывается, что несколько десятков готовящихся к выходу игр будут поддерживать DLSS-сглаживание.

Указывается, что несколько десятков готовящихся к выходу игр будут поддерживать DLSS-сглаживание.

Одним из немногих тестов, где уже сейчас можно проверить DLSS, стал бенчмарк Final Fantasy XV Benchmark. Если в системе установлена видеокарта GeForce RTX, в настройках появляется соответствующий пункт, позволяющий активировать DLSS.

По нашим тестам, активация DLSS привела к существенному увеличению производительности.

Качество изображения с использованием DLSS и с обычным TAA-сглаживанием в данном приложении сопоставимо. Вы можете самостоятельно сравнить кадры с DLSS и с TAA.

- DLSS

- TAA

Что еще нового?

Продолжает совершенствоваться технология автоматического повышения частоты GPU. В видеокартах NVIDIA RTX используется уже четвертое поколение GPU Boost.

Добавлена возможность ручной корректировки алгоритма работы разгона. Но куда более интересно, что впервые появилась функция автоматического разгона.

Но куда более интересно, что впервые появилась функция автоматического разгона.

Если ранее для определения предельной частоты GPU требовалось экспериментировать, запускать различные игры, приложения, то сейчас процесс может быть сильно упрощен.

В приложениях типа MSI AfterBurner доступен новый пункт Nvidia Scanner. Нажав всего одну кнопку, через минут 15 автоматических тестов вы получите измененную кривую частот/напряжений GPU, соответственно, с более высокими значениями частот.

В наших тестах для всех видеокарт RTX 2070 мы проверяли такой автоматический разгон. Конечно, для получения еще более высоких результатов оверклокинга придется все же проводить более сложный разгон «вручную».

К видеокартам RTX можно подключить сразу два монитора с разрешением 8K. Максимальная кадровая частота будет составлять 60 Гц у обоих устройств вывода изображения.

Порты DisplayPort теперь соответствуют версии DisplayPort 1.4a, а HDMI — HDMI 2. 0b. Обратите также внимание на наличие разъема USB Type-C прямо на видеокарте. Он предназначен для новых VR-шлемов.

0b. Обратите также внимание на наличие разъема USB Type-C прямо на видеокарте. Он предназначен для новых VR-шлемов.

Впрочем, этот порт может использоваться для любых устройств с поддержкой USB Type-C.

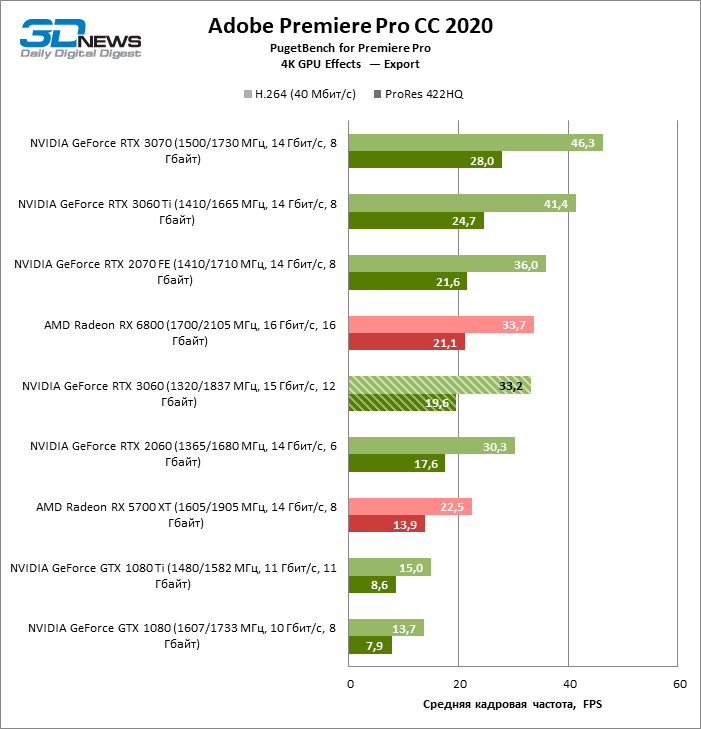

Вполне ожидаемо, что была проведена работа с различными видеокодеками. Например, добавлена поддержка компрессии данных в формате H.265 (HEVC) в режиме разрешении [email protected], а также повышено качество кодирования. Учитывая, что сегодня видеокарты активно используются при видеомонтаже, это весьма актуально.

Возможность объединения нескольких видеокарт в одной системе теперь доступна только в видеокартах самого высокого класса. NVIDIA GeForce RTX 2070 такой функции лишены.

Участники теста

В одном тесте нам удалось собрать сразу четыре видеокарты на базе NVIDIA GeForce RTX 2070 от разных производителей.

Это модели ASUS ROG Strix GeForce RTX 2070 OC edition, Gigabyte AORUS GeForce RTX 2070 XTREME 8G, Inno3D GeForce RTX 2070 Gaming OC X2 и MSI GeForce RTX 2070 GAMING Z 8G.

Gigabyte AORUS GeForce RTX 2070 XTREME 8G, ASUS ROG Strix GeForce RTX 2070 OC edition, MSI GeForce RTX 2070 GAMING Z 8G

Inno3D GeForce RTX 2070 Gaming OC X2

Все они имеют значительные отличия от референсных RTX 2070, получили повышенные частоты и используют фирменные системы охлаждения.

Сравнительная таблица характеристик

| ASUS ROG Strix GeForce RTX 2070 OC edition | Gigabyte AORUS GeForce RTX 2070 XTREME 8G | Inno3D GeForce RTX 2070 Gaming OC X2 | MSI GeForce RTX 2070 GAMING Z 8G | |

| Кодовый идентификатор модели | ROG-STRIX-RTX2070-O8G-GAMING | GV-N2070AORUS X-8GC | N20702-08D6X-2511683 | — |

| Поставщик | Представ-во ASUS | Представ-во Gigabyte | Представ-во Inno3D | Представ-во MSI |

| Цена, $ | 796 | 742 | 675 | 725 |

| Результаты измерений | ||||

| Производительность | 87,49 | 87,73 | 86,21 | 87,93 |

| Производитетльнось/Вт | 100 | 96,91 | 98,54 | 98,79 |

| Производитетльнось/Цена | 86,7 | 93,26 | 100 | 95,66 |

| Технические характеристики | ||||

| Чипсет | NVIDIA GeForce RTX 2070 | NVIDIA GeForce RTX 2070 | NVIDIA GeForce RTX 2070 | NVIDIA GeForce RTX 2070 |

| Техпроцесс чипсета, нм | 12 | 12 | 12 | 12 |

| Тип и объем памяти, ГБ | GDDR6, 8 | GDDR6, 8 | GDDR6, 8 | GDDR6, 8 |

| Конструкция системы охлаждения | фирменная | фирменная | фирменная | фирменная |

| Количество вентиляторов системы охлаждения | 3 | 3 | 2 | 2 |

| Количество занимаемых слотов | 3 | 3 | 2 | 3 |

| Субъективная оценка шумности охлаждения | Отлично | Отлично | Хорошо | Отлично |

| Номинальная частота GPU | 1410 | 1410 | 1410 | 1410 |

| Boost-частота GPU | 1815 | 1815 | 1755 | 1830 |

| Результирующая частота памяти, МГц | 14000 | 14142 | 14000 | 14000 |

| Шина памяти, бит | 256 | 256 | 256 | 256 |

| Требует дополнительного питания? | да | да | да | да |

Тип разъема доп. питания питания | 6pin+8pin | 6pin+8pin | 6pin+8pin | 6pin+8pin |

| Количество выходов HDMI/DisplayPort/USB Type-C | 2/2/1 | 3/3/1 | 1/3/1 | 2/2/1 |

ASUS ROG Strix GeForce RTX 2070 OC edition (ROG-STRIX-RTX2070-O8G-GAMING)

ASUS ROG Strix GeForce RTX 2070 OC edition

Представленная в тесте ASUS ROG Strix GeForce RTX 2070 OC edition на данный момент является самой мощной, в плане частоты GPU, и продвинутой среди всех видеокарт ASUS на базе RTX 2070.

Она имеет традиционный для ASUS ROG Strix дизайн, который практически не изменился со времен прошлого поколения.

Устройство получилось довольно крупным и в системе займет три слота расширения.

Тут используется модифицированная плата с конфигурацией фаз питания 10+2 и фирменная система охлаждения с тремя вентиляторами.

Как заявляется, вентиляторы имеют специальную конструкцию, а внутренности защищены от пыли. Кстати, направление вращения всех вентиляторов одинаковое.

Массивный радиатор СО пронизан шестью тепловыми трубками. Подошва теплоприемника имеет особую обработку, которую ASUS называет технологией MaxContact.

При осмотре ASUS ROG Strix GeForce RTX 2070 OC edition (ROG-STRIX-RTX2070-O8G-GAMING) со всех сторон обнаруживаются любопытные детали.

На плате установлены сразу две микросхемы BIOS с немного измененными режимами работы платы. Один из них (Performance) предусматривает повышенную эффективность охлаждения, что достигается более высокими скоростями работы вентиляторов, а второй (Quiet) рассчитан на более тихую эксплуатацию. Выбор BIOS осуществляется специальным переключателем.

Кстати, полная остановка вентиляторов при малой нагрузке становится доступна только при использовании варианта BIOS с режимом Quiet.

На торце выведена специальная кнопка для быстрого отключения/включения подсветки. Это неплохое решение, когда надо погасить свечение без использования фирменного ПО.

Также на плате предусмотрена площадка для ручного измерения напряжения RAM, GPU, PLL и набор контактов для подключения светодиодной ленты и корпусных вентиляторов. Скорость вращения этих вентиляторов можно связать с температурой GPU. Это классная функция.

На одной из сторон ASUS ROG Strix GeForce RTX 2070 OC edition можно заметить контакты для подключения светодиодной ленты и корпусных вентиляторов

Характеристики ASUS ROG Strix GeForce RTX 2070 OC edition (данные приложения GPU-Z)

Частота памяти в данной модели соответствует референсной, а вот Boost-частота GPU повышена очень значительно — с 1620 до 1815 МГц.

В результате ASUS ROG Strix GeForce RTX 2070 OC edition находится среди лидеров теста по производительности. Превзойти Gigabyte AORUS GeForce RTX 2070 XTREME 8G и MSI GeForce RTX 2070 GAMING Z 8G по скорости не удалось, так как все три модели, включая ASUS, имеют похожие рабочие частоты. Уж очень сильные видеокарты участвуют в тесте.

Уж очень сильные видеокарты участвуют в тесте.

Мониторинг работы ASUS ROG Strix GeForce RTX 2070 OC edition в приложении MSI Afterburner

При работе под нагрузкой в наших условиях температура GPU составила всего 57 °C. Для всех тестов производительности и замера температуры использовался BIOS с режимом Performance.

Учитывая довольно высокое энергопотребление видеокарты, это просто великолепный результат. К слову, это самое низкое значение температуры среди всех тестируемых видеокарт на базе RTX 2070 в этом тесте.

Скорость вращения вентиляторов составила около 1600 об/мин. При работе видеокарта не будет создавать шумовой дискомфорт.

При использовании автоматического разгона с изначальными настройками максимальная частота GPU почти достигла отметки 2100 МГц.

Кривые зависимости частоты и напряжения графического процессора ASUS ROG Strix GeForce RTX 2070 OC со стандартными настройками (сверху) и после автоматического разгона

ASUS ROG Strix GeForce RTX 2070 OC edition позволяет увеличить предел энергопотребления до 125%. Это самое высокое значение в тесте.

Это самое высокое значение в тесте.

Система подсветки состоит из нескольких элементов с RGB-подсветкой на передней панели, светящимся логотипом ASUS ROG по боку и еще одним крупным логотипом, выведенным на заднюю пластину.

Работой подсветки, разумеется, можно управлять. Доступны ряд эффектов, а также возможность смены цвета в зависимости от температуры GPU.

Особенность: цвет свечения может меняться, но одновременно все элементы подсветки имеют один и тот же цвет.

Весьма неплохо, но сегодня уже есть и более продвинутые решения, в том числе и среди участников теста. Подсветка видеокарт Gigabyte AORUS и MSI оказалась еще более крутой.

Фирменное ПО ASUS по возможностям примерно представляет собой объединение MSI Afterburner и GPU-Z

ASUS ROG Strix GeForce RTX 2070 OC edition — это очень мощная видеокарта на базе RTX 2070 с просто-таки отличной по эффективности системой охлаждения.

Она находится среди лидеров по производительности, имеет ряд любопытных дополнительных функций в виде двух микросхем BIOS, контактов для вентиляторов корпуса и светодиодной ленты.

Но при всех своих достоинствах, ASUS ROG Strix GeForce RTX 2070 OC edition обладает и самой высокой стоимости среди других участников теста на базе RTX 2070.

Оценка ASUS ROG Strix GeForce RTX 2070 OC edition (ROG-STRIX-RTX2070-O8G-GAMING):

+ отличная система охлаждения

+ отключение вентиляторов при низкой нагрузке

+ значительно повышенные частоты GPU

+ предел энергопотребления выше чем у других участников

+ двойной BIOS

+ контакты для подключения RGB светодиодных лент и вентиляторов корпуса

— самая высокая стоимость

— большие габариты

— сравнительно скромная комплектация

MSI GeForce RTX 2070 GAMING Z 8G

MSI GeForce RTX 2070 GAMING Z 8G

Если видеокарты ASUS ROG Strix в новом поколении выглядят почти также, как и в предыдущем, то MSI свою серию GAMING видоизменила существенно.

Узнаваемый дизайн с преобладанием красного цвета и вставками, напоминающими когти дракона, решили больше не использовать.

Модель хоть и не такая длинная, но широкая и в системе займет место трех слотов расширения.

MSI GeForce RTX 2070 GAMING Z 8G (внимание на приставку Z в названии) выделяется более высокими частотами по сравнению с близнецами MSI GeForce RTX 2070 GAMING X 8G и MSI GeForce RTX 2070 GAMING 8G и является самой быстрой RTX 2070 у компании MSI на данный момент.

Плата типично для серии GAMING переработанная. Распаяна конфигурация фаз питания 8+2. СО состоит из двух вентиляторов и мощного радиатора с шестью тепловыми трубками.

Если присмотреться, то в каждом вентиляторе чередуются лопасти двух видов. Технология носит название TORX FAN 3.0. В сочетании с новым дизайном рассеивающих пластин радиатора это, по информации производителя, будет способствовать лучшей эффективности.

Технология носит название TORX FAN 3.0. В сочетании с новым дизайном рассеивающих пластин радиатора это, по информации производителя, будет способствовать лучшей эффективности.

Система охлаждения и вправду оказалась очень эффективной.

Мониторинг работы MSI GeForce RTX 2070 GAMING Z 8G в приложении MSI Afterburner

Зафиксированная температура под нагрузкой — 66 °C. Но удивило другое. Данная температура держится при скорости вращения вентилятора всего 1100 об./мин.

В результате видеокарта работает очень тихо. По эффективности охлаждения MSI превзошла других участников кроме, пожалуй, ASUS ROG Strix GeForce RTX 2070 OC edition. Но с СО ASUS сравнивать сложно. С одной стороны, у конкурента более низкая температура, а с другой — это достигается при заметно более высоких оборотах вентиляторов.

Характеристики MSI GeForce RTX 2070 GAMING Z 8G (данные приложения GPU-Z)

Boost-частоте GPU видеокарты MSI GeForce RTX 2070 GAMING Z 8G составляет 1830 МГц. Это самое высокое значение среди всех участников теста. Но превосходство над ASUS ROG Strix GeForce RTX 2070 OC edition и Gigabyte AORUS GeForce RTX 2070 XTREME 8G совсем мизерное. У этих видеокарт данное значение составляет 1815 МГц.

Это самое высокое значение среди всех участников теста. Но превосходство над ASUS ROG Strix GeForce RTX 2070 OC edition и Gigabyte AORUS GeForce RTX 2070 XTREME 8G совсем мизерное. У этих видеокарт данное значение составляет 1815 МГц.

Частота памяти, при этом, стандартная. Логично, что RTX 2070 GAMING Z 8G оказалась среди лидеров по производительности. При автоматическом разгоне максимальная частота доходит до отметки 2100 МГц.

Кривые зависимости частоты и напряжения графического процессора Характеристики MSI GeForce RTX 2070 GAMING Z 8G (данные приложения GPU-Z) со стандартными настройками (сверху) и после автоматического разгона

Доступный лимит энергопотребления — 111%.

Очень порадовала новая система подсветки данной видеокарты. Светящимися участками по периметру окружили вентиляторы. Подсвечивается и логотип на боку.

Подсветка MSI GeForce RTX 2070 GAMING Z 8G

Все дело в том, как тут реализованы динамические эффекты. В некоторых режимах это, своего рода, цветовое шоу. Хотя тут и нет светящегося элемента на задней пластине данная подсветка MSI понравилась больше, чем решение у ASUS.

В некоторых режимах это, своего рода, цветовое шоу. Хотя тут и нет светящегося элемента на задней пластине данная подсветка MSI понравилась больше, чем решение у ASUS.

Управление подсветкой

В комплекте с видеокартой поставляется дополнительная планка для более надежного крепежа видеокарты в корпусе. Видеокарта действительно увесистая, но, на наш взгляд, большой необходимости в такой планке нет. Вероятно, она не помешает, при транспортировке корпуса.

Планка прикручивается в корпусе компьютера ниже видеокарты после чего устройство опирается на эту планку через мягкие прокрадки

MSI GeForce RTX 2070 GAMING Z 8G отличается и высоким заводским разгоном, и отличной по эффективности системой охлаждения, и интересной новой подсветкой. Хорошая получилась модель.

Оценка MSI GeForce RTX 2070 GAMING Z 8G:

+ отличная система охлаждения

+ отключение вентиляторов при низкой нагрузке

+ значительно повышенные частоты GPU

+ продвинутая система RGB-подсветки

+ дополнительная планка крепления в комплекте

— большие габариты

Gigabyte AORUS GeForce RTX 2070 XTREME 8G (GV-N2070AORUS X-8GC)

Gigabyte AORUS GeForce RTX 2070 XTREME 8G

Даже по сравнению с другими крупными видеокартами в тесте Gigabyte AORUS GeForce RTX 2070 XTREME 8G оказывается еще массивнее.

Gigabyte AORUS GeForce RTX 2070 XTREME 8G слева

Но основной вклад в толщину устройства вносит не радиатор СО, а довольно любопытное размещение вентиляторов.

Они расположены немного внахлест. За счет этого, при умеренной длине, удалось разместить сразу три 100-миллиметровых вентилятора.

Gigabyte AORUS GeForce RTX 2070 XTREME 8G является самой быстрой RTX 2070 у Gigabyte.

Характеристики Gigabyte AORUS GeForce RTX 2070 XTREME 8G (данные приложения GPU-Z)

Boost частота составляет 1815 МГц, что, впрочем, сравнимо с тестируемыми ASUS ROG Strix GeForce RTX 2070 OC edition и MSI GeForce RTX 2070 GAMING Z 8G.

Любопытно, что заводской разгон получила и память. Во всех остальных видеокартах RTX 2070 данного теста частоты памяти соотвествуют референсным.

Но прибавка по памяти в случае с AORUS GeForce RTX 2070 XTREME 8G чисто номинальная и мало влияет на итоговую производительность. Частоту подняли со стандартной 14 000 до 14 140.

Производительность Gigabyte AORUS GeForce RTX 2070 XTREME 8G оказалась на уровне видеокарт MSI и ASUS.

Используя автоматический разгон максимальное значение частоты GPU составило около 2100. Что примерно повторяет результаты MSI и ASUS.

Кривые зависимости частоты и напряжения графического процессора Gigabyte AORUS GeForce RTX 2070 XTREME 8G со стандартными настройками (сверху) и после автоматического разгона

Доступный для изменения максимальный лимит энергопотребления — 109%.

Конфигурация фаз системы питания — 10+2.

В отличие от других участников, в конструкции системы охлаждения вместо полированной пластины или испарительной камеры используется вариант, когда сами тепловые трубки касаются GPU.

Всего тепловых трубок пять.

Производитель обращает отдельное внимание, что центральный вентилятор имеет другое направление вращения по сравнению с крайними. Указано, что это позволяет избежать турбулентности и увеличивает эффективность СО.

Умеет модель и останавливать вентиляторы при низкой нагрузке. На боковой панели, традиционно для Gigabyte, даже выведена подсвечиваемая надпись “Fan Stop”, которая загорается, когда вентиляторы бездействуют.

Как такая СО показала себя в деле?

Зафиксированные значения температуры и оборотов вентиляторов под нагрузкой составили 67 °C при 1700 об./мин. Очень неплохо, но, получается, что эффективность СО участвующих в тесте ASUS ROG Strix GeForce RTX 2070 OC edition и MSI GeForce RTX 2070 GAMING Z 8G немного выше.

Мониторинг работы Gigabyte AORUS GeForce RTX 2070 XTREME 8G в приложении MSI Afterburner

Система подсветки в Gigabyte AORUS GeForce RTX 2070 XTREME 8G устроена очень необычно.

На краю одной из лопастей каждого вентилятора размещен RGB-диод. Этот диод может менять цвет в зависимости от того, в каком секторе круга он находится при вращении вентилятора. Получаемые эффекты впечатляют.

Подсветка Gigabyte AORUS GeForce RTX 2070 XTREME 8G

Видеокарта действительно способна привлечь немало внимания.

Дополнительно подсвечиваются логотипы, размещенные на лицевой, обратной сторонах и на боку видеокарты.

Из-за того, что подсветка AORUS GeForce RTX 2070 XTREME 8G связана с вращением вентиляторов обнаружились и не очень приятные особенности. Во-первых, эффекты с кольцами работают только при работающих вентиляторах. Во-вторых, заметно небольшое мерцание. Второй недостаток, впрочем, выражен не так существенно. Если видеокарта не находится постоянно в вашем поле зрения, неудобств не будет.

У видеокарты Gigabyte AORUS GeForce RTX 2070 XTREME 8G оказалось самое большое количество видеовыходов вреди других видеокарт на базе RTX 2070 в этом обзоре

В комплекте обнаружилась ножка для надежной фиксации видеокарты в корпусе.![]() Да, видеокарта увесистая, но острой необходимости в такой дополнительной поддержке, на наш взгляд, нет.

Да, видеокарта увесистая, но острой необходимости в такой дополнительной поддержке, на наш взгляд, нет.

К слову, уровень материалов и обработки у этой ножки просто изумительные.

Неужели такого рода аксессуары становится трендом для видеокарт высокого класса?

Резюмируя, можно сказать, что Gigabyte AORUS GeForce RTX 2070 XTREME 8G выделяется не только значительным заводским разгоном, но и довольно смелым дизайном в сочетании с любопытной системой подсветки.

Это очень достойный соперник для других мощнейших участников данного теста.

Оценка Gigabyte AORUS GeForce RTX 2070 XTREME 8G (GV-N2070AORUS X-8GC):

+ эффективная система охлаждения

+ отключение вентиляторов при низкой нагрузке

+ значительно повышенные частоты GPU

+ эффектная система RGB-подсветки

+ дополнительная ножка крепления в комплекте

— большие габариты

— Эффекты системы подсветки зависят от того, вращаются вентиляторы или нет

Inno3D GeForce RTX 2070 Gaming OC X2 (N20702-08D6X-2511683)

Inno3D GeForce RTX 2070 Gaming OC X2

Inno3D GeForce RTX 2070 Gaming OC X2 — это далеко не рядовая модель. Тут и заводской разгон GPU, и фирменная система охлаждения, и подсветка с RGB-элементами.

Тут и заводской разгон GPU, и фирменная система охлаждения, и подсветка с RGB-элементами.

Но на фоне других видеокарт GeForce RTX 2070 из данного теста, а это оказались очень продвинутые модели, она выглядит скромнее.

Видеокарта от Inno3D единственная в тесте занимает не три, а два слота расширения.

Радиатор содержит четыре тепловые трубки и обдувается парой вентиляторов.

Учитывая более скромный класс устройства, по эффективности охлаждения Inno3D GeForce RTX 2070 Gaming OC X2 ожидаемо уступила другим участникам теста.

Мониторинг работы Inno3D GeForce RTX 2070 Gaming OC X2 в приложении MSI Afterburner

Под нагрузкой температура составила 66 °C. Это более чем комфортный уровень, но обороты вентиляторов при этом оказались на уровне 2050 об/мин, что заметно выше, чем у представленных видеокарт ASUS, Gigabyte, MSI.

Соответственно, Inno3D GeForce RTX 2070 Gaming OC X2 работает не так тихо, но уровень ее шума большого дискомфорта создавать не должен.

Видеокарта умеет останавливать вентиляторы при низкой нагрузке, но делает это несколько своеобразно. Перед окончательной остановкой вентиляторы еще пару десятков раз раскручиваются от 0 до, примерно, 600 об./мин. Вполне возможно, что этот «баг» может быть решен в новой версии прошивки, хотя и сейчас существенной проблемой это не является.

На гистограмме видно, как вентиляторы перед полной остановкой некоторое время «пульсирует» со скоростью от 0 до 600 об/мин.

Характеристики Inno3D GeForce RTX 2070 Gaming OC X2 (данные приложения GPU-Z)

Boost-частота GPU повышена со стандартных 1620 до 1755 МГц. Это неплохой заводской разгон, но, опять-таки, конкуренты оказались уж слишком мощными и у них этот параметр еще выше.

Как результат, Inno3D GeForce RTX 2070 Gaming OC X2 немного уступила соперникам по производительности.

Если проанализировать полученную кривую частоты GPU/напряжения при автоматическом разгоне, то можно увидеть, что максимальная частота GPU примерно на 50 МГц ниже чем у других видеокарт RTX 2070 в тесте при заданных значениях напряжений.

Кривые зависимости частоты и напряжения графического процессора Inno3D GeForce RTX 2070 Gaming OC X2 со стандартными настройками (сверху) и после автоматического разгона

Подсветкой в Inno3D GeForce RTX 2070 Gaming OC X2 оснащены несколько элементов. На лицевой панели логотип Inno3D подсвечивается белым цветом. Зажигаются также и желтые вставки рядом с этим логотипом. А вот логотип Inno3D на боку может светиться уже любым цветом (RGB-подсветка).

Подсветка Inno3D GeForce RTX 2070 Gaming OC X2

Доступно управление подсветкой при помощи приложения.

Фирменное ПО Inno3D

Да, Inno3D GeForce RTX 2070 Gaming OC X2 несколько уступила соперникам в скорости и в эффективности системы охлаждения. Но для многих это все может быть запросто нивелировано тем, что Inno3D GeForce RTX 2070 Gaming OC X2 отличается заметно более доступной стоимостью и по соотношению производительности и цены она переигрывает всех других участников данного теста.

Но для многих это все может быть запросто нивелировано тем, что Inno3D GeForce RTX 2070 Gaming OC X2 отличается заметно более доступной стоимостью и по соотношению производительности и цены она переигрывает всех других участников данного теста.

А еще у Inno3D GeForce RTX 2070 Gaming OC X2 весьма продвинутая комплектация. Модель поставляется с игровым ковриком и ключами для тестов VRMark, 3DMark.

Оценка Inno3D GeForce RTX 2070 Gaming OC X2 (N20702-08D6X-2511683):

+ наилучший баланс стоимости и производительности среди всех видеокарт на базе RTX 2070 в тесте

+ отключение вентиляторов при низкой нагрузке

+ заводской разгон GPU

+ интересная комплектация

— сравнительно скромная подсветка

— странное поведение вентиляторов при переходе в режим остановки

Как мы тестировали видеокарты

Видеокарты работали с использованием изначальных настроек драйверов, оптимизированные игровые профили не применялись.

Видеокарты тестировались без разгона и без использования фирменных профилей (OC, Gaming, Silence и т. д.), которые иногда доступны при установке фирменного программного обеспечения.

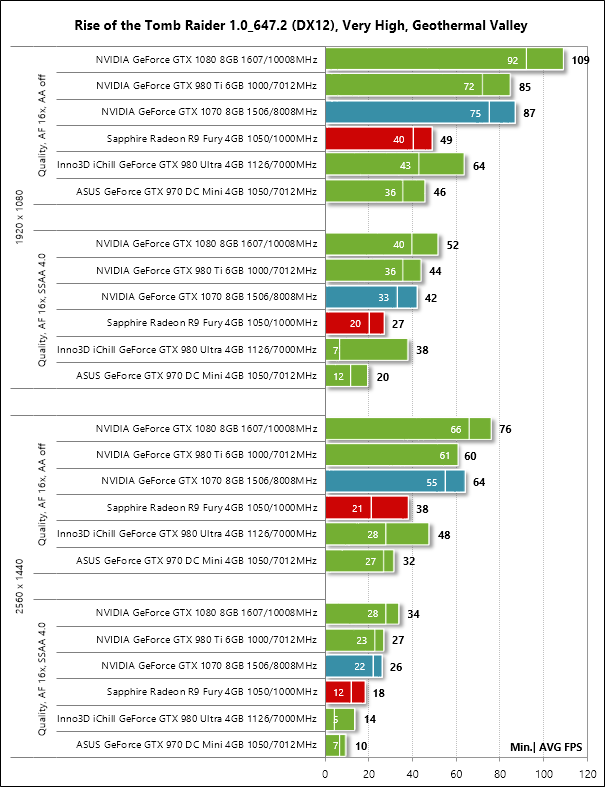

Тестируемые видеокарты на базе RTX 20170 мы сравнивали с видеоадаптерами прошлого поколения на базе GTX 1080 и GTX 1080 Ti, в роли которых выступили MSI GeForce GTX 1080 GAMING X 8G и Gigabyte GeForce GTX 1080 Ti Gaming OC 11G.

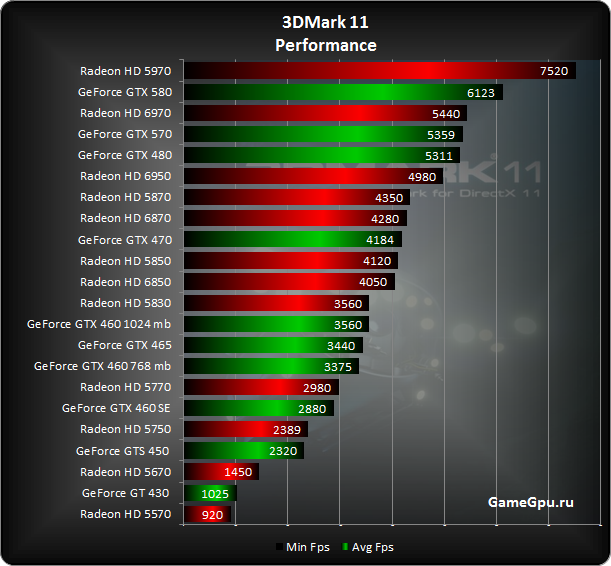

В качестве тестовых приложений для определения производительности видеокарт мы использовали современные игры с поддержкой DirectX 11 и DirectX 12, которые имеют встроенные бенчмарки. Также в программу вошли популярные синтетические тесты 3DMark.

В каждой игре применялись максимальные или близкие к максимальным настройки графики. В играх мы использовали разрешение 2560×1440 и 3840×2160 пикс. (4K-разрешение). В 3DMark 11 видеокарты тестировались с предустановкой Extreme, а в 3DMark (2013) использовались тесты Fire Strike Extreme, Fire Strike Ultra и DirectX 12-тест Time Spy.

Отслеживание максимальной температуры GPU и энергопотребления системы (без монитора) производилось в игре Metro: Last Light. Именно в этой игре видеокарты, по наблюдениям, нагревались наиболее интенсивно и происходило максимальное энергопотребление.

Сама система эксплуатировалась вне корпуса ПК (открытый стенд) при температуре в помещении около 21 °C. Уровень шума, создаваемый работой систем охлаждения видеокарт, оценивался субъективно.

Итоговая оценка в категории «Производительность» определялась на базе всех тестов с равнозначным вкладом каждого теста. При этом, если говорить об играх, для уменьшения влияния зависимости от процессора, при подсчете общей производительности (категория «Производительность») учитывались только результаты с разрешением 3840×2160 пикс. (4K).

Результаты с разрешением 2560×1440 пикс. приведены для ознакомления.

Гистограммы нормированы в процентах с сортировкой моделей по результатам тестов. Конкретные результаты в виде баллов и FPS также указаны.

Стоимость видеокарт указана на базе данных крупных интернет-магазинов (на момент публикации) с сайта Hotline.

В отдельном тесте Final Fantasy XV benchmark проводились эксперименты с технологией DLSS (см. гистограмму выше).

Конфигурация тестовой платформы:

Процессор: Intel Core i7-3770K, разогнанный до 4,4 МГц

Материнская плата: Biostar Hi-Fi Z77X

Объем оперативной памяти: 4×4 ГБ DDR3 1600

Накопители: SSD (система), HDD

Операционная система: Windows 10 Pro 64 бит

Монитор: Philips 272P7VPTKEB с разрешением 4K

Используемый драйвер NVIDIA для всех видеокарт: GeForce 416.94

Результаты тестов

Выводы

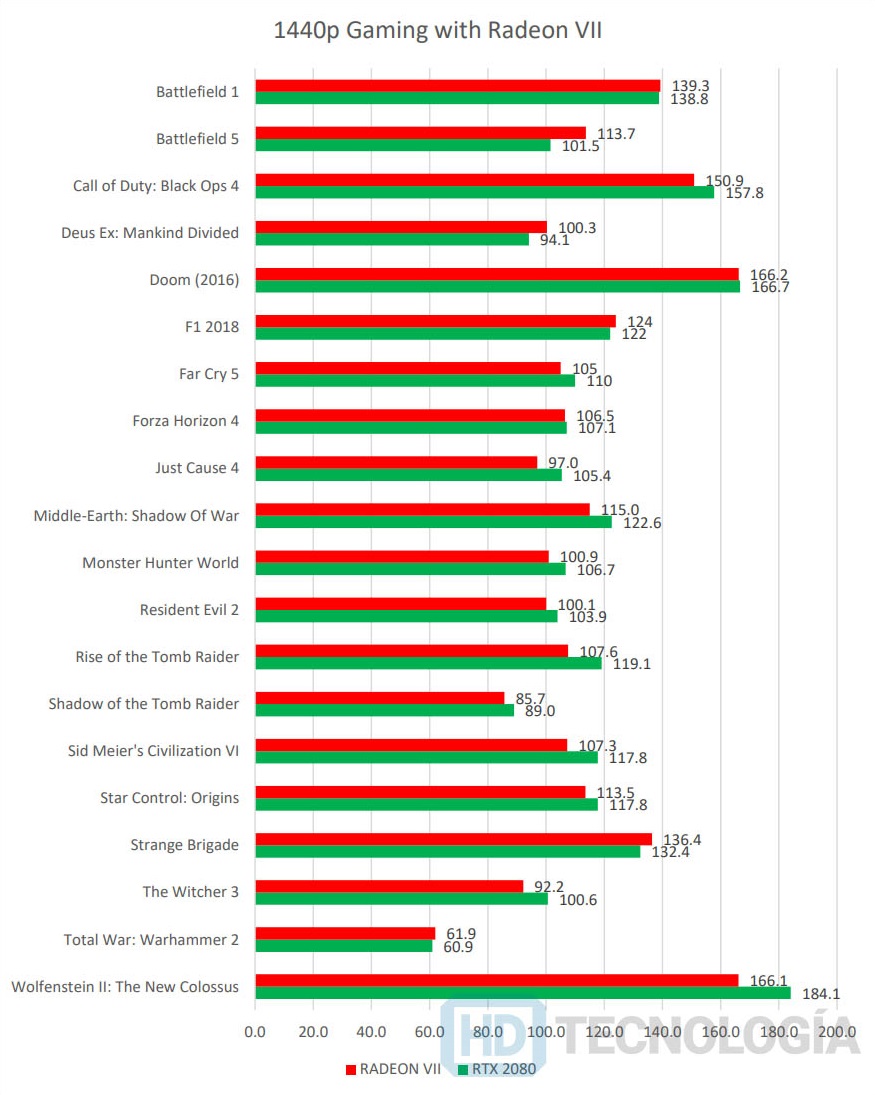

Как видно по результатам тестов, если сравнивать с решениями прошлого поколения, производительность новых видеокарт на базе RTX 2070 находится между NVIDIA GeForce GTX 1080 и GTX 1080 Ti ближе к GTX 1080.

Тройка ASUS ROG Strix GeForce RTX 2070 OC edition, Gigabyte AORUS GeForce RTX 2070 XTREME 8G и MSI GeForce RTX 2070 GAMING Z 8G — это очень «навороченные» видеокарты. Они имеют продвинутые системы подсветки, значительно повышенные частоты GPU.

Разницу в скорости между ними без специальных тестов вы точно не заметите. По эффективности систем охлаждения в этой тройке лидируют модели от ASUS и MSI.

ASUS позволяет сильнее других увеличить лимит энергопотребления. Эта же модель, кстати, выделяется и самой высокой стоимостью среди всех участников теста.

По впечатлениям от работы подсветки Gigabyte AORUS и MSI можно поставить несколько выше, чем ASUS. Inno3D тут в аутсайдерах.

Представленная в тесте Inno3D GeForce RTX 2070 Gaming OC X2 скромнее на фоне тройки ASUS, Gigabyte AORUS и MSI, хотя тоже далеко не рядовая модель. Она имеет более низкие частоты GPU, не такую продвинутую систему охлаждения и уступит по возможностям подсветки и разгона.

Но, зато, данная модель от Inno3D и самая доступная по цене. По соотношению производительности и стоимости она превосходит других участников теста.

Разница в скорости между Inno3D и тройкой ASUS, Gigabyte AORUS, MSI есть, но она не такая и существенная. Если есть желание сэкономить — это очень достойный вариант.

С самими участниками теста полный порядок. Любая видеокарта из теста — это качественное устройство с высокой производительностью, эффективным охлаждением без каких-то существенных недостатков.

Но новое поколение видеокарт RTX в целом оставляет целый ряд поводов для раздумий, хотя именно переход к RTX производитель называет революционным.

Если не «копать» сильно далеко в прошлое и взять во внимание переходы от поколения GTX 700 к GTX 900 (серия 800 в десктопных видеокартах была пропущена) и от GTX 900 к GTX 1000, то всегда новое поколение видеокарт отличалось сильно возросшей производительностью с одновременным значительным улучшением энергопотребления. При этом большого скачка стоимости равнозначных моделей не происходило.

А что же мы видим сейчас с выходом поколения NVIDIA GeForce RTX?

Да, рост производительности есть, но он не такой заметный, как это было ранее с новым поколением видеокарт.

По энергоэффективности новинки лучше моделей GTX 1000, но совсем незначительно.

А еще вы заметили, что в поколении RTX не произошло роста объема видеопамяти?

Но главное, что новые видеокарты оказались намного дороже своих предшественников.

Причем, ожидать значительного снижения стоимости видеокарт NVIDIA RTX довольно сложно. Они получили намного более сложные и дорогие в производстве графические процессоры.

Проблема в том, что значительная часть усложнений в новых GPU пошла на используемые впервые RT-ядра (аппаратная поддержка трассировки лучей), которые пока мало где можно задействовать. Кстати, на момент выхода видеокарт RTX игр с аппаратной поддержкой трассировки не было вовсе!

И тут еще большой вопрос, стоят ли те изменения в изображении, которые привносит трассировка лучей, очень серьезного падения производительности, происходящего при активации этой функции.

Получается, что на данный момент по соотношению производительности и стоимости новинки RTX 2000 уступают видеокартам-предшественникам серии GTX 1000 (прошлое поколение на архитектуре Pascal).

Да, потенциально RTX 2000 могут наращивать свою привлекательность со временем, с появлением большего количества игр, поддерживающих трассировку лучей и DLSS-сглаживание, но пока об этом говорить рано.

Philips 272P7VPTKEB

Благодарим компанию Philips за предоставленный 4K-монитор Philips 272P7VPTKEB

Смотрите также:

Обзор видеокарт на базе NVIDIA GeForce GTX 1070 Ti от ASUS, Gigabyte и MSI. Заполняя ниши

evoИнженер тестовой лаборатории

Читайте также

мощные видеокарты, не интересные майнерам

Бум криптовалют продолжается уже несколько месяцев и не думает идти на спад. Видеокарт в продаже тоже больше не становится из-за дефицита как видеочипов, так и видеопамяти. Даже по самым оптимистичным оценкам ситуация улучшится лишь осенью, однако нетребовательным геймерам повезло — Nvidia готовит пару видеокарт, которые точно не заинтересуют майнеров.

И дело тут не в программной «антимайнинговой» защите как у GeForce RTX 3060, которую быстро удалось обойти — у новинок в лице RTX 3050 и 3050 Ti будет по 4 ГБ видеопамяти стандарта GDDR6, чего уже не хватает для майнинга самой выгодной криптовалюты, эфира. Да, есть и другие альткоины, которые получится добывать на таких видеокартах, но они ощутимо менее прибыльные и сильнее нагружают видеочип, что приводит к большому потреблению энергии. Поэтому есть шанс, что линейка RTX 3050 будет доступна в рознице за адекватные деньги.

И теперь ресурсы Videocardz и Notebookcheck выложили технические характеристики и тесты новинок — правда, в мобильном исполнении, но скорее всего десктопные решения будут еще быстрее. Старшая RTX 3050 Ti может похвастаться 2560 ядрами CUDA, младшая RTX 3050 — 2048. Обе имеют настраиваемый теплопакет от 35 до 80 Вт, и, как уже было сказано выше, 4 ГБ видеопамяти GDDR6 на частоте 11 ГГц.

Что касается производительности, то новинки в полтора раза быстрее базовой GTX 1650 в тесте 3Dmark, а в относительно новой и тяжелой игре Shadow of The Tomb Raider обе видеокарты способны выдать 60 FPS на ультра-настройках графики в FHD, более того — старшая RTX 3050 Ti на средних настройках даже обгоняет RTX 2060. В итоге можно сказать, что это будут неплохие решения для игр в 1920х1080, которые позволят поиграть в большинство новых проектов на высоких и даже ультра-настройках графики, при этом как базовые решения в линейке RTX 30 они скорее всего будут не особо дорогими.

iGuides в Telegram — t.me/igmedia

iGuides в Яндекс.Дзен — zen.yandex.ru/iguides.ru

Появились официальные тесты видеокарты GeForce RTX 3060 Ti — она обходит GeForce RTX 2080 Super

Веб-ресурс VideoCardz опубликовал результаты тестов производительности видеокарты GeForce RTX 3060 Ti, чей выход ожидается 2 декабря. Сообщается, что сама NVIDIA поделилась слайдом из грядущей презентации с прессой.

Как можно видеть на слайде ниже, производительность новинки в 1,4 раза выше предшественника в лице GeForce RTX 2060 Super. Более того, в большинстве случаев GeForce RTX 3060 Ti обходит даже модель GeForce RTX 2080 Super. Нужно еще дождаться выхода детализированных независимых обзоров с более объективной оценкой, но в целом оценка NVIDIA не вызывает сомнений.

Официальные тесты производительности NVIDIA GeForce RTX 3060 Ti. Источник: VideoCardzОснова RTX 3060 Ti — урезанный кристалл NVIDIA GA104, в его конфигурации 4864 ядра CUDA, 152 тензорных и 38 RT-ядер. Базовая частота GPU составляет 1410 МГц, а частота в режиме Boost — 1665 МГц. По характеристикам памяти RTX 3060 Ti повторяет RTX 3070, которая тоже использует урезанный кристалл GA104: она получила 8 ГБ памяти GDDR6 с эффективной частотой 14 ГГц, соединенной с GPU 256-раздядной шиной (пропускная способность составляет 448 Гбайт/с) и TGP 180 Вт.

Главным же козырем RTX 3060 Ti станет относительно низкая цена — $400 для рынка США. Важно подчеркнуть, что это цена без обязательных налогов и наценки розничных магазинов. В украинских магазинах, как обычно, карта будет продаваться по более высокой цене.

| Видеокарта | GeForce RTX 3090 | GeForce RTX 3080 | GeForce RTX 3070 | GeForce RTX 3060 Ti |

|---|---|---|---|---|

| Графический процессор | GA102 | GA102 | GA104 | GA104 |

| Количество транзисторов, млн. шт | 28 000 | 28 000 | 17 000 | 17 400 |

| Техпроцесс, нм | 8 (Samsung) | 8 (Samsung) | 8 (Samsung) | 8 (Samsung) |

| Количество ядер CUDA | 10496 | 8704 | 5888 | 4864 |

| Количество тензорных ядер | 328 | 272 | 184 | 152 |

| Количество ядер RT | 82 | 68 | 46 | 38 |

| Частота ядра Boost, МГц | 1700 | 1710 | 1730 | 1665 |

| Шина памяти, бит | 384 | 320 | 256 | 256 |

| Тип памяти | GDDR6X | GDDR6X | GDDR6 | GDDR6 |

| Частота памяти, МГц | 19 500 | 19 000 | 14 000 | 14 000 |

| Объем памяти, ГБ | 24 | 10 | 8 | 8 |

| Вычислительная мощность (FP32) | 35,7 Тфлопс | 29,8 Тфлопс | 20,4 Тфлопс | 16,2 Тфлопс |

| Мощность, Вт | 350 | 320 | 220 | 180 |

| Интерфейс | PCI-E 4.0 | PCI-E 4.0 | PCI-E 4.0 | PCI-E 4.0 |

| Дата выхода | 24 сентября 2020 | 17 сентября 2020 | 29 октября 2020 | ноябрь 2020 |

| Рекомендованная стоимость, долл США | $1499 | $699 | $499 | $399 |

Первые карты RTX 3060 Ti уже начали прибывать в магазины. Собственно, PCMasterRace опубликовал фото варианта ASUS GeForce RTX 3060 Ti TUF (на заглавном изображении) с массивным трехвентиляторным кулером, который, вероятно, будет также выделяться заводским разгоном.

RTX 3060 Ti начали поступать к ритейлерам.Стресс-тест GPU NVidia на транскодинге живых потоков / Хабр

Ниже — подробный рассказ о том, как мы нагрузили карту от NVidia задачами транскодирования видео для его потоковой передачи. Покажем, что попробовали, что получилось, и как лучше всего использовать видеокарты для стриминга в онлайне.На протяжении нескольких лет наша команда разрабатывает продукты для обработки и раздачи медиа-контента в онлайне.

В этой статьене так давно было расписано, зачем владельцам контента подобные решения могут быть нужны в наш век YouTube.

Одним из наших продуктов является медиа-сервер Nimble Streamer — это серверное ПО, которое берёт на вход живые потоки и файлы и делает их доступными большому числу зрителей, попутно позволяя монетизировать контент. Это нативное приложение, написанное на С++ и портированное на все популярные ОС (Linux, Windows, MacOS) и платформы (x64, ARM). С самого начала низкая ресурсоёмкость и большая производительность были главными требованиями, и нам удаётся достигать в этом хороших показателей.

В прошлом году мы выпустили дополнение в Нимбл Стримеру — транскодер живых потоков. Это приложение позволяет брать на вход поток видео и/или аудио в разных форматах и делать с ними различные преобразования в реальном времени. Функциональность включает в себя декодирование (как программное, так и аппаратное), преобразование видео и аудио с помощью фильтров (изменение размера, наложение и т.п.) и кодирование (энкодинг) — как программное, так и аппаратное.

Управляется транскодер через веб-сервис WMSPanel, сценарии транскодирования создаются через drag-n-drop интерфейс, что позволяет наглядно видеть процесс. Различные сценарии можно запускать вместе — при таком подходе удобно запускать комбинации тестов, нагружая сервер в любых вариациях.

В этих видео можно посмотреть примеры работы интерфейса.

Декодирование каждого потока делается только один раз перед всеми дальнейшими преобразованиями… Это позволяет сэкономить ресурсы на дорогостоящей операции декодинга, это будет хорошо видно дальше по ходу тестов.

Одним из механизмов преобразования, который можно использовать в нашем транскодере, является аппаратное декодирование и кодирование видео с помощью GPU от NVidia. Графические карты последних поколений позволяют брать на себя часть типовых задач, что снимает нагрузку с CPU. Наш транскодер умеет работать с этим железом, чем активно пользуются наши клиенты.

По ходу общения с представителями российского офиса NVidia нам предложили попробовать устроить совместное стресс-тестирование нашего транскодера и NVidia GPU, чтобы понять, каков будет экономический эффект от подобного тандема по сравнению с исключительно программным транскодированием, без аппаратного ускорения. Кроме того, хотелось понять, как наиболее оптимально использовать GPU, и по возможности дать хорошие рецепты.

Нам требовалось оперативно получить соответствующее железо и доступ к нему, для цикла наших экспериментов. Мы планировали уложиться в пару недель. Осталось найти, где же взять оборудование. Оптимальным вариантом было бы найти их в облаке и получить удаленный доступ. Поискав варианты выяснилось, что в AWS пока нет VM с GPU поколения Maxwell, а в облаке Azure пока только планируется начать их предоставлять в скором времени.

1. Железо от NVidia в облаке Softlayer, настройка Nimble Streamer

При содействии NVidia, компания IBM предоставила нам доступ к своему облаку — IBM Bluemix Cloud Platform (в прошлом

Softlayer). Это большая сеть современных ЦОД-ов (около 50 на момент публикации) по всему миру, связанных общей частной сетью и предоставляющих большой выбор облачных инфраструктурных сервисов. Все ЦОД-ы унифицированы и позволяют арендовать от одного до сотен виртуальных или физических серверов требуемых конфигураций в течении нескольких часов, а также балансировщики, системы хранения, файрволы — в общем всё, что требуется чтобы построить надежную ИТ-инфраструктуру под развертываемый ИТ-сервис.

Российское представительство IBM предоставило нам полный доступ к порталу самообслуживания для управления облачными услугами и к нужной серверной конфигурации, где мы смогли поработать с разными входными потоками и настройками нашего транскодера.

Железо

Сначала нам предоставили физический сервер (bare-metal) с 128 ГБ RAM и 2xGPU NVidia Tesla M60 и предустановленной ОС Ubuntu 14.04. Все параметры сервера, пароли, версии прошивок, его коммутация, выделенные IP, состояние аппаратных компонент, были видны прямо в личном кабинете, позволяющем сделать с арендованным железом требуемые манипуляции, что минимизировало необходимость взаимодействия со службой поддержки IBM. В ходе прогона тестов, выяснилось, что нам не удается оптимально нагрузить такую конфигурацию, из-за ряда ограничений при генерации контекстов.

Нам захотелось уменьшить конфигурацию. Поскольку мы использовали облачную платформу, то потребовалось через портал самообслуживания запросить изменения в конфигурации. После согласования, данная операция заняла около 2 часов, в утвержденное окно обслуживания. В течении этого времени, технический персонал в ЦОД-е Амстердама, извлек лишние компоненты (планки RAM и 1xGPU) из предоставленного нам ранее сервера и вернул его в строй. Надо отметить, что для разработчиков такой вариант очень удобен, поскольку нет необходимости ни самим разбираться с настройками железа, ни чинить его, ни даже тратить время на установку ОС. Напомню, в данном случае не используется гипервизор поскольку нам надо выжать максимум из аппаратных ресурсов.

По итогам наших изысканий мы остановились на следующей конфигурации сервера:

Dual Intel Xeon E5-2690 v3 (2.60GHz)

24 Cores

64GB RAM

1TB SATA

Имеем 2 процессора по 12 ядер, а благодаря Hyper threading получаем вдвое больше, т.е. виртуально 48 ядер.

В сценариях с графическим ускорителем использовалась карта на базе чипа GM204 — Tesla M60:

NVIDIA Tesla M60

1xGPU: 2 x Maxwell GM204

Memory: 16GB GDDR5

Clock Speed: 2.5 GHz

NVIDIA CUDA Cores: 2 x 2048

Memory Bandwidth: 2 x 160GB/sec

Обращаю внимание, что на приведённом железе не делалось никакого affinity, chip tuning-а, overclocking-а и прочей магии — только неразогнанные CPU и GPU, и для GPU использовался только официальный драйвер, взятый с сайта NVidia. Если у кого-то есть подобный опыт — поделитесь в комментариях.

Итак, мы получили доступ. Беглое ознакомление с веб-интерфейсом панели управления (там всё просто и понятно), далее доступ к серверу через SSH — и вот мы уже в привычной командной строке Ubuntu, ставим Nimble Streamer, регистрируем свежую лицензию транскодера и делаем небольшую настройку конфига.

Nimble Streamer Transcoder

Nimble Streamer был настроен на предварительное создание кеша контекстов GPU. Связано это с тем, что у GPU есть ограничение на максимальное число создаваемых контекстов декодинга и энкодинга, а кроме того, создание контекстов “на лету” может занимать слишком много времени.

Более подробно о проблеме создания контекстов — в соответствующем разделе ниже.

Настройки Нимбла на примере первой серии тестов:

nvenc_context_cache_enable = true

nvenc_context_create_lock = true

nvenc_context_cache_init = 0:30:15,1:30:15

nvenc_context_reuse_enable = true

Более подробно про эти настройки написано

в нашей статье.

Перед запуском каждой серии тестов кеш настраивался отдельно, с учетом специфики каждой задачи.

Создание сценариев транскодинга

Далее работа шла в нашем сервисе WMSPanel, где и происходит настройка сценариев транскодера.

Как уже было сказано, работа идёт через веб-интерфейс, всё предельно понятно и удобно. Мы создали ряд сценариев, сочетающих разные варианты транскодинга (CPU/GPU), разные варианты разрешений и разные параметры энкодинга (CPU/GPU, профайл, битрейт и т.п.)

Наборы сценариев можно запускать одновременно, что даёт возможность вводить в оборот разные сочетания тестов, повышать нагрузку в разном порядке и менять её в зависимости от ситуации. Просто выделяем нужные сценарии и останавливаем либо возобновляем их.

Вот так выглядит набор сценариев:

Вот пример одного из сценариев:

Декодер с GPU выглядит вот так:

Накладываем фильтр размера изображения:

А вот энкодер для варианта с GPU:

В целом работу интерфейса транскодера можно посмотреть на этих видео.

2. Транскодирование потоков FullHD 1080p

Для начала мы опробовали сценарий с самыми большими нагрузками, чтобы узнать пределы возможностей железа. На данный момент самым “тяжёлым” из используемых на практике разрешений является FullHD 1080p.

Для генерации исходных живых потоков был взят файл в FullHD (1920*1080) в high profile H.264. Сам контент- это видеоэкскурсия по городу, т.е. это видео со средней интенсивностью смены изображения. Нет статичных одноцветных кадров, которые могли бы облегчить работу транскодеру, но нет и слишком быстрой смены видов и цветов. Одним словом — довольно типовая нагрузка.

На вход в Nimble Streamer подавали 36 одинаковых потоков, которые затем использовались в транскодере в разных сценариях.

Сценарий транскодинга используется типовой — входящий поток 1080p high profile, из него делаются 720p, 480p, 360p main profile и далее потоки baseline profile: 240p, 160p. Итого, на входе 1 поток, на выходе 5. Обычно также делается pass-through (передача без изменений) исходного потока, чтобы зритель мог выбрать собственно 1080p при просмотре. Его мы не добавляли в сценарии, т.к. в нём не используется транскодинг — идёт прямая передача данных из входа на выход. Этот сценарий у нас в Нимбле оптимизирован и в реальных условиях это относительно немного увеличит потребление памяти.

Аудио в генерируемых потоках — нет. Добавление аудио в сценарии не даст значительных нагрузок на CPU, но для чистоты эксперимента звук мы исключили.

Тест на CPU, без GPU

Для начала мы запустили сценарии транскодинг без использования GPU, указав в сценариях программные декодер и энкодер.

В результате получилось обработать только 16 потоков на вход с выдачей 80 потоков всех разрешений на выход.

Нагрузка CPU — 4600%, т.е. было задействовано 46 ядер. Расход RAM — порядка 15Гб.

Тест на CPU + GPU

Кеш контекстов при запуске настроен как 0:30:15,1:30:15 — т.е. 30 контекстов на энкодинг, 15 на декодинг, у каждого GPU.

Напомню, что на GPU у нас два ядра, что позволяет распараллеливать задачи — это нам пригодится.

Максимальная нагрузка получилась при следующей конфигурации потоков.

На вход декодера GPU0 и GPU1 — по 15 потоков. Таким образом мы получаем 30 декодированных потоков, готовых к дальнейшему использованию. Каждый поток декодируется только один раз, независимо от того, в скольких сценариях он в дальнейшем используется.

На энкодеры GPU0 и GPU1 подавалось по 15 потоков для получения 720p, т.е. получилось 30 потоков 720p на выход.

Также на энкодеры GPU0 и GPU1 давалось по 15 потоков для 480p — и так же получилось 30 потоков 480p на выход.

Поскольку контексты энкодера были исчерпаны, энкодинг остальных разрешений был установлен на CPU. Получилось следующее:

- 30 потоков 360p

- 30 потоков 240p

- 30 потоков 160p

Нагрузка получилась 2600% CPU, 75% декодер, 32% энкодер. Далее CPU был догружен 6 потоками на декодинг, для каждого настроено по 5 аналогичных разрешений, итого 30 потоков на выход.

Итого получили на вход 36 потоков, выдали на выход — 180 потоков. Финальная нагрузка зафиксирована следующая: 4400% CPU, 75% декодер карты, 32% энкодер карты, 30Гб RAM.

Немного деталей