Сравнение видеокарт в графических приложениях

Какая видеокарта оптимально подходит для ваших задач?Сравните производительность видеокарт для быстрой и комфортной работы с графикой.

Игровые ноутбуки

Ядра для трассировки лучей: для точного освещения, теней, отражений и более быстрого качественного рендеринга.

ИИ & тензорные ядра: для ускоренных операций с ИИ, таких как повышение разрешения, улучшение фото, подбор цветов, разметка и передача стиля.

Работа в нескольких приложениях одновременно: для работы над ресурсоемкими задачами в нескольких приложениях, каждое из которых требует определенных ресурсов.

Сертификация программного обеспечения: производители ПО, которые разрабатывают графические приложения, тестируют и сертифицируют специализированное аппаратное обеспечение для оптимальной и стабильной работы.

Корпоративная техническая поддержка: специальные возможности и поддержка корпоративных пользователей.

Видеопамять: быстрая память для ресурсоемких задач. Большой объем видеопамяти означает увеличение числа сложных задач, которые могут выполняться на GPU.

Игровые ПК

Ядра для трассировки лучей: для точного освещения, теней, отражений и более быстрого качественного рендеринга.

ИИ & тензорные ядра: для ускоренных операций с ИИ, таких как повышение разрешения, улучшение фото, подбор цветов, разметка и передача стиля.

Работа в нескольких приложениях одновременно: для работы над ресурсоемкими задачами в нескольких приложениях, каждое из которых требует определенных ресурсов.

Сертификация программного обеспечения: производители ПО, которые разрабатывают графические приложения, тестируют и сертифицируют специализированное аппаратное обеспечение для оптимальной и стабильной работы.

Корпоративная техническая поддержка: специальные возможности и поддержка корпоративных пользователей.

Видеопамять: быстрая память для ресурсоемких задач. Большой объем видеопамяти означает увеличение числа сложных задач, которые могут выполняться на GPU.

Подпишитесь На Новостную Рассылку По NVIDIA Studio

Графический дизайн, фотография, видеомонтаж, 3D и многое другое.

- Section

- Section

consumerOptIns hidden field

Подпишитесь и получайте материалы по работе с профессиональными приложениями и новости о последних продуктах NVIDIA Studio для творчества.

Фамилия

Адрес электронной почты

Location

Location Afghanistan Albania Algeria American Samoa Andorra Angola Anguilla Antarctica Antigua & Barbuda Argentina Armenia Aruba Ascension Island Australia Austria Azerbaijan Bahamas Bahrain Bangladesh Barbados Belarus Belgium Belize Benin Bermuda Bhutan Bolivia Bosnia Botswana Bouvet Island Brazil British Indian Ocean Territory British Virgin Islands Brunei Bulgaria Burkina Faso Burundi Cambodia Cameroon Canada Canary Islands Cape Verde Caribbean Netherlands Cayman Islands Central African Republic Ceuta & Melilla Chad Chile China Christmas Island Clipperton Island Cocos (Keeling) Islands Colombia Comoros Congo (DRC) Congo (Republic) Cook Islands Costa Rica Croatia Cuba Curaçao Cyprus Czech Republic Denmark Diego Garcia Djibouti Dominica Dominican Republic East Timor Ecuador Egypt El Salvador Equatorial Guinea Eritrea Estonia Ethiopia European Union Falkland Islands (Islas Malvinas) Faroe Islands Fiji Finland France French Guiana French Polynesia French Southern Territories Gabon Gambia Georgia Germany Ghana Gibraltar Greece Greenland Grenada Guadeloupe Guam Guatemala Guernsey Guinea Guinea-Bissau Guyana Haiti Heard & McDonald Islands Honduras Hong Kong Hungary Iceland India Indonesia Iran Iraq Ireland Isle of Man Israel Italy Ivory Coast Jamaica Japan Jersey Jordan Kazakhstan Kenya Kiribati Kosovo Kuwait Kyrgyzstan Laos Latvia Lebanon Lesotho Liberia Libya Liechtenstein Lithuania Luxembourg Macau Macedonia (FYROM) Madagascar Malawi Malaysia Maldives Mali Malta Marshall Islands Martinique Mauritania Mauritius Mayotte Mexico Micronesia Moldova Monaco Mongolia Montenegro Montserrat Morocco Mozambique Myanmar Namibia Nauru Nepal Netherlands Netherlands Antilles New Caledonia New Zealand Nicaragua Niger Nigeria Niue Norfolk Island North Korea Northern Mariana Islands Norway Oman Outlying Oceania Pakistan Palau Palestine Panama Papua New Guinea Paraguay Peru Philippines Pitcairn Islands Poland Portugal Puerto Rico Qatar Romania Russia Rwanda Réunion Samoa San Marino Saudi Arabia Senegal Serbia Seychelles Sierra Leone Singapore Sint Maarten Slovakia Slovenia Solomon Islands Somalia South Africa South Georgia & South Sandwich Islands South Korea South Sudan Spain Sri Lanka St.

Предпочитаемый язык

Предпочитаемый язык Chinese (Simplified) Chinese (Traditional) Czech Danish Dutch English (Australia) English (GB) English (India) English (Malaysia) English (Philippines) English (Singapore) English (US) Finnish French French (Belgium) German German (Austria) Indonesian Italian Japanese Korean Netherlands (Belgium) Norwegian Polish Portuguese (Brazil) Russian Spanish (Latin America) Spanish (Spain) Swedish Thai Turkish Vietnamese

Выберите страну

Выберите страну 安徽 北京 重庆 福建 广东 甘肃 广西 贵州 海南 湖北 河北 河南 黑龙江 湖南 吉林 江苏 江西 辽宁 内蒙古 宁夏 青海 四川 山东 上海 陕西 山西 天津 新疆 西藏 云南 浙江

本人知悉且同意 NVIDIA Corporation 基于调研、活动组织的目的对本人的上述信息的收集和处理,并已经阅读并同意 <a href=»https://www. nvidia.cn/about-nvidia/privacy-policy/» target=»_blank»>NVIDIA 隐私政策</a>。

nvidia.cn/about-nvidia/privacy-policy/» target=»_blank»>NVIDIA 隐私政策</a>。

本人知悉且同意,因调研、活动组织的必须,以及相对应的 NVIDIA 内部管理和系统操作的需要,上述信息会被传输到位于美国的 NVIDIA Corporation 按照符合 <a href=»https://www.nvidia.cn/about-nvidia/privacy-policy/» target=»_blank»>NVIDIA 隐私政策</a>的方式进行存储,您可以通过发送邮件至 <a href=»mailto:[email protected]»>[email protected]</a> 进行联系以解决相关问题,实现可适用的数据保护法所规定的权利。

SPECviewperf 12 — Creo — результаты бенчмарка ✽ Сравнительная таблица производительности видеокарт

У каждого опытного пользователя компьютеров и ноутбуков есть свои критерии выбора видеокарт. Сегодня мы предлагаем сравнение видеокарт ноутбуков от разных производителей. Оно основано на проверке GPU в бенчмарке SPECviewperf 12 с кодовым названием ‘Creo’. В рейтинге представлены все типы интегрированных видеокарт для ноутбуков и ПК. Обратите внимание и на следующее: — Какая видеокарта лучше для ноутбука? — Какая видеокарта лучше для ноутбука встроенная или дискретная? — Можно ли в ноутбуке заменить видеокарту на более мощную?

NVIDIA Quadro P5200

NVIDIA Quadro RTX 5000 Mobile

NVIDIA Quadro P5000 Mobile

NVIDIA Quadro RTX 5000 Max-Q

NVIDIA Quadro RTX 3000 Mobile

NVIDIA Quadro P3200

NVIDIA Quadro P4000 Max-Q

NVIDIA Quadro T2000 Max-Q

NVIDIA Quadro P3000 Mobile

NVIDIA Quadro M5000M

NVIDIA Quadro T1000 Mobile

NVIDIA GeForce GTX 880M

NVIDIA Quadro M2200

NVIDIA Quadro M4000M

NVIDIA Quadro M3000M

NVIDIA Quadro P2000 Mobile

NVIDIA GeForce RTX 2080 Ti

NVIDIA Titan X Pascal

NVIDIA GeForce GTX 1080 Ti

NVIDIA Quadro P620

AMD Radeon RX Vega 64

NVIDIA GeForce GTX 1080 Mobile

NVIDIA Quadro P1000

NVIDIA GeForce GTX 1080 SLI Mobile

NVIDIA GeForce GTX 1080

NVIDIA GeForce RTX 2080

NVIDIA GeForce RTX 2070 Super

NVIDIA GeForce GTX 1070 Mobile

NVIDIA GeForce RTX 2070

NVIDIA Quadro M1200

NVIDIA GeForce RTX 2060 Super

NVIDIA GeForce GTX 1070 Max-Q

NVIDIA Quadro K5100M

NVIDIA Quadro P600

NVIDIA Quadro M2000M

NVIDIA GeForce GTX 970M

AMD FirePro M6100

NVIDIA GeForce GTX 1060 Mobile

NVIDIA GeForce GTX 1060 6 GB

NVIDIA GeForce GTX 960M

NVIDIA Quadro K4100M

NVIDIA GeForce GTX 980 Mobile

AMD Radeon Pro WX 3200

NVIDIA Quadro M620

NVIDIA Quadro M1000M

AMD Radeon Pro 555

NVIDIA Quadro P520

NVIDIA Quadro K3100M

NVIDIA GeForce GTX 980M SLI

NVIDIA GeForce GTX 980M

NVIDIA Quadro P500

NVIDIA GeForce GTX 860M

NVIDIA GeForce GTX 850M

AMD FirePro M5100

NVIDIA Quadro M500M

NVIDIA GeForce GTX 965M

NVIDIA Quadro K2100M

NVIDIA GeForce 840M

AMD Radeon PRO WX 3100

AMD Radeon R5 M255

NVIDIA Quadro K1100M

Intel UHD Graphics 630

Intel UHD Graphics 620

Intel HD Graphics 620

NVIDIA GeForce MX150

Intel HD Graphics 5500

Intel HD Graphics 4400

Intel HD Graphics 5300

Обзор Nvidia GeForce RTX 3070 Ti: больше пропускной способности, больше мощности, больше денег

При покупке по ссылкам на нашем сайте мы можем получать партнерскую комиссию. Вот как это работает.

Вот как это работает.

Nvidia GeForce RTX 3070 Ti продолжает выпуск архитектуры Ampere , на которой работают графические процессоры многих из лучших видеокарт . На прошлой неделе Nvidia выпустила GeForce RTX 3080 Ti — карту, цена которой, по нашему мнению, слишком сильно выросла по сравнению со следующим шагом вниз. RTX 3070 Ti должна работать лучше, поскольку стоит всего 59 долларов.9 (теоретически), а также потому, что разница между существующими GeForce RTX 3070 и GeForce RTX 3080 составляет до 33%. Это увеличение цены на 100 долларов по сравнению с существующим 3070, но и 3070, и 3080 пока будут продолжать продаваться в версиях с «ограниченным хешрейтом». Вскоре мы добавим RTX 3070 Ti в нашу иерархию тестов GPU , если вы хотите увидеть, как все графические процессоры ранжируются с точки зрения производительности.

Основная идея RTX 3070 Ti достаточно проста. Nvidia берет графический процессор GA104, который работает на RTX 3070 и RTX 3060 Ti, только на этот раз это полный вариант чипа 48 SM, и соединяет его с GDDR6X. В то время как Nvidia могла попытаться сделать это в прошлом году, обе RTX 3080 и RTX 3090 уже изо всех сил пытались получить достаточно памяти GDDR6X, и задержка на девять месяцев позволила Nvidia создать достаточный запас как графического процессора, так и памяти для этого запуска. Nvidia также внедрила свой ограничитель хешрейта Ethereum, по сути, вдвое снизив производительность майнинга криптовалют, использующих алгоритм Ethash/Dagger-Hashimoto.

В то время как Nvidia могла попытаться сделать это в прошлом году, обе RTX 3080 и RTX 3090 уже изо всех сил пытались получить достаточно памяти GDDR6X, и задержка на девять месяцев позволила Nvidia создать достаточный запас как графического процессора, так и памяти для этого запуска. Nvidia также внедрила свой ограничитель хешрейта Ethereum, по сути, вдвое снизив производительность майнинга криптовалют, использующих алгоритм Ethash/Dagger-Hashimoto.

Будет ли этого достаточно, чтобы избежать немедленной распродажи карт при запуске? Дайте подумать об этом, нет. Не шанс. Фактически, майнеры, вероятно, все еще пытаются купить ограниченные карты RTX 3080 Ti, 3080, 3070, 3060 Ti и 3060. Может быть, они надеются, что ограничитель снова взломают или случайно разблокируют. Возможно, они заработали слишком много денег на скачке цен на криптовалюту за последние шесть месяцев. Или, может быть, они просто с оптимизмом смотрят в будущее криптовалют. Хорошая новость, в зависимости от вашей точки зрения, заключается в том, что прибыльность майнинга значительно снизилась за последний месяц, что означает такие карты, как RTX 309. 0 теперь зарабатывают менее 7 долларов в день после учета затрат на электроэнергию, а RTX 3080 упала до чуть более 5 долларов в день.

0 теперь зарабатывают менее 7 долларов в день после учета затрат на электроэнергию, а RTX 3080 упала до чуть более 5 долларов в день.

GeForce RTX 3070 Ti: не лучший вариант для майнинга, но все же прибыльный

Изображение 1 из 3 не имеет ограниченного хэшрейта, он будет приносить всего около 4,25 доллара в день. С установленным ограничителем Ravencoin (KAWPOW) и Conflux (Octopus) сейчас являются самыми прибыльными криптовалютами, и оба этих алгоритма хеширования по-прежнему работают на полной скорости. Доходность должна быть немного выше с настройкой, но сейчас мы оцениваем прибыль всего в 3,50 доллара или около того в день. Этого по-прежнему достаточно, чтобы карты «окупились» примерно через шесть месяцев, но опять же, прибыльность упала и может продолжать падать.

Геймеры среди нас, безусловно, на это надеются, но даже без майнинга криптовалюты спрос на графические процессоры продолжает значительно превышать предложение. Выпуская RTX 3070 Ti с его объединенными чипами GA104 и памятью GDDR6X, Nvidia продолжает неуклонно увеличивать количество продаваемых графических процессоров. Nvidia также производит больше графических процессоров Turing прямо сейчас, в основном для линейки майнерских карт CMP, и в какой-то момент поставки должны наверстать упущенное. Произойдет ли это до появления графических процессоров следующего поколения? Вероятно, но только потому, что графические процессоры следующего поколения, вероятно, будут отброшены из-за того же дефицита, что и чипы текущего поколения.

Nvidia также производит больше графических процессоров Turing прямо сейчас, в основном для линейки майнерских карт CMP, и в какой-то момент поставки должны наверстать упущенное. Произойдет ли это до появления графических процессоров следующего поколения? Вероятно, но только потому, что графические процессоры следующего поколения, вероятно, будут отброшены из-за того же дефицита, что и чипы текущего поколения.

Ладно, хватит вводной информации. Давайте взглянем на спецификации RTX 3070 Ti, а также на соответствующие графические процессоры Nvidia, такие как 3080, 3070 и RTX 2070 Super предыдущего поколения: Карта

8

8 GeForce RTX 3070 Ti обеспечивает чуть большую теоретическую вычислительную производительность, чем 3070, благодаря добавлению еще двух SM. У него также немного более высокие тактовые частоты, что дает ему на 7% больше TFLOPS — и все еще на 27% меньше TFLOPS, чем у 3080. Гораздо важнее то, что 3070 Ti переходит от 14 Гбит/с GDDR6 и 448 ГБ/с пропускной способности к 19 Гбит/с GDDR6X. и пропускная способность 608 ГБ/с, улучшение на 36%. В целом мы ожидаем, что производительность будет между 3080 и 3070, но ближе к 3070.

У него также немного более высокие тактовые частоты, что дает ему на 7% больше TFLOPS — и все еще на 27% меньше TFLOPS, чем у 3080. Гораздо важнее то, что 3070 Ti переходит от 14 Гбит/с GDDR6 и 448 ГБ/с пропускной способности к 19 Гбит/с GDDR6X. и пропускная способность 608 ГБ/с, улучшение на 36%. В целом мы ожидаем, что производительность будет между 3080 и 3070, но ближе к 3070.

Помимо характеристик производительности, важно также обратить внимание на мощность. Немного шокирует тот факт, что TDP 3070 Ti на 70 Вт выше, чем у 3070, и мы предполагаем, что почти все это уходит в память GDDR6X. Некоторые из них также позволяют немного увеличить тактовые частоты, но в целом это значительное увеличение TDP только за счет изменения VRAM.

Вот еще вопрос, хватит ли 8гб памяти. В наши дни мы бы сказали, что достаточно для любой игры, в которую вы хотите играть, но определенно есть случаи, когда вы столкнетесь с проблемами объема памяти. Неудивительно, что многие из них появляются в играх, продвигаемых AMD, похоже, что AMD убедила разработчиков ориентироваться на 12 или 16 ГБ видеопамяти при максимальных настройках качества. Но нескольких разумных настроек (например, снижения качества текстур на ступеньку выше) обычно бывает достаточно.

Но нескольких разумных настроек (например, снижения качества текстур на ступеньку выше) обычно бывает достаточно.

Сложность в том, что нет другого способа получить больше памяти, кроме как просто сделать это. 256-битный интерфейс означает, что Nvidia может использовать 8 ГБ или 16 ГБ — ничего между ними. А с 3080 и 3080 Ti, предлагающими 10 ГБ и 12 ГБ соответственно, у Nvidia практически не было шансов оснастить меньший графический процессор большим объемом памяти GDDR6X. (Да, я знаю, но RTX 3060 12 ГБ остается чем-то вроде аномалии в этом плане.)

Изображение 1 из 6

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) В отличие от RTX 3080 Ti, Nvidia внесла некоторые изменения в дизайн RTX 3070 Ti. По сути, 3070 Ti имеет проточный охлаждающий вентилятор на задней панели карты, как и карты 3080 и 3090 Founders Edition. Для сравнения, 3070 использовал два вентилятора на одной стороне карты. Это также потребовало некоторых изменений в компоновке печатной платы, поэтому в 3070 Ti не используются те же самые платы, что и в 3070 и 3060 Ti. Точно неясно, насколько изменение дизайна помогает с охлаждением, но, учитывая 290 Вт против 220 Вт TDP, предположительно, Nvidia провела множество тестов, прежде чем остановилась на конечном продукте.

Это также потребовало некоторых изменений в компоновке печатной платы, поэтому в 3070 Ti не используются те же самые платы, что и в 3070 и 3060 Ti. Точно неясно, насколько изменение дизайна помогает с охлаждением, но, учитывая 290 Вт против 220 Вт TDP, предположительно, Nvidia провела множество тестов, прежде чем остановилась на конечном продукте.

В целом, независимо от того, значительно ли это изменение улучшает охлаждение или нет, мы думаем, что оно улучшает внешний вид карты. Выпуски RTX 3070 и 3060 Ti Founders Edition выглядели немного пресно, так как в них отсутствовал даже большой логотип, указывающий на название продукта. Тем не менее, 3080 и выше (модели FE) включают RGB-подсветку, которой нет у 3070 Ti и ниже. Сторонние карты, конечно, могут делать с графическим процессором все, что захотят, и мы предполагаем, что многие из них обеспечат более мощное охлаждение и RGB-подсветку, а также заводской разгон.

Перед этим обзором у нас возник вопрос, насколько хорошо карта будет охлаждать память GDDR6X. Различные карты Founders Edition с памятью GDDR6X могут достигать 110 градусов по Цельсию в памяти с различными алгоритмами крипто-майнинга, после чего вентиляторы включаются на высокой скорости, а GPU дросселирует. Игры, как правило, менее требовательны, но мы все же видели 102C-104C на 3080 Ti. У 3070 Ti такой проблемы нет. Даже с алгоритмами майнинга температура памяти достигала 100°C, а температура в играх обычно была на 8–12°C ниже. В этом преимущество необходимости охлаждать только 8 ГБ памяти GDDR6X вместо 10, 12 или 24 ГБ.

Различные карты Founders Edition с памятью GDDR6X могут достигать 110 градусов по Цельсию в памяти с различными алгоритмами крипто-майнинга, после чего вентиляторы включаются на высокой скорости, а GPU дросселирует. Игры, как правило, менее требовательны, но мы все же видели 102C-104C на 3080 Ti. У 3070 Ti такой проблемы нет. Даже с алгоритмами майнинга температура памяти достигала 100°C, а температура в играх обычно была на 8–12°C ниже. В этом преимущество необходимости охлаждать только 8 ГБ памяти GDDR6X вместо 10, 12 или 24 ГБ.

GeForce RTX 3070 Ti: стандартная игровая производительность

TOM’S HARDWARE GPU TEST PC

Intel Core i9-9900K (открывается в новой вкладке)

MSI MEG Z390 Ace (открывается в новой вкладке)

62DDR 3CL6GB 4x16GB Corsair 2x16GB Corsair 2x16GB (открывается в новой вкладке)

XPG SX8200 Pro 2 ТБ (открывается в новой вкладке)

Seasonic Focus 850 Platinum (открывается в новой вкладке)

Corsair Hydro h250i Pro RGB (открывается в новой вкладке)

OpenBenchTable

ksПро М

Наша тестовая установка не изменилась по сравнению с предыдущими обзорами, и, как и в случае с 3080 Ti, мы будем проводить дополнительное тестирование с трассировкой лучей и DLSS — используя те же тесты, что и в нашем тесте AMD против Nvidia: Ray Tracing Showdown. Мы используем тестовое оборудование, показанное выше, которое состоит из Core i9-9900K, 32 ГБ памяти DDR4-3600, 2 ТБ M.2 SSD и различных тестируемых графических процессоров — все они являются эталонными моделями, за исключением RTX. 3060 (модель EVGA с эталонными часами).

Мы используем тестовое оборудование, показанное выше, которое состоит из Core i9-9900K, 32 ГБ памяти DDR4-3600, 2 ТБ M.2 SSD и различных тестируемых графических процессоров — все они являются эталонными моделями, за исключением RTX. 3060 (модель EVGA с эталонными часами).

Это дает нам два набора результатов. Во-первых, это традиционная производительность рендеринга с использованием тринадцати игр в разрешении 1080p, 1440p и 4K с настройками ультра/максимального качества. Затем у нас есть еще десять игр с RT (и иногда с DLSS, где это применимо). Мы начнем с 4K, так как это GPU высшего уровня, который с большей вероятностью будет использоваться в этом разрешении, плюс это то, где карта работает лучше всего по сравнению с другими GPU — узкие места процессора почти полностью устраняются при 4K, но более распространены при 1080р. Если вы хотите проверить среднюю производительность 1080p/1440p/4K, у нас есть эти результаты в наших статьях о лучших видеокартах и тестах графических процессоров, но только для девяти игр.

Изображение 1 из 14

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено кредит: Tom’s Hardware) RTX 3070 Ti лучше всего подходит для игрового решения с разрешением 1440p, которое остается лучшим с точки зрения качества изображения и требований к производительности. Общая производительность закончилась 9% быстрее, чем RTX 3070, и на 13 % медленнее, чем RTX 3080, поэтому добавленная пропускная способность памяти лишь частично устраняет узкие места. Тем не менее, несколько игр выигрывают больше, например Assassin’s Creed Valhalla , Dirt 5 , Horizon Zero Dawn , Shadow of the Tomb Raider и Strange Brigade — все из которых показывают двузначные процентные улучшения относительно до 3070.

Тем не менее, несколько игр выигрывают больше, например Assassin’s Creed Valhalla , Dirt 5 , Horizon Zero Dawn , Shadow of the Tomb Raider и Strange Brigade — все из которых показывают двузначные процентные улучшения относительно до 3070.

Некоторые игры также явно сталкиваются с другими узкими местами, такими как ядра графического процессора. Borderlands 3 , The Division 2 , Far Cry 5 , FFXIV , Metro Exodus и Red Dead Redemption 2 показывают прирост производительности, близкий к теоретической разнице в 7%, которую мы получаем из вычислений. количество ядер и тактовая частота. Между тем, Watch Dogs Legions показывает наименьшее изменение производительности, улучшаясь всего на 3% по сравнению с RTX 3070. 20% для увеличения производительности чуть менее чем на 10%. По сравнению с картами AMD RX 6000, 3070 Ti легко превосходит RX 6700 XT, но отстает от RX 6800 на 6%, что, конечно же, означает, что она также отстает от RX 6800 XT.

С одной стороны, графические процессоры AMD, как правило, продаются по более высоким ценам, даже если вы видите их в таких местах, как Newegg Shuffle. В то же время аппаратное обеспечение серии RTX 30 на eBay остается чрезвычайно дорогим: 3070 продается примерно за 1300 долларов по сравнению с примерно 1400 долларов за RX 6800. Учитывая, что RTX 3070 Ti быстрее, чем RTX 3070, это еще предстоит выяснить. куда приземляется уличное ценообразование. Конечно, снижение хэшрейта для майнинга Ethereum на 3070 Ti также может сыграть свою роль.

Изображение 1 из 14

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) Далее идет тестирование 1080p. Понижение разрешения имеет тенденцию делать игры более ограниченными процессором, и это именно то, что мы видим. На этот раз 3070 Ti была на 7% быстрее, чем 3070, и на 11% медленнее, чем 3080. Она также была на 7% быстрее, чем 6700 XT, и на 6% медленнее, чем 6800. Хотя вы по-прежнему можете легко играть в игры с разрешением 1080p на RTX. 3070 Ti, то же самое можно сказать и о большинстве других графических процессоров в наших таблицах.

Понижение разрешения имеет тенденцию делать игры более ограниченными процессором, и это именно то, что мы видим. На этот раз 3070 Ti была на 7% быстрее, чем 3070, и на 11% медленнее, чем 3080. Она также была на 7% быстрее, чем 6700 XT, и на 6% медленнее, чем 6800. Хотя вы по-прежнему можете легко играть в игры с разрешением 1080p на RTX. 3070 Ti, то же самое можно сказать и о большинстве других графических процессоров в наших таблицах.

Мы не будем останавливаться на этом, отметим лишь, что наш текущий набор тестов немного больше склонен в пользу графических процессоров AMD (шесть игр, продвигаемых AMD, по сравнению с четырьмя играми, продвигаемыми Nvidia, с тремя «независимыми» играми). Мы исправим это, когда через мгновение пройдем тесты трассировки лучей.

Изображение 1 из 14

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено кредит: оборудование Тома) Неудивительно, что в то время как ультраигры 4K дали RTX 3070 Ti самый большой отрыв по сравнению с RTX 3070 (11%), он также понес наибольший проигрыш (17%) по сравнению с 3080. 4K также сократил разрыв между 3070 Ti и RX 6800, так как AMD Infinity Cache начинает достигать своих пределов при разрешении 4K.

4K также сократил разрыв между 3070 Ti и RX 6800, так как AMD Infinity Cache начинает достигать своих пределов при разрешении 4K.

Технически RTX 3070 Ti по-прежнему может играть во все тестовые игры в разрешении 4K, но не всегда со скоростью более 60 кадров в секунду. Почти половина протестированных нами игр оказались ниже этой отметки, с Valhalla и Watch Dogs Legion 9.0326 — это два самых низких показателя — и они все еще находятся в середине 40-х. RTX 3070 уже была в основном связана с RTX 2080 Ti предыдущего поколения, а это означает, что RTX 3070 Ti теперь явно быстрее, чем карта Halo предыдущего поколения, за полцены.

GeForce RTX 3070 Ti: трассировка лучей и игровая производительность DLSS

До сих пор мы фокусировались на игровой производительности с использованием традиционной растеризованной графики. Мы также исключили использование технологии Nvidia DLSS , чтобы обеспечить сравнение между яблоками. Теперь мы сосредоточимся на производительности трассировки лучей с включенным DLSS 2. 0, где это применимо. Мы используем DLSS только в режиме качества (2-кратное увеличение) в шести играх, где он поддерживается. Придется ждать AMD FSR , чтобы посмотреть, сможет ли он предоставить разумную альтернативу DLSS 2.0 в ближайшие месяцы, хотя у Nvidia явно есть долгое преимущество. Обратите внимание, что это те же самые тесты, которые мы использовали в нашей недавней битве AMD против Nvidia Ray Tracing Battle .

0, где это применимо. Мы используем DLSS только в режиме качества (2-кратное увеличение) в шести играх, где он поддерживается. Придется ждать AMD FSR , чтобы посмотреть, сможет ли он предоставить разумную альтернативу DLSS 2.0 в ближайшие месяцы, хотя у Nvidia явно есть долгое преимущество. Обратите внимание, что это те же самые тесты, которые мы использовали в нашей недавней битве AMD против Nvidia Ray Tracing Battle .

Изображение 1 из 11

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) RTX 3070 Ti от Nvidia работает намного лучше — по крайней мере, по сравнению с конкурентами AMD — в играх с трассировкой лучей. Это не полный перебор, так как RX 6800 по-прежнему лидирует в Godfall , но 3070 Ti ничья или выигрывает во всех остальных играх. Фактически, 3070 Ti в основном связывает RX 6800 XT в нашем наборе тестов трассировки лучей, и это до того, как мы включим DLSS 2.0.

Это не полный перебор, так как RX 6800 по-прежнему лидирует в Godfall , но 3070 Ti ничья или выигрывает во всех остальных играх. Фактически, 3070 Ti в основном связывает RX 6800 XT в нашем наборе тестов трассировки лучей, и это до того, как мы включим DLSS 2.0.

Изображение 1 из 11

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) Даже 1080p DXR обычно ограничивается графическим процессором, поэтому рейтинг не сильно меняется по сравнению с предыдущим. DLSS не так сильно помогает при 1080p, но в остальном 3070 Ti оказывается примерно на 25% быстрее, чем RX 6800 — так же, как и при 1440p. Мы уже упоминали ранее, что Fortnite , вероятно, является лучшим «нейтральным» взглядом на продвинутые методы трассировки лучей, а 3070 Ti там примерно на 5–7% быстрее. Включите качество DLSS, и частота кадров удвоится по сравнению с RX 6800.

Мы уже упоминали ранее, что Fortnite , вероятно, является лучшим «нейтральным» взглядом на продвинутые методы трассировки лучей, а 3070 Ti там примерно на 5–7% быстрее. Включите качество DLSS, и частота кадров удвоится по сравнению с RX 6800.

GeForce RTX 3070 Ti: мощность, тактовая частота и температура

Наше оборудование Powenetics снова работает, поэтому мы добавили 3080 Ti в эти таблицы. К сожалению, произошла еще одна небольшая неразбериха: в этом раунде мы не смогли добиться нужной скорости вращения вентилятора. Наверное, всегда то одно, то другое. В любом случае, мы используем Metro Exodus с разрешением 1440p Ultra (без RT или DLSS) и FurMark с разрешением 1600×900 в режиме стресс-теста для тестирования энергопотребления. Каждый тест длится около 10 минут, и мы регистрируем результат для создания диаграмм. Для гистограмм мы усредняем только данные, где загрузка графического процессора выше 9.0% (чтобы избежать искажений в Metro при перезапуске теста).

Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) использование этой силы. В нашем тестировании Metro в среднем около 282 Вт, но это отчасти связано с затишьем в работе графического процессора между итерациями тестов. FurMark показал энергопотребление 291 Вт, что соответствует ожиданиям. 91 из 4 с чуть более низкими тактовыми частотами, чем у RTX 3070 в FurMark и Metro . С другой стороны, обе карты легко превзошли официальные тактовые частоты примерно на 100 МГц. Пользовательские сторонние карты, скорее всего, будут иметь более высокие тактовые частоты и производительность, но также и более высокое энергопотребление.Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) Хотя у нас нет данных о вентиляторах (или данных о шуме — извините , я все еще пытаюсь распаковаться с переезда), RTX 3070 Ti действительно достигла самых высоких температур среди всех графических процессоров как в Metro , так и в FurMark . Однако, как мы уже отмечали ранее, ни одна из карт не перегревается, и нас больше беспокоит температура памяти. К счастью, 3070 Ti не превышала 100°C при температуре соединения GDDR6X при тестировании, и даже это значение имело место при тестировании майнинга криптовалюты.

Однако, как мы уже отмечали ранее, ни одна из карт не перегревается, и нас больше беспокоит температура памяти. К счастью, 3070 Ti не превышала 100°C при температуре соединения GDDR6X при тестировании, и даже это значение имело место при тестировании майнинга криптовалюты.

GeForce RTX 3070 Ti: хорошо, но с убывающей отдачей

(Изображение предоставлено Tom’s Hardware)Мы должны задаться вопросом, как бы обстояли дела с RTX 3070 Ti без двойного удара пандемии Covid и бума криптовалюты . Если вы посмотрите на серию RTX 20, Nvidia начала с более высоких цен (599 долларов за RTX 2070 FE), а затем год спустя снизила цену на 100 долларов с «супер» обновлениями. Ampere пошла по противоположному пути: первоначальные цены были отличными, по крайней мере, на бумаге, и все карты были распроданы моментально. Это все еще происходит сегодня, и результатом является повышение цены — наряду с улучшением производительности — для 3070 Ti и 3080 Ti.

К счастью, скачок цен на 3070 Ti по сравнению с 3070 не слишком велик. Еще 100 долларов за переход на GDDR6X — это почти приемлемо. За исключением того, что хотя 3070 предлагает около 90% производительности 3070 Ti за 80% цены и представляет собой, возможно, более выгодную покупку, реальной проблемой является RTX 3080. Она примерно на 12–20% быстрее в нашем наборе из 13 игр и только стоит на 100 долларов больше (увеличение цены на 17%).

Еще 100 долларов за переход на GDDR6X — это почти приемлемо. За исключением того, что хотя 3070 предлагает около 90% производительности 3070 Ti за 80% цены и представляет собой, возможно, более выгодную покупку, реальной проблемой является RTX 3080. Она примерно на 12–20% быстрее в нашем наборе из 13 игр и только стоит на 100 долларов больше (увеличение цены на 17%).

Во всяком случае, в теории. На самом деле никто не продает RTX 3080 за 700 долларов, и они не делали этого с момента его запуска. 3080 часто стоит более 1000 долларов даже в лотерейном Newegg Shuffle, а обычная цена на eBay по-прежнему превышает 2000 долларов. Это одна из худших карт для покупки на eBay, учитывая размер наценки. Для сравнения, RTX 3070 Ti может стоить на eBay всего вдвое дороже, чем рекомендованная производителем розничная цена, но это все равно 1200 долларов. И это вполне может стоить дороже.

Посмотрим, что будет в ближайшие месяцы. Надеемся, что появление еще двух видеокарт для настольных ПК в виде RTX 3080 Ti и RTX 3070 Ti немного уменьшит нехватку. Ограничитель хешрейта тоже не повредит, по крайней мере, если вас интересует только игровая производительность, и падение прибыльности майнинга может помочь. Но мы далеки от того, чтобы выйти из леса дефицита.

Ограничитель хешрейта тоже не повредит, по крайней мере, если вас интересует только игровая производительность, и падение прибыльности майнинга может помочь. Но мы далеки от того, чтобы выйти из леса дефицита.

Если вы действительно можете найти RTX 3070 Ti по рекомендованной розничной цене около 600 долларов и ищете новую видеокарту, это хороший вариант. Найти его будет трудной частью. Это обязательно будет повторением каждого запуска графических процессоров AMD и Nvidia в прошлом году. Если вам еще не удалось приобрести новую карту, вы можете попробовать еще раз (и еще, и еще…). Но для тех, у кого уже есть неплохая видеокарта, здесь нет ничего особенно нового: немного лучшая производительность и более высокое энергопотребление по более высокой цене. Будем надеяться, что предложение и цены улучшатся к тому времени, когда начнется осень.

ДОПОЛНИТЕЛЬНО: Лучшие видеокарты

ДОПОЛНИТЕЛЬНО: Тесты графических процессоров и иерархия

ДОПОЛНИТЕЛЬНО: 6 909008 Все содержимое Получите мгновенный доступ к последним новостям, подробным обзорам и полезным советам. Джарред Уолтон — старший редактор Tom’s Hardware, специализирующийся на GPU. Он работает техническим журналистом с 2004 года, пишет для AnandTech, Maximum PC и PC Gamer. От первых «3D-замедлителей» S3 Virge до современных графических процессоров — Джарред следит за всеми последними графическими тенденциями и всегда задает вопросы о производительности игр. При покупке по ссылкам на нашем сайте мы можем получать партнерскую комиссию. Вот как это работает. Если вы подумываете о новой сборке игрового ПК, то сравнение видеокарт, скорее всего, будет в самом верху вашего списка дел. Независимо от того, присматриваетесь ли вы к последним моделям от Nvidia или AMD, вам нужно кое-что узнать, прежде чем вкладывать деньги, особенно в современном технологическом ландшафте. В то время, когда достать лучшие видеокарты для игр все труднее, чем когда-либо, вопрос становится не столько о разнице в цене каждой модели, сколько о технологических и архитектурных преимуществах, которые предлагает каждый производитель. Сравнение видеокарт Nvidia и AMD сводится не только к тому, что встроено в чип. Мы учли все, от общей доступности предложений обоих брендов от дешевых видеокарт до флагманов более высокого класса. Более того, мы также подробно изучили технологии суперсэмплинга и трассировки лучей, чтобы дать вам полное представление о том, на что способны эти графические процессоры в 2022 году.

: вот как Nvidia соотносится с AMD в 2022 году

AMD Radeon RX 6000 Series vs Nvidia RTX 30 Series

NVIDIA GEFORCE RTX 30 SERIA

AMD RADEON RX 6000 Series

1218 ARTHICELURE 0522

0522 Сравнение графических карт Nvidia и AMD

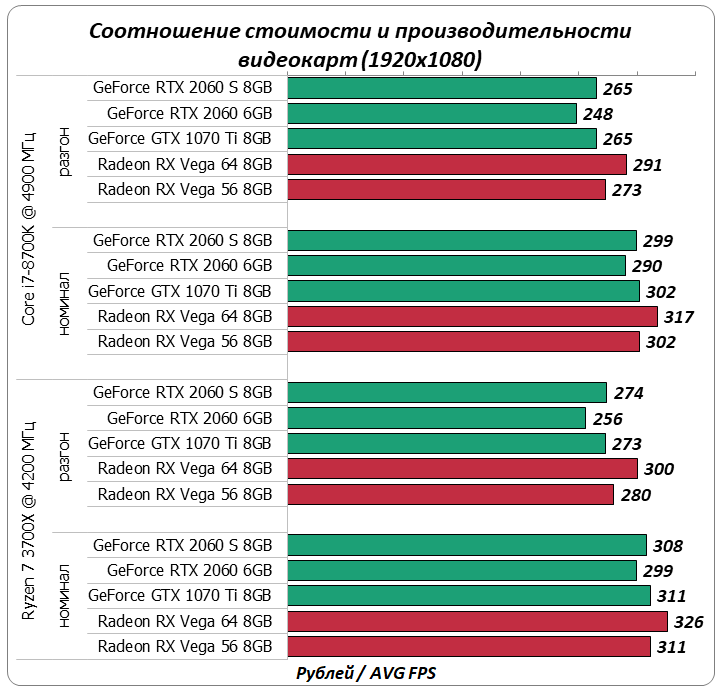

Сравнение графических карт AMD и Nvidia: соотношение цены и качества доступное оборудование. То же самое можно сказать и о Radeon RX 6000 Series, где самая дешевая модель видеокарты стоит всего 19 долларов.9. RX 6500 XT с 4 ГБ памяти GDDR6 и 64-битной шиной памяти может звучать не так уж и много на бумаге, но этого графического процессора, ориентированного на разрешение 1080p, достаточно для современных игр в формате Full HD.

Если вы хотите получить отдачу от 30-й серии, тогда RTX 3050 — это то, что вам нужно. Стартовая рекомендованная производителем розничная цена этой модели составляет 249 долларов США за графические процессоры с 8 ГБ памяти GDDR6 и 128-битной шиной памяти, что делает ее гораздо более функциональной, чем предложение AMD 2022 года. В нашем обзоре RTX 3050 мы достойно описали новинку из линейки Ampere, высоко оценив ее мастерство в разрешении 1080p в требовательных играх. Однако главное предостережение заключается в том, что акции RTX 3050 гораздо сложнее найти по фактическим розничным ценам, в отличие от акций RX 6500 XT на данный момент.

В нашем обзоре RTX 3050 мы достойно описали новинку из линейки Ampere, высоко оценив ее мастерство в разрешении 1080p в требовательных играх. Однако главное предостережение заключается в том, что акции RTX 3050 гораздо сложнее найти по фактическим розничным ценам, в отличие от акций RX 6500 XT на данный момент.

Если бы у вас был выбор между RTX 3050 или RX 6500 XT по их соответствующей рекомендованной розничной цене, то наша личная рекомендация заключалась бы в том, чтобы сделать ставку на зеленую команду здесь. Вы получаете в два раза больше видеопамяти, что пригодится, поскольку 4 ГБ памяти последней модели уже довольно узки, и многие современные игры выходят за рамки этого ограничения. В наши дни современные игры также нередко используют 6 ГБ+ для текстур, так что вы оставите себе немного свободного места.

- Победитель: Nvidia

Сравнение видеокарт AMD и Nvidia: доступность

Если вы следили за рынком видеокарт в течение последних двух лет, то вы, несомненно, знаете, насколько резко выросли текущие цены. являются. Когда дело доходит до Nvidia против AMD, линейка Nvidia RTX 30 больше всего пострадала как от моделей Founders Edition, так и от партнерских карт.

являются. Когда дело доходит до Nvidia против AMD, линейка Nvidia RTX 30 больше всего пострадала как от моделей Founders Edition, так и от партнерских карт.

В целях борьбы с нехваткой цепочек поставок зеленая команда досрочно выпустила обновления Ti. Тем не менее, полушаговые видеокарты было так же сложно отследить по рекомендованной розничной цене, за исключением редких случаев.

Серия AMD Radeon RX 6000, хотя и по-прежнему неуловимая, с момента запуска стала немного лучше доступна в таких странах, как США и Великобритания. Хотя цены не совсем MSRP, обычно легче найти подобные RX 6600 по цене менее 500 долларов, чем, например, для RTX 3060 и RTX 3060 Ti.

Если вы ищете видеокарту для своей машины с приличной скоростью, вы можете получить выгоду от карты AMD, близкой к рекомендованной производителем розничной цене, по сравнению с графическим процессором серии RTX 30 с пиковой ценой на данный момент.

- Победитель: AMD

Сравнение видеокарт AMD и Nvidia: высокопроизводительные графические процессоры

Если вам нужна максимальная вычислительная мощность графического процессора, то ваши высокопроизводительные графические процессоры будут немного более чистыми. Nvidia лидирует на этом фронте со своей видеокартой RTX 3090 в комплекте с 24 ГБ видеопамяти GDDR6X и 384-битной шиной памяти за 1499 долларов. Это действительно мощная видеокарта, созданная специально для 4K.

Nvidia лидирует на этом фронте со своей видеокартой RTX 3090 в комплекте с 24 ГБ видеопамяти GDDR6X и 384-битной шиной памяти за 1499 долларов. Это действительно мощная видеокарта, созданная специально для 4K.

AMD не сильно отстает с Radeon RX 6900XT, однако. В то время как эта конкретная видеокарта не имеет такого же ворчания на покадровой основе, эти графические процессоры ближе, чем могут показаться на первый взгляд. Эта модель имеет MSRP 999 долларов и оснащена 16 ГБ видеопамяти GDDR6 и 256-битной шиной памяти. Несмотря на то, что RX 6900 XT не такая мощная, как ведущая карта Nvidia, при выпуске она стоит на 500 долларов дешевле, чем стандартная RTX 3090.

Несмотря на то, что обе видеокарты невероятно мощные и станут преимуществом для всех, кто хочет играть в 4K в 2022 году, если у вас есть выбор из обеих, наши деньги на RTX 309.0 в целом. Эта дополнительная видеопамять и обновление до GDDR6X вместо стандартной GDDR6 лидера AMD. На момент написания статьи предложения ПК с RTX 3090 представляли собой наиболее экономичные способы получить в свои руки высокопроизводительные графические процессоры.

- Победитель: Nvidia RTX 3090

Сравнение видеокарт AMD и Nvidia: трассировка лучей игры, конечно, есть разница, в которой производитель выходит на первое место. Nvidia была первой из двух, кто активно продвигал функции трассировки лучей в своих картах, занимая второе место в линейке RTX теперь с Ampere (серия RTX 30), ранее Turing (серия RTX 20).

Видеокарты Ampere оснащены ядрами трассировки лучей второго поколения и ядрами Tensor третьего поколения (для DLSS). Для справки, графические процессоры Big Navi используют первое поколение ядер трассировки лучей с аппаратным ускорением. Таким образом, хотя видеокарты AMD могут это делать, технология в этих моделях еще не настолько развита, чтобы дать Team Green возможность побороться за свои деньги (пока).

- Победитель: Nvidia

DLSS против FSR: какая технология суперсэмплирования лучше?

(Изображение предоставлено Nvidia) На первый взгляд, технология Deep Learning Super Sampling (DLSS) от Nvidia и AMD FideltyFX Super Resolution имеют много общего. Это технологии масштабирования, использующие искусственный интеллект. чтобы обеспечить повышение частоты кадров с минимальным влиянием на общее качество изображения по сравнению с исходным запуском игр.

Это технологии масштабирования, использующие искусственный интеллект. чтобы обеспечить повышение частоты кадров с минимальным влиянием на общее качество изображения по сравнению с исходным запуском игр.

Трассировка лучей невероятно требовательна к оборудованию, вот где красота DLSS пригодится:

Он разделен между четырьмя настройками качества; качество, сбалансированность, производительность и сверхпроизводительность, при этом качество изображения немного снижается в зависимости от использования. DLSS работает путем рендеринга игры в реальном времени с более низким исходным разрешением, а затем масштабирования до желаемого разрешения. Например, в Control при воспроизведении в формате 4K с DLSS в режиме производительности изначально отображается разрешение 1440p, но отображается 2160p.

(Изображение предоставлено AMD) FSR, однако, не полагается на ядра Tensor, а вместо этого действует как форма постобработки, реализация которой требует гораздо меньше аппаратного обеспечения. Он основан на алгоритме, который по существу использует фильтры повышения резкости и обнаружение краев, чтобы обеспечить более качественное изображение и более высокую частоту кадров, чем исходное разрешение.

Он основан на алгоритме, который по существу использует фильтры повышения резкости и обнаружение краев, чтобы обеспечить более качественное изображение и более высокую частоту кадров, чем исходное разрешение.

Основное преимущество FSR в DLSS заключается в том, что первая технология доступна для гораздо большего количества видеокарт, чем вторая, поскольку DLSS поддерживается только сериями RTX 20 и 30.

Что касается того, какая из технологий суперсэмплинга лучше, на самом деле это полностью зависит от оптимизации и поддержки игры, которая имеет значение. Например, игра, поддерживаемая Nvidia, такая как Metro Exodus, будет значительно улучшена с помощью DLSS на новейших картах Nvidia. Тем не менее, такая игра, как Far Cry 6, лучше всего масштабируется с помощью FSR на оборудовании AMD, особенно с учетом этих 11-гигабайтных HD-текстур.

Во многих случаях новейшие компьютерные игры поддерживают как DLSS, так и FSR независимо от оптимизации, поэтому, если графическая карта, на которой работает ваша машина, поддерживает технологию A. I. технология апскейлинга, то ее точно стоит включить. На наш взгляд, они выглядят и работают так же хорошо, как друг друга, обеспечивая основной прирост частоты кадров, одновременно снимая часть вычислительной нагрузки с самого графического процессора.

I. технология апскейлинга, то ее точно стоит включить. На наш взгляд, они выглядят и работают так же хорошо, как друг друга, обеспечивая основной прирост частоты кадров, одновременно снимая часть вычислительной нагрузки с самого графического процессора.

- Tie

Сравнение видеокарт серии Nvidia RTX 30

Каждая серия RTX 30 построена на архитектуре Ampere с минимальным объемом памяти 8 ГБ GDDR6, как RTX 3050, RTX 3060 Ti, так и RTX 3070. Как ни странно, стандарт RTX 3060 вместо этого имеет 12 ГБ видеопамяти.

Все начинает меняться, если сравнивать видеокарты среднего уровня серии RTX 30. Самый большой скачок, который RTX 3070 Ti делает по сравнению с исходной моделью, — это увеличение памяти GDDR6X для более высокой общей пропускной способности. Если вам нужна более дешевая линейка видеокарт с новейшей памятью, вам подойдут RTX 3070 и RTX 3070 Ti.

Это тот же тип памяти, который используется в RTX 3080, RTX 3080 Ti и RTX 3090, поэтому игра в этом отношении несколько выравнивается. Основное различие, которое определяет потенциал мощности каждого графического процессора Ampere, заключается в размере ширины шины памяти, на которой построены графические карты, при этом меньшие размеры означают, что меньше данных передается для меньшей производительности.

Основное различие, которое определяет потенциал мощности каждого графического процессора Ampere, заключается в размере ширины шины памяти, на которой построены графические карты, при этом меньшие размеры означают, что меньше данных передается для меньшей производительности.

Это очевидно для RTX 3050, самой дешевой и самой слабой из серии RTX 30, поскольку, несмотря на то, что она имеет тот же 8 ГБ памяти GDDR6, что и RTX 3060 Ti, и RTX 3070, она гораздо менее способна обрабатывать большие объемы данных из-за к его 128-битной шине памяти. Для справки, RTX 3060 Ti имеет 256-битную шину памяти, как и RTX 3070, а это означает, что этим картам легче обрабатывать более высокие разрешения (например, 1440p и 2160p). ПК с RTX 3060 и ПК с RTX 3070 близки по цене, но мы рекомендуем стремиться немного выше, если позволяет ваш бюджет.

Благодаря тому, что RTX 3080, RTX 3080 Ti и RTX 3090 продаются с их возможностями 4K, здесь значительно увеличивается общий объем видеопамяти и ширина шины памяти. RTX 3080 использует 320-битную шину памяти и 10 ГБ памяти, однако RTX 3080 Ti и RTX 3090 имеют 384-битную шину памяти, а также 12 ГБ и 24 ГБ памяти GDDR6X соответственно. Запас RTX 3080 является самым дешевым из трех, с небольшим разрывом в цене между запасом RTX 3080 Ti и запасом RTX 3090 на сегодняшнем рынке.

RTX 3080 использует 320-битную шину памяти и 10 ГБ памяти, однако RTX 3080 Ti и RTX 3090 имеют 384-битную шину памяти, а также 12 ГБ и 24 ГБ памяти GDDR6X соответственно. Запас RTX 3080 является самым дешевым из трех, с небольшим разрывом в цене между запасом RTX 3080 Ti и запасом RTX 3090 на сегодняшнем рынке.

Сравнение видеокарт Radeon RX 6000

Серия видеокарт AMD Radeon RX 6000 — это новейшая линейка видеокарт компании, построенная на архитектуре RDNA 2. Каждый графический процессор Big Navi можно разделить на три категории в зависимости от уровня мощности отдельной карты; 1080p, 1440p и 4K для игр.

Самая дешевая и самая последняя карта в линейке — это Radeon RX 6500 XT, которая рассчитана на производительность 1080p начального уровня в современных играх. Это единственный графический процессор в линейке Radeon RX 6000 с 4 ГБ GDDR6 и, следовательно, меньшей 64-битной шиной памяти. Точно так же RX 6600 и RX 6600 XT — это видеокарты, созданные для высококлассных игр в разрешении 1080p с частотой кадров, намного превышающей 60 кадров в секунду при максимальных настройках. Это связано с 8 ГБ памяти GDDR6 и 128-битной шиной памяти.

Это связано с 8 ГБ памяти GDDR6 и 128-битной шиной памяти.

Для производительности 1440p вам следует рассмотреть видеокарты Radeon RX 6700 XT и RX 6800. Основная стратегия AMD по сравнению с Nvidia в этом отношении заключается в производстве графических процессоров с более высокими тактовыми частотами и большим объемом видеопамяти, и это видно из 12 ГБ и 16 ГБ памяти, соответствующих каждой видеокарте здесь.

Наконец, есть видеокарты AMD RX 6000 Series, RX 6800 XT и RX 6900 XT, предназначенные для энтузиастов. Оба графических процессора используют 16 ГБ видеопамяти и 256-битную шину памяти. Эти карты примерно эквивалентны RTX 3080 Ti и RTX 309.0 соответственно по уровню мощности.

Стоит ли покупать видеокарты Nvidia или AMD?

Сравнение Nvidia и AMD, в конечном счете, сведется к тому, что вы хотите получить от видеокарты в 2022 году. Видеокарты AMD и Nvidia никогда не были так похожи по своей цели, хотя и предлагают конкурентные преимущества друг перед другом, когда все сказано. и сделано. Как правило, вы можете найти серию Radeon RX 6000 проще, чем серию RTX 30, по ценам, близким (но редко соответствующим) MSRP.

и сделано. Как правило, вы можете найти серию Radeon RX 6000 проще, чем серию RTX 30, по ценам, близким (но редко соответствующим) MSRP.

И FSR, и DLSS прошли долгий путь с момента появления этих технологий, и оба производителя оборудования явно усердно работают над тем, чтобы сделать масштабирование изображения в игре в тандеме с трассировкой лучей приоритетным. Поддержка большего количества игр продолжает выходить еженедельно как от Nvidia, так и от AMD, и, по крайней мере, на наш взгляд, между ними очень мало заметной разницы, даже если они расположены рядом.

Основным преимуществом Nvidia является трассировка лучей и чистое графическое ворчание RTX 309.0, чего AMD сейчас просто не может достичь. В то время как красный угол может похвастаться более высокими тактовыми частотами и более низкой ценой входа, с грубой технической точки зрения он не может конкурировать с лучшей в отрасли производительностью, демонстрируемой зеленой командой.

Лучшие предложения видеокарт на сегодня

(открывается в новой вкладке)

Nvidia Geforce GT 1030

(открывается в новой вкладке)

(открывается в новой вкладке)

£79,99

903 (открывается в новой вкладке)0003Посмотреть (откроется в новой вкладке)

Посмотреть все цены

(откроется в новой вкладке)

Gigabyte GeForce GT 1030 2GB

(откроется в новой вкладке)

(откроется в новой вкладке)

(откроется в новой вкладке)

Посмотреть (откроется в новой вкладке)

Посмотреть все цены новая вкладка)

109,90 фунтов стерлингов

(откроется в новой вкладке)

Посмотреть (откроется в новой вкладке)

Посмотреть все цены

(откроется в новой вкладке)

AMD Radeon RX 550

(откроется в новой вкладке)

(откроется в новой вкладке) )

117,95 фунтов стерлингов

(откроется в новой вкладке)

Посмотреть (откроется в новой вкладке)

Посмотреть все цены

(откроется в новой вкладке)

XFX GeForce GT220 1GB 9003

откроется вкладка 3)(открывается в новой вкладке)

128,98 фунтов стерлингов

(откроется в новой вкладке)

Посмотреть (откроется в новой вкладке)

Посмотреть все цены

(откроется в новой вкладке)

Gigabyte GT 1030 OC 2G

(откроется в новой вкладке)

(откроется в новой вкладке) вкладка)

£149,51

(открывается в новой вкладке)

£132,26

(открывается в новой вкладке)

Просмотр (открывается в новой вкладке)

См. все цены

все цены

3 90 в новой вкладке4) (открывается в новой вкладке) ASRock Challenger Arc A380

(открывается в новой вкладке)

(откроется в новой вкладке)

164,75 фунтов стерлингов

(откроется в новой вкладке)

147,59 фунтов стерлингов

(откроется в новой вкладке)

Посмотреть (откроется в новой вкладке)

3в новой вкладке)

XFX Speedster SWFT105 Radeon RX 6400

(открывается в новой вкладке)

(открывается в новой вкладке)

£150,80

Посмотреть все цены

(откроется в новой вкладке)

AMD Radeon RX 6400

(откроется в новой вкладке)

(откроется в новой вкладке)

155,32 £

(откроется в новой вкладке)

Посмотреть цены (откроется в новой вкладке) 20

4 Посмотреть все (открывается в новой вкладке)

Nvidia GeForce GTX 1650 Super

(открывается в новой вкладке)

(открывается в новой вкладке)

£161,47

(открывается в новой вкладке)

Просмотр (открывается в новой вкладке)

Посмотреть все цены

Продолжайте уверенно собирать ПК с лучший процессор для игр , лучшие корпуса ПК и лучшие игровые мониторы .

Ваш комментарий будет первым