что это и как рассчитывается?

Опубликовано 5.04.2020 автор Андрей Андреев — 0 комментариев

Здравствуйте, дорогие читатели моего блога! Тема сегодняшнего поста — пропускная способность видеокарты: что это такое, на что влияет, в чем измеряется, от чего зависит, какая должна быть оптимальная у хорошего графического адаптера, есть ли формула для рассчета, чтобы определить этот показатель, как посмотреть параметры своего девайса.

О том, как проверить производительность видеокарты, можно почитать тут.

Что такое шина данных

Как вы, вероятно, уже знаете, основные компоненты, которыми определяется производительность видеоадаптера — графический чип и видеопамять. Соединяются между собой они специальным каналом, который называется шиной данных.

Пропускная способность, или же битность — «ширина» этого канала, которая измеряется в битах. Она определяет количество информации, которой могут обменяться графический процессор и память видеокарты за единицу времени. Логично, что чем больше эта цифра, тем лучше.

Логично, что чем больше эта цифра, тем лучше.

Для игр это особенно актуально: в современных видеоиграх, требовательных к вычислительной мощности, часто ширина канала помимо прочих характеристик определяет, будет игра лагать или нет.

Если же включены сглаживание и анизотропная фильтрация, добавляющие красоты эффектам и игровым объектам, графическая плата с малой битностью попросту захлебнется от такого потока данных.

Оптимальная и максимальная пропускная способность

Благодаря унификации значений не слишком много. Сегодня в продаже можно найти устройства с такой битностью:

64 бита — довольно распространенные бюджетные графические адаптеры. Мощности хватит для работы, а также запуска простеньких игр — например, какой-нибудь браузерки или казуальной «Веселой фермы». Для игр ААА класса не подходят.

128 бит — средний ценовой сегмент. Такие видеокарты идеально подходят для домашнего мультимедийного центра. Можно запускать «тяжелые» программы типа Photoshop или 3D Max. Рендеринг видео тоже возможен, но времени на это уйдет много. Требовательные игры будут работать, но на средних настройках качества графики.

Рендеринг видео тоже возможен, но времени на это уйдет много. Требовательные игры будут работать, но на средних настройках качества графики.

256 или 384 бита — топовый сегмент. Мощные графические ускорители, «заточенные» под видеоигры. Как правило, остальные параметры, а именно частоты процессора и памяти, не отстают от битности. Стоят дорого, зато и современные игры «летают» на максимальных и ультра настройках.

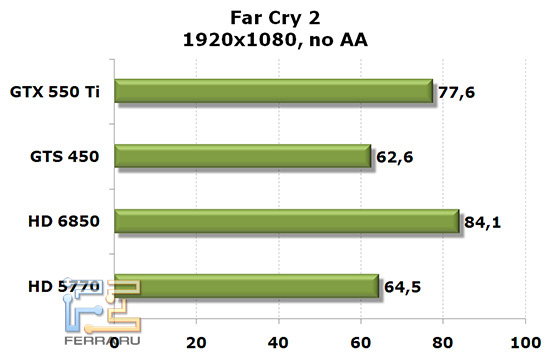

Хочу добавить, что эта классификация скорее условная, так как по одной лишь пропускной способности некорректно судить о возможностях графического адаптера.По результатам тестов, лучше видеоадаптер с большими частотами памяти и чипа, но меньшей битностью, чем наоборот. Если стоит выбор, то при прочих равных условиях лучше взять девайс с большей пропускной способностью.

Как посчитать пропускную способность памяти

Иногда требуется знать не только битность видеокарты, что сделать несложно (характеристики указаны на сайте производителя), но и битность самой памяти. Как узнать это параметр? Для расчетов нужно частоту памяти умножить на ширину шины в байтах.

Как узнать это параметр? Для расчетов нужно частоту памяти умножить на ширину шины в байтах.

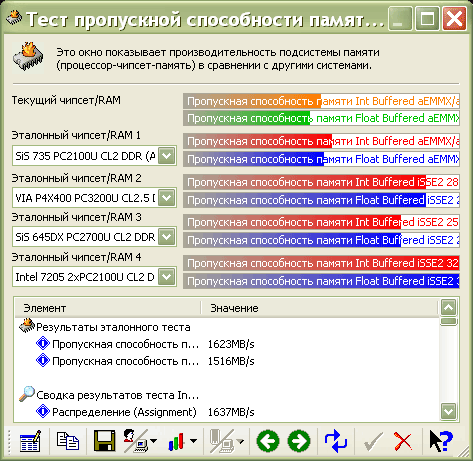

Например, 384 бита ֫— это 48 байт. Соответственно, девайс с частотой памяти 6000 МГц будет иметь пропускную способность памяти 288 Гбайт/с. Впрочем, такие расчеты уже лишние. ПСП можно посмотреть с помощью специальной диагностической утилиты — например, той же GPU‑Z.

Также советую ознакомиться с публикациями «Что такое GDDR5 на видеокарте» и «Что такое ОС в видеокартах». Буду признателен, если вы поделитесь этой статьей в социальных сетях, чтобы помочь в продвижении моего блога. До скорой встречи!

С уважением, автор блога Андрей Андреев.

Инструкция: Как узнать тип памяти видеокарты (GPU)

Тип памяти видеокарты — один из самых важных параметров, на который нужно обязательно смотреть при выборе платы. От типа памяти сильно зависит производительность GPU, что является главным критерием при выборе видеокарты. Если вы получили плату, но не знаете ее тип памяти, мы поможем определить его при помощи простых инструментов.

Оглавление: 1. Что такое тип памяти видеокарты 2. Как узнать тип памяти видеокарты - При помощи приложения - При помощи сайта

Что такое тип памяти видеокарты

Тип памяти (Type Memory) бывает GDDR и DDR. В современных видеокартах используется только GDDR — графическая память с удвоенной скоростью передачи данных.

Обратите внимание

DDR — это, чаще всего, оперативная память.

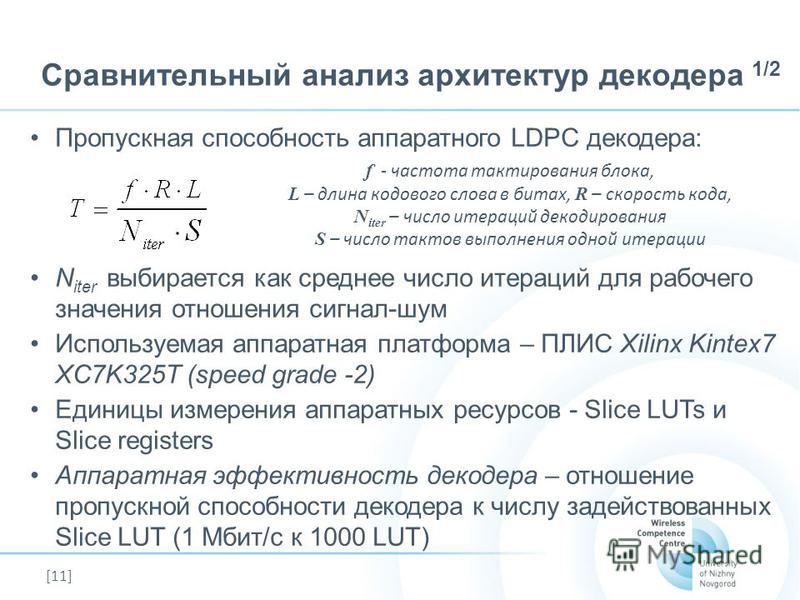

Память GDDR делится на несколько типов. В зависимости от типа GDDR, сильно отличается ее пропускная способность. Сейчас самые распространенные типы памяти видеокарты — это GDDR3 и GDDR5. Но на рынке можно встретить и все другие вариации памяти — GDDR, GDDR2 и GDDR4.

Обратите внимание

Видеокарты могут иметь практически одинаковое название и объем памяти, но отличаться по типу памяти. От этого модель более современного типа памяти будет стоить заметно дороже.

Стоит отметить, что память GDDR4, которая является более современной, нежели GDDR3, не имеет особой популярности среди производителей. Связано это с тем, что переход от GDDR4 к GDDR5 случился слишком быстро, и технологические мощности многие компании не перестроили с производства памяти GDDR3 на GDDR4. В итоге они сразу перешли на GDDR5, сохранив часть мощностей под производство GDDR3. Тем самым память GDDR4 так и не стала популярной.

Связано это с тем, что переход от GDDR4 к GDDR5 случился слишком быстро, и технологические мощности многие компании не перестроили с производства памяти GDDR3 на GDDR4. В итоге они сразу перешли на GDDR5, сохранив часть мощностей под производство GDDR3. Тем самым память GDDR4 так и не стала популярной.

Как узнать тип памяти видеокарты

Способов узнать тип памяти видеокарты — немало. Мы рассмотрим два из них — при помощи одного из специальных приложений и при помощи сайта.

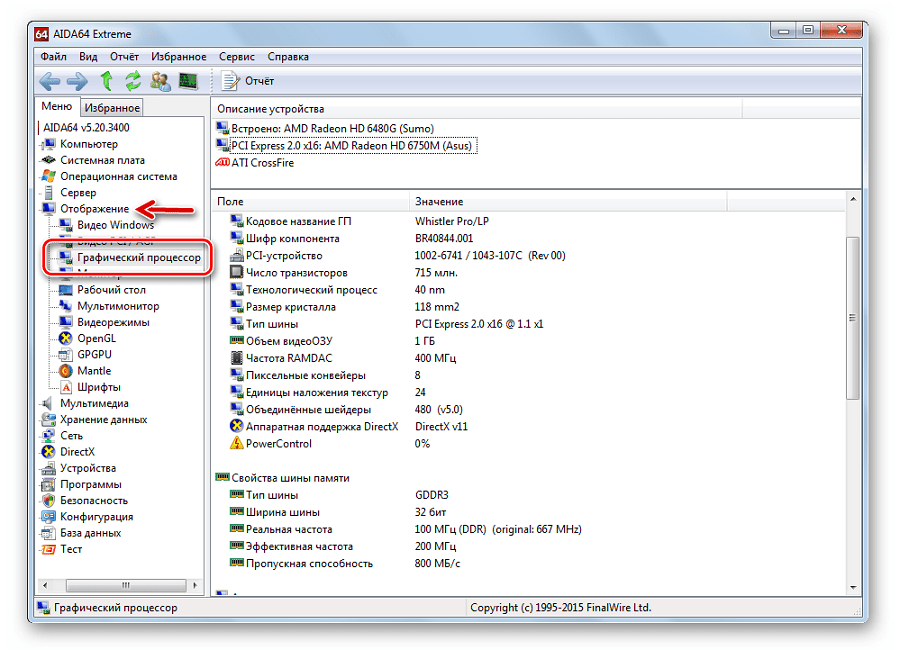

При помощи приложения

Обратите внимание

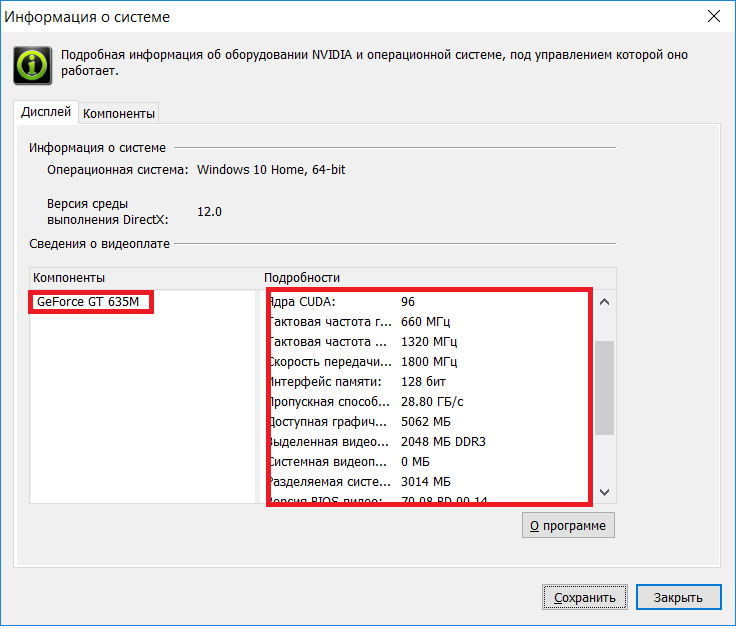

Многие приложения, которые анализируют техническую составляющую компьютера, способны показать тип памяти видеокарты. Мы рассмотрим работу приложения GPU-Z, но у него есть масса аналогов.

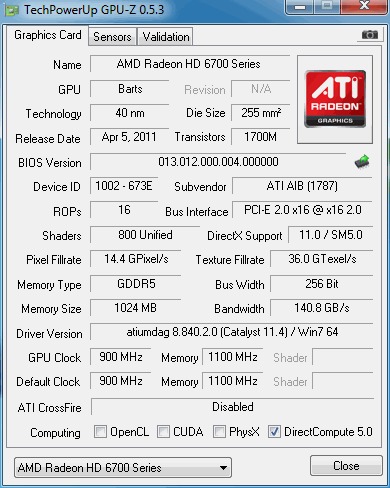

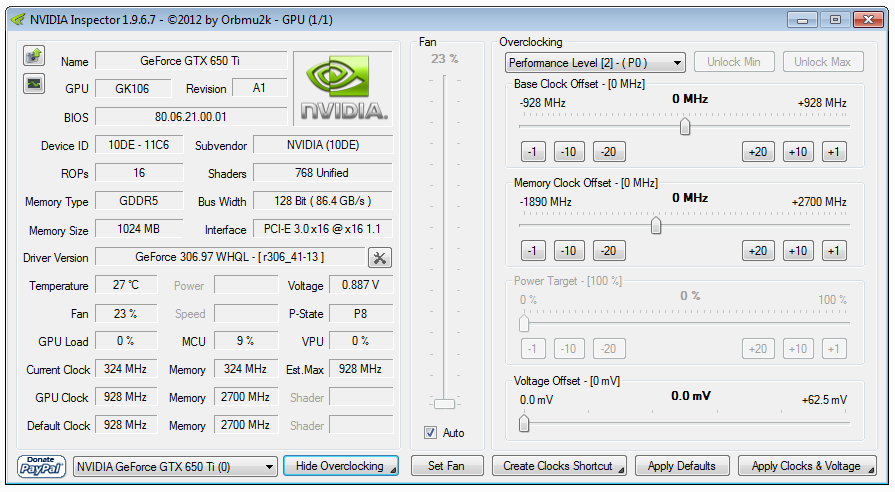

Запустите приложение для анализа информации о технической составляющей системы. В нашем случае это приложение GPU-Z. Отметим, что конкретно это приложение можно скачать бесплатно с сайта разработчиков.

В нижней части приложения можно переключиться на нужную видеокарту, если их установлено в компьютере несколько штук.

Выбрав нужную видеокарту, узнать тип памяти можно в графе “Memory Type”.

Обратите внимание

Приложение GPU-Z дает возможность получить максимально исчерпывающую техническую информацию о видеокарте. Помимо типа памяти, можно узнать ее размер, техпроцесс самой видеокарты, версию драйверов на компьютере и многое другое, что касается графики.

При помощи сайта

Есть множество сайтов, которые содержат в себе информацию обо всех основных видеокартах. Такой сайт дает возможность узнать тип памяти видеокарты, при этом не устанавливая на компьютер дополнительные приложения.

Обратите внимание

Чтобы при помощи сайта определить тип памяти видеокарты, нужно точно знать модель GPU.

Одним из сайтов, который позволяет узнать тип памяти видеокарты, является Game Debate. Просто перейдите на сайт и введите модель своей видеокарты в соответствующее поле.

Откроется страница с полной информацией о видеокарте. Внизу в таблице можно видеть пункт Memory Type — в нем и можно узнать тип памяти.

Обратите внимание

На сайте можно видеть рейтинг видеокарты в сравнении с другими моделями.

Загрузка…Сколько должно быть бит у видеокарты?

Дата публикации: 29.08.2012

Один из самых известных и популярных при торговле видеокартами параметров — разрядность шины памяти. Вопрос — «а сколько бит в видеокарте» не дает покоя покупателям и существенно влияет на цену ускорителя, чем не брезгуют пользоваться продавцы. Дадим однозначный ответ на вопрос о важности ширины шины памяти видеокарт и приведем в пример шкалу.

Для начала перечислим все варианты по возрастанию. В виде экзотики появились модели т.н. видеокарт, у которых разрядность составляет 32 бита 🙂 Так же компания Nvidia любит делать кратные трем величины, для создания обрезков, хотя в большинстве случаев разрядности всегда являются степенью двойки.

Итак существующие разрядности шин видеопамяти: 32, 64, 128, 192, 256, 320, 384, 448, 512.

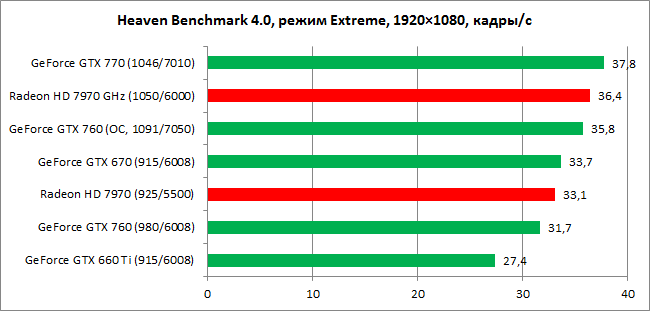

Так сколько же?! Конечно, чем больше — тем лучше! Но…

Крайние значения очень редки, как и кратные варианты, не считая набравшей популярность 192-х битной шины. Правда заключается в том, что важна НЕ РАЗРЯДНОСТЬ ШИНЫ сама по себе, а итоговая пропускная способность памяти ( далее ПСП). Другими словами — скорость доступа к памяти в гигабайтах в секунду Гб/с.

КАК ПОСЧИТАТЬ ПСП?

Считать не нужно, за вас это сделает масса утилит, например GPU-Z.

Как видим на картинке — ПСП видеокарты Radeon HD 6790 составляет 134 Гб/с. Но если утилиты нет или нужно прикинуть самому, то это тоже не сложно.

ПСП = Битность * Частоту памяти. Частоту памяти следует брать эффективную (удвоенное значение DDR2/DDR3/DDR4 и учетверенное для DDR5).

Для нашей видеокарты из примера это 1050МГц*4*256= 1075200 Мегабит/с. Для того, чтобы получить байты нужно разделить на 8 (1 байт= 8 бит).

1075200/8= 134,4 Гб/с.

Важно понимать, что если у вас видеокарта с шиной 64 бита или типом памяти DDR2, то ПСП высоким быть не сможет в принципе.

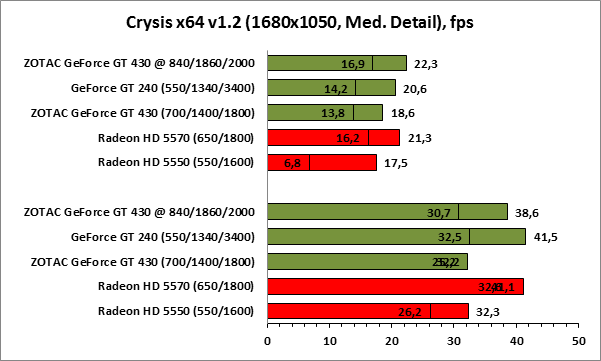

ТАБЛИЦА ЗНАЧЕНИЙ ПСП для видеокарт 2012-го года

Прежде чем комментировать данную таблицу следует а помнить, что производительность видеокарты зависит в первую очередь от графического чипа, а уж потом от ПС памяти. Но, некоторая зависимость все-таки есть. Тем более мало кому приходит в голову на видеокарту с высокой ПСП ставить слабый видеочип или наоборот. Хотя, бывают и исключения.

Видеокарты с ПСП менее 16Гб/с, вообще говоря — не видеокарты. Это заглушки, которые сгодятся только для того, чтобы воткнуть что-то в сокет и подключить монитор.

ПСП выше 20 Гб/с имеют видеокарты с шиной 128 бит и медленным типом памяти. Например GT 430 Nvidia. Поиграться можно, но не более. Цена им 50-80$ за новую.

Выше 37 Гб/с имеют видеокарты с шиной не менее 128 бит и эффективной частотой выше 2,3ГГц. Т.е. тип памяти DDR4/5.

Видеокарты с ПСП свыше 75 Гб/с следует относить к актуальным игровым. Этот уровень пропускной способности памяти может быть достигнут либо за счет современной высокочастотной памяти DDR5, либо шиной в 256 бит и выше. При условии, что используется современный видеочип, большинство игр будут отлично работать на настройках выше среднего при любых разрешениях. За такую новую видеокарту попросят около 160$, хотя можно найти варианты видеокарт за 100$.

Планка в 150Гб/с берется при обязательном наличии шины не менее 256 бит и современном типе видеопамяти ОДНОВРЕМЕННО. Типичное значение ПСП для топовых ускорителях колеблется около 200 Гб/с. Это 250+ у.

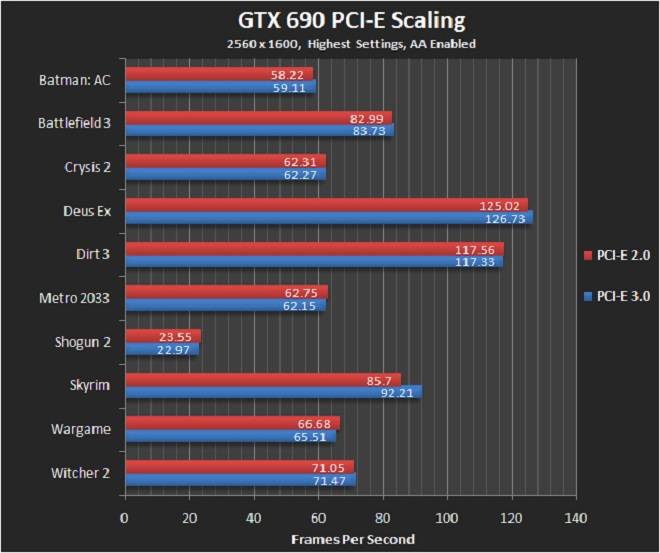

ПСП свыше 300 Гб/с можно назвать чудовищной! Объем жесткого диска 320 Гб скопировался бы за секунду при такой скорости. Тут недостаточно самой быстрой памяти на частотах в 6ГГц и выше, а так же шины в 256 или 384 бита. Тут необходим одновременный доступ несколькими видеоядрами по собственным широким шинам (не менее 256 бит каждая). Такое реализуется в топовых двухчиповых видеокартах, наподобие GTX 690 или HD 7990. Выглядят они примерно так…

У таких видеоускорителей чудовищная не только ПСП, но и цена.

В любом случае не забывайте, что выбор видеокарты начинается с типа графического процессора, ибо единственная задача ПСП — позволять видеоядру раскрыть свой потенциал. ПСП для ядра, а не наоборот.

👆Чем отличаются поколения видеопамяти | Видеокарты | Блог

Память, будь то оперативная память или видеопамять, является неотъемлемой частью современного компьютера. Сегодня вкратце узнаем, как все начиналось, как работает, почему диагностические программы показывают неверные частоты, в чем измеряется производительность памяти, как рассчитывается пропускная способность памяти и почему «МГц» для памяти — некорректное выражение.

DDR

До 2000-ых годов использовалась оперативная память стандарта SDR.

Потом ей на смену пришел новый стандарт памяти — DDR, который имел удвоенную пропускную способность памяти за счет передачи данных как по восходящим, так и по нисходящим фронтам тактового сигнала. Первоначально память такого типа, как и SDR, применялась в видеоплатах, но позднее появилась поддержка со стороны чипсетов.

DDR (Double Data Rate) расшифровывается как «удвоенная скорость передачи данных».

Таким образом, за один такт передается вдвое больше информации. Увеличилось количество передаваемой информации, реальная частота памяти осталась неизменной. Вместе с этим появилось такие понятия как эффективная частота, которая стала в два раза больше реальной.

Именно с приходом стандарта DDR появилась путаница с реальной и эффективной частотой работы памяти.

Реальная частота — частота шины модуля памяти. Эффективная частота — удвоенная частота шины модуля.

Как можно видеть, реальная частота памяти составляет 1900 МГц, в то время как эффективная в 2 раза больше — 3800 МГц, потому что за один такт теперь поступает вдвое больше данных.

Для того чтобы информация передавалась с удвоенной скоростью, она должна поступать из массива памяти вдвое быстрее. Реализовали это с помощью удвоения внутренней ширины модуля памяти. Благодаря чему за одну команду чтения мы стали получать сразу 2n единицы данных. Для стандарта DDR n = 1. Такая архитектура была названа n-prefetch (предвыборка). У памяти стандарта DDR, одной командой, при чтении, передается от ядра к буферу ввода-вывода две единицы данных.

Вместе с ростом производительности уменьшилось рабочее напряжение с 3.3V у SDR до 2.5V у DDR. Это позволило снизить энергопотребление и температуру, что дало возможность повысить рабочие частоты. На самом деле, потребление и, как следствие, нагрев, — это одна из самых больших проблем оперативной памяти того времени.

DDR2

Оперативная память стандарта DDR2 пришла на смену стандарту DDR в 2003 году, правда, поддерживающие ее чипсеты появились годом позже. Основное отличие DDR2 от DDR заключается в увеличенной вдвое частоте работы внутренней шины, по которой данные поступают в буфер «ввод-вывод». Передача на внутреннюю шину теперь осуществляется по технологии (4n-Prefetch), одной командой из массива памяти к буферу поступает 4 единицы данных.

Таким способом удалось поднять пропускную способность в два раза, не увеличивая частоту работы чипов памяти. Это выгодно с точки зрения энергоэффективности, да и количество годных чипов, способных работать на меньшей частоте, всегда больше. Однако у данного способа увеличения производительности есть и минусы: при одинаковой частоте работы DDR2 и DDR временные задержки у DDR2 будут значительно выше, компенсировать которые можно только на более высоких частотах работы.

Рабочее напряжение понизилось почти на 30% до 1.8V.

GDDR

На основе стандарта DDR для видеокарт в 2000 году был разработан новый стандарт памяти GDDR.

Технически GDDR и DDR похожи, только GDDR разработан для видеокарт и предназначен для передачи очень больших объемов данных.

GDDR (Graphics Double Data Rate) расшифровывается как двойная скорость передачи графических данных.

Несмотря на то, что они используются в разных устройствах, принципы работы и технологии для них очень похожи.

Главным отличием GDDR от DDR является более высокая пропускная способность, а также другие требования к рабочему напряжению.

Разработкой стандарта видеопамяти GDDR2 занималась компания NVIDIA. Впервые она была опробована на видеокарте GeForce FX 5800 Ultra.

GDDR2 это что-то среднее между DDR и DDR2. Память GDDR2 работает при напряжении 2.5V, как и DDR, однако обладает более высокими частотами, что вызывает достаточно сильный нагрев. Это и стало настоящей проблемой GDDR2. Долго данный стандарт на рынке не задержался.

Это и стало настоящей проблемой GDDR2. Долго данный стандарт на рынке не задержался.

Буквально чуть позже компания ATI представила GDDR3, в которой использовались все наработки DDR2. В GDDR3, как и DDR2, реализована технология 4n-Prefetch при операции записи данных. Память работала при напряжении 2V, что позволило решить проблему перегрева, и обладала примерно на 50% большей пропускной способностью, чем GDDR2. Несмотря на то, что разработкой стандарта занималась ATI, впервые его применила NVIDIA на обновленной видеокарте GeForce FX 5700 Ultra. Это дало возможность уменьшить общее энергопотребление видеокарты примерно на 15% по сравнению с GeForce FX 5700 Ultra с использованием памяти GDDR2.

Современные типы видеопамяти

На сегодняшний день наиболее распространенными типами видеопамяти являются GDDR5 и GDDR6, однако до сих пор в бюджетных решениях можно встретить память типа GDDR3-GDDR4 и даже DDR3.

Стандарт GDDR5 появился в 2008 году и пришел на смену стандарту GDDR4, который просуществовал совсем недолго, так и не получив широкое распространение вследствие не лучшего соотношения цена/производительность.

GDDR5 спроектирована с использованием наработок памяти DDR3, в ней используется 8-битовый Prefetch. Учитывая архитектурные особенности (используются две тактовые частоты CK и WCK), эффективная частота теперь в четыре раза выше реальной, а не в два, как было раньше. Таким способом удалось повысить эффективную частоту до 8 ГГц, а вместе с ней и пропускную способность в два раза. Рабочее напряжение составило 1.5V.

GDDR5X — улучшенная версия GDDR5, которая обеспечивает на 50% большую скорость передачи данных. Это было достигнуто за счет использования более высокой предварительной выборки. В отличие от GDDR5, GDDR5X использует архитектуру 16n Prefetch.

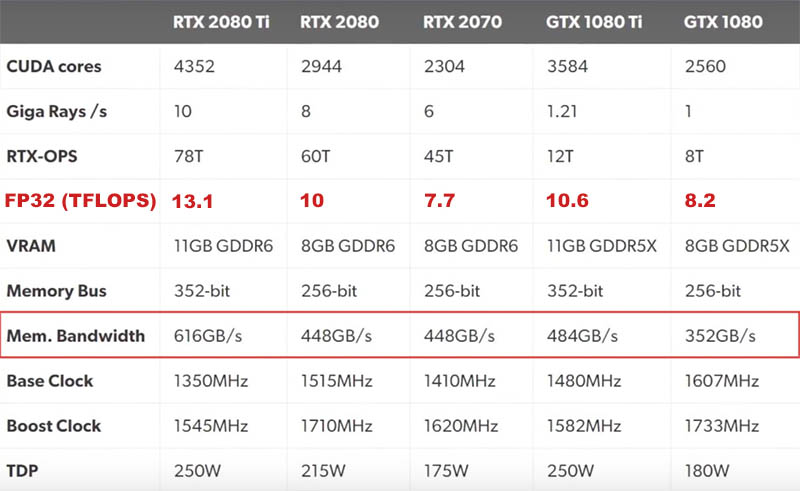

GDDR5X способна функционировать на эффективной частоте до 11 ГГц. Данная память использовалась только для топовых решений NVIDIA 10 серии GTX1080 и GTX1080Ti.

Память стандарт GDDR6 появился в 2018 году. GDDR6, как и GDDR5X, имеет архитектуру 16n Prefetch, но она разделена на два канала. Хотя это не улучшает скорость передачи данных по сравнению GDDR5X, оно позволяет обеспечить большую универсальность.

Сейчас данная память активно используется обоими производителями видеокарт в новой линейке NVIDIA серий GeForce 20 и 16 (кроме некоторых решений: GTX 1660 и GTX 1650, так как в них используется память GDDR5). При покупке нужно внимательно изучить характеристики видеокарты, потому как разница в производительности от типа памяти в данном случаи достигает от 5 до 15%. В то время как разница в цене совершенно несущественна.

Также тип памяти GDDR6 активно используется компанией AMD в видеокартах RX 5000 серии.

На начальном этапе GDDR6 способна функционировать с эффективной частотой 14 ГГц. Это позволяет удвоить пропускную способность относительно GDDR5. В дальнейшем эффективная частота будет увеличена, как это происходило с другими типами памяти.

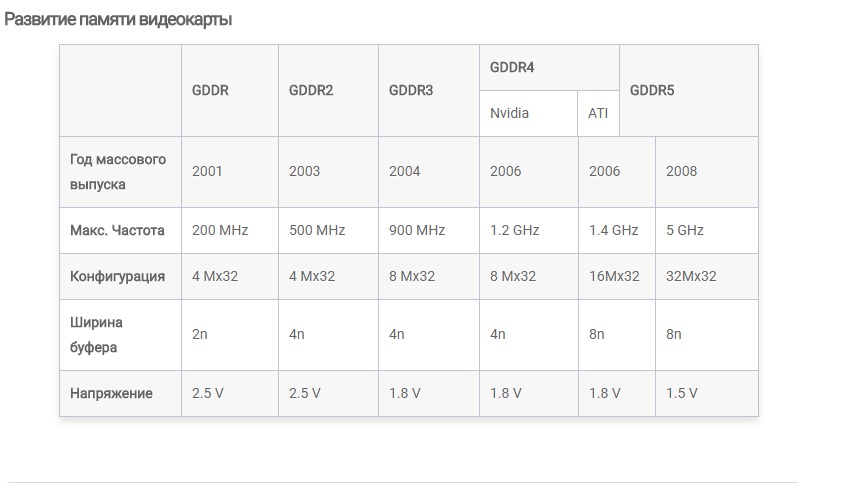

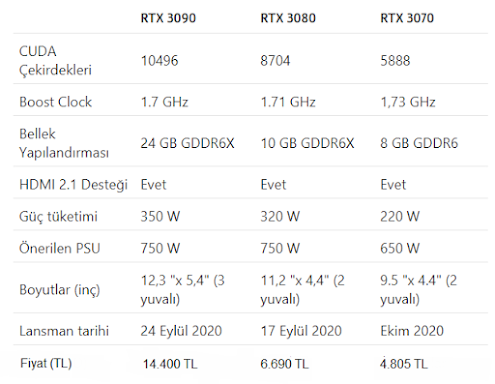

Memory Technology | Memory Speed | Memory Bus | Memory Bandwidth |

GDDR6 | 14 Gbps | 384-bit | 672 GB/s |

GDDR5X | 11 Gbps | 384-bit | 528 GB/s |

GDDR5 | 7 Gbps | 384-bit | 336 GB/s |

GDDR6 | 14 Gbps | 256-bit | 448 GB/s |

GDDR5X | 11 Gbps | 256-bit | 352 GB/s |

GDDR5 | 7 Gbps | 256-bit | 224 GB/s |

GDDR6 | 14 Gbps | 192-bit | 336 GB/s |

GDDR5X | 11 Gbps | 192-bit | 264 GB/s |

GDDR5 | 7 Gbps | 192-bit | 168 GB/s |

- Шину памяти (Memory Bus) можно рассматривать как дорожные полосы

— Чем больше полос выделено для движения, тем живее поток.

С приходом нового типа памяти ее реальные частоты могут быть даже меньше, чем у предыдущего поколения. Однако в последующем производители отлаживают процесс и выжимают максимум возможного.

Например, сейчас такое происходит с оперативной памятью DDR4. На старте продаж ее частоты были как и у DDR3, но сейчас мы видим, что в продаже есть модули, способные функционировать на частоте 5000 МГц, а уже в следующем году наc ждет новый тип оперативной памяти DDR5.

Кратко о типе памяти HBM

HBM — это совершенно новый стандарт памяти, он обладает низкой рабочей частотой, но имеет очень широкую шину, благодаря чему обладает существенно более высокой пропускной способностью и значительно меньшими задержками по сравнению с GDDR5, одновременно потребляя значительно меньше электроэнергии. Память стандарта HBM достаточно дорогая для использования в геймерских видеокартах, поэтому чаще всего используется в профессиональных решениях.

HBM имеет отличия и в компоновке по сравнению с традиционной видеопамятью. В случае GDDR чипы памяти распаиваются на плате рядом с графическим процессором, а сами чипы занимают много места. Но кристаллы HBM оснащены сквозными контактами, благодаря чему память можно собирать в вертикальные стэки, когда один кристалл лепят к другому сверху.

В случае GDDR чипы памяти распаиваются на плате рядом с графическим процессором, а сами чипы занимают много места. Но кристаллы HBM оснащены сквозными контактами, благодаря чему память можно собирать в вертикальные стэки, когда один кристалл лепят к другому сверху.

Чипы памяти взаимодействуют с GPU через дополнительную кремниевую подложку. Получается этакий бутерброд из кристаллов. Это позволяет экономить место на плате, значительно упрощает и удешевляет саму печатную плату (у GDDR сотни контактов на один чип) и позволяет более эффективно охлаждать память.

Плюсы HBM:

- высокая пропускная способность

- высокая битовая плотность на модуль

- низкое энергопотребление

- маленькая задержка

- значительное уменьшение размеров видеокарты

Минусы по сравнению с GDDR:

- высокие производственные затраты, следовательно, высокая конечная цена

- высокие затраты на интеграцию из-за повышенной сложности конструкции

Частота памяти — некорректное понятие

Что за цифры в характеристиках памяти и чем измеряются?

В спецификации стандарта JEDEC есть замечание, что применение термина «МГц» в DDR некорректно, правильно указывать скорость «миллионов передач в секунду через один вывод данных» MT/S.

Именно поэтому запись DDR4 3600 МГц лишена смысла — поскольку шина памяти работает на реальной частоте 1800 МГц и лишь передает данные два раза за такт. А поскольку с виду все это кажется как 1800*2 = 3600, то маркетологи тут же принялись писать 3600 МГц.

Как говорят маркетологи из компании Intel, «пользователь покупает ГГц», и неважно, соответствует ли фраза истине.

Со временем у производителей памяти сложилось стойкое ощущение, что нужно использовать термин Мегагерц «МГц», для покупателя короче и выглядит внушительнее. Вот и прижились всем МГц несмотря на то, что звучит некорректно.

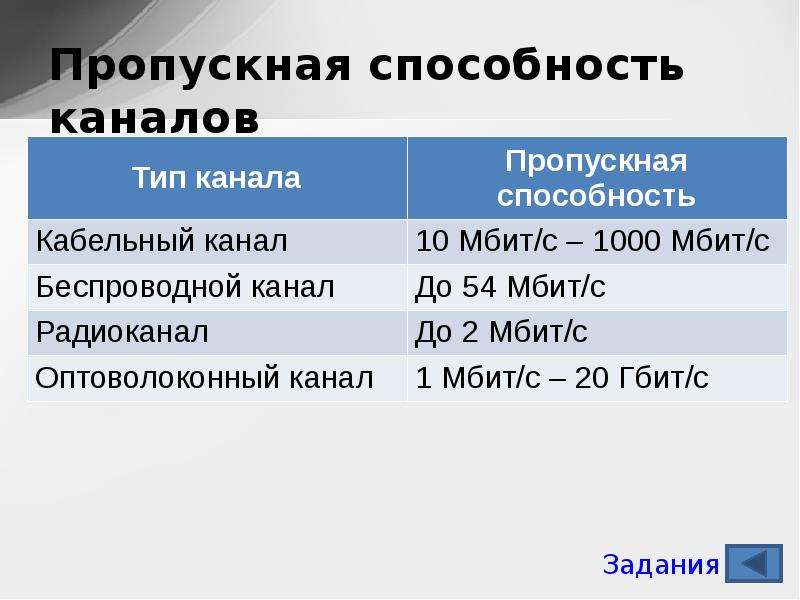

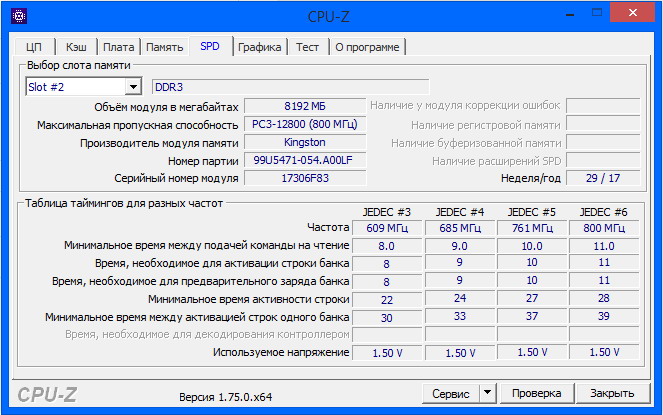

Как вычислить пропускную способность памяти?

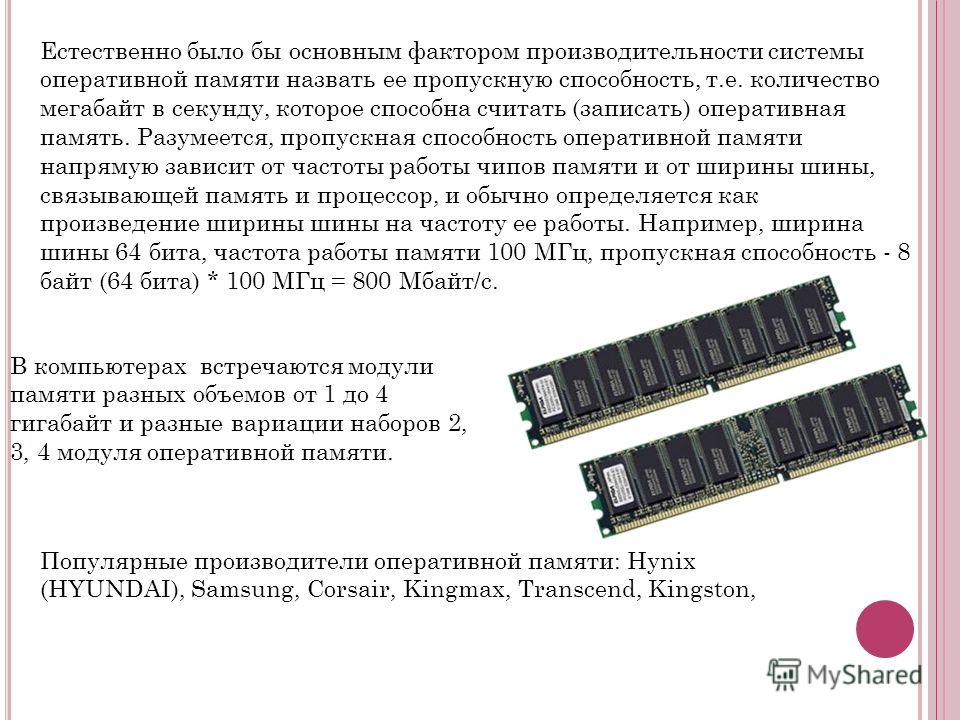

Пропускная способность памяти напрямую зависит от эффективной частоты и разрядности шины памяти.

Разрядность оперативной памяти характеризуется количеством бит, с которыми операция чтения из памяти или запись может быть выполнена одновременно. Современные модули памяти имеют разрядность 8 байт или 64 бита. В большинстве компьютеров сейчас используется либо двухканальный режим работы памяти (при использовании двух модулей памяти) — это 128 бит, либо одноканальный (один модуль памяти) — 64 бит. Есть еще 256-битный режим работы оперативной памяти, но он чаще встречается в HEDT-платформах (High-End Desktop — высокопроизводительная рабочая станция).

Современные модули памяти имеют разрядность 8 байт или 64 бита. В большинстве компьютеров сейчас используется либо двухканальный режим работы памяти (при использовании двух модулей памяти) — это 128 бит, либо одноканальный (один модуль памяти) — 64 бит. Есть еще 256-битный режим работы оперативной памяти, но он чаще встречается в HEDT-платформах (High-End Desktop — высокопроизводительная рабочая станция).

Чтобы рассчитать теоретическую пропускную способность, воспользуемся формулой:

ПСП = Эффективная частота * шину памяти (64 для одноканального режима и 128 для двухканального) и / 8.

Для примера, мои модули DDR4 G.Skill SNIPER X [F4-3600C19D-32GSXWB] 32 ГБ с эффективной частотой 3600 МГц. Чтобы узнать эффективную частоту нужно реальную частоту умножить на 2: 1800*2 = 3600.

Для двухканального режима работы 3600*128/8 = 57600 Мбайт/с.

Для одноканального режима работы 3600*64/8 = 28800 Мбайт/с.

Именно это число указывается при маркировке модуля «PC4-28800».

Чтобы узнать эффективную частоту видеопамяти, нужно реальную умножить на 4, это касается видеокарт с памятью GDDR5, в то время как для GDDR5X и GDDR6 реальную частоту нужно умножить на 8.

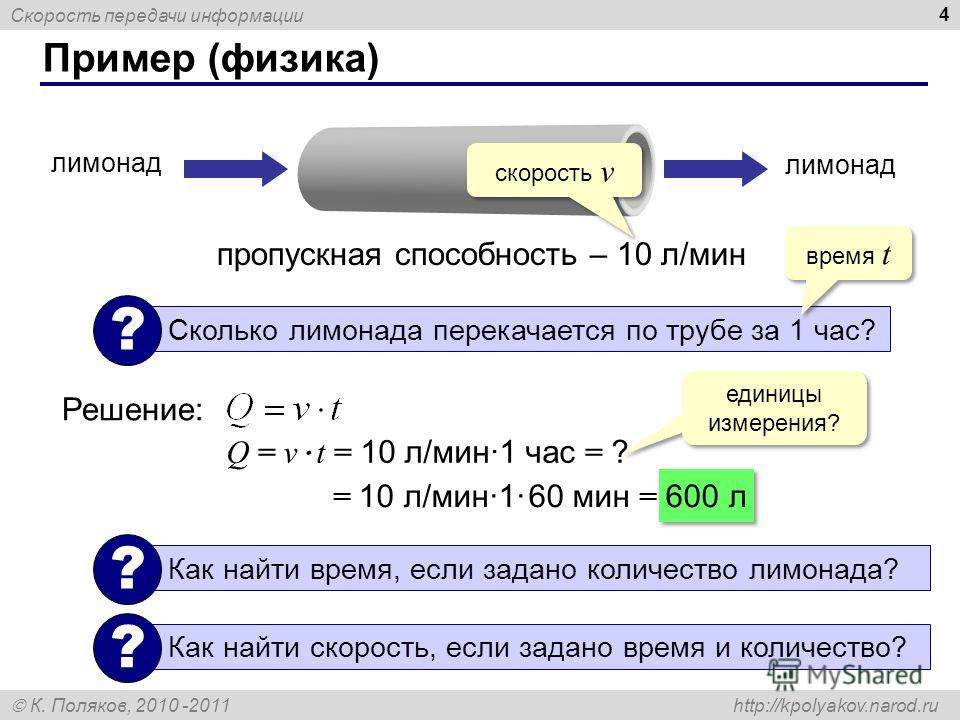

Пример расчета пропускной способности памяти для видеокарт:

Для нашей видеокарты R290X реальная частота памяти равна 1250 МГц. Так как за такт в памяти GDDR5 передается в 4 раза больше данных, нужно умножить на 4, чтобы получить эффективную частоту. Так как шина памяти у видеокарты составляет 512 бит, умножаем на 512. 1250 МГц*4*512 = 2560000 Мегабит/с.

Для того, чтобы получить байты, нужно полученное число разделить на 8 так как 1 байт = 8 бит, 2560000/8/1000 = 320,0 Гб/с. Получается, пропускная способность памяти у данной видеокарты равна 320,0 Гб/с.

Поскольку базовая скорость памяти не изменяется существенно от поколения к поколению, именно увеличивающаяся предварительная выборка и шина с каждым поколением DDR помогает обеспечить рост пропускной способности.

Тип памяти | Базовая частота | Шина памяти | Предвыборка | МТ/s | Пропусная прособность | Напряжение |

SDRAM | 100–166 | 100–166 | 1 | 100–166 | 0,8–1,3 | 3,3 |

DDR | 100–200 | 100–200 | 2 | 200–400 | 1,6–3,2 | 2,5/2,8 |

DDR2 | 100–266 | 200–533 | 4 | 400–1066 | 3,2–8,5 | 1,8 |

DDR3 | 100–266 | 400–1066 | 8 | 800–2133 | 6,4–17,1 | 1,35/1,5 |

DDR4 | 100–266 | 1066–2133 | 8 | 2133–4266 | 17,1–34,1 | 1,2 |

Как можно видеть, с каждым приходом нового стандарта оперативной памяти наблюдается двухкратный рост пропускной способности. Вместе с тем постоянно снижается рабочее напряжение и, как следствие, энергопотрбление. Так как оно напрямую связано с энергоэффективностью, его важность лишь продолжит усиливаться в дальнейшем.

Вместе с тем постоянно снижается рабочее напряжение и, как следствие, энергопотрбление. Так как оно напрямую связано с энергоэффективностью, его важность лишь продолжит усиливаться в дальнейшем.

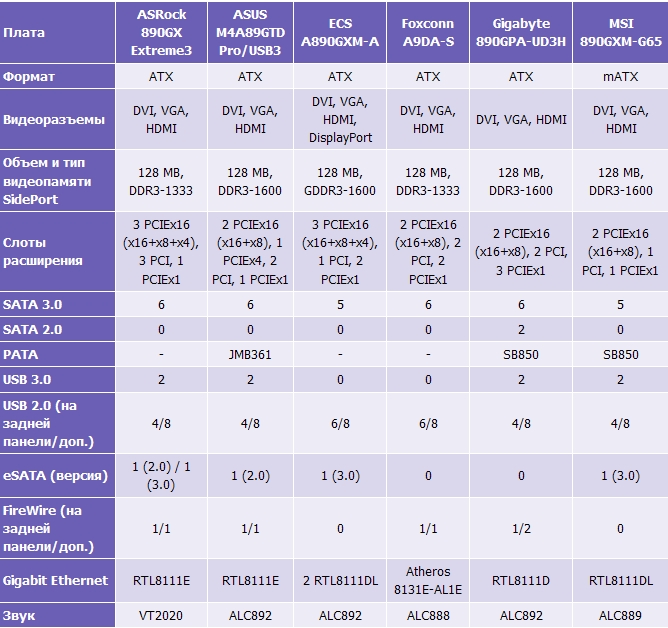

Совместимость материнской платы и видеокарты — 4 критерия подбора

Чтобы добиться наибольшей производительности от сборки, необходимо, чтобы все ее элементы были максимально совместимы. Этот гайд расскажет, каким образом можно понять, какой дискретный видеоадаптер поддерживает системная плата. Он также содержит советы, которые помогут подобрать подходящий вариант.

Как подобрать видеокарту к материнской плате

При выборе видеоадаптера важно удостовериться в его совместимости с материнкой. Так, должно совпадать количество и тип слотов. Некоторые мощные карты занимают два гнезда, а бывает, что и все три. Но есть и другие нюансы.

Узнайте: Что такое материнская плата в компьютере и на что она влияет: 5 поясняющих разделов

Совместимость материнской платы и видеокарты

Порты обоих устройств должны совпадать. Ниже — краткое описание возможных разъемов.

Ниже — краткое описание возможных разъемов.

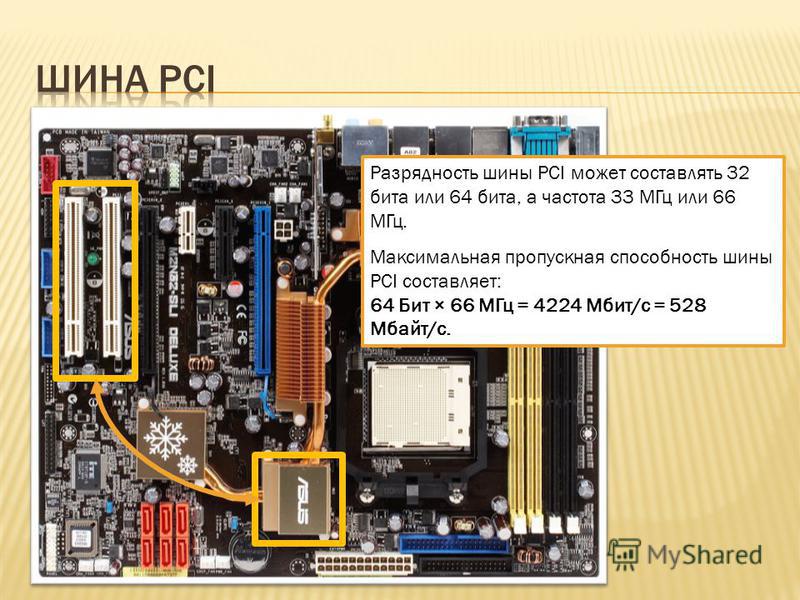

AGP и PCI Express

АГП интерфейс — устаревший вариант. Его уверенно заменил PCI Express. Словом, для современных производительных компьютеров AGP — не вариант. Но и с PCI есть нюансы.

Читайте также: Игровые видеокарты для ПК: 5 критериев, как выбирать

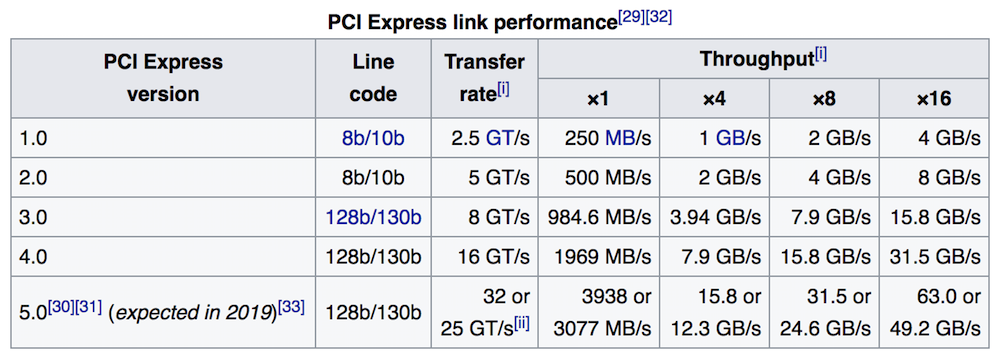

PCI Express 2.0 и 3.0

Первая версия разъема обладала скоростью в 2,5 гигатранзакций в секунду. Во второй, вышедшей в 2007 году, быстрота увеличилась в два раза. За счет обратной совместимости старые видеокарты нормально работали в более новых материнских платах.

Какие были новшества, кроме скорости:

- обновленные механизмы, созданные для контроля скорости соединений программным образом;

- смена системы питания.

В PCI-SIG была создана спецификация, способная обеспечить необходимую подпитку с учетом особенностей потребления энергии графических адаптеров: диапазон повысили до 225-300 Вт на устройство. Для этого стали использовать новый в то время 2×4-пиновый разъем.

Для этого стали использовать новый в то время 2×4-пиновый разъем.

В 2010 году выпустили 3-ю вариацию интерфейса с показателем скорости в восемь гигатранзакций. Такой прорыв получилось совершить за счет новой схемы кодировки, когда 128 бит информации, которая проходит по шине, кодируется 130 битами. Девайсы с поддержкой этой версии стали доступны на рынке только в 2012 году.

Четвертая версия появилась в 2017 году. Она стала еще быстрее: этот разъем способен осуществлять аж 16 гигатранзакций в одно мгновение. Стандарт 5.0, утвержденный два года спустя, получил пропускную способность в 32 Гт/с. Такая скорость подходит для проектов, которые связаны с VR.

SLI и Crossfire

Создавая топовую геймерскую систему, разработчики ставят в приоритет задачу добиться максимально возможной производительности при работе с 3D-проектами. Это логично, так как современные игры весьма требовательны к ресурсам компьютера, и особенно — к его графической составляющей.

С этой целью две лидирующие компании — AMD и NVidia — разработали технологии, которые позволяют объединить два и более GPU в сборке. Это нужно, чтобы использовать суммарную мощность видеокарт, подключив их параллельно. У АМД такая разработка называется Crossfire, поддерживается, например, моделью RX 560, а у Нвидиа — SLI, есть у HP NVIDIA Quadro P620 2GB.

Это нужно, чтобы использовать суммарную мощность видеокарт, подключив их параллельно. У АМД такая разработка называется Crossfire, поддерживается, например, моделью RX 560, а у Нвидиа — SLI, есть у HP NVIDIA Quadro P620 2GB.

Возможность существенного увеличения графической мощности открывает новые горизонты не только для геймеров, но и для тех, кто работает с трехмерной графикой.

Что нужно учесть при выборе:

- Имеет смысл объединять только топовые GPU.

- Материнка также должна поддерживать такие технологии.

- Для параллельной стабильной работы видеоадаптеров рекомендуется приобретать идентичные модели. В противном случае велика вероятность того, что девайсы будут конфликтовать.

Совет: если пользователь на 100% уверен в том, что он поставит вторую видеокарту, тогда покупка моделей с поддержкой подобных технологий — необходимое решение. Если же это не более, чем планы на будущее, то лучше уж заменить старое ГПУ на более мощное, когда появится такая возможность, и не заморачиваться с нюансами сейчас.

Пригодится: Какую материнскую плату выбрать — 8 ключевых критериев

Мощность процессора

Чтобы сборка работала стабильно, она должна быть сбалансированной. Только грамотный подбор компонентов позволит по максимуму насладиться возможностями ПК.

Мощность ЦП обязательно стоит учитывать. Слабый процессор не способен раскрыть потенциал GPU на 100%.

Неопытные пользователи часто полагают, что мощный графический адаптер — решение всех проблем, однако это не так. Да, установив производительное устройство, пользователь получит хороший прирост быстродействия, но нет смысла ставить, например, модель уровня GTX 1080 в сборку с двухъядерным «камнем». Это не дает 100% гарантии избавления от фризов, и уж точно не факт, что комфортно поиграть на ультрапресете во все новинки удастся без проблем.

Совет: не стоит забывать, что не менее важен и объем ОЗУ, который должен составлять как минимум 8 Гб для дизайна, видеомонтажа, а для геймерских моделей рекомендуется не менее 16 Гб, тем более, если пользователь настроен играть на максималках.

Важно учитывать не только количество ядер (нужно минимум четыре), но и потоков, так как многие игры, профессиональный софт оптимизированы под многопоточные модели.

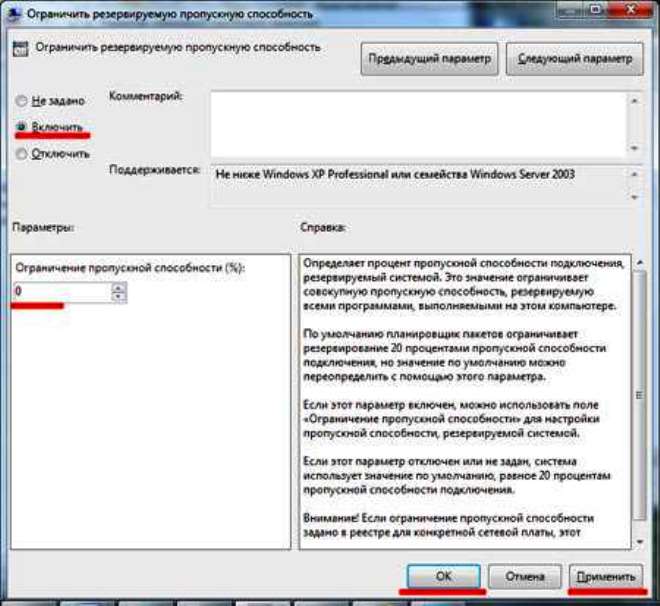

Как узнать, в каком режиме работает видеокарта

Бывает так, что GPU использует меньшую, чем x16, ширину шины, и от этого страдает быстродействие.

|

Как можно устранить проблему |

|

|---|---|

| Шаг 1 | Убедиться, что видеокарта надежно закреплена в слоте. |

| Шаг 2 | Проверить разъем видеокарты и слот на материнке на механические повреждения. |

| Шаг 3 | Обратить внимание на число поддерживаемых чипсетом материнской платы линий PCI Express и на конфигурацию слотов PCIE х16 на конкретной модели. Возможно, пропускная способность разъема платы ниже, чем нужно видеоадаптеру. |

| Шаг 4 | Проверить, не включено ли по ошибке в настройках BIOS не то число каналов. Это можно посмотреть в строке «PEG Force X1» или «PCI-E Lanes». |

| Шаг 5 | В ноутбуках технология PowerMizer, повышающая энергоэффективность, может изменять число активных каналов шины PCI Express. Если ее отключить, быстродействие повысится. |

| Шаг 6 | Одной из возможных причин снижения ширины шины может стать система управления ее энергопотреблением, интегрированная вОС от Майкрософт, начиная с версии VISTA. Ее можно отключить в панели управления. Как это сделать: |

| 1. Зайти в «Управление электропитанием». | |

| 2. Изменить дополнительные настройки электропитания, отключив опцию «Управление питанием состояния связи» (Link State Power Management). | |

| Шаг 7 | Если же необходимо убедиться в том, активен ли режим SLI или Crossfire, то проверку можно осуществить с помощью одной из бесплатных программ: CPU Z или AMD Catalyst. |

Подборка: 10 лучших моделей недорогих игровых видеокарт

Габариты

Чтобы узнать, подойдет ли ГПУ к материнке, и станет ли оно в корпус, необходимо убедиться в совместимости размерных параметров. Если в системник большего размера, компактный девайс установится без проблем. А вот габаритное ГПУ с мощной системой охлаждения никак не войдет в компактный корпус.

Размеры GPU указываются в характеристиках, кроме того, поддерживаемая максимальная длина адаптера обозначается в спецификациях корпуса.

Совместимость по габаритам касается материнки и видеокарты. Если в сборке стоит компактная плата, то и карту нужно выбирать соответствующую. Крупные устройства могут прогнуть «мать» или просто не вместятся в нее.

Примечание: ширина компонента может зависеть от числа разъемов на нем. На бюджетных чаще расположен один ряд.

Есть компактные дискретки без охлаждения или с пассивным радиатором. Как правило, это маломощные варианты, которые приобретают как времянку, если в выбранный процессор не встроено графическое ядро.

Как правило, это маломощные варианты, которые приобретают как времянку, если в выбранный процессор не встроено графическое ядро.

Интересно: мощная Gigabyte GeForce RTX 2080 SUPER GAMING OC WATERFORCE WB 8G оснащена жидкостным охлаждением, дополненным радиатором.

Впрочем, есть и довольно производительные низкопрофильные экземпляры, компоненты с одним вентилятором, которые в компактный корпус ставятся без проблем и обеспечивают хорошие скоростные показатели.

Полезно: Совместимость процессора и материнской платы — как подобрать комплектующие: гайд в 3 разделах

Подобрать видеоадаптер к материнке несложно, главное — соответствие контактов, габаритная совместимость. Чтобы собрать хороший PC, также нужно иметь ввиду объем RAM и параметры ЦПУ.

Слоты расширения: AGP и PCI Express | Все о видеокартах | Железо

При смене одной только видеокарты обязательно нужно учитывать, что новые модели могут просто не подходить к вашей материнской плате, так как существует не просто несколько разных типов слотов расширения, но несколько их версий (применительно к AGP, и в скором времени — к PCI Express). Если вы не уверены в своих знаниях по этой теме, внимательно ознакомьтесь с разделом.

Если вы не уверены в своих знаниях по этой теме, внимательно ознакомьтесь с разделом.

Как мы уже отметили выше, видеокарта вставляется в специальный разъем расширения на системной плате компьютера, через этот слот видеочип обменивается информацией с центральным процессором системы. На системных платах чаще всего есть слоты расширения одного-двух (реже трёх) разных типов, отличающихся пропускной способностью, параметрами электропитания и другими характеристиками, и не все из них подходят для установки видеокарт. Очень важно знать имеющиеся в системе разъемы и покупать только ту видеокарту, которая им соответствует. Разные разъемы расширения несовместимы физически и логически, и видеокарта, предназначенная для одного типа, в другой не вставится и работать не будет.

Мы не будем касаться ISA и VESA Local Bus слотов расширения и соответствующих им видеокарт, так как они безнадежно устарели, и не каждый специалист ныне знает о них что-то большее, чем их названия и то, что они когда-то существовали. Обойдем вниманием и слоты PCI, так как игровых видеокарт для них давно уж нет.

Обойдем вниманием и слоты PCI, так как игровых видеокарт для них давно уж нет.

Современные графические процессоры используют один из двух типов интерфейса: AGP или PCI Express. Эти интерфейсы отличаются друг от друга в основном пропускной способностью, предоставляемыми возможностями для питания видеокарты, а также другими менее важными характеристиками. Теоретически, чем выше пропускная способность интерфейса, тем лучше. Но практически, разница в пропускной способности даже в несколько раз не слишком сильно влияет на производительность, и пропускная способность интерфейса крайне редко является узким местом, ограничивающим производительность.

Лишь очень малая часть современных системных плат не имеет слотов AGP или PCI Express, единственной возможностью расширения для них является интерфейс PCI, видеокарты для которого весьма редки и попросту не подходят для домашнего компьютера. Рассмотрим два современных интерфейса подробнее, именно эти слоты вам нужно искать на своих системных платах. Смотрите фотографии и сравнивайте.

Смотрите фотографии и сравнивайте.

AGP

AGP (Accelerated Graphics Port или Advanced Graphics Port) — это высокоскоростной интерфейс, основанный на спецификации PCI, но созданный специально для соединения видеокарт и системных плат. Шина AGP лучше подходит для видеоадаптеров по сравнению с PCI (не Express!) потому, что она предоставляет прямую связь между центральным процессором и видеочипом, а также некоторые другие возможности, увеличивающие производительность в некоторых случаях, например, GART — возможность чтения текстур напрямую из оперативной памяти, без их копирования в видеопамять; более высокую тактовую частоту, упрощенные протоколы передачи данных и др.

В отличие от универсальной шины PCI, AGP используется только для видеокарт. Интерфейс имеет несколько версий, последняя из них — AGP 8x с пропускной способностью 2.1 Гб/с, что в 8 раз больше начального стандарта AGP с параметрами 32-бит и 66 МГц. Новых системных плат с AGP уже не выпускают, они окончательно уступили рынок решениям с интерфейсом PCI Express, но AGP до сих пор имеет широкое распространение и дает достаточную пропускную способность даже для новых видеочипов.

Спецификации AGP появились в 1997 году, тогда Intel выпустил первую версию описания, включающую две скорости: 1x и 2x. Во второй версии (2.0) появился AGP 4x, а в 3.0 — 8x. Рассмотрим все варианты подробнее:

AGP 1x — это 32-битный канал, работающий на частоте 66 МГц, с пропускной способностью 266 Мбайт/с, что в два раза выше полосы PCI (133 Мбайт/с, 33 МГц и 32-бит).

AGP 2x — 32-битный канал, работающий с удвоенной пропускной способностью 533 Мбайт/с на той же частоте 66 МГц за счет передачи данных по двум фронтам, аналогично DDR памяти (только для направления «к видеокарте»).

AGP 4x — такой же 32-битный канал, работающий на 66 МГц, но в результате дальнейших ухищрений была достигнута учетверенная «эффективная» частота 266 МГц, с максимальной пропускной способностью более 1 ГБ/с.

AGP 8x — дополнительные изменения в этой модификации позволили получить пропускную способность уже до 2.1 ГБ/с.

Видеокарты с интерфейсом AGP и соответствующие слоты на системных платах совместимы в определенных пределах. Видеокарты, рассчитанные на 1.5 В, не работают в 3.3 В слотах, и наоборот. Но существуют универсальные разъемы, которые поддерживают оба типа плат. Некоторые новые видеокарты из последних AGP серий, такие как NVIDIA GeForce 6 серии и ATI X800, имеют специальные ключи, не позволяющие установить их в старые системные платы без поддержки 1.5 В, а последние AGP карты с поддержкой 3.3 В — это NVIDIA GeForce FX 5×00 и часть из ATI RADEON 9×00, кроме основанных на R360.

Видеокарты, рассчитанные на 1.5 В, не работают в 3.3 В слотах, и наоборот. Но существуют универсальные разъемы, которые поддерживают оба типа плат. Некоторые новые видеокарты из последних AGP серий, такие как NVIDIA GeForce 6 серии и ATI X800, имеют специальные ключи, не позволяющие установить их в старые системные платы без поддержки 1.5 В, а последние AGP карты с поддержкой 3.3 В — это NVIDIA GeForce FX 5×00 и часть из ATI RADEON 9×00, кроме основанных на R360.

При апгрейде старой AGP системы обязательно нужно учитывать возможную несовместимость разных версий слотов AGP. Бывает, что никаких проблем не возникает, но перед модернизацией видеосистемы стоит ознакомиться со статьей:

Краткая выжимка из этой статьи: новые видеокарты в старые системные платы можно пробовать вставлять без особого риска, в крайнем случае, система просто не заработает, в отличие от попытки установки старых видеокарт на новую материнскую плату, что может иметь печальные последствия. Для установки новых видеоплат на устаревшую системную, имеющую разъема AGP 1. 0, нужно, чтобы новая видеокарта имела универсальный разъем AGP 1.0/2.0:

0, нужно, чтобы новая видеокарта имела универсальный разъем AGP 1.0/2.0:

Но если новая видеокарта имеет разъем AGP 2.0, то заставить ее работать на старой системе не получится.

AGP 3.0 видеокарты имеют такой же разъем, как показан выше, и их можно устанавливать на материнские платы со слотом AGP 2.0. Существуют и видеокарты AGP 3.0 с универсальным разъемом, которые можно устанавливать в том числе и на системную плату с портом AGP 1.0.

Несмотря на то, что версии AGP действительно сильно отличаются друг от друга по теоретическим показателям, таким, как пропускная способность, более старый и медленный интерфейс тормозить работу видеокарты будет не сильно, разница в производительности в играх при режимах AGP 4x и AGP 8x составляет лишь несколько процентов, а то и еще меньше:

NVIDIA GeForce4 Ti 4200 with AGP8x (NV28) и GeForce4 MX 440 with AGP8x (NV18)

Посмотрите — теоретическая разница в пропускной способности отличается в два раза, но практические результаты тестов показывают отсутствие значительного преимущества AGP 8x решений по сравнению с AGP 4x вариантами.

Нужно отметить, что в переходный период смены слотов AGP на PCI Express выходили системные платы с гибридными решениями, предоставляющими так называемые слоты AGP Express. Эти слоты зачастую размещались совместно с PCI Express x16 слотом, но они не являются полноценными AGP слотами и работают на скорости обычных PCI слотов, что дает очень низкую скорость, позволяющую разве что переждать время перехода на полноценное PCI Express решение.

Про подобный продукт можно прочитать в статье:

Тестирование AGP-Express в исполнении ECS

Вообще же, видеокарты, рассчитанные на морально и физически устаревший слот AGP, в наших статьях не рассматриваются, поэтому мы ограничимся лишь написанным выше текстом и ссылкой на последние тесты AGP видеокарт на iXBT.com.

Последние из Могикан на базе AGP: GeForce 7800 GS, RADEON X1600 PRO, X1300

PCI Express

PCI Express (PCIe или PCI-E, не путать с PCI-X), ранее известная как Arapaho или 3GIO, отличается от PCI и AGP тем, что это последовательный, а не параллельный интерфейс, что позволило уменьшить число контактов и увеличить пропускную способность. PCIe — это лишь один из примеров перехода от параллельных шин к последовательным, вот другие примеры этого движения: HyperTransport, Serial ATA, USB и FireWire. Важное преимущество PCI Express в том, что он позволяет складывать несколько одиночных линий в один канал для увеличения пропускной способности. Многоканальность последовательного дизайна увеличивает гибкость, медленным устройствам можно выделять меньшее количество линий с малым числом контактов, а быстрым — большее.

PCIe — это лишь один из примеров перехода от параллельных шин к последовательным, вот другие примеры этого движения: HyperTransport, Serial ATA, USB и FireWire. Важное преимущество PCI Express в том, что он позволяет складывать несколько одиночных линий в один канал для увеличения пропускной способности. Многоканальность последовательного дизайна увеличивает гибкость, медленным устройствам можно выделять меньшее количество линий с малым числом контактов, а быстрым — большее.

Интерфейс PCIe пропускает данные на скорости 250 Мбайт/с на одну линию, что почти вдвое превышает возможности обычных слотов PCI. Максимально поддерживаемое слотами PCI Express количество линий — 32, что дает пропускную способность 8 ГБ/с. А PCIe слот с восемью рабочими линиями примерно сопоставим по этому параметру с быстрейшей из версий AGP —. Что еще больше впечатляет при учете возможности одновременной передачи в обоих направлениях на высокой скорости. Наиболее распространенные слоты PCI Express x1 дают пропускную способность одной линии (250 Мбайт/с) в каждом направлении, а PCI Express x16, который применяется для видеокарт, и в котором сочетается 16 линий, обеспечивает пропускную способность до 4 ГБ/с в каждом направлении.

Несмотря на то, что соединение между двумя PCIe устройствами иногда собирается из нескольких линий, все устройства поддерживают одиночную линию, как минимум, но опционально могут работать с большим их количеством. Физически, карты расширения PCIe входят и работают нормально в любых слотах с равным или большим количеством линий, так, PCI Express x1 карта будет спокойно работать в x4 и x16 разъемах. Также, слот физически большего размера может работать с логически меньшим количеством линий (например, на вид обычный x16 разъем, но разведены лишь 8 линий). В любом из приведенных вариантов, PCIe сам выберет максимально возможный режим, и будет нормально работать.

Чаще всего для видеоадаптеров используются разъемы x16, но есть платы и с x1 разъемами. А большая часть системных плат с двумя слотами PCI Express x16, работает в режиме x8 для создания SLI и CrossFire систем. Физически другие варианты слотов, такие как x4, для видеокарт не используются. Напоминаю, что всё это относится только к физическому уровню, попадаются и системные платы с физическими PCI-E x16 разъемами, но в реальности с разведенными 8, 4 или даже 1 каналами. И любые видеокарты, рассчитанные на 16 каналов, работать в таких слотах будут, но с меньшей производительностью. Кстати, на фотографии выше показаны слоты x16, x4 и x1, а для сравнения оставлен и PCI (снизу).

И любые видеокарты, рассчитанные на 16 каналов, работать в таких слотах будут, но с меньшей производительностью. Кстати, на фотографии выше показаны слоты x16, x4 и x1, а для сравнения оставлен и PCI (снизу).

Хотя разница в играх получается не такой уж и большой. Вот, например, обзор двух системных плат на нашем сайте, в котором исследуется разница в скорости трехмерных игр на двух системных платах, пара тестовых видеокарт в которых работает в режимах 8 каналов и 1 канала соответственно:

http://www.ixbt.com/mainboard/foxconn/foxconn-mcp61vm2ma-rs2h-mcp61sm2ma-ers2h.shtml

Интересующее нас сравнение — в конце статьи, обратите внимание на две последние таблицы. Как видите, разница при средних настройках весьма небольшая, но в тяжелых режимах начинает увеличиваться, причем, большая разница отмечена в случае менее мощной видеоплаты. Примите это к сведению.

PCI Express отличается не только пропускной способностью, но и новыми возможностями по энергопотреблению. Эта необходимость возникла потому, что по слоту AGP 8x (версия 3. 0) можно передать не более 40 с небольшим ватт суммарно, чего уже не хватало видеокартам последних поколений, рассчитанных для AGP, на которых устанавливали по одному или двух стандартным четырехконтактным разъемам питания (NVIDIA GeForce 6800 Ultra). По разъему PCI Express можно передавать до 75 Вт, а дополнительные 75 Вт получают по стандартному шестиконтактному разъему питания (см. последний раздел этой части). В последнее время появились видеокарты с двумя такими разъемами, что в сумме дает до 225 Вт.

0) можно передать не более 40 с небольшим ватт суммарно, чего уже не хватало видеокартам последних поколений, рассчитанных для AGP, на которых устанавливали по одному или двух стандартным четырехконтактным разъемам питания (NVIDIA GeForce 6800 Ultra). По разъему PCI Express можно передавать до 75 Вт, а дополнительные 75 Вт получают по стандартному шестиконтактному разъему питания (см. последний раздел этой части). В последнее время появились видеокарты с двумя такими разъемами, что в сумме дает до 225 Вт.

PCI Express 2.0

Не так давно, группой PCI-SIG, которая занимается разработкой соответствующих стандартов, были представлены основные спецификации PCI Express 2.0. Вторая версия PCIe вдвое увеличивает стандартную пропускную способность, с 2.5 Гб/с до 5 Гб/с, так что разъем x16 позволяет передавать данные на скорости до 8 ГБ/с в каждом направлении. При этом PCIe 2.0 совместим с PCIe 1.1, старые карты расширения будут нормально работать в новых системных платах, появление которых ожидается уже в 2007 году.

Спецификация PCIe 2.0 поддерживает как 2.5 Гб/с, так и 5 Гб/с скорости передачи, это сделано для обеспечения обратной совместимости с существующими PCIe 1.0 и 1.1 решениями. Обратная совместимость PCI Express 2.0 позволяет использовать прошлые решения с 2.5 Гб/с в 5.0 Гб/с слотах, которые просто будут работать на меньшей скорости. А устройство, разработанное по спецификациям версии 2.0, может поддерживать 2.5 Гб/с и/или 5 Гб/с скорости.

Основное нововведение в PCI Express 2.0 — это удвоенная до 5 Гб/с скорость, но это не единственное изменение, есть и другие нововведения для увеличения гибкости, новые механизмы для программного управления скоростью соединений и т.п. Нас больше всего интересуют изменения, связанные с электропитанием устройств, так как требования видеокарт к питанию неуклонно растут. В PCI-SIG разработали новую спецификацию для обеспечения увеличивающегося энергопотребления графических карт, она расширяет текущие возможности энергоснабжения до 225/300 Вт на видеокарту. Для поддержки этой спецификации используется новый 2×4-штырьковый разъем питания, предназначенный для обеспечения питанием будущие модели видеокарт.

Для поддержки этой спецификации используется новый 2×4-штырьковый разъем питания, предназначенный для обеспечения питанием будущие модели видеокарт.

PCI Express External

И уже в этом году, группа PCI-SIG, занимающаяся официальной стандартизацией решений PCI Express, объявила о принятии спецификации PCI Express External Cabling 1.0, описывающих стандарт передачи данных по внешнему интерфейсу PCI Express 1.1. Эта версия позволяет передавать данные со скоростью 2.5 Гб/с, а следующая должна увеличить пропускную способность до 5 Гб/с. В рамках стандарта представлены четыре внешних разъема: PCI Express x1, x4, x8 и x16. Старшие разъемы оснащены специальным язычком, облегчающим подключение.

Внешний вариант интерфейса PCI Express может использоваться не только для подключения внешних видеокарт, но и для внешних накопителей и других плат расширения. Максимальная рекомендованная длина кабеля при этом равна 10 метров, но её можно увеличить при помощи соединения кабелей через повторитель.

Чем это может быть полезно для видеокарт? Например, это точно может облегчить жизнь любителей ноутбуков, при работе от батарей будет использоваться маломощное встроенное видеоядро, а при подключении к настольному монитору — мощная внешняя видеокарта. Значительно облегчится апгрейд подобных видеокарт, не нужно будет вскрывать корпус ПК. Производители смогут делать совершенно новые системы охлаждения, не ограниченные особенностями карт расширения, да и с питанием должно быть меньше проблем — скорее всего, будут использоваться внешние блоки питания, рассчитанные специально на определенную видеокарту, их можно в один внешний корпус с видеокартой встроить, используя одну систему охлаждения. Должна облегчиться сборка систем на нескольких видеокартах (SLI/CrossFire). В общем, с учетом постоянного роста популярности мобильных решений, такие внешние PCI Express должны завоевать определенную популярность.

В статье мы не трогаем устаревшие интерфейсы, их характеристики действительно сильно влияли на производительность даже в старые времена. Затем производители перешли на производство видеокарт, рассчитанных на интерфейс AGP (Accelerated Graphics Port), но его первой спецификации оказалось недостаточно, AGP 1.0 в некоторых случаях мог ограничивать производительность. Поэтому в дальнейшем стандарт модифицировали, версии 2.0 (AGP 4x) и 3.0 (AGP 8x) уже достигли высоких значений пропускной способности, выше которых скорость просто не росла.

Затем производители перешли на производство видеокарт, рассчитанных на интерфейс AGP (Accelerated Graphics Port), но его первой спецификации оказалось недостаточно, AGP 1.0 в некоторых случаях мог ограничивать производительность. Поэтому в дальнейшем стандарт модифицировали, версии 2.0 (AGP 4x) и 3.0 (AGP 8x) уже достигли высоких значений пропускной способности, выше которых скорость просто не росла.

Абсолютное большинство современных видеоплат рассчитано на интерфейс PCI Express, поэтому при выборе видеокарты мы предлагаем серьезно рассматривать только его, все данные о AGP приведены для справки. Хотя производители видеокарт по своей инициативе делают карты среднего уровня для интерфейса AGP (ATI RADEON X1950 PRO, NVIDIA GeForce 7800 GS и 7600 GT) до сих пор, но все они используют специальный мост для трансляции вызовов PCI Express в AGP, а новых видеочипов с поддержкой AGP давно не существует.

Итак, новые платы используют интерфейс PCI Express x16, объединяющий скорость 16 линий PCI Express, что дает пропускную способность до 4 ГБ/с в каждом направлении, это примерно в два раза больше, по сравнению с той же характеристикой AGP 8x. Важное отличие состоит в том, что PCI Express работает с такой скоростью в каждом из направлений, поэтому в некоторых случаях PCI Express может дать преимущества по сравнению с AGP. Но чаще всего пропускной способности стандарта AGP 8x достаточно, и разницы с соответствующими картами для PCI Express просто нет, разные версии видеокарт работают примерно с одной скоростью, что на AGP, что на PCI Express. Например, RADEON 9600 XT и RADEON X600 XT, для AGP и PCI Express, соответственно.

Важное отличие состоит в том, что PCI Express работает с такой скоростью в каждом из направлений, поэтому в некоторых случаях PCI Express может дать преимущества по сравнению с AGP. Но чаще всего пропускной способности стандарта AGP 8x достаточно, и разницы с соответствующими картами для PCI Express просто нет, разные версии видеокарт работают примерно с одной скоростью, что на AGP, что на PCI Express. Например, RADEON 9600 XT и RADEON X600 XT, для AGP и PCI Express, соответственно.

Другое дело, что будущего у AGP давно нет, и этот интерфейс следует рассматривать только с точки зрения апгрейда, все новые системные платы поддерживают только PCI Express, наиболее производительные видеокарты с интерфейсом AGP не выпускаются, а те, что есть, труднее найти в продаже. Если речь о покупке новой платы или одновременной смене системной и видеоплаты, то просто необходимо покупать карты с интерфейсом PCI Express, он будет наиболее распространен еще несколько лет, а его следующая версия будет совместима с нынешней.

Битность и объем памяти современных видеокарт

Если вас интересует замена видеокарты, то, скорее всего, вы задавались вопросом о ее битности. В данной статье мы обсудим этот вопрос и постараемся дать простые рекомендации. О выборе видеокарт мы более подробно поговорили здесь и можем с уверенностью сказать, что при покупке видеоадаптера нужно обращать внимание на три основные составляющие: битность, объем памяти и тип памяти.

Объем памяти

Объем памяти видеокарты может составлять от 512 до 4 Гб. Если вы любите проходить компьютерные игры, то для вас лучшим выбором будет видеокарта с как можно большим количеством памяти, однако имейте ввиду, что аппараты с 3-4 Гб памяти стоят очень дорого, не каждый ПК пользователь сможет себе их позволить. На данный момент оптимальным решением являются видеоадаптеры с 1-2 Гб памяти.

На данный момент оптимальным решением являются видеоадаптеры с 1-2 Гб памяти.

Знайте, что некоторые производители видеокарт оснащают свою продукцию большим объемом памяти (например, 2 и более Гб), при этом изделие стоит не очень дорого. Не купитесь на эту уловку, — такие видеокарты очень слабы и не потянут даже на средних настройках большинство современных игр.

Производители, желая продать свою продукцию, комплектуют некоторые свои изделия излишне большим объемом памяти, который им совсем не нужен. Говоря проще, на видеокарту действительно будет установлено 2 и более Гб памяти, однако большая часть объема использоваться не будет из-за малой пропускной способности (битности) аппарата. Заметили в магазине видеокарту с большим количеством гигабайт, а цена удивительно мала? Не спешите покупать!

Битность — шина памяти

Стоит упомянуть и типы памяти, сейчас существуют два основных типа: GDDR-3 и GDDR-5, первый вариант используется в бюджетных видеокартах (как правило не очень мощных), второй же вариант наиболее оптимален (обеспечивает высокую скорость памяти). Если вы подбираете видеоадаптер для игр, то обращайте внимание на экземпляры с памятью GDDR-5.

Если вы подбираете видеоадаптер для игр, то обращайте внимание на экземпляры с памятью GDDR-5.

Еще одной важной характеристикой видеокарты является ее битность (другое название – шина памяти). Сейчас на рынке есть карты с 64, 128, 192, 256, 448, 512 бит.

Говоря о битности видеокарт, для лучшего понимания, представьте себе бутылку с горлышком. Жидкость в емкости является объемом данных, а горлышко — это сама шина. Чем шире горлышко, тем быстрее выльется жидкость, в случае видеокарты будет проходить больший объем данных.

64-битной шиной комплектуются видеоадаптеры предназначенные для офисного использования, т.е. если вы хотите проходить игры на более-менее высоких настройках графики, то данные видеокарты не для вас, они слишком слабы.

Карты со 128-битной шиной уже более подходящий выбор для геймеров, которые имеют ограниченный бюджет для покупки новой видеокарты. Чтобы получить наибольшую производительность, покупайте 128 битную карту только с памятью GDDR-5.

256 бит — это оптимальный вариант для любителей игр, данная пропускная способность позволит наиболее эффективно реализовать потенциал видеокарты. Если ваш бюджет позволяет, то мы рекомендуем покупать аппараты именно с 256 битной шиной.

448, 512 бит – такой пропускной способностью обладают видеокарты только высшего ценового диапазона, они стоят очень дорого и позволить их смогут только обеспеченные геймеры.

Отсюда следует простое правило: чем выше битность у видеокарты, тем лучше, при условии, что вы покупаете ее для игр, если вы не планируете играть, то вам вполне подойдет и 64-битный вариант.

Подведем итог: если ваш бюджет позволяет, то берите 448-битные и более видеокарты, 128-битные карты покупайте только с GDDR-5 памятью, оптимальным вариантом являются карты с 256 бит.

Пропускная способность видеопамяти ОЗУ

Пропускная способность видеопамяти ОЗУ

Основы пропускной способности памяти

Одна из главных вещей, которые нужно учитывать при выборе

видеокарта

это пропускная способность памяти

видео RAM. Пропускная способность памяти — это в основном скорость видеопамяти. Это измеряется в

гигабайт в секунду (ГБ / с). Чем больше у вас пропускная способность памяти, тем лучше.

Видеокарта с более высокой пропускной способностью памяти может рисовать быстрее и потреблять больше

качественные изображения.Но видеокарты — это не только пропускная способность памяти.

Вы также должны учитывать скорость рисования

GPU.

Нет смысла покупать видеокарту с очень быстрым графическим процессором и ограниченными возможностями.

пропускная способность памяти, потому что память будет узким местом. GPU будет

тратить много времени на бездействие в ожидании медленной видеопамяти. Посредством

тот же токен, вы не хотите получать видеокарту с медленным графическим процессором и очень высокой

пропускная способность памяти. Эта страница касается только пропускной способности памяти.

Пропускная способность памяти — это в основном скорость видеопамяти. Это измеряется в

гигабайт в секунду (ГБ / с). Чем больше у вас пропускная способность памяти, тем лучше.

Видеокарта с более высокой пропускной способностью памяти может рисовать быстрее и потреблять больше

качественные изображения.Но видеокарты — это не только пропускная способность памяти.

Вы также должны учитывать скорость рисования

GPU.

Нет смысла покупать видеокарту с очень быстрым графическим процессором и ограниченными возможностями.

пропускная способность памяти, потому что память будет узким местом. GPU будет

тратить много времени на бездействие в ожидании медленной видеопамяти. Посредством

тот же токен, вы не хотите получать видеокарту с медленным графическим процессором и очень высокой

пропускная способность памяти. Эта страница касается только пропускной способности памяти.

Пропускная способность памяти определяется тактовой частотой памяти, типом памяти и

ширина памяти. Тактовая частота памяти — это тактовая частота микросхем памяти. Текущие (2006 г.) микросхемы памяти имеют тактовую частоту от 167 до 167 Гц.

МГц

к

1000 МГц. Наиболее распространенный тип памяти — удвоенная скорость передачи данных.

(ГДР)

это означает, что он передает два значения памяти для каждого цикла тактовой частоты памяти.

Существуют также другие типы DDR, такие как DDR2, GDDR3 и GDDR4, и они также

передача с удвоенной тактовой частотой памяти.Некоторые очень старые видеокарты все еще используют

единая скорость передачи данных (SDR), которая передает одно значение за такт. Память

ширина обычных карт колеблется от 32 бит до 256 бит. Максимум

Теоретическая пропускная способность памяти является продуктом тактовой частоты памяти,

передачи за такт в зависимости от типа памяти и ее ширины. Для

Например, видеокарта с видеопамятью DDR 200 МГц и шириной 128 бит имеет

полоса пропускания 200 МГц умноженная на 2 раза по 128 бит, что дает 6,4

ГБ / с.

Эта таблица содержит видеопамять.

пропускная способность для многих видеокарт в своем

Колонка скорости RAM.

Текущие (2006 г.) микросхемы памяти имеют тактовую частоту от 167 до 167 Гц.

МГц

к

1000 МГц. Наиболее распространенный тип памяти — удвоенная скорость передачи данных.

(ГДР)

это означает, что он передает два значения памяти для каждого цикла тактовой частоты памяти.

Существуют также другие типы DDR, такие как DDR2, GDDR3 и GDDR4, и они также

передача с удвоенной тактовой частотой памяти.Некоторые очень старые видеокарты все еще используют

единая скорость передачи данных (SDR), которая передает одно значение за такт. Память

ширина обычных карт колеблется от 32 бит до 256 бит. Максимум

Теоретическая пропускная способность памяти является продуктом тактовой частоты памяти,

передачи за такт в зависимости от типа памяти и ее ширины. Для

Например, видеокарта с видеопамятью DDR 200 МГц и шириной 128 бит имеет

полоса пропускания 200 МГц умноженная на 2 раза по 128 бит, что дает 6,4

ГБ / с.

Эта таблица содержит видеопамять.

пропускная способность для многих видеокарт в своем

Колонка скорости RAM. Если

вы посмотрите на эти пропускные способности памяти, вы увидите, насколько они различаются

между быстрыми видеокартами и медленными.

Если

вы посмотрите на эти пропускные способности памяти, вы увидите, насколько они различаются

между быстрыми видеокартами и медленными.

Будьте осторожны с шириной памяти при покупке младших видеокарт!

Если вы проверите таблицу видеокарты

внимательно, вы заметите, что есть некоторые видеокарты низкого уровня, которые могут

поставляются с шириной памяти 64 или 128 бит. Также есть несколько карточек

который может иметь ширину 32 или 64 бита. Например, Radeon 9550

поставляется как в 128-битной модели

и 64-битная модель.В

компании проектируют

Графические процессоры

для поддержки определенной ширины памяти. Ширина памяти соответствует потребностям

графического процессора. К сожалению, производители видеокарт часто делают немного дешевле.

модели, которые используют более дешевую видеопамять, которая использует только половину ширины

доступно на GPU. Это сокращает пропускную способность памяти вдвое и почти вдвое.

всегда серьезно вредит производительности видеокарты. Эти «полуширины»

модели обычно проводят много времени с графическим процессором, ничего не делая в ожидании

чтобы медленная видеопамять отреагировала.На самом деле печально то, что

карты полной ширины обычно лишь немного дороже, чем карты половинной ширины.

открытки. Карты половинной ширины, как правило, очень плохая сделка, если вам вообще не все равно.

о производительности. К сожалению, многие сайты, продающие это видео

карты не сообщают вам ширину памяти и не дают неверное значение. я не

просто говорю о сайтах-однодневках. Некоторые из крупнейших веб-сайтов,

список ширины памяти часто перечисляет значение полной ширины даже для полуширины

версии видеокарты.А если вы покупаете видеокарты в рознице

храните, читая спецификации на коробке, у вас все еще есть проблемы, потому что

большинство карт половинной ширины вообще не указывают ширину своей памяти.

Эти «полуширины»

модели обычно проводят много времени с графическим процессором, ничего не делая в ожидании

чтобы медленная видеопамять отреагировала.На самом деле печально то, что

карты полной ширины обычно лишь немного дороже, чем карты половинной ширины.

открытки. Карты половинной ширины, как правило, очень плохая сделка, если вам вообще не все равно.

о производительности. К сожалению, многие сайты, продающие это видео

карты не сообщают вам ширину памяти и не дают неверное значение. я не

просто говорю о сайтах-однодневках. Некоторые из крупнейших веб-сайтов,

список ширины памяти часто перечисляет значение полной ширины даже для полуширины

версии видеокарты.А если вы покупаете видеокарты в рознице

храните, читая спецификации на коробке, у вас все еще есть проблемы, потому что

большинство карт половинной ширины вообще не указывают ширину своей памяти.

Итак, вопрос в том, как определить, покупаете ли вы полуширины или

карта во всю ширину? Некоторые производители достаточно любезны, чтобы предоставить точные

спецификации, которые обеспечивают тактовую частоту и ширину памяти. Так что самый безопасный

способ быть уверенным — поискать именно ту модель, которая вас интересует, на

на сайте производителя и ознакомьтесь с техническими характеристиками.Говоря от

опыта, с низкими картами у вас есть примерно 50/50 шансов получить

необходимую информацию с сайта производителя. И если

информация есть на сайтах производителя, все равно не всегда можно доверять

Это. Я видел несколько сайтов производителей, на которых

значение полной ширины для некоторых моделей половинной ширины. Сомневаюсь, что это сделано специально. Это

обычно просто выглядит ошибкой. Вы также должны быть осторожны, когда

чтение спецификаций видеокарты, потому что многие вещи, которые звучат как

ширина видеопамяти на самом деле тут ни при чем.Ни один из

следующие описания имеют какое-либо отношение к размеру памяти.

Так что самый безопасный

способ быть уверенным — поискать именно ту модель, которая вас интересует, на

на сайте производителя и ознакомьтесь с техническими характеристиками.Говоря от

опыта, с низкими картами у вас есть примерно 50/50 шансов получить

необходимую информацию с сайта производителя. И если

информация есть на сайтах производителя, все равно не всегда можно доверять

Это. Я видел несколько сайтов производителей, на которых

значение полной ширины для некоторых моделей половинной ширины. Сомневаюсь, что это сделано специально. Это

обычно просто выглядит ошибкой. Вы также должны быть осторожны, когда

чтение спецификаций видеокарты, потому что многие вещи, которые звучат как

ширина видеопамяти на самом деле тут ни при чем.Ни один из

следующие описания имеют какое-либо отношение к размеру памяти.

- 128-битная точность цвета с плавающей запятой обеспечивает больший диапазон цветов и яркости

- Высокооптимизированный 128-битный 2D-движок с поддержкой новых расширений WindowsXP GDI

- 128-битная точность студийного качества с плавающей запятой на всем графическом конвейере

- Встроенная поддержка 128-битных режимов рендеринга с плавающей запятой, 64-битных с плавающей запятой и 32-битных целочисленных режимов.

- Настоящая 128-битная студийная точность цвета

- 256-битная графическая архитектура

- 64-битная фильтрация и смешивание текстур с плавающей запятой

- Частота ядра 250 МГц

- 3.Скорость заполнения 8 миллиардов текселей / сек

Все последующие описания относятся к системам видеопамяти.

| Описание | Тип памяти | Тактовая частота памяти | Ширина памяти | Пропускная способность |

|---|---|---|---|---|

| 64/128-битный расширенный интерфейс памяти | ? | ? | 64 бит или 128 бит | ? |

| 128-битный расширенный интерфейс памяти | ? | ? | 128 бит | ? |

| 16/32 МБ SDRAM | SDR | ? | ? | ? |

| 128/256 МБ DDR SDRAM | DDR | ? | ? | ? |

| Частота памяти 400 МГц | ? | 400 МГц | ? | ? |

8. Пропускная способность памяти 0 ГБ / сек (128 бит, 500 МГц) Пропускная способность памяти 0 ГБ / сек (128 бит, 500 МГц) | DDR | 250 МГц | 128 бит | 8,0 ГБ / с |

| Пропускная способность памяти 30,4 ГБ / сек | ? | ? | ? | 30,4 ГБ / с |

Во многих случаях вы можете определить ширину памяти, внимательно изучив

изображения видеокарты, доступные на многих сайтах

которые их продают. Newegg, например,

обычно показывает картинки обеих сторон видеокарты.Вы также можете часто

используйте Google, чтобы найти в Интернете обзоры

видеокарта, которая включает в себя изображения крупным планом. Но чтобы найти память

ширину из изображений, вам нужно узнать некоторую загадочную информацию о графических процессорах,

печатные платы и упаковка RAM. Если ты не хочешь этому учиться

(интересно только компьютерным фанатам) информации, тогда вам стоит просто попытаться найти

модель, у которой есть информация о ширине памяти на сайте производителя. Но

если у вас ограниченный выбор карточек, вы можете застрять, узнав, как

чтобы определить ширину памяти, внимательно посмотрев на карту.Это, как правило,

младшие видеокарты, которые не раскрывают свою истинную пропускную способность памяти. Если

вы покупаете недорогую карту, тогда вам определенно нужно быть осторожным, чтобы избежать

модели половинной ширины. Во-первых, эти карты не так быстры, и

последнее, что вам нужно, — это усугубить ситуацию, купив карту с малым объемом памяти

пропускная способность.

Но

если у вас ограниченный выбор карточек, вы можете застрять, узнав, как

чтобы определить ширину памяти, внимательно посмотрев на карту.Это, как правило,

младшие видеокарты, которые не раскрывают свою истинную пропускную способность памяти. Если

вы покупаете недорогую карту, тогда вам определенно нужно быть осторожным, чтобы избежать

модели половинной ширины. Во-первых, эти карты не так быстры, и

последнее, что вам нужно, — это усугубить ситуацию, купив карту с малым объемом памяти

пропускная способность.

Остальная часть этого раздела носит технический характер, поэтому вам, вероятно, следует только

продолжайте, если вы не можете найти нужную информацию на

сайт производителя (или просто любите быть предельно осторожными при покупке

вещи).Первое, что вам нужно знать, это как выглядит видеопамять. А

На видеокарте много кремниевых микросхем, но только некоторые из них являются микросхемами ОЗУ. В

На рисунках ниже микросхемы ОЗУ отмечены зеленым знаком «X».

На видеокарте обычно четыре или восемь микросхем ОЗУ, но некоторые очень У младших карт их всего одна-две. Иногда оперативная память все чипы находятся на лицевой стороне карты, а в других случаях — половина чипов RAM находятся спереди, а половина — сзади. Все микросхемы ОЗУ идентичный.Их легко идентифицировать, потому что они расположены очень близко к GPU. Графический процессор — это большой чип с большим радиатором и часто с вентилятором. Некоторые высокопроизводительные видеокарты также имеют радиаторы, закрывающие чипы оперативной памяти. В такие случаи, вам просто нужно идти по спецификациям производителя так как вы не можете увидеть фишки на изображениях.

Теперь вам нужно проверить пакеты микросхем RAM. «Пакет» относится к черная пластиковая упаковка, в которой заключен чип. На изображениях ниже показаны наиболее распространенные пакеты микросхем RAM.

Вам нужно проверить, какой тип упаковки используют чипы RAM. TSOP (тонкие маленькие наброски пакета) имеют булавки (маленькие металлические провода, торчащие по бокам черная пластиковая часть) на противоположных сторонах упаковки. TSOP 66 состоит из 66 булавки и очень распространенная упаковка. TSOP 86 имеет 86 контактов и намного меньше общий. Возможно, вам придется внимательно посмотреть изображения видеокарты и посчитайте булавки, чтобы понять, на какой из них вы смотрите.TQFP 100 (тонкий quad flat pack) упаковка имеет в общей сложности 100 контактов, торчащих со всех четырех сторон своего пакета. BGA 144 (сетка шариков) на самом деле не имеет контактов что вы можете видеть. Под корпусом 144 шарика припоя, но это нетрудно идентифицировать пакеты BGA, потому что это просто небольшие пакеты с никаких видимых штифтов.

Причина, по которой вам нужно распознать пакет чипа, заключается в том, что он помогает вам угадайте, насколько «широкая» микросхема ОЗУ. Чипы ОЗУ — это определенное количество бит широкий.Наиболее распространенные микросхемы оперативной памяти, используемые сейчас (конец 2006 г.), 16-битные или 32 бита. Обычно они обозначаются как «x16» и «x32», которые произносится «на 16» и «на 32». Единственный способ быть абсолютно уверенным в ширина чипа RAM должна считывать номер производителя с верхней части чип, а затем найдите его (обычно довольно легко с Google). Но виды картинок вы поиск на веб-сайтах редко бывает достаточно точным, чтобы позволить вам читать числа, поэтому вы застряли в догадках о ширине ОЗУ, глядя на пакеты.TSOP 66 может иметь максимальную ширину 16 бит. TSOP 66 иногда может быть 8 бит, но это очень редко для видеокарт любого типа, который вы, вероятно, столкнуться. Если вы смотрите на TSOP 66 на видеокарте, построенной примерно с 2000, это почти наверняка чип ОЗУ x16. TSOP 66 является «стандартным» x16 RAM, поэтому он очень распространен. TSOP 86 встречается гораздо реже и обычно чип x32. TQFP 100 почти всегда представляет собой микросхему x32. Пакеты BGA могут немного различаются, но BGA RAM на видеокартах почти всегда x32.Так что если ты если посмотреть на TSOP 66, то, вероятно, это чип x16. Если у вас есть другие три пакета, показанных выше, вероятно, это микросхема x32. Если у вас есть что-нибудь иначе, тогда вам просто нужно обойтись тем, что вы можете найти на сайт производителя.

Чтобы выяснить общую ширину памяти практически всех современных видеокарт, все вам нужно умножить ширину каждой RAM на общее количество RAM. фишки на карте. К сожалению, есть исключения из «умножения». правило, но они довольно редки.Некоторые очень старые видеокарты не следуют это правило, но вы все равно не должны их покупать. Еще одно исключение — это карта, где правило умножения дает результат, вдвое превышающий максимальный количество бит, поддерживаемых графическим процессором. В этом случае, конечно, настоящая память ширина — это максимальное количество бит, поддерживаемое графическим процессором. Этот случай подходит иногда, когда производитель использует одну и ту же печатную плату для двух моделей: один с определенным объемом ОЗУ (например, 128 МБ), а другой с вдвое большим объем оперативной памяти (например, 256 МБ), но обе модели поддерживают максимальную ширину памяти.

Если вы рассматриваете недорогие карты, есть один очень распространенный случай, когда Берегись. На изображении выше показана видеокарта GeForce FX 5700 LE со 128 мегабайтами. видеопамяти. У этой конкретной карты есть две модели: 128 МБ модель и модель 256 МБ. Оно имеет место для восьми микросхем ОЗУ на печатной плате, но модель 128 МБ использует только четыре микросхемы ОЗУ. Модель 256 МБ имеет все восемь микросхем оперативной памяти. Если вы проверите Столбец ширины ОЗУ в таблице видеокарты, вы увидите, что ширина FX 5700 LE может быть 64 бит или 128 бит.Многие производители просто сделайте одну печатную плату, чтобы сделать модели на 128 и 256 МБ. Затем они включают только четыре микросхемы ОЗУ, чтобы сделать карты на 128 МБ. К несчастью, это уменьшает ширину памяти вдвое во всех примерах, которые мне удалось проверить. Карта, показанная выше, является картой шириной 64 бита. Чрезвычайно часто можно найти веб-сайты, продающие версию на 128 МБ, которые утверждают, что это карта шириной 128 бит даже если это на самом деле 64 бита. Вы также часто встречаетесь с этим случаем с GeForce FX 5200s, Radeon 9200s, Radeon 9250s, Radeon 9550s и другие.

Когда у вас есть ширина памяти, вы можете использовать ее, а также тип памяти и память clock для расчета пиковой пропускной способности памяти. Если вы смотрите видео карта с двумя разной шириной памяти, то она определенно стоит проблема, чтобы убедиться, что вы знаете, что получаете. Маркетинг спецификации на модели с меньшей емкостью памяти редко выходят за рамки их способ указать на недостатки этой модели. Если маркетинг информация не указывает четко пропускную способность памяти, тогда вы обычно можете предполагать худшее.А если вы ищете недорогие видеокарты, будьте абсолютно обязательно избегайте моделей с половиной максимальной ширины памяти. Карты с половина пропускной способности памяти обычно немного дешевле, но их производительность намного ниже.

HyperMemory и TurboCache