Программы для скачивания сайта целиком

Программы для скачивания сайта целиком

В интернете хранится множество полезной информации, к которой необходим практически постоянный доступ для некоторых пользователей. Но не всегда есть возможность подключиться к сети и зайти на нужный ресурс, а копировать содержание через такую функцию в браузере или перемещать данные в текстовый редактор не всегда удобно и конструкция сайта теряется. В таком случае на помощь приходит специализированный софт, который предназначен для локального хранения копий определенных веб-страниц.

Teleport Pro

Данная программа оснащена только самым необходимым набором функций. В интерфейсе нет ничего лишнего, а само главное окно разделено на отдельные части. Создавать можно любое количество проектов, ограничиваясь только вместительностью жесткого диска. Мастер создания проектов поможет правильно настроить все параметры для скорейшего скачивания всех необходимых документов.

Teleport Pro распространяется платно и не имеет встроенного русского языка, но он может пригодится только при работе в мастере проекта, с остальным можно разобраться даже без знания английского.

Local Website Archive

У этого представителя уже имеется несколько приятных дополнений в виде встроенного браузера, который позволяет работать в двух режимах, просматривая онлайн страницы или сохраненные копии сайтов. Еще присутствует функция печати веб-страниц. Они не искажаются и практически не изменяются в размере, поэтому на выходе пользователь получает почти идентичную текстовую копию. Радует возможность помещения проекта в архив.

Остальное все очень схоже с другими подобными программами. Во время скачивания пользователь может мониторить состояние файлов, скорость загрузки и отслеживать ошибки, если они имеются.

Website Extractor

Website Extractor отличается от других участников обзора тем, что разработчики подошли немного по-новому к составлению главного окна и распределению функций по разделам.

Опытным пользователям понравится широкий набор различных настроек проекта, начиная от фильтрации файлов и лимитов уровней ссылок, и заканчивая редактированием прокси-сервера и доменов.

Web Copier

Ничем не примечательная программа для сохранения копий сайтов на компьютере. В наличии стандартный функционал: встроенный браузер, мастер создания проектов и подробная настройка. Единственное, что можно отметить – поиск файлов. Пригодится для тех, кто потерял место, где была сохранена веб-страница.

Для ознакомления есть бесплатная пробная версия, которая не ограничена в функционале, лучше опробовать ее перед тем, как покупать полную версию на официальном сайте разработчиков.

WebTransporter

В WebTransporter хочется отметить ее абсолютно бесплатное распространение, что редкость для подобного софта. В ней присутствует встроенный браузер, поддержка скачивания нескольких проектов одновременно, настройка соединения и ограничения по объему загруженной информации или размерам файлов.

Скачивание происходит в несколько потоков, настройка которых осуществляется в специальном окне. Мониторить состояние загрузки можно на главном окне в отведенном размере, где отображается информация о каждом потоке отдельно.

WebZIP

Интерфейс данного представителя выполнен довольно непродуманно, поскольку новые окна не открываются отдельно, а отображаются в главном. Единственное, что спасает – редактирование их размера под себя. Однако данное решение может понравиться некоторым пользователям. Программа отображает скачанные страницы отдельным списком, и доступен их просмотр сразу же во встроенном браузере, который ограничен автоматическим открытием только двух вкладок.

Подходит WebZIP для тех, кто собирается скачивать большие проекты и будет открывать их одним файлом, а не каждую страницу отдельно через HTML документ. Такой просмотр сайтов позволяет выполнять оффлайн браузер.

HTTrack Website Copier

Просто хорошая программа, в которой присутствует мастер создания проектов, фильтрация файлов и дополнительные настройки для продвинутых пользователей. Файлы не скачиваются сразу, а первоначально проводится сканирование всех типов документов, что есть на странице. Это позволяет изучить их еще даже до сохранения на компьютере.

Отслеживать подробные данные о состоянии скачивания можно в главном окне программы, где отображено количество файлов, скорость загрузки, ошибки и обновления. Доступно открытие папки сохранения сайта через специальный раздел в программе, где отображены все элементы.

Список программ еще можно продолжать, но здесь приведены основные представители, которые отлично справляются со своей задачей. Почти все отличаются некоторым набором функций, но одновременно и похожи друг на друга. Если вы выбрали для себя подходящий софт, то не спешите его покупать, протестируйте сначала пробную версию, чтобы точно сформировать мнение о данной программе.

Почти все отличаются некоторым набором функций, но одновременно и похожи друг на друга. Если вы выбрали для себя подходящий софт, то не спешите его покупать, протестируйте сначала пробную версию, чтобы точно сформировать мнение о данной программе.

Отблагодарите автора, поделитесь статьей в социальных сетях.

Как скачать сайт целиком – обзор программ для скачивания сайтов

Доступ в интернет уже давно стал обыденностью, при этом перебои с доступом случаются крайне редко, и открыть нужную страницу можно в любой момент. Вопреки этому, порой возникают ситуации, когда необходимо воспользоваться оффлайн-версией ресурса. В статье ниже предоставим три способа, как целиком скачать сайт на компьютер: постраничное сохранение, онлайн-сервисы и специальные программы.

Скачивание отдельных страниц

Для таких целей не потребуется стороннее ПО или сервис – необходимый инструмент есть в каждом браузере. Этот вариант будет оптимальным, если возникла задача сохранить информацию из опубликованного в интернете материала, чтобы исключить риск ее потери. Инструкция:

Инструкция:

- Открыть страницу в любом браузере.

- Кликнуть по пустой области правой кнопкой.

- Выбрать пункт «Сохранить как».

Указать место в памяти компьютера. Важно, чтобы тип файла был указан «Веб страница полностью». Так будет скачан не только HTML-код, но и графические элементы.

После скачивания отобразится HTML-документ и папка с файлами. Открытие страницы выполняется по двойному нажатию на HTML-документ.

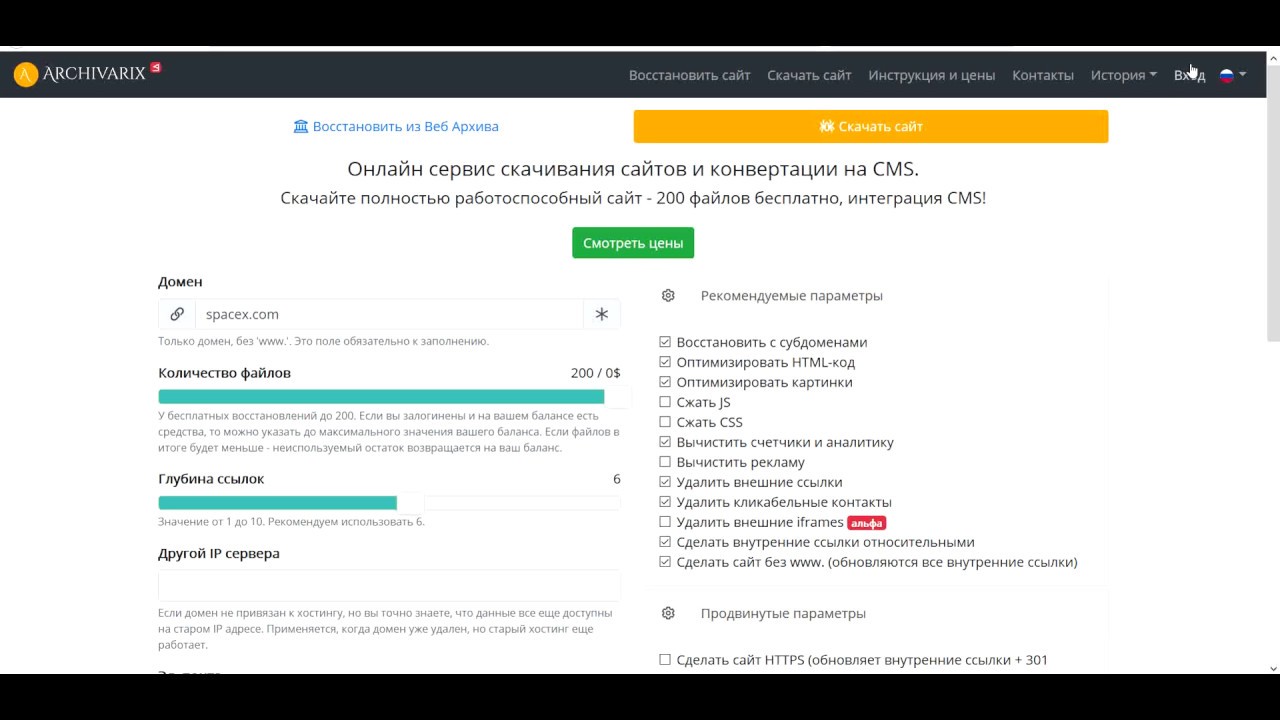

Скачивание через онлайн-сервисы

Когда требуется заполучить большое количество страниц, прибегают к специальным инструментам. Скачать сайт онлайн помогут сервисы, которые называются парсерами. Рассмотрим несколько самых популярных.

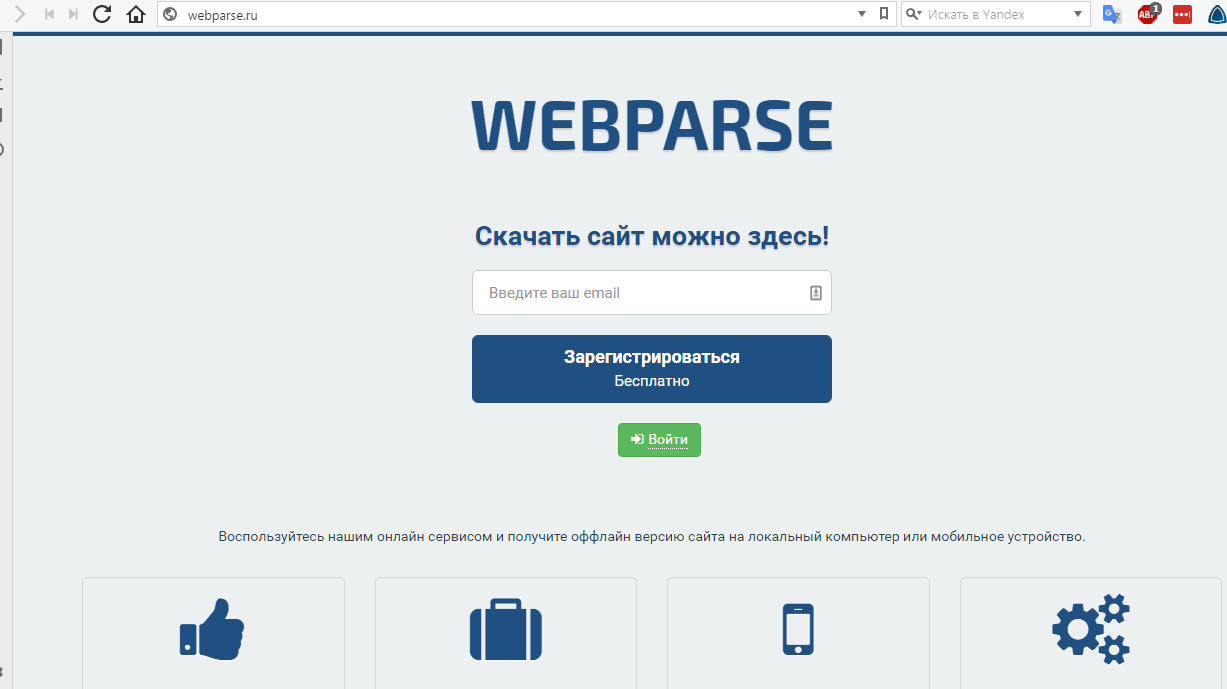

Webparse.ru

Проект примечателен тем, что первый сайт доступен для скачивания бесплатно. Ресурс проводит архивацию всех данных с указанного URL, на выходе пользователь получает готовый HTML, CSS или JS код. Управление инструментарием очень простое, достичь задуманного получится даже с телефона. В настройках выставляется версия сайта для скачивания: полная или мобильная.

Управление инструментарием очень простое, достичь задуманного получится даже с телефона. В настройках выставляется версия сайта для скачивания: полная или мобильная.

На выходе пользователь получает архив, который нужно лишь распаковать в корневую директорию нового сайта. После небольших изменений в настройках получится воспользоваться копией ресурса по новому адресу или открыть на виртуальном сервере (например Denwer).

Web2pdfconvert.com

Ресурс используется для конвертации страниц в PDF-документы. С его помощью получится скачать часть сайта бесплатно, обеспечив сохранность размещенной там информации.

Посетив главную страницу сервиса, потребуется вставить адрес в отведенную для этого строку и нажать «Convert to PDF». По клику на иконку рожкового ключа открываются дополнительные настройки: ширина и высота страницы, задержка в секундах перед преобразованием, отступы, ориентация и прочее. Пользоваться инструментом крайне просто, несмотря на отсутствие русскоязычного интерфейса.

R-tools.org

Основная направленность сервиса заключается в восстановлении сайтов из резервных копий. Однако побочной функцией также является скачивание ресурса целиком. Среди преимуществ можно выделить:

- использование на любой платформе, имеющей выход в интернет;

- при желании оплата производится только за определенное количество страниц;

- быстрый ответ службы поддержки и прямой контакт с создателем сервиса;

- при неудовлетворительном результате скачивания, деньги возвращаются пользователю.

Из недостатков только отсутствие бесплатной версии. Ознакомиться с интерфейсом получится через демо-аккаунт.

Программы для скачивания сайта целиком

Использование специальных программ – это самый функциональный вариант, при необходимости получения полноценной копии всего веб-ресурса. Часть софта распространяется на бесплатной основе, за другой потребуется заплатить. В обоих случаях пользователю предоставляется возможность тонкой настройки параметров сохранения с последующим просмотром сайтов, как при обычном использовании интернета.

В обоих случаях пользователю предоставляется возможность тонкой настройки параметров сохранения с последующим просмотром сайтов, как при обычном использовании интернета.

HTTrack Website Copier

Бесплатная и простая в использовании программа. Позволяет загружать веб-сайты из интернета в локальную папку. При этом создается рекурсивная структура разделов, извлекается HTML, картинки и другие расположенные на сервере документы. HTTrack обеспечивает оригинальную перелинковку, что позволяет просматривать зеркало ресурса в браузере, как будто это делается с использованием сетевого подключения.

В функционал программы также входит обновление уже созданных копий и отображение прерванного скачивания. Софт тонко настраивается, включает интегрированную систему помощи.

Получение установочного пакета доступно на сайте разработчиков. Поддерживаются все версии Windows, начиная с 2000, а также ОС Linux. После запуска HTTrack будет предложено выбрать язык – русский присутствует в списке. Дальше, чтобы скачать веб-сайт, потребуется:

После запуска HTTrack будет предложено выбрать язык – русский присутствует в списке. Дальше, чтобы скачать веб-сайт, потребуется:

- Указать имя нового проекта и его категорию.

- Выбрать папку на диске для сохранения файлов.

В выбранной папке появится файл «index.htm», с помощью которого открывается зеркало сайта.

Cyotek WebCopy

Бесплатная программа для полного или частичного копирования сайта на локальный накопитель. Интерфейс англоязычный. Софт автоматически переназначает ссылки на такие материалы, как стили, картинки и другие страницы, в соответствии с их локальным расположением. Используя тонкие настройки, можно в точности указать, какую часть необходимо скопировать и каким образом это сделать.

WebCopy сканирует HTML метки и пытается отыскать все документы, на которые ссылается ресурс: страницы, изображения, видео, файлы. Это позволяет скачать онлайн-версию сайта целиком для последующего просмотра в офлайн-режиме.

Программа не включает виртуальный DOM (способ представления структурного документа с помощью объектов) или любых форм JavaScript парсинга. Если сайт по большей части использует JavaScript для отображения информации, то выполнить целостное копирование не удастся.

Offline Explorer

Платная программа, которая своим внешним видом сильно напоминает MS Office. Тестовая версия работает 1 месяц, после этого придется купить лицензию – минимальная стоимость 80$. Основные преимущества:

- быстрый и точный поиск файлов, расположенных на веб-ресурсах;

- поддержка протокола BitTorrent;

- одновременная загрузка до 500 документов;

- скачанные сайты просматриваются через встроенный или пользовательский браузер;

- сохраненный ресурс может быть размещен на сервере, экспортирован в другую локацию или сжат в zip-файл;

- поддержка перетаскивания ссылок с браузера;

- полностью настраиваемый пользовательский интерфейс;

- возможность создания шаблонов для упрощения работы с новыми проектами;

- встроенный инструмент создания резервных копий и восстановления данных;

- контроль скорости скачивания;

- планировщик.

Список возможностей программы очень обширный. Поскольку интерфейс представлен на русском, выбрать параметры и скачать сайт не составит труда. Это профессиональный инструмент, который пригодится при регулярном выполнении соответствующих операций.

Ознакомившись с представленной в статье информацией, станет понятно, как сохранить сайт на компьютер целиком. Простейший способ заключается в постраничном сохранении через встроенные возможности браузеров. Онлайн-сервисы подойдут в случае, когда требуется единоразово загрузить несколько ресурсов. Специальные программы зачастую используются профессиональными веб-мастерами, поскольку с их помощью удается тонко настроить параметры.

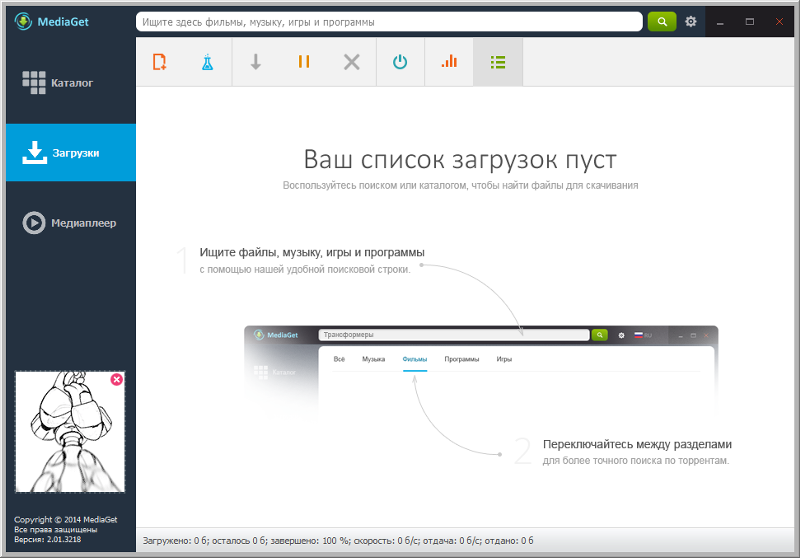

4 программы для скачивания сайтов

4 программы для скачивания сайтов

Эти четыре программы помогут вам загрузить практически любой сайт к себе на компьютер. Очень полезно, если вы боитесь потерять доступ к любимым статьям, книгам, инструкциям и всему остальному, что могут удалить или заблокировать.

1. HTTrack

HTTrack позволяет пользователям загружать сайт из интернета на жесткий диск. Программа работает путем копирования содержимого всего сайта, а затем загружает все каталоги, HTML, изображения и другие файлы с сервера сайта на ваш компьютер.

При просмотре скопированного сайта HTTrack поддерживает исходную структуру ссылок сайта. Это позволяет пользователям просматривать его в обычном браузере. Кроме того, пользователи могут нажимать на ссылки и просматривать сайт точно так же, как если бы они смотрели его онлайн.

HTTrack также может обновлять ранее загруженные сайты, а также возобновлять любые прерванные загрузки. Приложение доступно для Windows, Linux и даже для устройств на базе Android.

2. SiteSucker

Если вы твердо придерживаетесь экосистемы Apple и имеете доступ только к Mac, вам нужно попробовать SiteSucker. Программа, получившая такое название, копирует все файлы веб-сайта на жесткий диск. Пользователи могут начать этот процесс всего за несколько кликов, что делает его одним из самых простых в использовании инструментов. Кроме того, SiteSucker довольно быстро копирует и сохраняет содержимое сайта. Однако помните, что фактическая скорость загрузки будет зависеть от пользователя.

Кроме того, SiteSucker довольно быстро копирует и сохраняет содержимое сайта. Однако помните, что фактическая скорость загрузки будет зависеть от пользователя.

К сожалению, SiteSucker не лишен недостатков. Во-первых, SiteSucker — платное приложение. На момент написания этой статьи SiteSucker стоит $4.99 в App Store. Кроме того, SiteSucker загружает каждый файл на сайте, который может быть найден. Это означает большую загрузку с большим количеством потенциально бесполезных файлов.

3. Cyotek WebCopy

Cyotek WebCopy — инструмент, позволяющий пользователям копировать полные версии сайтов или только те части, которые им нужны. К сожалению, приложение WebCopy доступно только для Windows, но зато оно является бесплатным. Использовать WebCopy достаточно просто. Откройте программу, введите целевой URL-адрес и все.

Кроме того, WebCopy имеет большое количество фильтров и опций, позволяющих пользователям скачивать только те части сайта, которые им действительно нужны. Эти фильтры могут пропускать такие вещи, как изображения, рекламу, видео и многое другое, что может существенно повлиять на общий размер загрузки.

Эти фильтры могут пропускать такие вещи, как изображения, рекламу, видео и многое другое, что может существенно повлиять на общий размер загрузки.

4. GetLeft

Этот граббер с открытым исходным кодом существует уже давно, и на это есть веские причины. GetLeft — это небольшая утилита, позволяющая загружать различные компоненты сайта, включая HTML и изображения.

GetLeft очень удобен для пользователя, что и объясняет его долговечность. Для начала просто запустите программу и введите URL-адрес сайта, затем GetLeft автоматически анализирует веб-сайт и предоставит вам разбивку страниц, перечисляя подстраницы и ссылки. Затем вы можете вручную выбрать, какие части сайта вы хотите загрузить, установив соответствующий флажок.

После того, как вы продиктовали, какие части сайта вы хотите зазрузить, нажмите на кнопку. GetLeft загрузит сайт в выбранную вами папку. К сожалению, GetLeft не обновлялся какое-то время.

Спасибо, что читаете! Подписывайтесь на мой канал в Telegram и Яндекс. Дзен. Только там последние обновления блога и новости мира информационных технологий. Также, читайте меня в социальных сетях: Facebook, Twitter, VK, OK.

Дзен. Только там последние обновления блога и новости мира информационных технологий. Также, читайте меня в социальных сетях: Facebook, Twitter, VK, OK.

Респект за пост! Спасибо за работу!

Хотите больше постов? Узнавать новости технологий? Читать обзоры на гаджеты? Для всего этого, а также для продвижения сайта, покупки нового дизайна и оплаты хостинга, мне необходима помощь от вас, преданные и благодарные читатели. Подробнее о донатах читайте на специальной странице.

Спасибо! Все собранные средства будут пущены на развитие сайта. Поддержка проекта является подарком владельцу сайта.

Простая программа для того, чтобы скачать сайт целиком на компьютер. Так надежнее

Всем привет! Сейчас автор затронет одну очень интересную тему. Поговорим о бесплатной программе для того, чтобы скачать сайт целиком на компьютер. Ведь согласитесь, у каждого человека есть такие ресурсы, которые он боится потерять.

Вот и этот случай не исключение. При создании данного сайта, большое количество технических знаний было взято с разных полезных блогов. И вот сегодня мы один такой сохраним на всякий случай на ПК.

Содержание статьи:

Значит так, уважаемые дамы и господа, первым делом нужно скачать совершенно бесплатную программу, которая называется HTTrack Website Copier. Сделать это можно пройдя по ссылке на официальный сайт:

Как видно на скриншоте выше, здесь присутствуют версии для операционных систем разной разрядности. Поэтому надо быть внимательным при выборе установочного файла. Кстати, он совсем небольшой. Весит всего лишь около 4Мб:

Сам процесс установки программы стандартен, никаких проблем не возникнет. По его завершении запустится окошко с возможностью выбора языка:

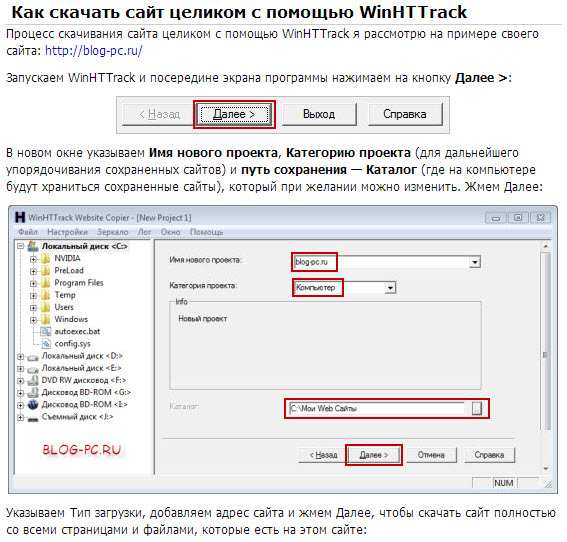

Для вступления указанных изменений в силу, следует сделать повторный перезапуск. Ну что же, на этом шаге нам нужно создать новый проект, благодаря которому будет запущена скачка на компьютер сайта из интернета.

Для этого нажимаем на кнопку “Далее”:

Затем указываем произвольное название создаваемого проекта:

В следующем окошке нас попросят ввести адрес скачиваемого сайта и выбрать тип загрузки:

Если нужно скачать какой-либо ресурс целиком, то выбираем параметр “Загрузить сайты”. В случае если скачка уже была сделана ранее, но, например, хочется докачать последние добавленные страницы, в графе “Тип” указываем опцию “Обновить существующую закачку”:

Забегая наперед следует сказать о том, что в случае автора статьи, проект по неизвестной причине выдавал ошибку при старте. Поэтому пришлось войти в раздел “Задать параметры” и на вкладке “Прокси” убрать галочку:

Ну вот вроде и все приготовления. Теперь осталось лишь нажать на кнопку “Готово”:

И наблюдать за процессом закачки указанного сайта:

Как говорится, не прошло и полгода, как приложение выдало радостное сообщение:

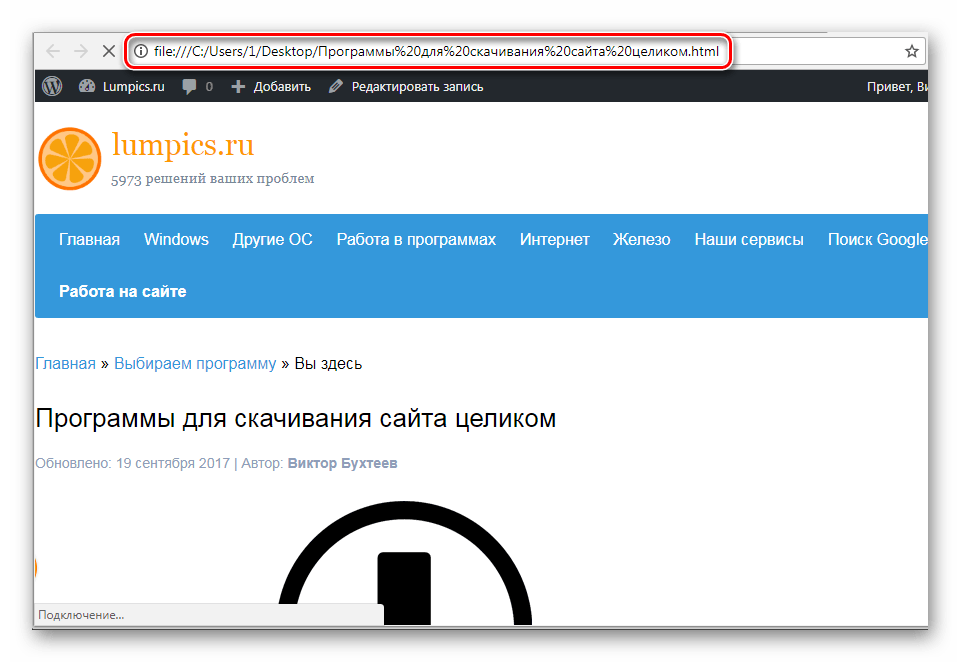

Это хорошо, но давайте проверим, так ли все на самом деле. Для этого идем в папку с названием нашего проекта и запускаем файл с именем index.html:

Для этого идем в папку с названием нашего проекта и запускаем файл с именем index.html:

После этого, о чудо, открывается наш драгоценный сайт, на котором безупречно работает вся структура ссылок и разделов. В общем, все отлично:

Вот такая замечательная и бесплатная программа HTTrack Website Copier, которая позволяет скачать сайт целиком на компьютер. А поскольку цель достигнута, можно завершать публикацию.

В случае если у вас остались вопросы, задавайте их в комментариях к статье. А сейчас можете посмотреть видеоролик про опасные сохранения, которые могут испортить жизнь.

Программы для загрузки сайтов на жесткий диск / Программное обеспечение

Обращаясь по любому поводу к нескончаемым ресурсам всемирной паутины, порой, мы даже не замечаем, насколько стали интернет-зависимыми. Нужно написать реферат – материалы берутся из Сети, возникла необходимость посоветоваться со знающим человеком в каком-либо вопросе – ответ на свой вопрос отыскивается на тематическом форуме, просто одолевает скука – в распоряжении есть онлайновые библиотеки, а также файловые архивы с играми, музыкой, видео и т. д. При этом, «зависимых» людей, которые были бы полностью довольны скоростью соединения с интернетом, крайне мало. Переход на более быстрый тип соединения помогает ощутить свободу, но лишь в первое время. Единственное средство не ждать загрузки с сервером – закачать любимый сайт на жесткий диск целиком. В этом случае время, потраченное на открытие файлов, будет определяться только скоростью работы винчестера. Если сайт содержит тысячу страниц, то сохранять их по одной в обычном браузере очень неудобно. Эта задача решается специальными утилитами, чьи возможности сохранения гораздо шире, чем у Firefox, Opera и других программ для веб-серфинга.

д. При этом, «зависимых» людей, которые были бы полностью довольны скоростью соединения с интернетом, крайне мало. Переход на более быстрый тип соединения помогает ощутить свободу, но лишь в первое время. Единственное средство не ждать загрузки с сервером – закачать любимый сайт на жесткий диск целиком. В этом случае время, потраченное на открытие файлов, будет определяться только скоростью работы винчестера. Если сайт содержит тысячу страниц, то сохранять их по одной в обычном браузере очень неудобно. Эта задача решается специальными утилитами, чьи возможности сохранения гораздо шире, чем у Firefox, Opera и других программ для веб-серфинга.Teleport Pro 1.43

Это программа из тех, про которые говорят: «проверено временем». Не претендуя на первое место по обилию редко используемых функций, она стабильно и качественно выполняет свою работу – загружает из сети сайты. Простой интерфейс Teleport Pro обманчив – программа достаточно гибкая в настройке и возможностей у нее достаточно, чтобы перенести на жесткий диск практически любой сайт. Настройка программы производится с помощью специального мастера, который позволяет указать глубину загрузки и определить типы файлов, которые нужно скачать. Важно также указать, что вы хотите получить на выходе: копию сайта с возможностью переходить с одной страницы на другую (в этом случае ссылки будут заменены на относительные) или же перенос сайта на жесткий диск с сохранением структуры и ссылок. Кроме выкачки сайта на жесткий диск, Teleport Pro может помочь решить несколько других задач, например, составить список всех страниц, на которые ссылается сайт, выполнить на сайте поиск файлов определенного типа или страниц, в тексте которых имеются ключевые слова. Сохранение страниц сайта может производиться с возможностью просмотра всех ссылок в режиме оффлайн или с сохранением внутренней структуры ссылок на страницы сайта. Для файлов, которые должны игнорироваться при загрузке проекта, в окне параметров программы нужно указать маски, согласно которым будут отсеиваться ненужные ссылки.

Настройка программы производится с помощью специального мастера, который позволяет указать глубину загрузки и определить типы файлов, которые нужно скачать. Важно также указать, что вы хотите получить на выходе: копию сайта с возможностью переходить с одной страницы на другую (в этом случае ссылки будут заменены на относительные) или же перенос сайта на жесткий диск с сохранением структуры и ссылок. Кроме выкачки сайта на жесткий диск, Teleport Pro может помочь решить несколько других задач, например, составить список всех страниц, на которые ссылается сайт, выполнить на сайте поиск файлов определенного типа или страниц, в тексте которых имеются ключевые слова. Сохранение страниц сайта может производиться с возможностью просмотра всех ссылок в режиме оффлайн или с сохранением внутренней структуры ссылок на страницы сайта. Для файлов, которые должны игнорироваться при загрузке проекта, в окне параметров программы нужно указать маски, согласно которым будут отсеиваться ненужные ссылки. Если требуется выполнить несколько проектов один за другим, можно использовать планировщик заданий Sсheduler, который позволяет загрузить несколько интернет-ресурсов, согласно составленному расписанию. Он представлен в виде отдельной утилиты, которую можно найти в папке, куда установлена Teleport Pro. После выполнения составленного проекта или через указанное время (например, через четыре часа после запуска) программа может автоматически завершить свою работу. Программа стоит $40. Скачать триал-версию можно отсюда.

Если требуется выполнить несколько проектов один за другим, можно использовать планировщик заданий Sсheduler, который позволяет загрузить несколько интернет-ресурсов, согласно составленному расписанию. Он представлен в виде отдельной утилиты, которую можно найти в папке, куда установлена Teleport Pro. После выполнения составленного проекта или через указанное время (например, через четыре часа после запуска) программа может автоматически завершить свою работу. Программа стоит $40. Скачать триал-версию можно отсюда.Offline Explorer Pro 4.6

Offline Explorer – это одна из самых мощных программ для загрузки Интернет-контента. Помимо своего основного предназначения — копирования сайтов целиком – Offline Explorer Pro имеет массу других назначений. Например, ее очень удобно использовать для сохранения на жесткий диск потокового видео и флеш-файлов. Поддерживается и загрузка видеофайлов с сайта YouTube. Также программа может автоматически загрузить все графические файлы из интернет-галереи и утилиты из файлового архива сайта. Все загруженные файлы можно тут же просматривать во встроенном браузере. Поскольку программа имеет большое количество настроек, параметры, определяющие характер загрузки, могут быть сохранены в виде так называемых пользовательских шаблонов, которые затем можно использовать повторно. Такие предварительные настройки могут включать, например, фильтры для типов скачиваемых файлов, ограничение на размер, определение их расположения, данные для автоматической авторизации и многое другое. Интересной особенностью программы является то, что для каждого из типов загружаемых файлов можно устанавливать свои правила. Так, например, проект можно сконфигурировать таким образом, чтобы файлы rar скачивались с любого сайта, а рисунки и звуковые файлы – только из исходной папки. Кроме этого, загрузку можно ограничивать по протоколу и ключевым словам. В отличие от аналогичных программ, Offline Explorer анализирует не только видимый текст, но и HTML-теги, отыскивая в них ключевые слова.

Все загруженные файлы можно тут же просматривать во встроенном браузере. Поскольку программа имеет большое количество настроек, параметры, определяющие характер загрузки, могут быть сохранены в виде так называемых пользовательских шаблонов, которые затем можно использовать повторно. Такие предварительные настройки могут включать, например, фильтры для типов скачиваемых файлов, ограничение на размер, определение их расположения, данные для автоматической авторизации и многое другое. Интересной особенностью программы является то, что для каждого из типов загружаемых файлов можно устанавливать свои правила. Так, например, проект можно сконфигурировать таким образом, чтобы файлы rar скачивались с любого сайта, а рисунки и звуковые файлы – только из исходной папки. Кроме этого, загрузку можно ограничивать по протоколу и ключевым словам. В отличие от аналогичных программ, Offline Explorer анализирует не только видимый текст, но и HTML-теги, отыскивая в них ключевые слова. Если вход на сайт защищен паролем, программа может приостановить выполнение проекта или самостоятельно заполнить поля для ввода пароля и логина. Интеграция Offline Explorer с такими популярными программами как Firefox и Opera, позволяет выполнять загрузку новой ссылки или всех ссылок, которые имеются на данной странице, прямо из окна контекстного меню браузера. Кроме этого, есть возможность импорта избранных ссылок с последующей загрузкой некоторых из них. Наконец, стоит сказать, что Offline Explorer выпускается в трех версиях: Offline Explorer, Offline Explorer Pro и Offline Explorer Enterprise. Первая версия является базовой и содержит только основные параметры. В ней отсутствуют такие возможности, как перетаскивание ссылок из браузера, организация проектов при помощи вложенных папок, сохранение страниц и файлов, загрузка по протоколу HTTPS и некоторые другие. Две другие версии программы незначительно различаются между собой максимальным количеством загруженных ссылок (в Offline Explorer Enterprise их может быть до 100 млн.

Если вход на сайт защищен паролем, программа может приостановить выполнение проекта или самостоятельно заполнить поля для ввода пароля и логина. Интеграция Offline Explorer с такими популярными программами как Firefox и Opera, позволяет выполнять загрузку новой ссылки или всех ссылок, которые имеются на данной странице, прямо из окна контекстного меню браузера. Кроме этого, есть возможность импорта избранных ссылок с последующей загрузкой некоторых из них. Наконец, стоит сказать, что Offline Explorer выпускается в трех версиях: Offline Explorer, Offline Explorer Pro и Offline Explorer Enterprise. Первая версия является базовой и содержит только основные параметры. В ней отсутствуют такие возможности, как перетаскивание ссылок из браузера, организация проектов при помощи вложенных папок, сохранение страниц и файлов, загрузка по протоколу HTTPS и некоторые другие. Две другие версии программы незначительно различаются между собой максимальным количеством загруженных ссылок (в Offline Explorer Enterprise их может быть до 100 млн. в одном проекте, а в Offline Explorer Pro – до трех миллионов) и поддержкой OLE-автоматизации, благодаря которой можно управлять программой из других приложений. В целом можно сказать, что Offline Explorer Enterprise предназначена для крупных компаний, поэтому большинству пользователей будет достаточно возможностей Offline Explorer Pro, стоимость которой $70. Скачать Offline Explorer можно отсюда.

в одном проекте, а в Offline Explorer Pro – до трех миллионов) и поддержкой OLE-автоматизации, благодаря которой можно управлять программой из других приложений. В целом можно сказать, что Offline Explorer Enterprise предназначена для крупных компаний, поэтому большинству пользователей будет достаточно возможностей Offline Explorer Pro, стоимость которой $70. Скачать Offline Explorer можно отсюда.WinHTTrack Website Copier 3.40-2

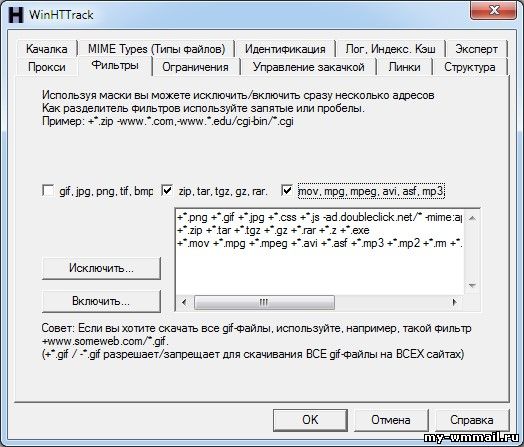

Основная причина, по которой эта программа попала в наш обзор – бесплатный статус. Оффлайн-браузеры – это достаточно удобные, но в то же время достаточно дорогие программы, поэтому программа, которая предлагает скачивать сайты бесплатно, не может не привлечь внимание. Работа с WinHTTrack Website Copier организована в виде мастера. Нужно указать название проекта, начальные ссылки, с которых должна производиться загрузка (можно сразу несколько), а также определить параметры выкачки сайта. Программа имеет русский интерфейс, но лучше использовать английскую версию, так как из-за проблем с кодировкой некоторые названия параметров отображаются некорректно. Среди интересных возможностей WinHTTrack Website Copier – определение максимальной глубины выкачки отдельно для страниц с того же сервера, на котором находится исходная страница, и для страниц, которые расположены на внешних серверах. Благодаря этому можно предотвратить ситуацию, когда программа начнет целиком скачивать сайт, на который имеет ссылка с исходной страницы, но который вас совершенно не интересует. Еще одна удобная особенность программы – возможность следить за процессом загрузки страниц. Выкачка сайта может выполняться в несколько потоков (их количество можно задать в настройках проекта). Когда она начинается, вы можете видеть адрес каждой страницы, которая загружается, а также ползунок, отображающий ход выкачки. Рядом с этими данными для каждой страницы есть кнопка «Пропустить». Таким образом, если вы увидите, что WinHTTrack Website Copier тянет ненужный и большой файл, вы тут же сможете остановить это задание. Загрузка проекта при этом прекращена не будет. В WinHTTrack Website Copier нет встроенной программы для просмотра веб-страниц, как, например, в Offline Explorer, поэтому выкаченные сайты нужно просматривать во внешнем браузере, с которым вы обычно работаете в интернете.

Среди интересных возможностей WinHTTrack Website Copier – определение максимальной глубины выкачки отдельно для страниц с того же сервера, на котором находится исходная страница, и для страниц, которые расположены на внешних серверах. Благодаря этому можно предотвратить ситуацию, когда программа начнет целиком скачивать сайт, на который имеет ссылка с исходной страницы, но который вас совершенно не интересует. Еще одна удобная особенность программы – возможность следить за процессом загрузки страниц. Выкачка сайта может выполняться в несколько потоков (их количество можно задать в настройках проекта). Когда она начинается, вы можете видеть адрес каждой страницы, которая загружается, а также ползунок, отображающий ход выкачки. Рядом с этими данными для каждой страницы есть кнопка «Пропустить». Таким образом, если вы увидите, что WinHTTrack Website Copier тянет ненужный и большой файл, вы тут же сможете остановить это задание. Загрузка проекта при этом прекращена не будет. В WinHTTrack Website Copier нет встроенной программы для просмотра веб-страниц, как, например, в Offline Explorer, поэтому выкаченные сайты нужно просматривать во внешнем браузере, с которым вы обычно работаете в интернете. Просто найдите команду «Просмотр сайтов» в меню «Файл», и программа сгенерирует HTML-страничку с перечнем всех проектов, которые загружались с ее помощью. Страница будет открыта в браузере, который используется в системе по умолчанию, после чего можно будет выбрать один из проектов и начать оффлайн-просмотр сайта. Скачать WinHTTrack Website Copier можно отсюда.

Просто найдите команду «Просмотр сайтов» в меню «Файл», и программа сгенерирует HTML-страничку с перечнем всех проектов, которые загружались с ее помощью. Страница будет открыта в браузере, который используется в системе по умолчанию, после чего можно будет выбрать один из проектов и начать оффлайн-просмотр сайта. Скачать WinHTTrack Website Copier можно отсюда.Выводы

К хорошему человек привыкает быстро, поэтому уже через неделю работы на быстром канале, вновь появляется дискомфорт от необходимости ждать момента, когда файлы будут скачаны на жесткий диск. При увеличении пропускной способности сети, естественно растет желание воспользоваться дополнительными сервисами – посмотреть трейлер нового фильма, пройтись по онлайновым телевизионным каналам в поисках свежих новостей, просмотреть видеоблог и так далее. Конечно, использование оффлайн-браузеров не решит в полной мере проблему нехватки «интернет-мощностей», однако сделает ее менее ощутимой, позволив комфортно искать информацию. Teleport Pro давно заслужила доверие многих тысяч пользователей, благодаря гибким настройкам и корректной обработке сайтов, Offline Explorer отличается более дружественным интерфейсом и поддержкой большего количества типов файлов. Что же касается WinHTTrack Website Copier, то, как уже было сказано выше, эта программа интересна, прежде всего, своим бесплатным статусом.

Teleport Pro давно заслужила доверие многих тысяч пользователей, благодаря гибким настройкам и корректной обработке сайтов, Offline Explorer отличается более дружественным интерфейсом и поддержкой большего количества типов файлов. Что же касается WinHTTrack Website Copier, то, как уже было сказано выше, эта программа интересна, прежде всего, своим бесплатным статусом.Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

Программы и онлайн сервисы для сохранения сайта целиком на компьютер

Необходимость в скачивании сайтов возникает в случае сохранения нужной информации на компьютере без создания закладок и вкладок в браузере. Это удобно, т.к. не требует подключения Интернета (важный контент всегда хранится на носителе). Также исключается постоянный поиск нужных сайтов для получения информации.

Есть онлайн-сервисы, позволяющие сохранить интересующие «юзера» сайты.

Используем Site2zip

Данный ресурс дает возможность в 3 «клика» сохранить необходимую веб –страницу. Первое действие — это ввод адреса сайта, второе – заполнение капчи и третье — непосредственный процесс скачивания нужного пользователю ресурса.

Первое действие — это ввод адреса сайта, второе – заполнение капчи и третье — непосредственный процесс скачивания нужного пользователю ресурса.

Из преимуществ можно отметить бесплатное пользование ресурсом и простой интерфейс управления. К недостаткам относятся отсутствие каких-либо настроек и медленная скорость закачки. Поэтому, Site2zip больше подходит для «работы» с небольшими сайтами.

Копирование с помощью Robotools

Это платный on-line ресурс. В нём имеется четыре тарифа в зависимости от объема скачиваемых страниц. Размеры платежей по тарифным планам: 500 стр.- 2доллара, 4000 стр.- 8 долларов, 9000 стр.- 15 долларов, 20000 стр.- 25 долларов. Но есть некоторые «поблажки» при оплате: если несколько страниц не нужны пользователю, то он может их удалить, вернув часть средств на свой баланс.

К плюсам Robotools можно отнести: понятный интерфейс, возможность закачки нескольких сайтов и просмотр скачанных сайтов на сервере. Минусом является донат за пользование услугой.

Минусом является донат за пользование услугой.

Приложение HTTrack WebSite Copier

Кроме онлайн сервисов существуют программы по сохранению сайтов на своем компьютере. Пожалуй, самой популярной из них является HTTrack WebSite Copier. Она отличается простым интерфейсом и возможностью работать в большинстве версий Windows (от 2000 до 7). Также её поддерживает Linux. Программа абсолютно бесплатная.

Из возможностей этого софта можно отметить следующее:

- выбор места сохранения контента.

- настройка скачиваемой информации (текст, либо видеофайлы, или то и другое).

- первоочередная загрузка текстовой информации, а потом лишь медиа-файлы.

К недостаткам можно отнести невзрачный интерфейс.

Программа Teleport Pro

Ещё одной программой по сохранению сайтов стала Teleport Pro. Сразу надо сказать, что «прога» платная. Её разработчики установили стоимость лицензии в размере 50 долларов. Программа может находить файлы определённого типа и размера на искомой веб-странице. Также, она позволяет осуществлять поиск необходимого места по ключевым словам, что очень удобно, особенно для больших сайтов. Одной из интересных функций Teleport Pro является возможность формирования номенклатуры всех страниц и файлов. Главным из минусов «проги» стало отсутствие русского языка в настройках. Также её поддерживает только Windows.

Также, она позволяет осуществлять поиск необходимого места по ключевым словам, что очень удобно, особенно для больших сайтов. Одной из интересных функций Teleport Pro является возможность формирования номенклатуры всех страниц и файлов. Главным из минусов «проги» стало отсутствие русского языка в настройках. Также её поддерживает только Windows.

Используем Offline Explorer Pro

Ещё одной, не особо популярной программой, является Offline Explorer Pro. Высокая цена от 60 до 600 долларов, в зависимости от пакета, отталкивает потенциальных клиентов. Однако эта «прога» позволяет скачивать не только сайты, но и видео- и аудиофайлы больших размеров. Интуитивно понятное расположение команд и разделов, а также наличие русского языка в интерфейсе делает Offline Explorer Pro незаменимым помощником для профессионального анализа скачанных файлов.

Утилита WGET

Кроме представленных ресурсов и программ, можно отметить интересную утилиту WGET. Сначала находим её по ссылке: https://sourceforge.net/projects/tumagcc/files/ под названием: wget-1.18 _curl -7.49.1_win32_win64.7z

Сначала находим её по ссылке: https://sourceforge.net/projects/tumagcc/files/ под названием: wget-1.18 _curl -7.49.1_win32_win64.7z

Скачав её на компьютер и распаковав, корректируем «Дополнительные параметры системы» (путь: Панель управления-Система-Дополнительные параметры системы). Здесь в свойствах системы выбираем: «Переменные среды». В этом «окне» в «значениях переменных» имеется некий файл. Прописываем в конце его: C:\Program Files\wget

Далее в командной строке (в «Пуске») набираем: cmd и попадаем в командную строку. Ее необходимо запустить от имени администратора.

Затем вписываем: wget-r-k-l 10-p-E-nc http://sidemob.com Число 10 в этой записи означает «глубину скачивания». После нажимаем «Enter». Теперь скаченный сайт будет сохраняться в: C:\Users\Asd\sidemob.com

Читайте также:

Как копировать сайты целиком и отредактировать

Вы ищите, как скопировать сайт из интернета себе на компьютер или флешку и, желательно, чтобы это было дешево и быстро? Есть несколько способов сделать полную копию сайта бесплатно, либо очень недорого. Давайте ознакомимся с каждым из способов и узнаем про их плюсы и минусы. Кроме того, разберемся какой из способов выбрать для того, чтобы целиком скопировать сайт себе на хостинг и разместить его на другом домене.

Давайте ознакомимся с каждым из способов и узнаем про их плюсы и минусы. Кроме того, разберемся какой из способов выбрать для того, чтобы целиком скопировать сайт себе на хостинг и разместить его на другом домене.

Скачайте сайт на компьютер, используя браузер

Первым и самым простым способом сделать копию веб-сайта считается использование браузера. В любом браузере есть возможность копирования и сохранения страниц сайта себе на компьютер.

Для того чтобы сохранить страницу не нужно обладать знаниями программиста или обладать навыками разработчика. Все очень просто, достаточно использовать стандартную возможность, встроенную в каждый браузер.

Как в браузере сделать копию страницы сайта?

Нажмите комбинацию клавиш «Ctrl»+«S», либо используйте команду «Сохранить страницу как». При вызове этой команды появится диалоговое окно, где нужно будет выбрать каталог для сохранения файлов сайта и указать, как стоит сохранить страницу сайта.

Важно выбрать опцию, позволяющую сохранить всю страницу полностью, а не только ее HTML-версию. В этом случае копия сайта будет содержать как HTML-файл, так и все относящиеся к нему изображения, скрипты, стили и другие документы.

В этом случае копия сайта будет содержать как HTML-файл, так и все относящиеся к нему изображения, скрипты, стили и другие документы.

Плюсы копирования сайта в браузере

Безусловно, главным и единственным плюсом этого метода копирования сайта является его доступность. Но как вы понимаете, если бы все было так просто, то не существовало бы других способов создания копий сайта. Дело в том, что этот плюс всего один, а вот минусов, конечно, гораздо больше.

Минусы при копировании сайта через браузере

К главному минусу можно отнести то, что при таком способе копирования сайта, скачиваются в основном те файлы, ссылки на которые есть в HTML-файле. Файлы, ссылки на которые указаны в скриптах JavaScript, остаются не замеченные браузером и попросту не сохраняются. Это приводит к тому, что часть содержимого сайта не отобразится или отобразится не правильно.

Вполне возможно, что некоторые скрипты, отвечающие за подключение стилей, перестанут работать сразу после того как завершится процесс сохранения сайта. В этом случае верстка сайта будет испорчена, некоторые блоки сайта будут отображаться некорректно.

В этом случае верстка сайта будет испорчена, некоторые блоки сайта будут отображаться некорректно.

Другим важным минусом является то, что формы для отправки заявок или сообщений с сайта также перестают работать, так как требуют исполнительных PHP-файлов. Эти файлы отвечают за отправку заявки на почту, и при любом желании скачать их не получится, они работают только на стороне сервера.

Тоже самое касается и административной панели для управления сайтом или другими словами «админки». Если у сайта есть такая панель, то при всем желании скопировать ее через браузер или любым другим способом у вас не получится.

Программы для копирования сайтов целиком

На данный момент существует немало программ для того, чтобы полностью скопировать сайт себе на компьютер и переделать его под себя. Программы могут отличаться по ряду возможностей, но они все позволят вам, как скопировать сайт целиком, так и сохранить необходимые файлы.

Сделать копию сайта вы сможете как бесплатно, так и платно, но стоит понимать, что возможности и функционал программ будет прямым образом влиять на их стоимость. Поэтому прежде чем скачать и установить что-то из интернета стоит разобраться с плюсами и минусами подобного способа клонирования сайтов.

Поэтому прежде чем скачать и установить что-то из интернета стоит разобраться с плюсами и минусами подобного способа клонирования сайтов.

Плюсы полного копирования сайта с помощью программ

Большим плюсом программ для копирования сайтов является их функционал и большое количество настроек. Если у вас есть время на то, чтобы со всем этим разобраться и вникнуть в процесс создания копии, то набор функций не только позволит скачать и даст возможность настроить сайт правильно.

Фильтр для поиска файлов по типу являются еще одним плюсом в копилку программ. Это очень удобная функция, когда вам нужно исключить все не нужные файлы и скачать файлы конкретного расширения. Например, достаточно задать скачивание изображений с сайта и программа просканирует интернет-ресурс и найдет изображения всех возможных форматов.

Еще одним плюсом будет возможность прерывать и возобновлять скачивание файлов с сайта. Это очень удобно, когда процесс копирования затягивается, а вам срочно требуется его приостановить и выключить компьютер.

Кроме того, к важным особенностям программ можно отнести возможность настроить «глубину» сканирования сайта. Это очень удобно, когда вам не нужно сохранять все страницы и вложения на сайте, а достаточно скачать только основные разделы.

Минусы при создании копии сайта с помощью программ

Первым недостатком программ для клонирования сайтов является необходимость их установки и настройки. Так как некоторые программы уже не обновляются, то нет гарантии, что выбранная вами программа легко установится и будет исправно работать на вашей операционной системе. Но если даже установка завершится успешно, то знайте, что вам потребуется время на то, чтобы разобраться с тем, как скачать сайт. Из-за того, что многие программы представляют собой целый букет настроек, то в них очень просто запутаться.

Еще одним минусом программ для копирования сайтов является их ограниченный функционал у бесплатных версий. Стоит понимать, что бесплатные программы для копирования сайтов, чаще всего, имеют небольшой список возможностей. Поэтому, если вам требуется один или два раза скопировать сайт, то задумайтесь, есть ли смысл платить десятки долларов за лицензию.

Поэтому, если вам требуется один или два раза скопировать сайт, то задумайтесь, есть ли смысл платить десятки долларов за лицензию.

Ну и последним минусом остается панель управления сайтом. Если вам будет необходимо переделать сайт под себя, изменить текст, загрузить новые изображения, то вам придется пользоваться стандартным редактором кода. Скачать панель для управления содержимым сайта или другими словами CMS у вас не получится, так как она работает на тех скриптах, которые попросту не загружаются.

Онлайн-сервисы, позволяющие скопировать сайт

Если вы обратитесь к поиску с запросом «сервис для копирования сайтов онлайн», то, скорее всего, вы обнаружите сразу несколько сайтов, предоставляющих данную услугу. Какие-то из этих ресурсов окажутся бесплатные, а какие-то потребуют небольшую плату, но в любом случае они помогут сделать копию необходимого вам сайта. Только, перед использованием подобных ресурсов, давайте разберемся с их преимуществами и недостатками.

Преимущества онлайн-сервисов для копирования

Явным преимуществом онлайн-сервисов для копирования сайтов целиком, в сравнении с теми же программами, является отсутствие требований к операционной системе. Вам не нужно разбираться, будет ли работать сервис на вашей операционной системе или нет, вам достаточно открыть любой браузер и перейти на сервис. Более того вы можете попробовать скачать сайт даже со своего телефона.

Вам не нужно разбираться, будет ли работать сервис на вашей операционной системе или нет, вам достаточно открыть любой браузер и перейти на сервис. Более того вы можете попробовать скачать сайт даже со своего телефона.

Вторым плюсом сервисов по скачиванию сайтов онлайн считается отсутствие лишних установок и большого количества настроек. Вам не нужно, как в случае с программами, искать инструкцию для того чтобы скопировать сайт. Вам достаточно будет указать ссылку на скачиваемый ресурс и запустить копирование сайта, вся операция займет у вас, буквально, 2 – 3 клика.

Недостатки при копировании сайтов онлайн

Главными недостатками онлайн-сервисов можно считать их медленную скорость скачивания сайта и отсутствие дополнительных настроек. Нужно понимать, что бесплатные сервисы не гарантируют высокой скорости загрузки и большого количества настроек, они лишь предоставляют определенный минимум и ограничены в плане возможностей. Так, например, скорость скачивания будет явно меньше, чем у программ, а возможность настроить сам процесс копирования будет в корне отсутствовать. В этом смысле использование программ для копирования сайтов, возможно, будут даже лучшим решением.

В этом смысле использование программ для копирования сайтов, возможно, будут даже лучшим решением.

Кроме того, сервисы не гарантируют, что вы всегда получите точную копию сайта. Очень часто сайты скачиваются не полностью, что приводит к некорректному отображению страниц. Вследствие чего, приходится пробовать скопировать сайт ни на одном подобном сервисе. Возможно, это обернется вам большой потерей времени. Ну а если вы, при этом, заплатили деньги, то вернуть их или повторно скопировать сайт за эту же стоимость у вас точно не получится.

Еще стоит заметить, что работа форм и отправка данных на почту, как и в предыдущих способах, будет не возможна. Это связано все с теми же проблемами копирования исполнительных PHP-файлов как и при использовании программ.

Что касается системы управления сайтом, то ее скопировать с помощью онлайн-сервисов тоже будет невозможно. Это невозможно все по той же причине, что и в случае с отправкой данных на почту. Так как панель управления работает на PHP-скриптах, которые, как мы уже знаем, не копируются, то и скопировать панель у вас также не получится.

Вывод и рекомендации по созданию копии сайта

Для того чтобы разобраться, какое копирование вам подойдет лучше всего, в первую очередь, вам стоит определиться с целями и задачами. Возможно, вам подойдет простое копирование с помощью браузера, а, возможно, потребуется помощь специалиста. Давайте вкратце пройдемся по основным способам копирования сайта и сделаем правильный вывод.

Требуется скачать содержимое страниц сайта?

И так, если вам достаточно просто скопировать содержимое страниц сайта себе на компьютер или флешку, то вам подойдет банальное сохранение страниц через браузер. Это будет самый простой, быстрый и бесплатный способ копирования. Само собой, этот вариант не гарантирует, что копия сайта будет работать также исправно, как и сайт-оригинал, но материалы сайта к себе на локальный компьютер у вас получиться сохранить.

Необходимо скопировать сайт с минимальными изменениями?

Если же вам нужно иметь точную копию сайта и при этом у вас есть небольшие навыки программирования или знания основ верстки сайтов, то использование программ и сервисов, скорее всего, будет наилучшим для вас решением. С помощью программы или онлайн-сервиса вы сможете бесплатно создать копию сайта, а дальше внести все необходимые изменения и переделать сайт под себя. Скорее всего, ваших знаний и нескольких дней чтения советов с форумов будет достаточно, чтобы удалить ненужный код, отредактировать текст и изображения.

С помощью программы или онлайн-сервиса вы сможете бесплатно создать копию сайта, а дальше внести все необходимые изменения и переделать сайт под себя. Скорее всего, ваших знаний и нескольких дней чтения советов с форумов будет достаточно, чтобы удалить ненужный код, отредактировать текст и изображения.

Стоит задача сделать рабочую копию сайта?

Если же вы планируете скопировать сайт целиком и переделать его под себя, при этом вы не являетесь разработчиком сайтов, и знаний верстки у вас нет, то ни один из выше описанных способов вам не подойдет. В вашем случае, рекомендуется сразу обратиться к специалисту, который все сделает за вас и сэкономит ваше драгоценное время. Найти разработчика, который скопирует и настроит функционал сайта, вы сможете либо по объявлению, либо на фрилансе, либо воспользовавшись сервисами предоставляющие услуги по копированию сайтов.

Стоит понимать, что обращаясь к специалисту, сделать копию сайта бесплатно у вас вряд ли получится, но вот договориться и скопировать сайт недорого вы сможете. Главное, не старайтесь искать исполнителя, который скопирует сайт очень дешево. Не гонитесь за низкими ценами, так как это чаще всего влияет на качество проделанной специалистом работы. Ищите надежного специалиста, который сможет помочь вам и в будущем и не исчезнет после того как получит деньги от вас.

Главное, не старайтесь искать исполнителя, который скопирует сайт очень дешево. Не гонитесь за низкими ценами, так как это чаще всего влияет на качество проделанной специалистом работы. Ищите надежного специалиста, который сможет помочь вам и в будущем и не исчезнет после того как получит деньги от вас.

Полезный совет перед копированием сайта

И так, мы разобрались и выяснили, что для того чтобы копия сайта отображалась и работала, так же корректно как и оригинал, потребуются хоть какие-то знания разработчика. Если вы не хотите тратить время на это или не чувствуете в себе силы справиться с этой задачей, и все-таки решили обратиться к специалисту, то рекомендуем вам составить правильное техническое задание и прописать все нюансы. Это однозначно поможет вам добиться лучшего результата, а программисту позволит быстрее понять, что от него требуется.

Обзор методов копирования

Мы рассмотрим методы, и постараемся описать преимущества и недостатки. На сегодняшний день существует два основных метода копирования сайтов:

ручной и автоматизированный.

Ручной метод

С ручным все понятно. Это когда через браузер в один клик сохраняете страницу, либо в ручную создаете все файлы страницы: html файл с исходным кодом верстки, js, css, картинки и т.д. Так себя мучать мы Вам не рекомендуем.

Автоматизированный

Рассмотрим наименее затратный способ – автоматизированный. К нему относятся онлайн сервисы (грабберы) для парсинга, и специальные десктопные программы. Чтобы Вам легче было выбрать, ниж рассмотрим более детально.

Преимущество онлайн сервисов заключается в том, что Вы получаете готовый результат, и не о чем не беспокоитесь. Ко всему прочему, Вы всегда можете спросить за результат. В редких случаях имеется возможность внесения правок в исходный код и дизайн силами исполнителя. К сожалению, данное удовольствие стоит денег, а потому для многих данный способ не приемлим.

Для тех, кто хочет сэкономить, на помощь приходят специальные программы для парсинга. Метод довольно затратный, если Вам нужно получить два-три сайта, т. к. каждая отдельная программа обладает своими особенностями, и для изучения Вам понадобится не мало времени.

к. каждая отдельная программа обладает своими особенностями, и для изучения Вам понадобится не мало времени.

А учитывая, что результат работы трудно редактируемый, то возникает вопрос: стоит ли тратить время на изучение, чтобы получить результат на который надо потратить еще кучу времени. Выбор за Вами.

Video

Выкачать сайт с помощью COPYRON.RU

Если вы хотите скачать сайт онлайн, можете воспользоваться нашим сервисом. Нам не важно на чем сделан чужой сайт: на wordpress (вордпресс), joomla (джумла), wix, drupal (друпал), либо это просто шаблонный дизайн, или вообще одностраничник (лэндинг-пэйдж). Мы все равно его выкачаем для Вас.

У нас масса преимуществ по сравнению с аналогичными сервисами и публичным софтом.

«Дешевая Дешивизна»

«Дешевая дешивизна» — это специальная программа лояльности для наших клиентов. Суть ее заключается в том, что если Вы нашли аналогичную услугу где-то дешевле чем у нас, мы сделаем еще дешевле чем у конкурента. Для заказа пишите на почту или в Skype.

Для заказа пишите на почту или в Skype.

«Скидочная постоянная»

Это скидочная программа для клиентов. Если Вы много заказываете, то мы готовы обсудить с Вами Вашу индивидуальную скидку. Некоторые клиенты с нами работают со скидкой 45%.

«Социальная»

Вступи в нашу группу в VK.COM и получи одноразовую скидку в 50% от заказа. Заказ при этом делается через личные сообщения администратора группы. Ссылку на группу найдете в «подвале» сайта.

Как полностью скопировать страницу сайта или сайт с исходным кодом?

Ответ прост – COPYRON.RU. Мы для Вас предоставляем возможность сделать

заказ на рип сайта несколькими способами.

Самый оперативный метод. 24/7 онлайн. Оперативная обратная связь. Всегда можете задать вопрос.

Самый надежный. Пишите нам на электронную почту – всегда на связи, и Ваше письмо не затеряется.

Сделав заказ через сайт, Вы получите возможность отслеживать выполнение заказа с помощью трек номера.

Мануал по копированию сайта

Отслеживание Вашего заказа можно смотреть по «номеру заказа», который будет Вам выдан автоматически при заказе.

Если сайт небольшой, ссылку на архив получите в течении 30 минут – 1 часа. Если сайт большой, то мы Вас предупредим, и сообщим сколько приблизительно по времени ожидать. В любом случае — на связи.

Как переделать сайт под себя?

Результат работы сервиса представлен в виде структурированной информации упаковонной в архиве, поэтому у Вас не будет вопросов типа: «как сохранить на компьютер копию сайта?». По сути сайт работает на платформе с сохранением оригинальной структуры. Это делает сайт наиболее гибким для редактирования, что позволит Вам без труда отредактировать исходный код у себя на компьютере используя блокнот. Более того, код самого движка написан на php и является открытым.

Все страницы сайта находятся в одной папке без какого либо мусора и вложенности. Удобный роутер URL (адресов) позволяет эмулировать какие угодно адреса страниц. Конфигурационные файлы позволяют: задать переменные, массово заменить участки кода, замена по регулярным выражениям.

Без проблем разместите ресур на своем домене. Для того, чтобы переделать сайт под себя, необходимо ознакомится с мануалом. Это не займет много времени. Для изучения желательно иметь базовые знания html и php. Но если у Вас с этим проблемы, – мы и об этом позаботились, написав отдельную статью с готовыми примерами кода.

В наше время, когда интернет доступен практически в любой момент, иногда возникает необходимость скачать сайт целиком. Зачем это нужно? Причины могут быть разные: и желание сохранить важную информацию на будущее, и необходимость получить доступ к нужным данным при отсутствии доступа в сеть, и возможность ознакомиться с тем, как сверстаны страницы. Могут быть и другие резоны. Важно знать, как выполнить эту задачу, и далее мы покажем несколько способов как сделать копию сайта для последующего его использования в оффлайн режиме.

Способ 1. Постраничное сохранение

Самый простой способ о котором все знают, даже если ни разу не пользовались. Эта возможность есть в любом браузере. Достаточно лишь нажать комбинацию клавиш «Ctrl»+«S», после чего в открывшемся окне отредактировать название сохраняемой страницы и указать папку, в которую ее следует поместить.

Достаточно лишь нажать комбинацию клавиш «Ctrl»+«S», после чего в открывшемся окне отредактировать название сохраняемой страницы и указать папку, в которую ее следует поместить.

Казалось бы, куда проще. Вот только есть в этом способе один существенный недостаток. Мы скачали всего лишь одну страницу, а в интересующем нас сайте таких страниц может быть весьма большое количество.

Хорошо, если сайт маленький, или состоит всего из одной страницы, а если нет? Придется выполнять это действие для каждый из них. В общем, работа для усидчивых и целеустремленных, не знающих об одном из основных двигателей прогресса.

Способ 2. Использование онлайн-сервисов

Вот оно, самое простое решение. Сейчас много есть полезных онлайн-ресурсов для перекодирования файлов, редактирования аудиофайлов и т. п. Среди достоинств этого метода – кроссплатформенность, отсутствие необходимости захламлять свою операционную систему утилитами, которые, возможно, понадобятся лишь однажды.

Всего делов-то, зайти на такой ресурс, ввести в строку адрес интересующего сайта, нажать кнопку запуска процесса скачивания и подставить «емкость», в которую польется интересующая информация…

В теории так, но, к сожалению, подобных онлайн-ресурсов, позволяющих скачать сайт целиком, раз, два, три и… И, пожалуй, все, если говорить о бесплатной возможности сохранить копию сайта на компьютер. А за все остальное придется платить, или мириться с урезанным функционалом.

А за все остальное придется платить, или мириться с урезанным функционалом.

Но давайте рассмотрим примеры поближе.

Site2Zip.com

Перестал работать в начале 2019 года.

Едва ли не единственный бесплатный и русскоязычный ресурс. Интерфейс предельно прост. В строке вводим адрес интересующего сайта, вводим капчу, нажимаем кнопку «Скачать» и ждем…

Процесс небыстрый, к тому же с первого раза может и не получиться. Если все удачно, то на выходе получим архив с сайтом.

Webparse.ru

Условно-бесплатный ресурс, позволяющий один раз воспользоваться его услугами бесплатно, после чего за скачивание сайтов придется платить.

Работает webparse.ru быстрее предыдущего ресурса, но делает это не бесплатно. В итоге получаем архив со скачанным сайтом. В настройках нет настройки глубины парсинга структуры скачиваемого сайта, поэтому убедиться, что удалось скачать сайт полностью, придется только самостоятельной сверкой оригинала и его копии.

Другие ресурсы

Среди других способов можно отметить ресурс Web2PDFConvert.com, создающий PDF-файл со страницами скачиваемого сайта. Естественно, часть функционала сайта будет утеряна. Если это допустимо, то воспользоваться данным ресурсом можно.

Еще один ресурс, позволяющий скачать сайт – r-tools.org. К сожалению, пользоваться им можно только на платной основе.

Способ 3. Специализированные программы

Использование утилит для скачивания файлов — пожалуй, наиболее функциональный вариант, позволяющий добиться своей цели. Придется смириться с тем, что в системе появятся дополнительные программы, одна часть из которых бесплатна, а другая – более меркантильна и требует за выполнение тех же функций поощрение. Причем, бесплатные программы (иногда их еще называют оффлайн-браузерами) по возможностям практически не уступают платным аналогам.

В отличие от онлайн-сервисов, подобная программа работает гораздо быстрее, хотя придется искать подходящую под вашу ОС версию этого ПО. Некоторые программы можно найти не только для ОС Windows, но и для других.

Некоторые программы можно найти не только для ОС Windows, но и для других.

Рассмотрим несколько примеров таких программ.

WinHTTrack WebSite Copier

Одна из самых популярных программ, предназначенных для создания оффлайн-копий сайтов. Справедливости ради надо сказать, что бесплатных аналогов практически нет.

Для того, чтобы пользоваться программой, надо скачать с сайта разработчика подходящую версию, проинсталлировать ее в свою систему и запустить. В первом окне будет предложено выбрать язык интерфейса. Среди всех вариантов есть и русский.

Интерфейс программы прост и запутаться в нем не получится. В первом окне надо указать имя и категорию проекта, а также указать место, где будет храниться скачиваемый сайт.

Теперь надо ввести адрес сайта, который надо скачать. Программа имеет большое количество настроек, где задается глубина просмотра сайта, определяются фильтры, указывающие что скачивать надо, а что – нет. Например, можно запретить скачку изображений, исполняемых файлов и т. п. Настроек много, и если есть необходимость, можно внимательно с ними ознакомиться.

п. Настроек много, и если есть необходимость, можно внимательно с ними ознакомиться.

В следующем окне надо нажать кнопку «Готово», после чего остается только дождаться окончания процесса. По окончании в указанной папке будут находиться файлы скачанного сайта. Для того, чтобы открыть его для просмотра необходимо выбрать файл index.htm.

Теперь папку с проектом можно скачивать на любой носитель и просматривать там, где это удобно.

Cyotek WebCopy

Англоязычная программа с солидно выглядящим интерфейсом и большими возможностями по настройке процедуры скачивания сайта. Достаточно только вести адрес интересующего ресурса, указать папку, в которую сохранить скачанные данные и нажать кнопку «Copy Website».

Все, теперь остается дождаться окончания работы программы и в указанном места найти файл «index.htm», который и будет начальной страницей ресурса, который подготовили для оффлайн-просмотра.

Из недостатков можно отметить только отсутствие русификации, а также то, что Cyotek WebCopy работает только на ОС Windows, начиная с версии Vista. Версий под другие ОС нет.

Версий под другие ОС нет.

Teleport Pro

Одна из старейших программ, к сожалению, платная. Имеется тестовый период. После установки и запуска появится главное окно, где необходимо указать режим скачивания сайта. Это может быть полная копия, можно сохранить только определенный тип файлов и т. п.

После этого надо создать новый проект, который будет ассоциирован со скачиваемым сайтом и ввести адрес интересующего интернет-ресурса. По умолчанию глубина переходов по страницам имеет значение 3. Этот параметр можно изменить. После этого можно нажать кнопку «Далее».

Создастся новый проект, необходимо указать папку, в которую сохранять данные. Для запуска процедуры скачивания надо нажать кнопку «Start» (синий треугольник) в панели управления. Начнется процесс сохранения сайта на ваш диск.

Offline Explorer

Еще одна платная, но весьма функциональная программа. Есть русифицированная версия. Триальная версия работает 30 дней, при этом есть ограничение на количество скачиваемых файлов – 2000. Программа существует разновидностях Standard, Pro и Enterprise. Самая дешевая версия стоит 59.95$, а самая дорогая – 599.95$.

Программа существует разновидностях Standard, Pro и Enterprise. Самая дешевая версия стоит 59.95$, а самая дорогая – 599.95$.

Как и в других программах, работа начинается с того, что необходимо создать новый проект и указать адрес интересующего сайта. Доступно большое количеств настроек, при помощи которых можно отфильтровать ненужную информацию, задать глубину просмотра сайта и т. п.

После того как проект создан, отредактированы параметры загрузки, можно нажать кнопку «Загрузить» и дожидаться результата.

Возможностей у программы действительно много. Есть многопоточная загрузка, собственный веб-сервер для просмотра того, что было скачано, масса настроек. Если оценивать все возможности, то программа действительно ценная (уж простите за тавтологию), вот только стоимость ее неприлично высока.

Webcopier

Платная программа с 15-дневным триальным периодом. Существует в версиях для Windows и Mac OS. Алгоритм работы не отличается оригинальностью, что, впрочем, является плюсом. Для скачивания сайта надо создать новый проект, ввести URL.

Для скачивания сайта надо создать новый проект, ввести URL.

Мастер попросит ответить на несколько вопросов, например, ввести логин и пароль пользователя на скачиваемом сайте, указать папку назначения, позволит изменить некоторые параметры, например, отключить возможность скачивания изображений. После окончания создания проекта для начала процедуры создания локальной копии сайта надо нажать кнопку «Start download». Будет отображаться процесс при помощи графика, показывающего скорость работы, а также время работы.

Заключение

Возможностей создать локальную коллекцию нужных сайтов для их просмотра достаточно. Есть и онлайн-ресурсы, есть и специализированное ПО. Каждый из вариантов имеет свои достоинства и недостатки. К сожалению, большинство программ платные, и готовы ли вы раскошелиться за более широкий функционал или достаточно того, что умеют бесплатные утилиты – решать каждому самостоятельно.

Прежде чем отдавать предпочтение тому или иному решению, следует попробовать их все, благо даже платные программы имеют тестовый период, пусть и с некоторыми ограничениями. Это позволит оценить возможности этого ПО, понять, необходим ли вам весь этот функционал, насколько корректно производится скачивание сайтов.

Это позволит оценить возможности этого ПО, понять, необходим ли вам весь этот функционал, насколько корректно производится скачивание сайтов.

Локальная копия сайта, скачиваем сайт целиком

- IT в мире

- Локальная копия сайта, скачиваем сайт целиком

Written by Mark.

Скачать сайт целиком очень просто, для этого можно использовать утилиту wget. После скачивания сайт можно просматривать его в автономном режиме.

Для скачивания сайта целиком необходимо сделать следующее:

1. Задайте папку для скачивания:

cd /home/имя пользователя/Загрузки/

Можно указать другую папку, главное чтобы она была заранее создана.

2. Скачайте сайт в указанную ранее папку:

wget -r -k -l 7 -p -E -nc адрес сайта

Например:

wget -r -k -l 7 -p -E -nc http://ubuntu-desktop. ru

ru

Сайт будет скачать в указанную Вами папку, для запуска главной страницы запустите index.html

Используемые параметры:

- -r указывает на то, что нужно рекурсивно переходить по ссылкам на сайте, чтобы скачивать страницы.

- -k используется для того, чтобы wget преобразовал все ссылки в скаченных файлах таким образом, чтобы по ним можно было переходить на локальном компьютере (в автономном режиме).

- -p указывает на то, что нужно загрузить все файлы, которые требуются для отображения страниц (изображения, css и т.д.).

- -l определяет максимальную глубину вложенности страниц, которые wget должен скачать (по умолчанию значение равно 5). В большинстве случаев сайты имеют страницы с большой степенью вложенности и wget может просто «закопаться», скачивая новые страницы. Чтобы этого не произошло можно использовать параметр -l.

- -E добавлять к загруженным файлам расширение .html.

- -nc при использовании данного параметра существующие файлы не будут перезаписаны.

Это удобно, когда нужно продолжить загрузку сайта, прерванную в предыдущий раз.

Это удобно, когда нужно продолжить загрузку сайта, прерванную в предыдущий раз.

clubs.ya.ru

Обзор оффлайн браузера Teleport Pro

Ответ на вопрос, нужны ли офлайновые браузеры, довольно прост — конечно, нужны. Во-первых, иногда гораздо удобнее закачать интересующие разделы сайта или весь сайт целиком, а уж потом, не тратя драгоценные минуты диалапа, медленно и с расстановкой их просматривать. Во-вторых, у многих провайдеров в ночное время действуют значительные скидки, воспользоваться которыми без ущерба для сна тоже можно путем отложенного просмотра заранее скачанных материалов.

В случае с обычными браузерами, например Internet Explorer, вам пришлось бы открывать страницу за страницей, просматривать их и отдельно каждую сохранять. При этом не спать, а бдеть возле компьютера. Во-первых, на это тратилось бы ваше время, а значит, и деньги. Во-вторых, это неудобно, так как документов на сайте может быть очень много и если вы захотите заняться другими делами, то процесс остановится. Словом, скачивание сайтов превратилось бы для вас в каторгу около своего компьютера.

Словом, скачивание сайтов превратилось бы для вас в каторгу около своего компьютера.

Экономить деньги и время, а также нервы призван целый класс утилит под названием «офлайн-браузеры» — те же самые менеджеры закачки, только для сайтов. Относящаяся к этому классу программа Teleport Pro известна уже много лет. Это компактный, удобный и функциональный инструмент для загрузки сайтов на жесткий диск. С помощью Teleport Pro можно качать сайты целиком, сгружая файлы в одну директорию или в точности копируя структуру удаленного сервера, искать на удаленном сервере файлы конкретного типа, например только изображения, и загружать только их и еще многое другое.

Программа отличается простым интерфейсом, его логичностью, а также большим количеством настроек. Создать новый проект для закачки можно как с помощью мастера, так и вручную. При создании нового проекта важно правильно установить глубину закачки. Если выставить ее значение слишком большим, то есть шанс загрузить на свой жесткий диск добрую половину Сети. С помощью встроенного планировщика задается расписание, по которому скачиваются сайты. Программа закачивает файлы в десять потоков, и на скорость жаловаться не приходится. Teleport Pro может работать через прокси, а при наличии верного логина и пароля предоставляет доступ к сайтам, требующим авторизации.

С помощью встроенного планировщика задается расписание, по которому скачиваются сайты. Программа закачивает файлы в десять потоков, и на скорость жаловаться не приходится. Teleport Pro может работать через прокси, а при наличии верного логина и пароля предоставляет доступ к сайтам, требующим авторизации.

Создаем проект с помощью мастера

Создавая новый проект, на первом шаге вы выбираете структуру будущего офлайнового сайта, затем вводите адрес ресурса, указываете, файлы с какими расширениями нужно скачивать, и все — мастер завершил работу, можно запускать проект на исполнение. Копирование из Сети сопровождается полной визуализацией рабочего процесса. После сохранения файла проекта в главном окне можно увидеть две панели. В левой панели показана древовидная структура сайта, а в правой — непосредственно файлы. Весь проект с любым количеством стартовых адресов сохраняется в одном файле, открыв который вы получите доступ ко всем скачанным страницам.

Иногда оформление страниц зависит от того, какой браузер используется на стороне клиента. А некоторые сайты содержат прямой запрет на использование офлайн-браузеров. Teleport Pro умеет менять идентификацию и прикидываться, например, Internet Explorer или Opera для корректной работы с сайтами.

А некоторые сайты содержат прямой запрет на использование офлайн-браузеров. Teleport Pro умеет менять идентификацию и прикидываться, например, Internet Explorer или Opera для корректной работы с сайтами.

Teleport Pro делает реверанс в сторону пользователей с диалап-доступом. Он позволяет конфигурировать свойства соединения. Программа может дозваниваться до провайдера при запуске, разъединяться по завершении задания или при закрытии. Кроме того, позволяет лимитировать место для закачки. Если объем закачиваемого сайта достигает указанной величины (по умолчанию 24 мегабайта), то закачивание приостанавливается. Полезно при ограниченных ресурсах пользовательской машины.

Вводим адрес сайта, зеркало которого необходимо, и глубину переходов

Отличительной чертой Teleport Pro можно назвать поддержку Server Side Image Map — некоторые иллюстрации могут содержать навигационную карту, параметры которой указываются не в тексте страницы, а на сервере. Когда пользователь кликает на картинке, браузер отсылает координаты клика на сервер, который возвращает URL. Для перехода по таким ссылкам программа должна иметь возможность «прощупать» изображение с заданным шагом. Teleport Pro это умеет. Кроме того, можно отметить загрузку нескольких файлов из списка — в этом случае офлайн-браузер фактически заменяет «качалку», что довольно удобно, если нужно скачать несколько относительно небольших файлов. Многим пользователям пригодится поиск по ключевым словам — загрузка только тех страниц, в тексте которых есть искомые слова.

Для перехода по таким ссылкам программа должна иметь возможность «прощупать» изображение с заданным шагом. Teleport Pro это умеет. Кроме того, можно отметить загрузку нескольких файлов из списка — в этом случае офлайн-браузер фактически заменяет «качалку», что довольно удобно, если нужно скачать несколько относительно небольших файлов. Многим пользователям пригодится поиск по ключевым словам — загрузка только тех страниц, в тексте которых есть искомые слова.

Так как при навигации по некоторым сайтам или отдельным страницам ссылка может не содержаться в тексте напрямую, в виде тега, а генерироваться при выполнении скриптов, Teleport Pro умеет для корректных переходов выполнять скрипты. Поддерживаются DHTML, CSS и Java. Однако каскадные таблицы стилей (CSS) не входят по умолчанию в список скачиваемых текстовых файлов. Казалось бы, мелочь, но это обстоятельство может сильно навредить при последующем просмотре — вплоть до полной нечитаемости, так что перед началом работы уделите особое внимание этому моменту.

Настройки проекта

В программу встроен планировщик — проекты автоматически запускаются и останавливаются в заданное время. Очень удобно для качания по ночам, о котором мы говорили в самом начале статьи. Впрочем, запуском или остановкой все не ограничивается, в расписание можно добавить пункт для любой функции программы. Можно, к примеру, каждое утро обновлять свое зеркало сайта, скачивая только изменившиеся странички.

С первого взгляда программа может показаться ненужной. Однако рано или поздно сможет пригодиться любому пользователю. В заключение стоит отметить, что стоимость программы составляет 48 условных единиц, а интерфейс ее — английский.

7 бесплатных инструментов для загрузки целых веб-сайтов для использования в автономном режиме или для резервного копирования

При сегодняшней скорости интернета и подотчетности нет особых причин загружать весь веб-сайт для использования в автономном режиме. Возможно, вам нужна копия сайта в качестве резервной копии или вы отправитесь куда-нибудь в удаленное путешествие, эти инструменты позволят вам загрузить весь сайт для чтения в автономном режиме.

Связанная статья 2021 года ➤ 60 лучших веб-сайтов для загрузки электронных книг в формате ePub и PDF

Вот краткий список некоторых из лучших программ для загрузки веб-сайтов, которые помогут вам начать работу.HTTrack — лучший и любимый многими на протяжении многих лет.

↓ 01 — HTTrack |