Z — незаменимая утилита для владельцев SSD — Ответы на вопросы

Какой программой можно получить подробную информацию о твердотельном накопителе SSD ?

Бесплатная утилита SSD-Z от Aezay Productions (Anders Jakobsen) покажет подробную информацию о твердотельном накопителе SSD.

SSD-Z позволяет получить информацию о:

— производителе и модели,

— серийном номере и дате старта производства,

— версии прошивки и технологиях изготовления микросхем памяти,

— интерфейсе подключения и вместимости,

— статусах TRIM и SMART,

— объёмах записанных данных и других характеристиках.

Кроме того утилита покажет температуру и общее количество записанных байт, диски и разделы.

Также SSD-Z обладает функцией Benchmark, которая обеспечивает быстрый обзор производительности по нескольким самым популярным параметрам.

Установка SSD-Z не требуется, распространяется на бесплатной основе.

Язык интерфейса поддерживается только один — английский.![]()

Утилита похожа своим интерфейсом с другими информационными программами, как CPU-Z или GPU-Z.

Главное окно программы «Device» является основным и показывает только информацию о диске:

— «Device Name» — Наименование устройства

— «Firmware» — Номер прошивки

— «Serial Number» — Серийный номер

— «Controller» — Используемый контроллер

— «Technology — Поддерживаемые технологии

— «NAND-Capabilities» — Технология производства NAND памяти и тип ячеек

— «Launch Date» — Время запуска серии SSD и работоспособность команды TRIM

— «Interface» — Интерфейс передачи

— «S.M.A.R.T.» — Статус S.M.A.R.T.

— «Температура твердотельного диска и ряд других параметров по части секторов, и записанных данных.

Важно заметить, что часть информации зависит от предварительно внесенных в программу данных разработчиком.

То есть, SSD-Z не сможет распознать контроллер и память только что вышедшего в свет SSD, точно также как CPU-Z не может определять точно наименования и параметры инженерных образцов процессоров.

На вкладке «S.M.A.R.T.» получаем информацию из показаний самодиагностики SSD.

Наиболее полезными значениями тут будут температура, уровень записанных данных и конечно условное обозначение здоровья диска.

На вкладке «Partitions» обозначены все доступные (в том числе, системные и скрытые) разделы твердотельных дисков.

Если вы хотите выбрать другой накопитель, подключенный к ПК, то в нижней части программы есть меню, позволяющее это сделать.

Вкладка «Benchmark» создана для тестирования различных скоростей твердотельных дисков.

Остальные вкладки программы носят технических характер, например, показывая ряд определенных системных значений.

Также существует возможность отправить разработчику слепок показателей, вместе с дополнительным комментарием и связаться с ним иными способами.

M.2 (NGFF) — NVM Express. От теории к практике

https://sata-io.org/developers/sata-ecosystem/sata-m2-card

sata-io.org/sites/default/files/documents/M2_Webcast_Slides. pdf

pdf

https://ru.wikipedia.org/wiki/M.2

Обзор форм-фактора M.2

M.2 (в первоначальном варианте — NGFF, Next Generation Form Factor) — форм-фактор компактных плат расширения.

Платы M.2 имеют прямоугольную форму с 67-контактным двухсторонним ножевым разъемом и полукруглым вырезом для фиксации винтом.

Спецификация M.2 разрабатывается группой PCI-SIG M.2 http://www.pcisig.com

Преимущества и недостатки M.2Ключевые преимущества форм-фактора:

— компактная плата;

— не занимает разъем PCIe на материнской плате и не требует место для диска в корпусе;

— высочайшая скорость передачи данных по каналам интерфейса определяется скоростью PCIe;

— универсальность — поддерживаются интерфейсы NVMe и SATA.

Недостатки:

— не поддерживается горячая замена накопителей;

— затрудненный доступ к накопителю;

— несовместимость со старыми версиями интерфейса;

— недостаточно динамичный переход на новый форм-фактор.

Платы M. 2 маркируются по следующей схеме:

2 маркируются по следующей схеме:

ШШДД-СВ-К1-К2

где:

ШШ — ширина модуля в мм. Наиболее распространенная ширина SSD накопителей — 22 мм. Допускаются модули шириной 12, 16, 22 или 30 мм.

ДД — длина модуля в мм. Распространены модули SSD длиной 42 и 80 мм. Допустимая длина модулей — 16, 26, 30, 38, 42, 60, 80 или 110 мм.

СВ — высота и количество сторон. M.2 плата может быть с односторонним или двухсторонним монтажом навесных элементов. «С» показывает количество сторон, «В» — максимальную высоту навесных элементов (приводятся далее). Для односторонних плат определены следующие размеры в мм: 1.2 (S1), 1.35 (S2), 1.5 (S3). Для двухсторонних плат (сверху/снизу) в мм: 1.2/1.35 (D1), 1.35/1.35 (D2), 1.5/1.35 (D3), 1.5/0.7 (D4), 1.5/1.5 (D5).

К1 и К2 — ключи для плат с различными интерфейсами. Плата может иметь один или два ключа. Для SSD накопителей используют ключ «B» (вырез 12-19) для PCIe ×2 / SATA и ключ «M» (вырез 59-66) для PCIe ×4 / SATA накопителей.

Установка одностороннего модуля M.2 на плату.

Установка двухстороннего модуля M.2 на плату.

Варианты разъема для одно- и двухсторонних модулей M.2

| Высота, макс. мм | Dim A мм | Dim B мм | Dim C мм | Применение | |

| 2199125-x | 2.25 | 2.15 | 1.08 | 0.63 | Односторонние S1, S2, S3 |

| 2199119-x | 3.2 | 3.1 | 1.94 | 1.48 | Односторонние Двухсторонние D1, D2, D3, D4 |

| 2199230-x | 4.2 | 4.1 | 2.94 | 2.48 | Односторонние Двухсторонние D1, D2, D3, D4, D5 |

Стандарт M.2 достаточно универсальный. На разъем M.2 могут быть выведены интерфейсы PCI Express 3.0 и SATA 3.0, а также USB 3.0.

Накопители M.2 могут использовать подключение как по линиям PCI Express, так и SATA Express.

SATA SSD подключаются на скорости до 6 Гб/с и поддерживаются традиционными драйверами SATA/AHCI.

Подключение PCIe SSD с драйверами PCIe/AHCI происходит по линиям PCIe, но поддерживается драйвером AHCI и обеспечивает более широкую обратную совместимость с программным обеспечением. При этом, обработка сопряжена с большими, чем при подключении по протоколу PCIe/NVMe задержками и, как следствие, с частичной потерей производительности.

Самое производительное решение — работа PCIe SSD с «родным» PCIe/NVMe драйвером обеспечивает и самые высокие скорости и минимально возможные задержки передачи данных.

«Ключи» — перемычки в разъеме интерфейса и вырезы на плате M.2, предотвращающие ее неправильную установку. Благодаря ключам невозможно подключить плату «вверх ногами» и плату с «неправильным» интерфейсом.

M.2 допускает наличие одного или двух ключей на плате. Их расположение привязано к номерам контактов разъема и четко определено набором ключей. Каждый ключ в наборе имеет буквенную маркировку.

2.

2. Вырезы расположены несимметрично относительно краев платы — это не позволяет вставить накопитель перевернутым.

Для SSD накопителей используются 2 ключа из набора — B и M.

«B» — вырез на месте 12-19 контактов, позволяет подключить накопитель с интерфейсом PCIe x2 / SATA / USB 2.0 / USB 3.0.

«M» — вырез на месте 59-66 контактов, позволяет подключить накопитель с интерфейсом PCIe x4 / SATA.

В соответствии с этим, SSD накопители с интерфейсом PCIe x2 или SATA имеют ключ «B» или двойной ключ «B+M» (чаще всего).

SSD накопители с интерфейсом PCIe x4 имеют ключ «M».

Установка

Установку M.2 SSD иллюстрирует следующий рисунок:

Установка платы M.2 в системуПорядок установки модуля M.2:

Извлеките модуль M.2 из защитной упаковки.

Сориентируйте модуль в соответствии с ключом интерфейсного разъема.

Вставьте ножевой разъем модуля в разъем интерфейса под углом.

Удерживая под углом примерно в 25 градусов введите модуль в разъем интерфейса до упора.

Прижмите модуль к крепежной втулке, зафиксируйте его положение винтом.

Особенности форм-факторов и их применение в конкретной системе рассматриваются в заметке Выбор NVMe SSD. Форм-фактор

Aomei partition assistant википедия

AOMEI Partition Assistant – отличное решение для работы с жёсткими дисками. Перед пользователем открывается множество возможностей для настройки HDD. Благодаря программе вы сможете выполнять различного рода операции, включая: разделение, копирование и объединение разделов, форматирование и чистка локальных дисков.

Программа позволяет полностью оптимизировать ваше дисковое хранилище, а также восстановить повреждённые сектора. Функционал AOMEI Partition Assistant дает возможность переносить имеющуюся на HDD операционную систему на приобретённый SSD. Присутствующие подсказки для неопытных пользователей помогают принять правильное решение при выполнении той или иной задачи.

Интерфейс

Оформление и иконки инструментов программы выполнены в компактном стиле.

Конвертирование файловой системы

Присутствует возможность преобразования файловой системы из NTFS в FAT32 или наоборот. Это позволяет пользователям конвертировать раздел в системный или использовать форматирование диска для других требований. Удобство этой функции в том, что Partition Assistant позволяет это сделать без потери данных.

Копирование данных

Программа предусматривает операцию копирования данных, которые содержатся на винчестере. Возможность копирования диска подразумевает подключение к ПК другого HDD. Подключенный накопитель выступает в качестве диска назначения, а хранилище, с которого дублируется информация, как источник.

Аналогичные операции проводятся и с копируемыми разделами. В этом случае также необходимо выбрать копируемый и конечный раздел, который подразумевает резервную копию источника.

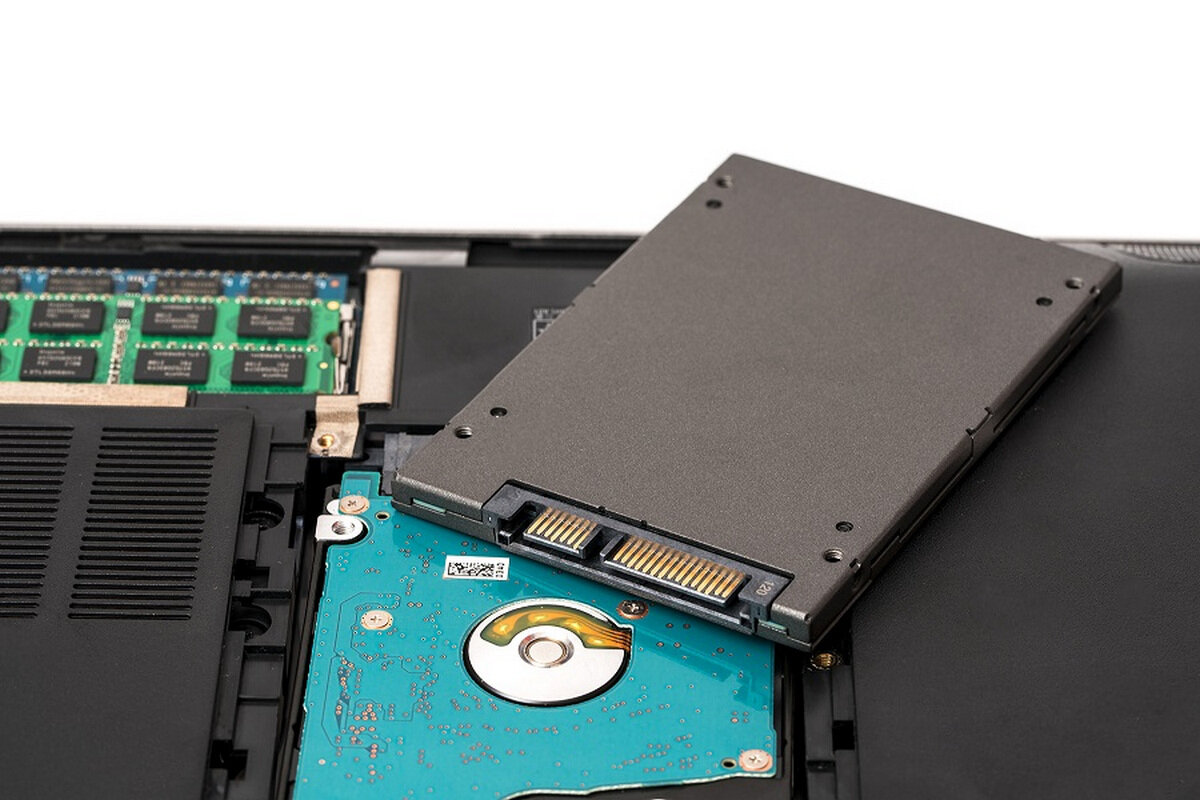

Перенос ОС с HDD на SSD

С приобретением SSD обычно приходится устанавливать ОС и всё программное обеспечение заново. Рассматриваемый инструмент позволяет это сделать без установки ОС на новый диск. Для этого необходимо подключить SSD к ПК и следовать инструкции мастера. Операция позволяет сделать дубль всей ОС с установленными на ней программами.

Восстановление данных

Функция восстановления позволяет найти утраченные данные или стёртые разделы. Программа позволяет выполнять как быстрый поиск, так и более глубокий, который, соответственно, подразумевает большие временные затраты, чем предыдущий. Последний вариант поиска использует технологию сканирования каждого сектора, находя в нём любую информацию.

Разделение и расширение разделов

Возможность разделения или объединения разделов также присутствует в данном ПО. Ту или иную операцию можно выполнить без потери каких-либо данных накопителя. Пошагово следуя мастеру настройки, можно без проблем расширить раздел или разделить его, введя желаемые размеры.

Загрузочный USB

Запись ОС Windows на флеш-устройство также возможна в этой программе. При выборе функции необходимо подключить USB и открыть на ПК файл-образ с операционной системой.

Проверка диска

Подразумевает поиск битых секторов и всплывающих ошибок, которые имеются на диске. Для выполнения этой операции программа использует стандартное приложение ОС Windows под названием chkdsk.

Преимущества

- Широкий функционал;

- Русскоязычная версия;

- Бесплатная лицензия;

- Удобный интерфейс.

Недостатки

- Отсутствует опция дефрагментации;

- Недостаточно глубокий поиск утраченных данных.

Наличие мощного инструментария делает программу востребованной в своем роде, тем самым привлекая своих сторонников использовать различные функции для изменения стандартных данных жёстких дисков. Благодаря набору практически всех операций с накопителями программа станет отличным подручным средством для пользователя.

AOMEI Partition Assistant Pro позволяет создавать, удалять, изменять размеры, производить форматирование разделов жесткого диска, объединять, разделять и перемещать их (или копировать), в том числе на другой жесткий диск или SSD-диск.

Приложение предоставляет пользователям пошаговый интерфейс для выполнения основных действий, связанных с управлением разделами жесткого диска. С помощью пошаговых действий, можно быстро выполнить необходимую работу без потери данных.

Поддерживает все устройства хранения данных, такие как: флэш-диски, HDD, SSD, RAID-массивы с обоими: MBR и GPT стилями раздела диска.

Кроме того, PA включает возможности AOMEI Dynamic Disk Manager Pro (DDM), что означает наличие возможности управления динамическим томом диска.

Основные возможности AOMEI Partition Assistant Pro

- Миграция ОС на SSD/HDD: Для многих пользователей SSD, эта простая технология может помочь перенести свою ОС на SSD и сохранить оригинальную систему.

- Восстановление разделов: восстановление потерянных или удаленных разделов за несколько шагов.

- Выравнивание разделов: ускорение работы дисков при прочтении и записи данных, особенно дисков SSD.

- Создание загрузочных CD: выполняет безопасное управление разделами диска в режиме WinPE и загрузка с CD/DVD, флэш-памяти USB.

- Перезапись MBR: перезапись с главного загрузочного диска на испорченный жесткий диск MBR для простого восстановления.

- Конвертация между GPT и MBR: конвертация с диска GPT на MBR без потери данных и обратно.

- Управление разделами Linux: создание, удаление, форматирование, копирование, уничтожение, восстановление разделов Ext2/Ext3.

- Изменение типа разделов (ID) и изменение серийного номера.

- Создание динамических разделов диска: установка зеркальных томов на Windows для устойчивости к ошибкам.

- Удаление и форматирование разделов с файловыми системами FAT или NTFS.

- Изменение размеров и местоположения динамических дисков, без потери данных.

- Сокращение динамических разделов для использования максимального пространства на диске.

- Расширение динамической системы/ объема загрузок для оптимальной работы компьютера.

Бесплатная лицензия AOMEI Partition Assistant Pro

Для получения бесплатной лицензии AOMEI Partition Assistant Pro выполните следующие действия:

1. Скачайте бесплатную версию AOMEI Partition Assistant Standard по ссылке ниже:

Поддерживаемые ОС Windows: 10 / 8.1 / 8 / 7 / Vista / XP 32|64-bit

2. Установите программу и активируйте версию Professional (Pro) следующим кодом лицензии в меню Register:

Условия предложения

- Это пожизненная лицензия только для версии 8.5, для домашнего (некоммерческого) использования.

- Нет бесплатной технической поддержки

- Может быть установлен или переустановлен в любое время

Вы также можете воспользоваться бесплатной версией AOMEI Partition Assistant Standard.

Easy-to-use Partition Software and Safe Disk Manager

The Overview of AOMEI Partition Assistant

AOMEI Partition Assistant contains more than 30 valuable functions, which can fix the problem “low disk space”, address the problem of irrational disk partition, and re-partition a hard drive without losing data. In a word, it can manage your hard disks and partitions in the most reasonable state. Besides, it supports you to migrate OS to SSD, copy hard drive to another HDD/SSD, convert disk between MBR and GPT, etc.

Main Functions:

Multiple Partition Manager: Resize/MoveCreate/Delete/Format/Split/Align/Merge partitions, etc.

Multiple Partition Wizard: Extend Partition Wizard, Disk Copy Wizard, Partition Copy Wizard, Partition Recovery Wizard, Make Bootable CD Wizard, etc.

Other Features: Migrate OS to SSD or HDD, Wipe Hard Drive, Rebuild MBR, Windows to Go Creator, Integrate to Recovery Environment, etc.

For Home and Business

An all-in-one and easy-to-use disk partition manager to help users to manage hard drive and partition.

It supports Windows PC operating systems, including Windows XP/Vista/7/8/8.1/10 (both 32 and 64 bit).

Partition Assistant Standard Edition

A magical and Free software contains a variety of partition management functions and allows you to manage your partitions and hard drives of PC. You can use it to resize, merge, create, delete or format partitions.

Partition Assistant Professional Edition

A professional and paid version covers more features. Compared with AOMEI Partition Assistant Standard Edition, the professional edition has more advanced functions, such as allocate free space from one partition to another, convert disk between dynamic and basic, etc.

For Server Users

A great partition manager For Windows Server users and Windows PC users.

It supports all Windows PC operating systems, and all Windowsw Server operating systems, including Windows Server 2000, 2003, 2008, 2012, 2016, 2019 (both 32 and 64 bit).

Partition Assistant Lite Edition

A free and easy partition manager that offers Windows Server and PC users to cope with basic problems about hard drives and partitions. It allows you to partition hard dirve on Windows Server operating systems.

Partition Assistant Server Edition

An advanced edition for Windows Server users. It is a reliable partition software that helps you to optimize the performance of your servers. It contains all features of AOMEI Partition Assistant that can easily solve hard disk partition problems of small and medium sized business.

For Enterprise and Service Providers

Advanced and reliable partition software that designed for enterprise to manage hard drives and partitions.

Supports both Windows PC and Server operating systems.

Partition Assistant Unlimited Edition

All features and functions are configured in AOMEI Partition Assistant Unlimited Edition, and it can be installed in Unlimited PCs and Servers within one company.

Partition Assistant Technician Edition

The most advanced edition includes Lifetime free upgrades. The buyer can use this software to provide profitable technical service to unlimited PCs and servers of unlimited companies and individuals.

Every edition has its own features, if you want to know the detailed difference on every version, you can visit edition comparison of AOMEI Partition Assistant.

Purchase Guarantee

Order process is secured by 256-bit SSL and 100% safe.

License code will be immediately delivered to your email

90-Day Unconditional Money Back Guarantee.

SPECIAL OFFERS

AOMEI Partition Assistant Professional

AOMEI Backupper Professional

All-in-one partition software & hard disk manager for 2 PCs. Complete and easy-to-use backup & restore software for 1 PC. Both support lifetime upgrades to every latest version.

$73.42 $104.90 Save Now

AOMEI Partition Assistant Server

AOMEI Backupper Server

Powerful and magic hard disk partition management tool for 2 servers. Stable and robust data protection & disaster recovery solution for a single server. Both support lifetime free upgrades to very latest version.

Stable and robust data protection & disaster recovery solution for a single server. Both support lifetime free upgrades to very latest version.

GW2 и SSD диск, стоит ли?

Как ускорить установку клиента игры и загрузку Guild Wars 2 между локациями? Прочтите сказку, сделайте выводы:

В этой статье Вы прочитаете о том, что такое SSD диск, как он влияет на производительность компьютера и Guild Wars 2.

Начнем с описания SSD диска и того, чем он отличается от обычного жесткого диска или HDD. В этом нам поможет википедия!

Solid—State Drive (сокр. SSD) — Твердотельный накопитель — компьютерное немеханическое запоминающее устройство на основе микросхем памяти. Кроме них, SSD содержит управляющий контроллер.

Различают два вида твердотельных накопителей: SSD на основе памяти, подобной оперативной памяти компьютеров, и SSD на основе флэш-памяти.

В настоящее время твердотельные накопители используются в компактных устройствах: ноутбуках, нетбуках, коммуникаторах и смартфонах.

Из выше написанного важно усвоить следующее – в основном SSD диски устанавливаются в мобильную технику. Новые диски помогают усилить эффект «Вау» у покупателя, который видит, что на ноутбуке «все летает и быстро открывается». Да, SSD диски улучшают производительность компьютеров. Еще одна причина установки в мобильную технику – человеческий фактор. Часто переносные устройства падают на пол и тогда можно прощаться с данными – жесткий диск выходит из строя. С твердотельным накопителем такого случится не может.

Причина, почему SSD диски еще не завоевали компьютерный рынок настольных систем одна – высокая цена. Однако, уже сейчас цены падают и скоро достигнут ту же категорию цен, какую занимают обычные HDD. А пока продвигающим фактором остаются мобильные системы.

Чем же отличается жесткий диск от твердотельного? (Читай, HDD от SSD?)

Дело в том, что в SSD нет механических частей. В них не применяется магнитная запись, и нет вращающихся блинов-дисков. Вместо них планка флеш-памяти, которая очень похожа на оперативную. Раз нет механических частей, значит скорость доступа к данным очень высока. От SSD диска Вы никогда не услышите шума, который производят обычные жесткие диски.

Вместо них планка флеш-памяти, которая очень похожа на оперативную. Раз нет механических частей, значит скорость доступа к данным очень высока. От SSD диска Вы никогда не услышите шума, который производят обычные жесткие диски.

+ Экономия электроэнергии

+ Скорость чтения и записи ограничена только пропускной способностью интерфейса и контроллеров на материнской плате (SATA 3GB/s или SATA 6GB/s и т.д)

+ Малые габариты и вес

+ Производительность компьютера вырастает на глазах

+ Прочность при ударах

+ Отсутствие шума

— Ограниченное количество циклов перезаписи. Обычная флеш-память позволяет переписать данные примерно 10 000 раз.

— Высокая цена

— Срок жизни – 3 года (Если не нагружать SSD диск, он будет стабильно отрабатывать 3 года, но главное быть готовым к срокуJ)

Классно! Хочу SSD диск!

Если такое желание уже появилось – прекрасно, можно задуматься о накоплении денежных средств к покупке. Пока же, главное понять, что SSD диск берется ради скорости, а не файлопомойки. Диск с объемом памяти 60-128 ГБ обойдется Вам в 100-200$. Однако, стоит подчеркнуть, что на данный момент это совсем не дорого для скоростного диска.

Пока же, главное понять, что SSD диск берется ради скорости, а не файлопомойки. Диск с объемом памяти 60-128 ГБ обойдется Вам в 100-200$. Однако, стоит подчеркнуть, что на данный момент это совсем не дорого для скоростного диска.

Как SSD диск улучшает производительность компьютера?

Хороший вопрос. Если поставить на SSD диск систему, 1-2 игры и часто использующиеся программы, Вы увидите, как сильно вырастит производительность своими глазами. Загрузки Windows будут проходить в секунды, то же самое касается установки и открытия программ/игр. Помимо этого оценка производительности компьютера, наконец, покажет Вам значение выше 5.9. Так как оценка выставляется по наиболее слабому компоненту в компьютере, им всегда является жесткий диск, который зарабатывает 5.9.

Сравнение скорости

Скорость чтения и записи SSD диска на 64ГБ

Скорость чтения записи обычного жесткого диска на 1ТБ

Если установить на SSD диск систему и пару ММО + программы, такие как фотошоп, скайп, офис, браузер и еще что-нибудь, то диск спокойно проживет у Вас 3 года. Не бойтесь перезаписи. И потому не стоит отключать файл подкачки, как советуют во многих руководствах. При отключении можно словить кучу глюков. Основной Ваш враг – страх за долгожительство диска, а это глупости. Если не устанавливать на SSD диск тяжелые программы для обработки видео, то вреда диску не будет. Он спокойно проживет 3 года.

Не бойтесь перезаписи. И потому не стоит отключать файл подкачки, как советуют во многих руководствах. При отключении можно словить кучу глюков. Основной Ваш враг – страх за долгожительство диска, а это глупости. Если не устанавливать на SSD диск тяжелые программы для обработки видео, то вреда диску не будет. Он спокойно проживет 3 года.

Я все больше хочу SSD! Как он поможет в игре Guild Wars 2?

Основные показатели – вырастет скорость загрузки локаций. Она сократится с 10-15 секунд до 5.

Уменьшится количество лагов при большом скоплении игроков. Вы увидите пользу диска в динамических событиях, sPvP и WvW.

Пропадут проблемы с разворотом камеры в игре, если в кадре присутствует много объектов или людей.

Как оптимально настроить SSD накопитель по Windows 7

В этой статье мы поговорим о настройке SSD накопителя под операционную систему Windows 7. Что для этого необходимо сделать и для чего вообще настраивать SSD устройства в Windows 7 рассмотрим далее.

Итак, совсем недавно мой знакомый покупал мощный компьютер. И для большей скорости работы было принято решение установить туда SSD накопитель для установки на него операционной системы.

Давайте разберемся чем отличается SSD от обычного HDD. Как говорит нам Википедия :

SSD — Твердотéльный накопитель (англ. solid-statedrive, SSD) — компьютерное немеханическое запоминающее устройство на основе микросхем памяти. Кроме них, SSD содержит управляющий контроллер.

В отличие от SSD, HDD это накопитель на жёстких магнитных дисках или НЖМД (англ. hard (magnetic) diskdrive, HDD, HMDD), жёсткий диск, в компьютерном сленге «винче́стер» — запоминающее устройство (устройство хранения информации) произвольного доступа, основанное на принципе магнитной записи. Является основным накопителем данных в большинстве компьютеров.

Основным преимуществом SSD перед стандартным винчестером является отсутствие механических (движущихся) частей, что увеличивает его надежность. Также преимущество SSD это высокая скорость работы, он меньше нагревается и не издает никаких звуков при работе. Но у SSD, помимо многих преимуществ, есть и недостатки. Основным недостатком SSD является ограниченное количество циклов записи/перезаписи. Обычная (MLC, Multi-level cell, многоуровневые ячейки памяти) флеш-память позволяет записывать данные примерно 10 000 раз. Более дорогостоящие виды памяти (SLC, Single-level cell, одноуровневые ячейки памяти) — около 100 000 раз. Для того чтобы уменьшить количество обращений к SSD накопителю и, соответственно, продлить ему жизнь необходима его тонкая настройка. Ну и еще один недостаток — это несовместимость со старыми ОС (ниже Windows Vista).

Но у SSD, помимо многих преимуществ, есть и недостатки. Основным недостатком SSD является ограниченное количество циклов записи/перезаписи. Обычная (MLC, Multi-level cell, многоуровневые ячейки памяти) флеш-память позволяет записывать данные примерно 10 000 раз. Более дорогостоящие виды памяти (SLC, Single-level cell, одноуровневые ячейки памяти) — около 100 000 раз. Для того чтобы уменьшить количество обращений к SSD накопителю и, соответственно, продлить ему жизнь необходима его тонкая настройка. Ну и еще один недостаток — это несовместимость со старыми ОС (ниже Windows Vista).

Далее рассмотрим, что конкретно необходимо выполнить для настройки твердотельного накопителя под операционной системой Windows 7. Т. к. когда я настраивал товарищу SSD, скриншотов не делал, то буду выполнять эти настройки на своем стареньком компьютере с обычным HDD.

Итак поехали.

Пункт первый: отключаем гибернацию. Отключать ее нужно по той причине, что каждый раз при переходе компьютера в этот режим, на жесткий диск пишется большой объем информации, а я ее отключаю всегда, потому, что иной раз из этого режима сложно выйти. К тому же отключив гибернацию мы освободим место на системном диске примерно равное объему оперативной памяти. Гибернация нужна для быстрой загрузки операционной системы, но так как у нас установлен SSD накопитель, то Windows и так загружается всего за 5-10 секунд. Для отключения гибернации запускаем командную строку (Пуск — Выполнить тут пишем команду cmd) . В командной строке прописываем powercfg.exe /hibernate off . После перезагрузки компьютера вы увидите освободившееся место на системном диске.

К тому же отключив гибернацию мы освободим место на системном диске примерно равное объему оперативной памяти. Гибернация нужна для быстрой загрузки операционной системы, но так как у нас установлен SSD накопитель, то Windows и так загружается всего за 5-10 секунд. Для отключения гибернации запускаем командную строку (Пуск — Выполнить тут пишем команду cmd) . В командной строке прописываем powercfg.exe /hibernate off . После перезагрузки компьютера вы увидите освободившееся место на системном диске.

Или идем в «Пуск» — «Панель Управления» – «Электропитание» – «Настройка плана электропитания» – «Изменить параметры питания» – находим пункт «Сон», раскрываем его, пункт «Гибернация после» вводим значение «0».

Пункт второй: переносим папку для хранения временных файлов TEMP на обычный HDD.

Для этого нажимаем правой кнопкой по значку «Мой компьютер» — «Свойства» – «Дополнительные параметры системы» – вкладка «Дополнительно» — кнопка «Переменные среды» — и меняем путь переменной TMP и TEMP на другую папку (я создал ее заранее на диске D:\).

Пункт третий: отключаем «Защиту системы».

Для отключения защиты системы жмем правой кнопкой мыши по «Мой компьютер» — «Свойства» — «Защита системы» — вкладка «Защита системы» — «Настроить» — «Отключить защиту системы».

При отключении защиты системы, в случае ее отказа, мы не сможем восстановиться из резервной копии, но оно нам и не нужно, ведь система устанавливается за каких-то 10-15 минут.

Пункт четвертый: переносим файл подкачки на второй винчестсер. Для этого нажимаем правой кнопкой мыши на «Мой компьютер» — «Свойства» — «Дополнительные параметры системы» — вкладка «Дополнительно» — раздел «Быстродействие» — кнопка «Параметры». Тут меняем параметры как на рисунке (в зависимости от свободного места на диске D:\ можно задать и больший объем).

Пункт пятый: отключение индексации.

Индексация необходима для ускорения поиска по диску. Но, к примеру, я ни разу не пользовался поиском, к тому же на SSD поиск и без нее работает быстро. Поэтому данную опцию можно смело отключать. Для этого заходим в «Мой компьютер», жмем ПКМ на диск С:\, пунк выпадающего меню «Свойства». Во вкладке «Общие» убираем галочку с пункта «Разрешить индексировать содержимое файлов на этом диске в дополнение к свойствам файлов».

Поэтому данную опцию можно смело отключать. Для этого заходим в «Мой компьютер», жмем ПКМ на диск С:\, пунк выпадающего меню «Свойства». Во вкладке «Общие» убираем галочку с пункта «Разрешить индексировать содержимое файлов на этом диске в дополнение к свойствам файлов».

Или можно убрать индексацию для всех дисков отключив службу «WindowsSearch». Для этого идем в «Панель управления» — «Администрирование» – «Службы» – находим нашу службу и кликаем по ней два раза – выбираем тип запуска «Вручную» и жмем кнопку «Остановить».

Пункт шестой: отключаем Preftch и RedyBoot.

Prefetch это технология, позволяющая ускорить загрузку Windows за счет упреждающего чтения данных с диска. Для SSD она не нужна, потому что SSD и так имеет высокую скорость рандомного чтения данных.

Для отключения Prefetch запускаем редактор реестра (Пуск – Выполнить – пишем regedit и жмем Enter). Далее открываем ветку реестра:

HKEY_LOCAL_MACHINES\SYSTEM\CurrentControlSet\Control\Session Manager\Memory Management\PrefetchParameters

и меняем на «0» значение ключа Enable Prefetcher.

RedyBoot это дополнение к Prefetch. Для для того чтоб его отключить идем по пути:

HKEY_LOCAL_MACHINES\SYSTEM\CurrentControlSet\Control\WMI\Autologger\ReadyBoot

Тут меняем на «0» значение параметра Start.

Пунк седьмой: перенос КЭШей приложений. Тут, в первую очередь имеется ввиду перенос КЭШа браузера на второй жесткий диск. Как это делать я описывать не буду, потому что для каждого браузера способ свой. Поэтому, если вы решите перенести кэш на второй винчестер, то гугл вам в помощь. Но я бы вообще не делал этого, ведь SSD мы установили для ускорения работы, а перенос КЭШа на второй HDD скорости нам не прибавит. Вообщем решать вам.

Еще необходимо отключать дефрагментацию, но для Windows 7, в отличие от Vista, дефрагментация, при установке на SSD накопитель отключается автоматом (то же пишут и про Prefetch и RedyBoot, но у меня они не были выставлены на «0», так что проверяйте).

На этом все. В интернете можно найти еще советы по оптимизации SSD под Windows 7, но они уже не так важны как эти. Впрочем даже без подобной настройки SSD прослужит довольно долго, но если вы хотите максимально возможно продлить ему жизнь, то рекомендую выполнить вышеперечисленные пункты. Плюс ко всему мы немного освободим место на системном диске, а учитывая себестоимость гигабайта памяти для SSD, это вполне оправдано.

Впрочем даже без подобной настройки SSD прослужит довольно долго, но если вы хотите максимально возможно продлить ему жизнь, то рекомендую выполнить вышеперечисленные пункты. Плюс ко всему мы немного освободим место на системном диске, а учитывая себестоимость гигабайта памяти для SSD, это вполне оправдано.

Также рекомендую прочитать:

Загрузка…5 неизвестных функций Википедии — «Хакер»

Содержание статьи

Думаю, что многие из вас даже не подозревали, что на сайте Википедии можно зарегистрироваться. Ещё меньше людей знают о том, что у Википедии есть бета-секция, в которой можно включить достаточно интересные функции, о которых мы расскажем ниже.

Сперва нужно зарегистрироваться. Для этого переходим сюда. Процедура стандартная. Теперь идём в бета-секцию. Здесь есть несколько функций, которые можно включить.

Бета-секция

Улучшенный поиск

Поиск почти как в GoogleПоловина наших запросов в Google так или иначе приводят на страницы Википедии. Так зачем же промежуточное звено? Раньше поисковая система Википедии оставляла желать лучшего, теперь она показывает не только результаты по запросу, но и актуальные статьи, ранжируя их по популярности.

Так зачем же промежуточное звено? Раньше поисковая система Википедии оставляла желать лучшего, теперь она показывает не только результаты по запросу, но и актуальные статьи, ранжируя их по популярности.

Карточки

Карточки экономят несколько кликовУдобная штука, которая точно сэкономит пару кликов. При наведении на любую активную ссылку будет отображаться карточка с краткой информацией. То есть вам не придётся переходить по ссылке, чтобы узнать самое важное.

Другие проекты

Другие проектыДругие проекты — это бета-функция, которая включает отображение в боковом меню остальных проектов Википедии: Викитеки, Викицитатника, Викисклада и Викиданных. Таким образом, ты можешь кликнуть на один из них и найти данные по своему запросу там.

Компактная личная панель

Эта функция упрощает личную панель и скрывает списки инструментов, давая к ним доступ лишь тогда, когда это нужно.

Ускорение загрузки больших материалов с помощью HHVM

HHVM, или HipHop Virtual Machine — это виртуальная машина для PHP, которая ускоряет его работу. К сожалению, у меня вообще нет этой настройки в бета-секции, и решения своей проблемы я найти не смог. Думаю, что это связано с тем, что функция не работает на Mac.

К сожалению, у меня вообще нет этой настройки в бета-секции, и решения своей проблемы я найти не смог. Думаю, что это связано с тем, что функция не работает на Mac.

Те, кто её подключили, говорят, что большие статьи действительно загружаются быстрее. Маленькие материалы — без изменений.

В бета-секции есть ещё несколько функций, к примеру визуальный редактор для статей, компактная панель языков и прочее. Однако эти функции не слишком интересны обычному пользователю, к тому же их описание можно прочитать прямо в Википедии. Все перечисленные выше функции можно подключить уже сейчас. Спустя некоторое время, когда они пройдут проверку и выйдут из бета-тестирования, ими можно будет пользоваться без приведённых махинаций.

Тестирование 2,5″ (U.2) NVMe SSD HGST SN100

Характеристики HGST SN100

- Объём: 0,8 ТБ, 1,6 ТБ, 3,2 ТБ

- Форм-фактор: U.2 (2,5″, высота 15 мм)

- Интерфейс: PCI-E 3.0 x4

- Производительность (в скобках — для модели 0,8 ТБ)

- Последовательный доступ (блок 128КиБ): чтение — 3000 (2600) МБ/с, запись — 1600 (1400) МБ/с

- Случайный доступ (блок 4 КиБ): чтение — 743 (634) тыс.

IOPS, запись — 140 (80) тыс. IOPS, 70/30 чтение/запись — 310 (190) тыс. IOPS

IOPS, запись — 140 (80) тыс. IOPS, 70/30 чтение/запись — 310 (190) тыс. IOPS - Случайный доступ (блок 8 КиБ): чтение — 385 (330) тыс. IOPS, запись — 75 (42) тыс. IOPS

- Средняя задержка (блок 512 байт, случайный доступ, запись): 20 мкс

- Поддержка T10 DIF. Размер сектора: 512/520/528 и 4096/4160/4224 байт

- Ресурс: 3 DWPD

- Максимальное энергопотребление: 25 Вт

- Гарантийный срок: 5 лет

Подробнее — в официальной спецификации.[4]

Результаты тестирования

Условия тестирования

Конфигурация тестового стенда:- Два процессора Intel Xeon E5-2660 V3 (10 ядер, 2,6 ГГц, HT включен)

- 64 ГБ памяти

- Платформа 1028R-WC1R, системная плата Supermicro X10SRi-F, BIOS v 2.0

- CentOS Linux 7 X86_64

- Для генерации нагрузки применялся FIO версии 2.8

- Использовался штатный драйвер NVMe

- HGST Ultrastar SN100 1.

6TB HUSPR3216ADP301

6TB HUSPR3216ADP301 - Прошивка: KMGNP120

- Объём: 1600321314816 байт (1490,4 ГиБ)

Методика тестирования SSD неоднократно описывалась в наших предыдущих статьях. Актуальное описание можно увидеть в статье Тестирование NVMe SSD Intel P3608. Полное тестирование не проводилось из-за идентичности накопителей SN150 и SN100 — в феврале тестировался SN150 аналогичного объёма. Был повторён тест с измерением задержки при варьировании количества потоков (1–4) и глубины очереди (1–128).

SNIA PTS: latency test

В таблице приведены данные для одного потока с QD=1. Данные отличаются от SN150 по причине перехода с CentOS 6 на CentOS 7. Процессор остался прежним — Xeon E5-2660 V3, но из-за перехода на 2-процессорную платформу понадобилась дополнительная оптимизация с учётом NUMA. Для этого сначала был определён процессор (точнее, узел NUMA), к которому подключён накопитель. В Linux это можно сделать, посмотрев топологию подключения при помощи lspci:

lspci -tv \-[0000:00]-+-00.Затем узел NUMA можно посмотреть в0 Intel Corporation Xeon E7 v3/Xeon E5 v3/Core i7 DMI2 +-01.0-[01]--+-00.0 Intel Corporation I350 Gigabit Network Connection | \-00.1 Intel Corporation I350 Gigabit Network Connection +-02.0-[02-03]----00.0 HGST, Inc. Ultrastar SN100 Series NVMe SSD +-02.1-[04-05]----00.0 HGST, Inc. Ultrastar SN100 Series NVMe SSD

/sys/devices/pci*/*/numa_node и запустить fio с параметром numa_cpu_nodes=x (где x — номер узла NUMA).| HGST SN100 1.6TB | Intel P3608 (P3600 0.8TB) | |||

| Задержка | 4КиБ | 8КиБ | 4КиБ | 8КиБ |

| Средняя | ||||

| Чтение | 97 | 109 | 67 | 101 |

| Запись | 22 | 26 | 16 | 18 |

| Чтение/запись 70/30% | 120 | 162 | 92 | 139 |

| 99% | ||||

| Чтение | 266 | 185 | 125 | 153 |

| Запись | 33 | 41 | 31 | 31 |

| Чтение/запись 70/30% | 354 | 3345 | 182 | 400 |

| 99,99% | ||||

| Чтение | 2015 | 226 | 2832 | 2812 |

| Запись | 44 | 59 | 79 | 86 |

| Чтение/запись 70/30% | 3120 | 7100 | 3096 | 3180 |

Сравнение с Intel P3600

Приведены графики зависимости задержки (среднее значение, 99% и 99,99% перцентили) от IOPS при варьировании количества потоков (1–4) и глубины очереди (1–128). Пунктирные линии соответствуют накопителю Intel P3608 1,6 ТБ из предыдущего теста.[2] Intel P3608 представляет собой два накопителя P3600 в общем корпусе, данные приведены для одной «половины» объёмом 800 ГБ.

Пунктирные линии соответствуют накопителю Intel P3608 1,6 ТБ из предыдущего теста.[2] Intel P3608 представляет собой два накопителя P3600 в общем корпусе, данные приведены для одной «половины» объёмом 800 ГБ.Средняя задержка.

99% перцентиль задержки.

99,99% перцентиль задержки.

SNIA PTS: Host Idle Recovery

Графики для этого теста приведены для одной половины накопителя. Напомним, что данный тест проводится после предыдущего, т.е. накопитель находится в режиме насыщения, с небольшим запасом подготовленных для записи ячеек. Производительность на запись снижена, далее мы даём накопителю возможность восстановить её, прерывая серию из 360 раундов с непрерывной нагрузкой (чёрный цвет на графике) сериями из 360-ти раундов с увеличивающимися паузами:

- 5 секунд нагрузки + 5 секунд паузы

- 5 секунд нагрузки + 10 секунд паузы

- 5 секунд нагрузки + 15 секунд паузы

- 5 секунд нагрузки + 25 секунд паузы

- 5 секунд нагрузки + 50 секунд паузы

5-секундных пауз хватает на восстановление IOPS до уровня «свежего» накопителя. По мере увеличения пауз производительность стабилизируется.

По мере увеличения пауз производительность стабилизируется.

Средняя задержка сразу же снижается с 1,8 до диапазона 0,6–0,7 мс, и в дальнейшем стабилизируется.

Перцентиль 99,99%. На начальном этапе мы видим уровень до 20-30 мс, в дальнейшем значение практически никогда не выходит за границы 7–8 мс.

Два HGST SN100

Напоследок — результаты с двух накопителей HGST SN100, объединённых в зеркало:- Случайный доступ, блок 4 КиБ, 10 потоков с QD=128: 1565000 (1,5 миллиона) IOPS при средней задержке в 1,6 мс (99,9% сравнительном тестировании SAS контроллеров нам удалось получить «всего лишь» 1,1 млн. IOPS при 100% нагрузке на 12-ядерный Xeon E5-2690 V3 – накладные расходы по обработке ввода-вывода через традиционный стек SCSI в ОС выше в сравнении с NVMe.

- Последовательный доступ, блок 128 КиБ, 4 потока с QD=128: 6774 МиБ/с. Вполне ожидаемый результат, ограниченный пропускной способностью 8 линий PCIe 3.0.

Заключение

Все сказанное насчёт SN150 можно отнести и к SN100 — хорошая производительность, отличное соотношение цена/производительность. Немного не хватает лишь линейки с существенно большим ресурсом (10 DWPD), но текущие 3 DWPD можно увеличить, отформатировав накопитель на меньший объём. Дополнительный плюс HGST SN100 как накопителя в форм-факторе U.2 — совместимость с платформами Supermicro.

Немного не хватает лишь линейки с существенно большим ресурсом (10 DWPD), но текущие 3 DWPD можно увеличить, отформатировав накопитель на меньший объём. Дополнительный плюс HGST SN100 как накопителя в форм-факторе U.2 — совместимость с платформами Supermicro.

Примечания

[1] Пространство имён NVMe (англ. NVMe namespace) — область накопителя NVMe, отформатированная для блочного доступа. Пространства имён могут иметь различные размеры сектора или могут использоваться виртуальными машинами через SR-IOV.

[2] Прямое сравнение является не совсем корректным из-за разницы в объёме. К тому же выяснилось, что P3608/P3600 демонстрирует лучшие результаты под Windows.

Ссылки

[1] Тестирование NVMe-совместимого PCI-E SSD HGST SN150. True System.

[2] Ultrastar SN100 Series PCIe SSD. HGST.

[3] Ultrastar SN100 Series PCIe SSD datasheet. HGST.

[4] 1028R-WC1R. Supermicro.

[5] Supermicro NVMe Platforms. Supermicro.

Supermicro.

[6] Expanding platform capabilities by enabling Hot-Plug support of Intel NVMe SSDs. Intel.

[7] Lance Shelton High Performance I/O with NUMA Systems in Linux. Fusion-IO.

Топ-10 твердотельных накопителей 2021 года

Заметки редактора

23 декабря 2020 г.:

Средний ПК будет значительно ускорен, разумно и рассчитан на будущее с помощью или, но если вы хотите перейти к следующему шагу, стоит взглянуть на модель PCIe 4.0, такую как или, хотя последний использует особенно громоздкий радиатор, который не поместится во всех конфигурациях. Он относится к тому же классу скорости и также поставляется в облегченной версии, но без радиатора, который вам, вероятно, понадобится, чтобы избежать дросселирования и потенциального повреждения.

Что касается внешней стороны, то здесь используется как стандарт USB 3.2, так и Thunderbolt 3, что делает его очень универсальным, в то время как его размер примерно такой же, как у портативного хранилища NVMe. Это, конечно, по-прежнему отличный выбор, обещающий высшую скорость, хотя и по такой же высокой цене.

Это, конечно, по-прежнему отличный выбор, обещающий высшую скорость, хотя и по такой же высокой цене.

16 декабря 2020 г.:

Мир твердотельных накопителей продолжает стремительно развиваться и расти. Как и в случае с большинством компьютерного оборудования, существует множество спецификаций, различных форм-факторов и проблем совместимости, которые могут сбивать с толку.Если вы хотите создать новую систему или обновить ее, важно помнить о том, какие типы соединений будет поддерживать ваша система.

Такие модели, как Samsung 860 QVO и Crucial MX500, используют Serial ATA, также известный как соединение SATA. Некоторые портативные устройства, такие как Samsung T5 и Sandisk Extreme, могут быть подключены к порту USB Type-C, а также могут работать с более старыми портами USB. Самые современные компьютерные системы будут иметь оба этих типа соединений.

Такие устройства, как Seagate Barracuda 510, нуждаются в интерфейсе другого типа, известном как PCI Express. Для них требуется специальный слот на материнской плате, и они несовместимы с традиционными разъемами SATA.

Для них требуется специальный слот на материнской плате, и они несовместимы с традиционными разъемами SATA.

Рассматривая цифры и спецификации, не стесняйтесь копаться настолько глубоко, насколько захотите, поскольку это, безусловно, часть удовольствия, когда дело доходит до выбора нового оборудования. Любой из этих вариантов обеспечит заметное увеличение скорости по сравнению с традиционными жесткими дисками.Мы попытались выбрать лучшие варианты и включили разные модели для разных нужд.

В этом обновлении мы удалили четыре элемента: OWC Envoy Pro EX, My Passport и Adata SE730H. Мы заменили их на модели, которые, как нам кажется, предлагают более выгодные. Мы также обновили списки Samsung T5, The и Crucial MX500. Мы также удалили предыдущий список для Samsung 860 Evo из-за проблем с доступностью. Он был заменен на более популярную версию с форм-фактором SATA, Samsung 860 Evo Internal, а его описание и детали были изменены, чтобы соответствовать новому элементу.

Sandisk Extreme — отличный портативный вариант, рассчитанный на падение с высоты до двух метров. Samsung 860 Evo Internal — одна из лучших доступных 2,5-дюймовых моделей, надежность которой была высоко оценена как критиками, так и покупателями. Samsung 980 Pro и WD_Black SN750 Internal Gaming — это накопители, совместимые с PCIe, которые обеспечивают исключительную производительность для геймеров и профессионалов. Наконец, Seagate Barracuda 510 — это дополнение компании в стиле NVMe к ее знаменитой линейке традиционных жестких дисков.

Samsung 860 Evo Internal — одна из лучших доступных 2,5-дюймовых моделей, надежность которой была высоко оценена как критиками, так и покупателями. Samsung 980 Pro и WD_Black SN750 Internal Gaming — это накопители, совместимые с PCIe, которые обеспечивают исключительную производительность для геймеров и профессионалов. Наконец, Seagate Barracuda 510 — это дополнение компании в стиле NVMe к ее знаменитой линейке традиционных жестких дисков.

27 мая 2019 г.:

Здесь нужно знать несколько различных форм-факторов, разъемов и скоростей шины. Максимальная скорость шины SATA составляет 6 гигабит в секунду, что теоретически составляет 600 мегабайт в секунду, хотя в реальном мире потолок ниже, обычно около 450 мегабайт в секунду. Шина PCIe может перемещать значительно больше данных и может обрабатывать несколько гигабайт в секунду.

Большинство современных внешних накопителей подключаются с помощью разъемов USB Type-A или Type-C.USB 3.1 Gen 1 и Gen 2, как правило, будут иметь внутри себя наборы микросхем SATA, поскольку они имеют схожий верхний предел. My Passport от Western Digital, Adata SE730H и Samsung T5 — отличные тому примеры. Все они очень устойчивы к ударам и должны хорошо держаться со временем, хотя у Samsung есть несколько более уважаемая родословная. С другой стороны, OWC Envoy Pro EX используют сверхбыстрый стандарт Thunderbolt 3 и хорошо используют накопители PCI NVMe внутри них. Однако они значительно дороже, чем обычные USB-модели.

My Passport от Western Digital, Adata SE730H и Samsung T5 — отличные тому примеры. Все они очень устойчивы к ударам и должны хорошо держаться со временем, хотя у Samsung есть несколько более уважаемая родословная. С другой стороны, OWC Envoy Pro EX используют сверхбыстрый стандарт Thunderbolt 3 и хорошо используют накопители PCI NVMe внутри них. Однако они значительно дороже, чем обычные USB-модели.

Когда дело доходит до содержимого вашего ПК, есть еще кое-что, о чем следует помнить. Шины такие же, но разъемы очень разные. Самые компактные персональные компьютеры используют диски M.2, такие как сверхкомпактный Samsung Evo, который имеет малый форм-фактор и использует шину SATA III. Он примерно так же быстр при записи больших файлов, как любой диск SATA, хотя по скорости произвольного чтения и включения питания он определенно может превосходить.

Если вы обновляете старую машину и переходите от устаревшего жесткого диска, обратите внимание на Crucial MX500 или Samsung QVO. Они работают с огромным количеством старых материнских плат — по сути, они в основном заменяют старые магнитные носители жесткого диска, просто они намного меньше (хотя, что интересно, они потребляют примерно столько же количество электроэнергии, несмотря на отсутствие движущихся частей).

Они работают с огромным количеством старых материнских плат — по сути, они в основном заменяют старые магнитные носители жесткого диска, просто они намного меньше (хотя, что интересно, они потребляют примерно столько же количество электроэнергии, несмотря на отсутствие движущихся частей).

Тем не менее, всем, кто ищет скорость, стоит обратить внимание на диски NVMe. И снова здесь Samsung выходит на первое место. Это очень распространено сейчас и было уже пару лет, поскольку Samsung находится на переднем крае разработки флэш-памяти NAND и контроля качества.Их 970 Evo Plus неизменно считается самым быстрым и надежным. Однако, хотя это лучший, он также очень дорогой. Если вы не хотите ждать загрузки ресурсоемких игр или копирования файлов и не хотите тратить кучу денег, рассмотрите одно из высокоскоростных предложений Adata. Они не могут сравниться со скоростью чтения предложений Samsung, но с точки зрения доступности они намного лучше.

Хранилище файлов — Официальная вики MythTV

Хранилище файлов относится к широкой теме оборудования, программного обеспечения и методологии хранения записей MythTV на компьютере (и в компьютерной сети).

Практически любой современный жесткий диск будет более чем достаточно как по объему, так и по скорости для MythTV. С введением групп хранения в версии 0.21 вы можете использовать столько дисков, сколько захотите, без проблем с LVM или Raid.

Производители жестких дисков

Примечание: Этот раздел будет полон слухов, личных предубеждений и многого другого, вероятно, апокрифического, так что отнеситесь к нему с недоверием и всегда спрашивайте. Если вы добавляете неофициальные данные о конкретном производителе, сделайте отступ на один уровень и подпишите свои комментарии.

В настоящее время [2014] основными производителями потребительских жестких дисков являются Seagate, Western Digital, HGST, Toshiba и Samsung, которые все производят устройства жестких дисков емкостью до 6 ТБ, доступные в последовательном (SATA) интерфейсе или в виде SCSI, хотя это не так вверх по размеру спереди.

Вот некоторые мысли пользователей о жестких дисках. Пожалуйста, не экстраполируйте эти результаты. Для получения значимых результатов проверьте это исследование надежности.

Пожалуйста, не экстраполируйте эти результаты. Для получения значимых результатов проверьте это исследование надежности.

- Seagate Barracudas обычно славятся своей тихой и надежной работой, недавно они вернулись к стандартной 5-летней гарантии. Накопители

- Western Digital работают немного лучше, чем Seagates, за счет того, что они более шумные.

- Hitachi восстанавливается после несколько запятнанной репутации линейки жестких дисков «Deathstar» и производит несколько очень хороших дисков SATA, хотя сам я никогда не использовал их. Накопители Samsung Spinpoint

- получают восторженные отзывы (быстрые, тихие и надежные ) от многих пользователей здесь, в Великобритании, хотя, опять же, я сам никогда ими не пользовался.

Western Digital

WD разделили свои линейки жестких дисков на каждый сегмент рынка (RAID / NAS, системы видеонаблюдения, настольные компьютеры и т. Д.). Фактическое влияние выбора жестких дисков неясно.

- Накопители WD Green — отличный выбор для небольших тихих HTPC.

Они вращаются со скоростью 5200 об / мин, доступны дешево и имеют большую мощность. Они не рекомендуются для системного привода из-за их низкой скорости вращения.

Они вращаются со скоростью 5200 об / мин, доступны дешево и имеют большую мощность. Они не рекомендуются для системного привода из-за их низкой скорости вращения. - Диски WD Red для конфигураций NAS / RAID Диски

- WD Black вращаются со скоростью 7200 об / мин, что при необходимости подходит для традиционных системных дисков.Следует отметить, что твердотельные накопители (SSD) лучше подходят для работы с системными дисками.

Следует отметить, что из-за функции «парковки головы» некоторые модели накопителей WD Green могут иметь избыточное количество оборотов головы в тесте SMART. Можно увеличить тайм-аут для парковки головки, и это, возможно, было исправлено на более поздних жестких дисках.

При использовании дисков WD Green в качестве жесткого диска для хранения мультимедийных данных он может замедляться. Однако из-за различий в прошивке стандартные инструменты Linux не могут переводить диск в режим ожидания по таймеру.Вместо этого используйте hd-idle. Сценарий systemd предоставляется внизу страницы, чтобы разрешить автоматический переход в режим ожидания, когда этот диск НЕ используется в качестве системного диска.

Сценарий systemd предоставляется внизу страницы, чтобы разрешить автоматический переход в режим ожидания, когда этот диск НЕ используется в качестве системного диска.

SSD Производители

С 2013 года твердотельные накопители (SSD) достигли зрелости, доступны по низкой цене и обеспечивают повышение производительности на порядок по сравнению с обычными жесткими дисками. Наиболее заметное улучшение происходит во время процесса загрузки, который может не понадобиться на постоянно включенном HTPC. Обычными производителями по состоянию на 2014 год являются Samsung, Corsair, Crucial, Mach, Intel, Kingston и OCZ.

SSD абсолютно бесшумны (без движущихся частей) и доступны в небольших форм-факторах (mSATA). Емкости по состоянию на 2014 год подходят только для установки системного диска (ОС).

Интерфейсы

В наши дни наиболее часто используются интерфейсы трех типов. Эти интерфейсы:

Имейте в виду, что производительность диска в качестве источника видеосигнала зависит от «постоянной скорости передачи» диска, которая не имеет ничего общего с типом интерфейса или скоростью. Стабильная скорость передачи ограничена «скоростью передачи мультимедиа». Скорость передачи мультимедиа — это скорость передачи данных между головкой и поверхностями диска. Это физическое ограничение , которое используется всеми жесткими дисками независимо от интерфейса. Единственное, что влияет на это: плотность данных на диске, физический размер (область чтения / записи) головок и скорость вращения привода. Все диски с одинаковой скоростью вращения и плотностью данных будут иметь примерно одинаковую скорость передачи данных.Высокопроизводительный накопитель со скоростью вращения 7200 об / мин может обеспечить максимальную скорость передачи мультимедиа около 80 МБ / с независимо от того, является ли интерфейсом SATA или SCSI.

Стабильная скорость передачи ограничена «скоростью передачи мультимедиа». Скорость передачи мультимедиа — это скорость передачи данных между головкой и поверхностями диска. Это физическое ограничение , которое используется всеми жесткими дисками независимо от интерфейса. Единственное, что влияет на это: плотность данных на диске, физический размер (область чтения / записи) головок и скорость вращения привода. Все диски с одинаковой скоростью вращения и плотностью данных будут иметь примерно одинаковую скорость передачи данных.Высокопроизводительный накопитель со скоростью вращения 7200 об / мин может обеспечить максимальную скорость передачи мультимедиа около 80 МБ / с независимо от того, является ли интерфейсом SATA или SCSI.

Производители накопителей не хотят, чтобы вы знали об этом, и отвлекают от этого внимание, подчеркивая скорость интерфейса в своей рекламе. Скорость интерфейса — только преимущество во время пакетов данных. Большинство производителей зашли так далеко, что перестали указывать скорости передачи носителей в своих таблицах спецификаций.

С накопителем с заданной скоростью вращения и плотностью данных единственный способ улучшить общую производительность системы — это использовать форму RAID, в которой используется разборка данных.Это эффективно использует два диска одновременно, так что общая скорость передачи мультимедиа увеличивается вдвое.

SATA

Большинство новых жестких дисков и материнских плат поддерживают новый интерфейс Serial ATA (SATA). Хотя SATA является превосходным стандартом (он поддерживает большую часть подмножества SCSI и включает в себя гораздо меньшие и более тонкие кабели, чем PATA, среди других улучшений), некоторые контроллеры SATA имеют драйверы с закрытым исходным кодом или не имеют драйверов Linux. Это привело к тому, что некоторые системы на базе Linux не могут адекватно использовать SATA из-за плохо функционирующих контроллеров.Эта ситуация уже не так серьезна, как раньше, но вам следует проверить поддержку драйверов вашего оборудования, чтобы быть уверенным.

Чтобы узнать текущий статус поддержки SATA в Linux, вы можете проверить Serial ATA (SATA) в Linux.

Пожалуйста, имейте в виду, что встроенные программные функции RAID на микросхемах SATA обычно не будут работать в Linux без серьезных изменений в ядре (если вообще будут). Поскольку Linux предоставляет собственные программные функции RAID, это не большая потеря для выделенного Linux-устройства (например, системы MythTV), но если вы выполняете двойную загрузку, вы не сможете использовать программный RAID контроллера.

SAS

Примечание: SAS предназначены для приложений промышленного масштаба и чрезмерны для домашней установки MythTV, этот раздел предназначен только для информации.

SAS, или Serial Attached SCSI, — это новая технология, которая берет лучшее от SCSI и SATA и во многих отношениях сравнивается с Fibre Channel (например, с технологией SAN) и USB. Большинство современных серверов уже поставляются с SAS вместо SCSI, и в конечном итоге ожидается, что они станут стандартом для настольных компьютеров. На сегодняшний день пропускная способность шины составляет 3 Гбит / с, а к 2011 году планируется увеличить до 12 Гбит / с. Отдельные диски SAS сегодня имеют скорость передачи данных 300 МБ / с, что чуть ниже скорости SCSI 320 МБ / с, но каждый диск получает полные 300 МБ / с на хост, а не на совместное использование, как с SCSI, SATA и PATA. Текущие тесты показывают производительность, сопоставимую с лучшими дисками SCSI 15K Ultra320, а в некоторых областях SAS намного превосходит SCSI. Некоторые другие интересные функции:

Отдельные диски SAS сегодня имеют скорость передачи данных 300 МБ / с, что чуть ниже скорости SCSI 320 МБ / с, но каждый диск получает полные 300 МБ / с на хост, а не на совместное использование, как с SCSI, SATA и PATA. Текущие тесты показывают производительность, сопоставимую с лучшими дисками SCSI 15K Ultra320, а в некоторых областях SAS намного превосходит SCSI. Некоторые другие интересные функции:

- Интерфейс SAS обратно совместим со всеми дисками SATA.

- Он может поддерживать более 16 000 устройств на одной шине, по сравнению с 16 с SCSI и 1 с SATA

- SAS Expanders предоставляют возможность подключать диски так же, как мы объединяем компьютеры в сеть с помощью коммутатора, но на меньших расстояниях (несколько метров). Доступны

- 2,5-дюймовые и 3,5-дюймовые диски.

— Накопители Seagate Barracuda ES2 Serial Attached SCSI емкостью 1 терабайт можно найти примерно за 270 долларов, а может быть, даже за 250 долларов. Они крутятся со скоростью 7200 об / мин. Неплохой выбор для систем MythTV, которые будут постоянно работать. РедмондСмокинг

Неплохой выбор для систем MythTV, которые будут постоянно работать. РедмондСмокинг

Внешние ссылки

Перегородки

Модель файловых систем Unix намного более гибкая, чем модель под Windows, и Linux не является исключением, позволяя легко интегрировать жесткие диски, разделы и различные форматы здесь, там и везде.Лично я большой поклонник настройки нескольких разделов, потому что, помимо прочего, это позволяет вам адаптировать файловую систему (см. Ниже) к файлам, которые будут на ней жить. По крайней мере, я бы поддержал как минимум три раздела:

-

/ boot— это место, где живут ядро и загрузчик. Я обычно форматирую этот ext2, так как он очень редко записывается. -

/— корень вашей файловой системы, в значительной степени эквивалент «C: \» под Windows; все ваши программы и файлы будут находиться где-то в корневой файловой системе (например,/ usrи/ var / log), если вы не укажете конкретное дерево каталогов, которое будет находиться в отдельной файловой системе (например, / boot, показанном выше) .

- В третьем разделе вы храните все ваши файлы MythTV (а также музыку и внешнее видео, если вам это нужно). Если вы хотите увидеть мою настройку разбиения на разделы для одного из моих бэкэндов, вы можете посмотреть раздел «Расширенное хранилище: пример настройки» ниже.

Обратите внимание, что, особенно если вы склонны обезьянничать с CVS Myth или с расширенными драйверами бета- и альфа-тестирования, вы будете намного счастливее, если поместите / var / log в отдельный раздел.

Большинство разделов в только что описанном смысле могут существовать вместо томов LVM (см. Раздел о LVM ниже).

При разбиении диска на разделы необходимо сначала выбрать схему разбиения. Для систем x86 и x86-64 система разделения основной загрузочной записи (MBR) долгое время была стандартом. Однако система MBR использует структуры данных размером до 2 ТБ. Если вы используете аппаратную конфигурацию RAID, ваши виртуальные диски могут превышать этот размер. К концу 2009 года, вероятно, появятся даже отдельные диски размером более 2 ТБ. Поэтому вам может потребоваться использовать новую систему таблицы разделов GUID (GPT), если вы планируете использовать много места для хранения.GPT уже является стандартом для Macintosh на базе Intel. Использование GPT требует разделения с помощью утилит, поддерживающих GPT, таких как GNU Parted, а не fdisk. Вам также может потребоваться найти исправленную версию загрузчика GRUB. Убедитесь, что ваш дистрибутив поддерживает установку на GPT-диски, если вы собираетесь использовать эту систему. В некоторых случаях может быть проще установить Linux на (относительно) небольшой диск с разделами на MBR и зарезервировать систему GPT для диска или массива RAID, на котором хранятся ваши записи.Если ваши отдельные диски или RAID-массивы меньше 2 ТБ, скорее всего, старая система MBR будет работать нормально.

Поэтому вам может потребоваться использовать новую систему таблицы разделов GUID (GPT), если вы планируете использовать много места для хранения.GPT уже является стандартом для Macintosh на базе Intel. Использование GPT требует разделения с помощью утилит, поддерживающих GPT, таких как GNU Parted, а не fdisk. Вам также может потребоваться найти исправленную версию загрузчика GRUB. Убедитесь, что ваш дистрибутив поддерживает установку на GPT-диски, если вы собираетесь использовать эту систему. В некоторых случаях может быть проще установить Linux на (относительно) небольшой диск с разделами на MBR и зарезервировать систему GPT для диска или массива RAID, на котором хранятся ваши записи.Если ваши отдельные диски или RAID-массивы меньше 2 ТБ, скорее всего, старая система MBR будет работать нормально.

Файловые системы

Как вы, наверное, знаете, в Linux имеется огромное количество доступных файловых систем, большинство из которых отлично справляются с конкретной задачей. Вы, конечно, можете форматировать свои диски в любой файловой системе по своему выбору, но вот некоторые общие сведения о наиболее популярных файловых системах:

Вы, конечно, можете форматировать свои диски в любой файловой системе по своему выбору, но вот некоторые общие сведения о наиболее популярных файловых системах:

- ext4 — это стандартная файловая система в Fedora среди других дистрибутивов.Он включает в себя функции, обеспечивающие поддержку больших файлов и файловых систем, а также лучшую производительность с большими файлами. Его стабильность и пригодность для использования на приставке MythTV идеальны.

- JFS изначально была разработана IBM для их операционной системы AIX, а затем была передана в дар Linux. JFS невероятно хорош в работе с огромными файлами, которые генерирует MythTV, и может удалить практически любой файл менее чем за секунду (ext3 может занять до 15 секунд, чтобы удалить действительно большие файлы).JFS — очень хорошая файловая система для хранения ваших видео, и она очень консервативна в отношении использования ЦП.

- XFS — еще одна «чужая» файловая система, разработанная SGI для их операционной системы IRIX и снова подаренная Linux.

Как и JFS, он исключительно хорош при работе с большими файлами и имеет самую высокую пропускную способность среди всех файловых систем Linux, хотя и при более высокой загрузке процессора. XFS также является отличным выбором в качестве хранилища для ваших файлов фильмов. (Обратите внимание, что файловые системы XFS в настоящее время могут быть увеличены с до , но не сжимаются; иногда это может быть проблематично.Также обратите внимание, что очистка файловой системы принудительно выполняется с помощью xfs_repair, а не fsck; Если вы собираетесь использовать XFS, и Bay Link рекомендует это сделать, сначала прочтите об этом ).

Как и JFS, он исключительно хорош при работе с большими файлами и имеет самую высокую пропускную способность среди всех файловых систем Linux, хотя и при более высокой загрузке процессора. XFS также является отличным выбором в качестве хранилища для ваших файлов фильмов. (Обратите внимание, что файловые системы XFS в настоящее время могут быть увеличены с до , но не сжимаются; иногда это может быть проблематично.Также обратите внимание, что очистка файловой системы принудительно выполняется с помощью xfs_repair, а не fsck; Если вы собираетесь использовать XFS, и Bay Link рекомендует это сделать, сначала прочтите об этом ). - Btrfs (произносится как «масло-эфф-есс») — это многообещающая файловая система Linux. Это ответ Linux на ZFS, популярную в Solaris. Хотя Btrfs имеет множество расширенных функций, таких как операция копирования при записи, онлайн-дефрагментация и моментальные снимки, он все еще очень новый и не был тщательно протестирован сообществом MythTV по состоянию на октябрь 2009 года.

Для использования любой из этих файловых систем вам потребуется их поддержка, скомпилированная в ядро, вместе с соответствующими утилитами пользовательского пространства. Драйверы файловой системы ваших разделов должны быть скомпилированы непосредственно в ядро (не как модули) или , скомпилированы как модули и включены в начальный RAM-диск (initrd). Первый подход обычно проще в использовании; Конфигурация initrd добавляет шаги в процесс компиляции ядра и иногда может ошибаться. Если вы создаете драйверы файловой системы как модули и не собираете initrd, ядро не сможет читать файловые системы, в которых хранятся драйверы файловой системы! Если вы используете стандартное предварительно скомпилированное ядро вашего дистрибутива, вам не о чем беспокоиться.

Некоторые дистрибутивы поставляются с выбором только одной или двух файловых систем, хотя, если вы пересобираете ядро, можно включить их все (включая поддержку Windows FAT32 и NTFS, если вам это нужно!). Все время появляются новые, экзотические и улучшенные файловые системы; На горизонте скоро появится Reiser4, который обещает быть очень высокопроизводительной и гибкой системой, хотя пока еще далек от стабильности.

Все время появляются новые, экзотические и улучшенные файловые системы; На горизонте скоро появится Reiser4, который обещает быть очень высокопроизводительной и гибкой системой, хотя пока еще далек от стабильности.

Многие файловые системы позволяют настраивать размер блока во время форматирования — выбор большого размера блока позволит более эффективно использовать пространство на жестком диске при работе с большими файлами, тогда как небольшой размер блока лучше подходит для разделов вашей системы.В случае сомнений внимательно прочтите руководство или просто оставьте значения по умолчанию, поскольку вы не можете изменить размер блока без переформатирования диска.

Параметры монтирования файловой системы могут иногда влиять на производительность. Например, при использовании XFS параметр allocsize может использоваться для установки размера блоков, которые файловая система использует при выделении нового дискового пространства. Установка большого значения (например, allocsize = 512m) может уменьшить фрагментацию и, следовательно, повысить производительность, когда большие файлы хранятся в файловой системе.

Короче говоря, хороший выбор — ext3 или ReiserFS для разделов вашей системы и JFS или XFS для хранилища MythTV. Если у вас есть отдельный / boot раздел, ext2 — хороший вариант, поскольку журнал ext3 не дает особых преимуществ для раздела такого размера, но занимает много места на диске. Обратите внимание, что реализации XFS в SuSE 9.0 и 9.1 были немного нестабильными, что может затруднить установку и обновление, если вы не знаете волшебства. (Я вложу сюда магию, когда перееду.- Ссылка на залив)

Расширенное хранилище

Группы хранения

Storage Groups — это функция, представленная в версии 0.21, позволяющая использовать несколько жестких дисков для хранения записей и других носителей. Это более простая, дешевая и безопасная альтернатива LVM. Он также может заменить RAID в определенных настройках.

LVM

LVM означает диспетчер логических томов. Он дает два основных преимущества перед обычными перегородками:

- Вы можете использовать его, чтобы два или несколько отдельных жестких дисков (или разделов на этих дисках) представлялись операционной системе как один огромный жесткий диск.

LVM может дополнительно разделить разделы вместе, что означает, что доступ к двум дискам чередуется. Это может улучшить производительность аналогично некоторым конфигурациям RAID.

LVM может дополнительно разделить разделы вместе, что означает, что доступ к двум дискам чередуется. Это может улучшить производительность аналогично некоторым конфигурациям RAID.

- Файловые системы хранятся в логических томах в разделах, используемых LVM. Размер этих логических томов можно изменять, добавлять и удалять независимо от их местоположения или того, где именно будут храниться данные, которые вы выделяете. (Логические тома действуют во многом как файлы в файловой системе.) Эта функция упрощает добавление дискового пространства к файловым системам, которые в нем нуждаются.Вы можете, например, добавить новый диск к существующей системе, а затем расширить файловую систему записей MythTV без необходимости копировать данные или иным образом нарушать существующие записи.

LVM, конечно, имеет определенные недостатки:

- Это добавляет сложности. Помимо создания разделов обычным способом, вы должны использовать несколько утилит для создания структур данных LVM, прежде чем вы сможете начать использовать свои диски.

- Не все дистрибутивы обеспечивают простую поддержку LVM.Например, в некоторых версиях Ubuntu отсутствует поддержка LVM «из коробки». (Вы можете обойти эту проблему, но это требует дополнительных знаний.)

- Если вы используете LVM для охвата нескольких физических дисков, ваши данные становятся более подверженными повреждению в случае отказа одного диска — поломка одного физического диска может сделать данные, хранящиеся на хорошем диске, недоступными.

- Аварийное восстановление становится более сложным. Ваши инструменты восстановления должны поддерживать LVM (к счастью, большинство современных восстановительных CD / DVD поддерживают), но вам может потребоваться выполнить дополнительные команды для доступа к вашим данным.

- Загрузка Linux может стать более сложной, потому что вы должны либо иметь поддержку LVM на начальном RAM-диске (initrd), либо предоставить базовые драйверы и инструменты LVM для раздела, отличного от LVM. (Обратите внимание, что вы можете установить свою базовую систему Linux на диск без LVM и зарезервировать LVM только для записей MythTV и файловых систем баз данных, если хотите. Эта конфигурация минимизирует этот недостаток LVM.)

Несмотря на эти недостатки, LVM Преимущества делают LVM привлекательным для многих пользователей.Группы хранения MythTV 0.21 — еще один вариант увеличения гибкости хранения. Для использования LVM вам потребуется включить LVM в ядре, а также установить пользовательские утилиты LVM. В серии ядра 2.6 реализован значительно улучшенный LVM2.

Подробности настройки LVM здесь немного сложны, поэтому, если вы хотите получить хорошее объяснение, вы можете прочитать LVM HOWTO. Короче говоря, вы можете выделить отдельные разделы или целые жесткие диски («физические тома») для использования LVM, что позволяет вам сопоставить их в одну или несколько «групп томов», из которых вы затем вырезаете «логические тома». «для установки файловых систем.

RAID

Первоначально RAID означал избыточный массив независимых дисков, хотя теперь слово «независимый» было заменено на «недорогой» (вероятно, потому, что в большинстве конфигураций RAID используются очень дорогие SCSI-диски ;). В основном это означает, что данные распределяются по нескольким жестким дискам таким образом, что если один из жестких дисков взорвется или будет съеден кошкой, вы сможете восстановить потерянные данные с других жестких дисков. Одна из меньших функций RAID — создание файловых систем с более высокой производительностью за счет распределения нагрузки чтения / записи по нескольким дискам.Чтобы получить очень четкое и краткое руководство по RAID, вы можете прочитать эти страницы http://www.acnc.com/04_00.html, а пока вот краткое изложение наиболее распространенных уровней RAID вместе с примерами емкости хранилища:

- RAID0 , также известный как чередование, не является настоящим RAID, поскольку не предлагает избыточности. Если один из дисков в массиве выходит из строя, все данные в массиве теряются. RAID0 линейно масштабируется с каждым добавленным диском; два диска по 80 ГБ образуют единую файловую систему на 160 ГБ.Обратите внимание, что RAID0 сильно отличается от LVM!

- RAID1 , также известный как зеркалирование, включает в себя копирование данных на два идентичных жестких диска, а не только на один. Если один диск выйдет из строя, другой останется полностью работоспособным со всеми вашими данными. Два диска по 80 ГБ образуют единую файловую систему размером 80 ГБ.

- RAID0 + 1 и RAID10 — две основные формы вложенных массивов. 0 + 1 — это зеркальная полоса, а 10 — зеркальная полоса.Хотя оба метода одинаково просты в исполнении, 0 + 1 чаще встречается на недорогих программных RAID-массивах, поставляемых с потребительскими материнскими платами. И наоборот, 10 — более надежный режим, требующий только одного функционального привода для каждого набора зеркал, тогда как 0 + 1 требует одной полностью функциональной полосы.

- RAID5 и RAID6 являются более сложными формами резервирования и обычно встречаются только на картах более высокого уровня. Подобно RAID0 , каждая полоса включает один избыточный блок четности (два в случае RAID6 ), используемый для расчета недостающих данных в случае отказа диска.Традиционно это очень интенсивно, с высокопроизводительными картами, имеющими специальные ASIC для обработки вычислений, однако современные процессоры, особенно многоядерные, не имеют проблем с выполнением этой функции в программном обеспечении. Из-за использования четности, которая должна вычисляться по всей полосе, эта форма RAID страдает низкой производительностью записи при выполнении нескольких операций записи, размер которых меньше одного размера полосы. Скорость чтения почти такая же, как у RAID0 .

В конце концов, если вас не беспокоит потеря данных (или если вы храните хорошие резервные копии), любой тип RAID будет излишним.Хороший компромисс может быть достигнут, если вы поместите все свои системные каталоги на какой-либо RAID (который защитит всю вашу трудоемкую конфигурацию), разместив хранилище телевизора на одном диске. Но если у вас достаточно денег и желания, вы можете RAID всей своей установки.

Сетевые файловые системы

Как следует из названия, это механизмы для локального доступа к удаленной файловой системе (и, следовательно, к файлам) по сети. MythTV будет осуществлять внутреннюю потоковую передачу контента с бэкэндов на удаленные интерфейсы, поэтому для большинства целей в этом нет необходимости.Эта возможность ограничена контентом, определенным на бэкэнде с помощью каталогов хранилища, что в настоящее время ограничивает его библиотеками записи и видео. Музыка и изображения еще не были перенесены в этот новый дизайн и требуют доступа к файловой системе на каждом интерфейсе. Серверные ВМ могут записывать только в локально смонтированные файловые системы и не будут передавать новую запись в удаленный бэкэнд для хранения.

Если требуется сетевая файловая система, два общих варианта — это NFS и CIFS. NFS — это собственный протокол, используемый Linux и другими операционными системами, совместимыми с POSIX.CIFS более известен как общий доступ к файлам Windows. CIFS предлагает гораздо больше возможностей настройки с точки зрения безопасности и ограничений доступа, в то время как NFS будет легче и быстрее. Что еще более важно, NFS разработана на основе тех же свойств файловой системы, что и другие файловые системы Linux, в то время как CIFS имеет очень чужеродный дизайн и вызывает некоторые сложности в местах, где нет прямого преобразования одного параметра в другой. NFS следует предпочесть CIFS, если нет особых требований, требующих использования CIFS.

типов твердотельных накопителей и какие их покупать — Techbytes

Фото: partitionwizard.comК настоящему времени, вероятно, вы слышали о твердотельных накопителях или SSD как о невероятно быстром накопителе для ускорения работы старых компьютеров или обеспечения надежного времени безотказной работы по сравнению с их заменой, жесткими дисками или жесткими дисками. Но существует бесчисленное множество вариантов, так какой привод лучше?