Видеокарта GeForce GTX 1660 Super [в 22 бенчмарках]

NVIDIA GeForce GTX 1660 Super

- Интерфейс PCIe 3.0 x16

- Частота ядра 1530

- Объем видеопамяти 6 GB

- Тип памяти GDDR6

- Частота памяти 14000

- Максимальное разрешение

Описание

NVIDIA начала продажи GeForce GTX 1660 Super 29 октября 2019 по рекомендованной цене 229$. Это десктопная видеокарта на архитектуре Turing и техпроцессе 12 нм, в первую очередь рассчитанная на геймеров. На ней установлено 6 Гб памяти GDDR6 на частоте 14 ГГц, и вкупе с 192-битным интерфейсом это создает пропускную способность 336.0 Гб/с.

С точки зрения совместимости это двухслотовая карта, подключаемая по интерфейсу PCIe 3.0 x16. Длина референсной версии – 229 мм. Для подключения требуется дополнительный 1x 8-pin кабель питания, а потребляемая мощность – 125 Вт.

Она обеспечивает хорошую производительность в тестах и играх на уровне

32.63%

от лидера, которым является NVIDIA GeForce RTX 4090.

GeForce RTX4090 СравнитьОбщая информация

Сведения о типе (для десктопов или ноутбуков) и архитектуре GeForce GTX 1660 Super, а также о времени начала продаж и стоимости на тот момент.

| Место в рейтинге производительности | 123 | |

| Место по популярности | 6 | |

| Соотношение цена-качество | 59.36 | |

| Архитектура | Turing (2018−2021) | |

| Графический процессор | Turing TU116 | |

| Тип | Десктопная | |

| Дата выхода | 29 октября 2019 (3 года назад) | |

| Цена на момент выхода | 229$ | |

| Цена сейчас | 219$ (1x) | из 168889 (A100 PCIe 80 GB) |

Отношение производительности к цене. Чем выше, тем лучше.

Чем выше, тем лучше.

Характеристики

Общие параметры GeForce GTX 1660 Super: количество шейдеров, частота видеоядра, техпроцесс, скорость текстурирования и вычислений. Они косвенным образом говорят о производительности GeForce GTX 1660 Super, но для точной оценки необходимо рассматривать результаты бенчмарков и игровых тестов.

| Количество потоковых процессоров | 1408 | из 20480 (Data Center GPU Max NEXT) |

| Частота ядра | 1530 МГц | из 2610 (Radeon RX 6500 XT) |

| Частота в режиме Boost | 1785 МГц | из 3599 (Radeon RX 7990 XTX) |

| Количество транзисторов | 6,600 млн | из 14400 (GeForce GTX 1080 SLI (мобильная)) |

| Технологический процесс | 12 нм | из 4 (GeForce RTX 4080) |

| Энергопотребление (TDP) | 125 Вт | из 2400 (Data Center GPU Max Subsystem) |

| Скорость текстурирования | 157. 1 1 | из 969.9 (h200 SXM5 96 GB) |

Совместимость и размеры

Параметры, отвечающие за совместимость GeForce GTX 1660 Super с остальными компонентами компьютера. Пригодятся например при выборе конфигурации будущего компьютера или для апгрейда существующего. Для десктопных видеокарт это интерфейс и шина подключения (совместимость с материнской платой), физические размеры видеокарты (совместимость с материнской платой и корпусом), дополнительные разъемы питания (совместимость с блоком питания).

| Интерфейс | PCIe 3.0 x16 | |

| Длина | 229 мм | |

| Толщина | 2 слота | |

| Дополнительные разъемы питания | 1x 8-pin |

Оперативная память

Параметры установленной на GeForce GTX 1660 Super памяти — тип, объем, шина, частота и пропускная способность. Для встроенных в процессор видеокарт, не имеющих собственной памяти, используется разделяемая — часть оперативной памяти.

Для встроенных в процессор видеокарт, не имеющих собственной памяти, используется разделяемая — часть оперативной памяти.

| Тип памяти | GDDR6 | |

| Максимальный объём памяти | 6 Гб | из 128 (Radeon Instinct MI250X) |

| Ширина шины памяти | 192 бит | из 8192 (Radeon Instinct MI250X) |

| Частота памяти | 14000 МГц | из 22400 (GeForce RTX 4080) |

| Пропускная способность памяти | 336.0 Гб/с | из 3276 (Aldebaran) |

| Разделяемая память | — |

Видеовыходы

Перечисляются имеющиеся на GeForce GTX 1660 Super видеоразъемы. Как правило, этот раздел актуален только для десктопных референсных видеокарт, так как для ноутбучных наличие тех или иных видеовыходов зависит от модели ноутбука.

| Видеоразъемы | 1x DVI, 1x HDMI, 1x DisplayPort | |

| HDMI | + | |

| HDCP | + | |

| Поддержка G-SYNC | + |

Технологии

Здесь перечислены поддерживаемые GeForce GTX 1660 Super технологические решения и API. Такая информация понадобится, если от видеокарты требуется поддержка конкретных технологий.

Такая информация понадобится, если от видеокарты требуется поддержка конкретных технологий.

| NVENC | + | |

| Ansel | + |

Поддержка API

Перечислены поддерживаемые GeForce GTX 1660 Super API, включая их версии.

| DirectX | 12 (12_1) | |

| Шейдерная модель | 6.5 | |

| OpenGL | 4.6 | |

| OpenCL | 1.2 | |

| Vulkan | 1.2.131 | |

| CUDA | 7.5 |

Тесты в бенчмарках

Общая производительность в тестах

Это наш суммарный рейтинг производительности. Мы регулярно улучшаем наши алгоритмы, но если вы обнаружите какие-то несоответствия, не стесняйтесь высказываться в разделе комментариев, мы обычно быстро устраняем проблемы.

Мы регулярно улучшаем наши алгоритмы, но если вы обнаружите какие-то несоответствия, не стесняйтесь высказываться в разделе комментариев, мы обычно быстро устраняем проблемы.

GTX 1660 Super 32.63

Passmark

Это очень распространенный бенчмарк, входящий в состав пакета Passmark PerformanceTest. Он дает видеокарте тщательную оценку, производя четыре отдельных теста для Direct3D версий 9, 10, 11 и 12 (последний по возможности делается в разрешении 4K), и еще несколько тестов, использующих DirectCompute.

Охват бенчмарка: 25%

GTX 1660 Super 12805

3DMark Vantage Performance

3DMark Vantage — это устаревший бенчмарк на базе DirectX 10. Он нагружает видеокарту двумя сценами, одна из которых изображает девушку, убегающую с какой-то военной базы, расположенной в морской пещере, а другая — космический флот, атакующий беззащитную планету. Поддержка 3DMark Vantage была прекращена в апреле 2017 года, и теперь вместо него рекомендуется использовать бенчмарк Time Spy.

Поддержка 3DMark Vantage была прекращена в апреле 2017 года, и теперь вместо него рекомендуется использовать бенчмарк Time Spy.

Охват бенчмарка: 16%

GTX 1660 Super 76654

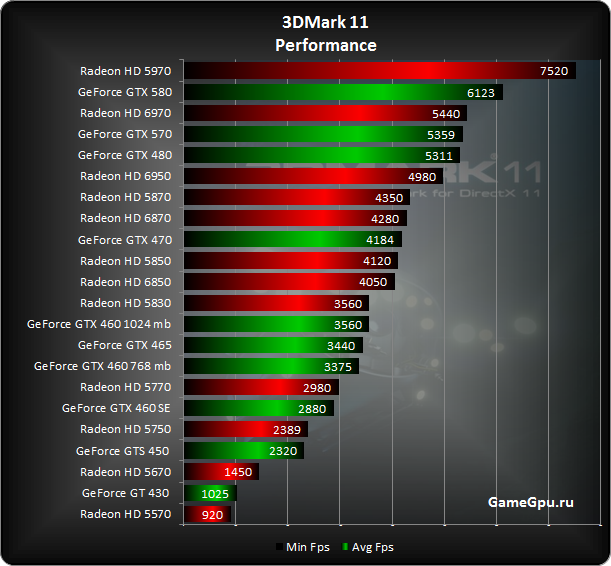

3DMark 11 Performance GPU

3DMark 11 — это устаревший бенчмарк DirectX 11 от Futuremark. Он использовал четыре теста, основанных на двух сценах: одна из них — это несколько подводных лодок, исследующих затонувший корабль, другая — заброшенный храм в глубине джунглей. Все тесты широко используют объемное освещение и тесселяцию, и, несмотря на то, что выполняются в разрешении 1280×720, являются относительно тяжелыми. Поддержка 3DMark 11 прекращена в январе 2020 года, теперь вместо него предлагается использовать Time Spy.

Охват бенчмарка: 16%

GTX 1660 Super 21982

3DMark Fire Strike Score

Охват бенчмарка: 13%

GTX 1660 Super 15164

3DMark Cloud Gate GPU

Cloud Gate — это устаревший бенчмарк, использующий DirectX 11 feature level 10, применявшийся для тестирования домашних ПК и недорогих ноутбуков. Он отображает несколько сцен с каким-то странным устройством телепортации, запускающим космические корабли в неизведанное, с фиксированным разрешением 1280×720. Так же, как и в случае с бенчмарком Ice Storm, его поддержка была прекращена в январе 2020 года, теперь вместо него рекомендуется использовать 3DMark Night Raid.

Он отображает несколько сцен с каким-то странным устройством телепортации, запускающим космические корабли в неизведанное, с фиксированным разрешением 1280×720. Так же, как и в случае с бенчмарком Ice Storm, его поддержка была прекращена в январе 2020 года, теперь вместо него рекомендуется использовать 3DMark Night Raid.

Охват бенчмарка: 13%

GTX 1660 Super 93241

3DMark Fire Strike Graphics

Fire Strike — это бенчмарк DirectX 11 для игровых ПК. В нем есть два отдельных теста, демонстрирующих борьбу между гуманоидом и огненным существом, похоже, сделанным из лавы. Используя разрешение 1920×1080, Fire Strike демонстрирует достаточно реалистичную графику и довольно требователен к оборудованию.

Охват бенчмарка: 13%

GTX 1660 Super 15829

GeekBench 5 OpenCL

Geekbench 5 — широко распространенный бенчмарк для видеокарт, объединяющий 11 различных тестовых сценариев. Все эти сценарии основаны на прямом задействовании вычислительной мощности графического процессора, без использования 3D-рендеринга. Этот вариант использует программный интерфейс OpenCL компании Khronos Group.

Все эти сценарии основаны на прямом задействовании вычислительной мощности графического процессора, без использования 3D-рендеринга. Этот вариант использует программный интерфейс OpenCL компании Khronos Group.

Охват бенчмарка: 9%

GTX 1660 Super 61945

3DMark Ice Storm GPU

Ice Storm Graphics — устаревший бенчмарк, часть пакета 3DMark. Ice Storm использовался для измерения производительности ноутбуков начального уровня и планшетов на базе Windows. В нем используется DirectX 11 feature level 9 для отображения битвы между двумя космическими флотами вблизи замерзшей планеты в разрешении 1280×720. Поддержка Ice Storm прекращена в январе 2020 года, теперь разработчики рекомендуют взамен использовать Night Raid.

Охват бенчмарка: 8%

GTX 1660 Super 477037

GeekBench 5 Vulkan

Geekbench 5 — широко распространенный бенчмарк для видеокарт, объединяющий 11 различных тестовых сценариев. Все эти сценарии основаны на прямом задействовании вычислительной мощности графического процессора, без использования 3D-рендеринга. Этот вариант использует программный интерфейс Vulkan компаний AMD и Khronos Group.

Все эти сценарии основаны на прямом задействовании вычислительной мощности графического процессора, без использования 3D-рендеринга. Этот вариант использует программный интерфейс Vulkan компаний AMD и Khronos Group.

Охват бенчмарка: 5%

GTX 1660 Super 61144

GeekBench 5 CUDA

Geekbench 5 — широко распространенный бенчмарк для видеокарт, объединяющий 11 различных тестовых сценариев. Все эти сценарии основаны на прямом задействовании вычислительной мощности графического процессора, без использования 3D-рендеринга. Этот вариант использует программный интерфейс CUDA компании NVIDIA.

Охват бенчмарка: 4%

GTX 1660 Super 65044

SPECviewperf 12 — specvp12 maya-04

Охват бенчмарка: 3%

GTX 1660 Super 134

SPECviewperf 12 — specvp12 sw-03

Охват бенчмарка: 3%

GTX 1660 Super 57

SPECviewperf 12 — specvp12 snx-02

Охват бенчмарка: 3%

GTX 1660 Super 9

SPECviewperf 12 — specvp12 medical-01

Охват бенчмарка: 3%

GTX 1660 Super 31

SPECviewperf 12 — specvp12 catia-04

Охват бенчмарка: 3%

GTX 1660 Super 63

SPECviewperf 12 — specvp12 creo-01

Охват бенчмарка: 3%

GTX 1660 Super 41

SPECviewperf 12 — specvp12 showcase-01

Охват бенчмарка: 3%

GTX 1660 Super 83

SPECviewperf 12 — specvp12 energy-01

Охват бенчмарка: 3%

GTX 1660 Super 8

SPECviewperf 12 — Showcase

Охват бенчмарка: 2%

GTX 1660 Super 83

SPECviewperf 12 — Maya

Эта часть бенчмарка для рабочих станций SPECviewperf 12 использует движок Autodesk Maya 13 для рендеринга супергеройской электростанции, модель которой состоит более чем из 700 тысяч полигонов, в шести разных режимах.

Охват бенчмарка: 2%

GTX 1660 Super 128

SPECviewperf 12 — specvp12 3dsmax-05

Охват бенчмарка: 1%

GTX 1660 Super 154

SPECviewperf 12 — 3ds Max

Эта часть бенчмарка SPECviewperf 12 эмулирует работу с 3DS Max, выполняя одиннадцать тестов в различных сценариях использования, включая архитектурное моделирование и анимацию для компьютерных игр.

Охват бенчмарка: 1%

GTX 1660 Super 154

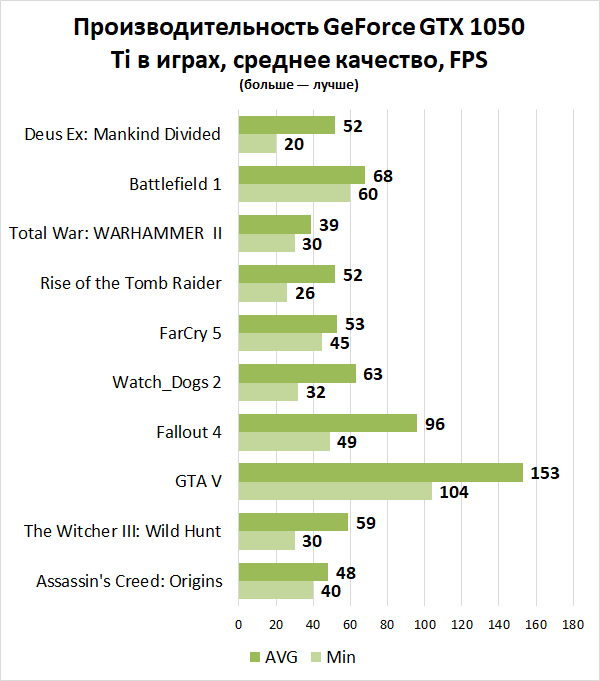

GeForce GTX 1660 Super в играх

FPS в популярных играх на GeForce GTX 1660 Super, а также соответствие системным требованиям. Помните, что официальные требования разработчиков не всегда совпадают с данными реальных тестов.

Средние FPS

Здесь приведены средние значения частоты кадров в секунду в большом наборе популярных игр в различных разрешениях:

| Full HD | 96 | |

| 1440p | 57 | |

| 4K | 34 |

Популярные игры

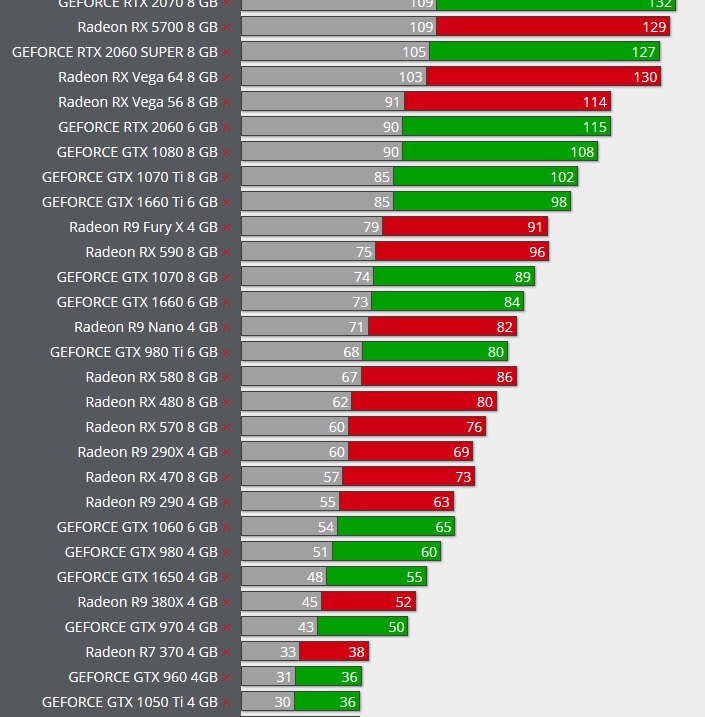

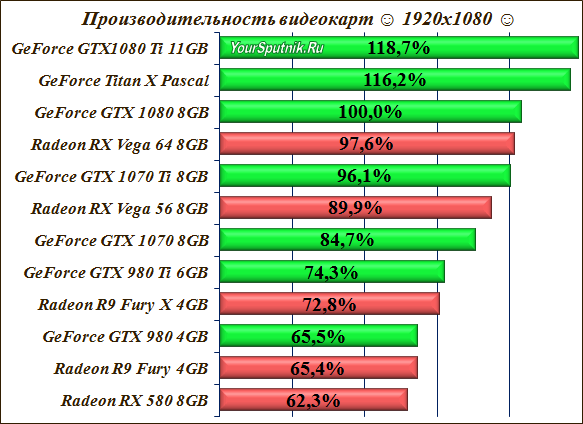

Относительная производительность

Общая производительность GeForce GTX 1660 Super по сравнению с ближайшими конкурентами среди десктопных видеокарт.![]()

NVIDIA GeForce GTX TITAN X 102.15

NVIDIA Titan X Pascal 101.72

NVIDIA GeForce GTX 1660 Ti 101.13

NVIDIA GeForce GTX 1660 Super 100

AMD Radeon RX 5600 OEM 99.48

NVIDIA GeForce RTX 3050 8 GB 98.47

NVIDIA GeForce RTX 3050 OEM 93.44

Конкурент от AMD

Мы полагаем, что ближайшим конкурентом GeForce GTX 1660 Super от компании AMD является Radeon RX 5600 OEM, которая в среднем на 1% медленнее и на 2 позиции ниже в нашем рейтинге.

Radeon RX5600 OEM СравнитьВот несколько ближайших конкурентов GeForce GTX 1660 Super от AMD:

AMD Radeon RX 5600 XT

107. 97

97

AMD Radeon RX Vega 56 105.49

AMD Radeon Vega Frontier Edition 105.12

NVIDIA GeForce GTX 1660 Super 100

AMD Radeon RX 5600 OEM 99.48

AMD Fiji 85.69

AMD Radeon R9 FURY X 78.58

Другие видеокарты

Здесь мы рекомендуем несколько видеокарт, более или менее близких по производительности к рассмотренной.

GeForce GTX1660 Ti СравнитьRadeon RXVega 56 СравнитьRadeon RX5600 XT СравнитьGeForce GTX1660 СравнитьGeForce RTX2060 СравнитьRadeon RXVega 64 СравнитьРекомендуемые процессоры

По нашей статистике эти процессоры чаще всего используются с GeForce GTX 1660 Super.

10.2%

Ryzen 5 36007.8%

Ryzen 5 26004.8%

Core i3 10100F4.3%

Core i5 9400F4.2%

Core i3 12100F2.9%

Core i5 11400F2.4%

Core i5 12400F2.3%

Ryzen 5 5600X2%

Ryzen 5 5500U1. 6%

6%

Оценка пользователями

Здесь Вы можете посмотреть оценку видеокарты пользователями, а также поставить свою оценку.

Советы и комментарии

Здесь можно задать вопрос о GeForce GTX 1660 Super, согласиться или не согласиться с нашими оценками, или сообщить об ошибках и неточностях на сайте.

Please enable JavaScript to view the comments powered by Disqus.

за что следует доплатить? GECID.com.

::>Видеокарты >2022 > Сравнение четырех видеокарт GeForce RTX 3060 от GIGABYTE: за что следует доплатить?

28-10-2022

В одном из предыдущих обзоров, там где мы выбирали оптимальный процессор Intel для GeForce RTX 3060, мы оговорились, что намеренно берем не самую дешевую версию видеокарты, чтобы тише и холоднее, а буст-частоты выше. То есть только по внешнему виду и некоторым характеристикам, плюс пара комментариев от зрителей, мы решили, что чуть более дорогая видеокарта серии Gaming значительно лучше модели из серии EAGLE./data/NFS_1920_A.png) Действительно ли это так? А если да, то насколько?

Действительно ли это так? А если да, то насколько?

К тому же, обе эти видеокарты мы еще не вернули. Почему бы не сравнить? Более того, для полноты картины попросили у Telemart.ua еще две версии RTX 3060 в исполнении GIGABYTE – VISION и AORUS ELITE.

Поэтому благодарим TELEMART за возможность делать разные тесты и напоминаем, здесь есть много комплектующих, периферии, сетевого оборудования и готовых ПК на разный вкус и кошелек. А недавно появилась возможность обновиться по принципу Trade-In – сдать уже не нужное железо и получить скидку на новое оборудование до 99%.

Почему RTX 3060 – оптимальный выбор?

Прежде чем знакомиться с видеокартами, напомним вообще о характеристиках и возможностях GeForce RTX 3060. Почему видеокарты на этом чипе сейчас так популярны?

По сравнению с младшими RTX 3050 видеокарты на GeForce RTX 3060 значительно мощнее благодаря почти на треть большему количеству CUDA ядер и других рабочих блоков – текстурных, растеризованных, RT ядер второго поколения и тензорных третьего. Также здесь в полтора раза шире шина видеопамяти, которой 12 ГБ против 8-ми. Это, кстати, запас на будущее. Плюс еще и зависимости от скорости интерфейса PCI-E почти нет, потому что у RTX 3060 полноценные 16 линий, а у RTX 3050 всего 8. Благодаря этому старшая без проблем тянет все в 1080p на максималках и даже в 1440p, если разумно подойти к настройкам графики и заручиться поддержкой DLSS.

Также здесь в полтора раза шире шина видеопамяти, которой 12 ГБ против 8-ми. Это, кстати, запас на будущее. Плюс еще и зависимости от скорости интерфейса PCI-E почти нет, потому что у RTX 3060 полноценные 16 линий, а у RTX 3050 всего 8. Благодаря этому старшая без проблем тянет все в 1080p на максималках и даже в 1440p, если разумно подойти к настройкам графики и заручиться поддержкой DLSS.

Что касается старшей RTX 3060 Тi, то обычная RTX 3060, конечно, проигрывает, потому что имеет на треть меньше CUDA ядер и других блоков, да еще работает с более узкой шины видеопамяти – 192 против 256 бит. Но у Тi версии, которая позиционируется уже под Quad HD, всего 8 ГБ памяти и стоит она дороже.

Чтобы не быть голословными, мы взяли уже собранную для предварительных тестов систему из GIGABYTE GeForce RTX 3060 Gaming OC и попробовали на ней и поработать, и поиграть.

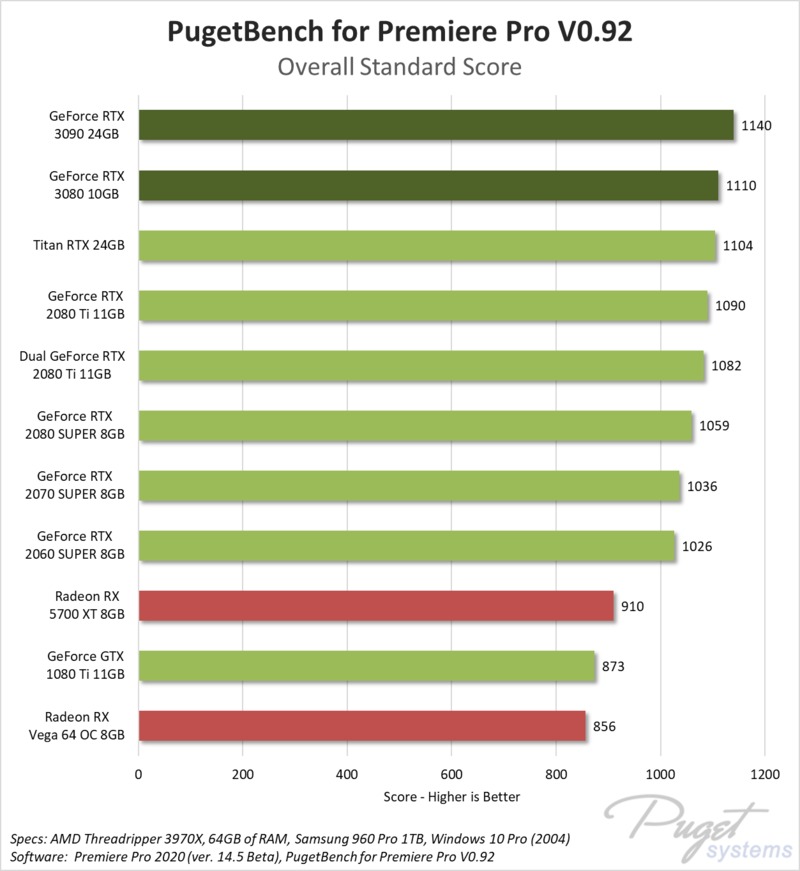

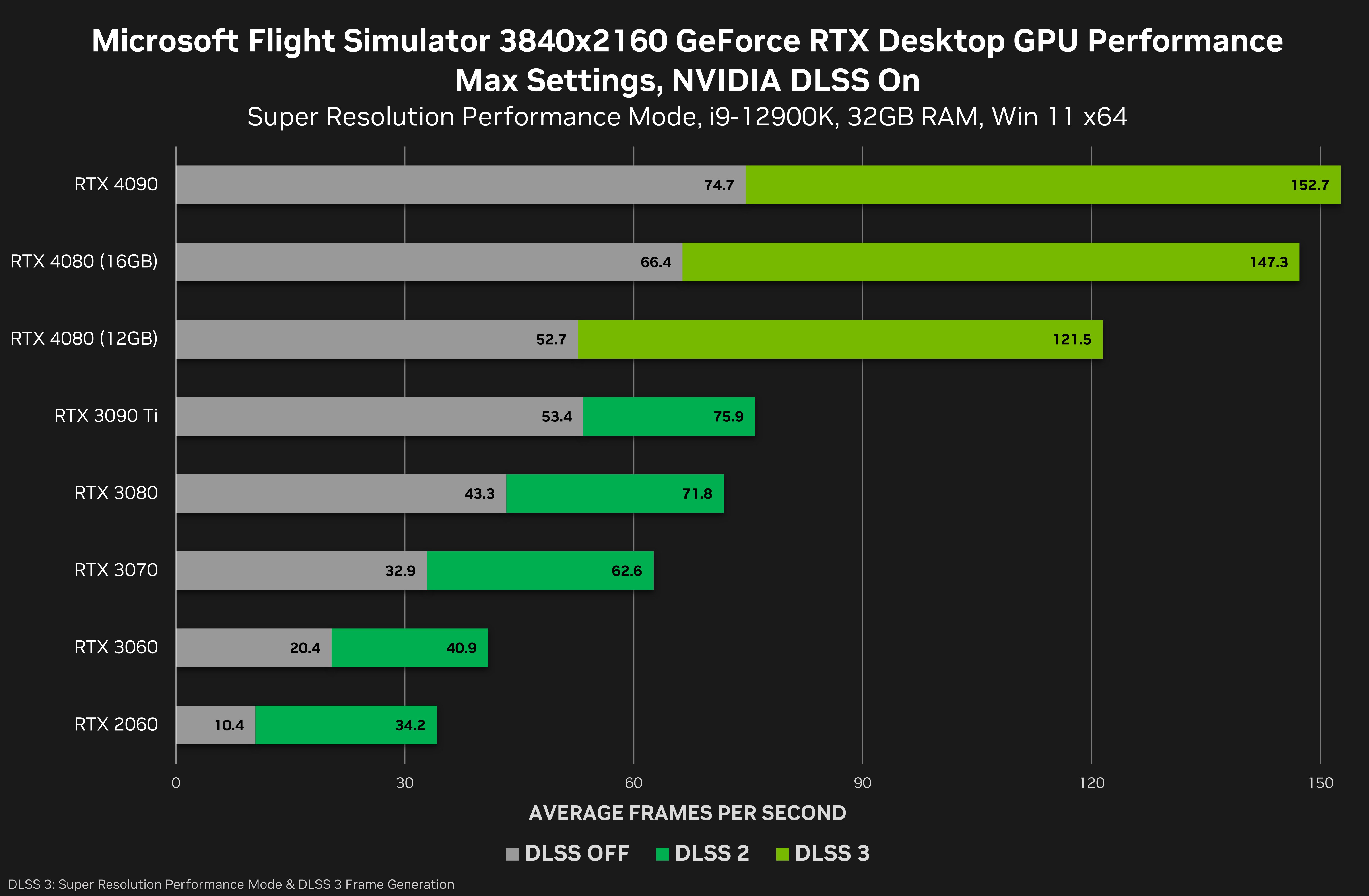

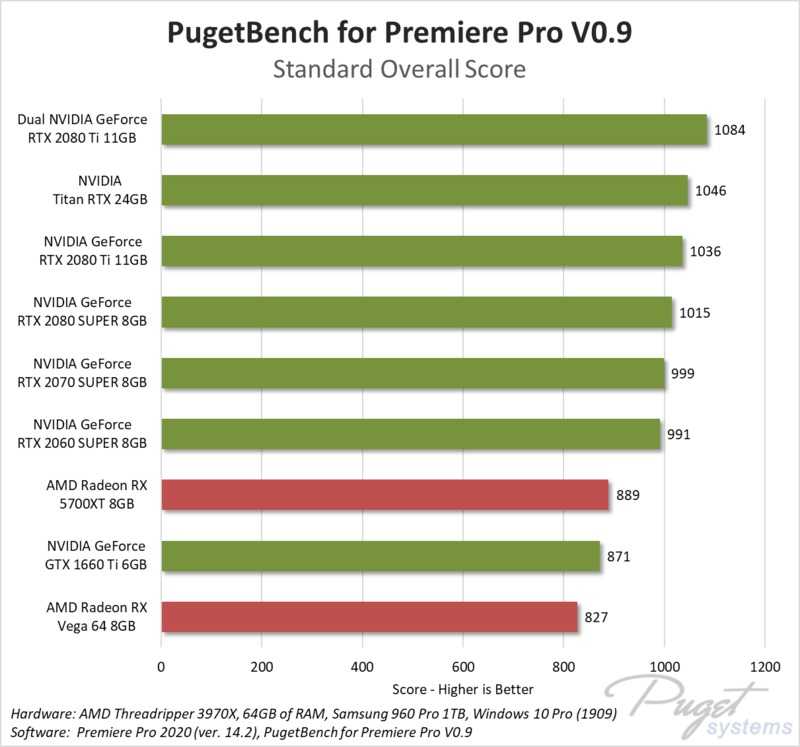

К примеру, графический адаптер значительно ускоряет монтаж видео даже в 4К, как сам процесс с предварительным просмотром, так и финальный рендер, что хорошо видно по загрузке GPU на мониторинге, а также по скорости работы программы. Такое же ускорение можно получить и в других графических и видеоредакторах, и профессиональных приложениях.

Такое же ускорение можно получить и в других графических и видеоредакторах, и профессиональных приложениях.

Кстати, здесь напомним, что у NVIDIA есть драйверы Studio, оптимизированные для тех, кто за компьютером в первую очередь работает, а не играется.

Если же ПК в первую очередь игровой, то стандартные драйверы обновляются довольно часто для улучшения поддержки новых игр, в которые добавляется в том числе фирменных технологий, например, DLSS или NVIDIA Reflex, а также оптимизации производительности в старых хитах.

Например, берем киберспортивную CS:GO для простоты на карте «Nuke» против ботов. Что у Full HD, что у Quad HD даже с максимальными настройками играть комфортно со средним fps за триста в первом случае и под триста во втором. На высокогерцовых мониторах будет то что нужно!

Или вот давайте в Dota 2 посмотрим трансляцию матча с максимальными настройками. Вновь в обоих случаях, то есть в 1080p и 1440p видеокарта обеспечивает комфортный гейсплей. Так, как всегда в этой игре, в начале матча есть немного подтупливаний, пока игра не закэшит все что нужно, а дальше никаких проблем, даже очень редкие события переваливают за сотню.

Так, как всегда в этой игре, в начале матча есть немного подтупливаний, пока игра не закэшит все что нужно, а дальше никаких проблем, даже очень редкие события переваливают за сотню.

Даже в более тяжелой и жадной к ресурсам СoD: Warzone с максимальными настройками графики нет нареканий к плавности видеоряда в самых популярных разрешениях. Даже небольших подлагиваний при езде на транспорте в этот раз не было.

То есть и простые популярные, и даже ресурсоемкие состязательные игры на RTX 3060 идут без проблем. Что касается тяжелых ААА-проектов, то посмотрим не на них уже в сравнительной части.

На чем тестировали?

Прежде, чем переходить к более близкому знакомству с видеокартами, осталось лишь напомнить конфиг системы, в которой мы их протестировали.

В основу системы легла доступная материнская плата GIGABYTE B660M GAMING DDR4.

Процессор взяли 6-ядерный 12-поточный Intel Core i5-12600 с рабочими частотами в диапазоне 3,3 – 4,6 ГГц.

Процессор достаточно горячий, поэтому охлаждали его немаленьким кулером Arctic Freezer 34 eSports DUO Black/Red.

Оперативной памяти установили 32 ГБ двумя модулями DDR4-3200 GOODRAM IRDM X Black.

Операционную систему и прочее установили на SSD GOODRAM IRDM M.2 на 512ГБ.

Источником питания выступил GIGABYTE P850GM 850W, которого хватило с запасом.

А разместились все эти компоненты в корпусе DeepCool MATREXX 40 Tempered Glass.

Подробнее о видеокартах

Сразу скажем, что все модели в названии имеют уточнение rev.2.0. Это означает, что в них встроена защита от майнинга – карты для этого не подходят. А вот работа и игры – пожалуйста!

И еще один момент – непосредственно печатные платы практически одинаковые. Особенно у трех младших, у которых 6 фаз стабилизатора питают GPU, а еще 2 – память. Итого 8 фаз. Несколько отличается здесь AORUS ELITE. У нее питание обеспечивается по схеме 8+2, то есть на две больше, что должно обеспечить более высокие частоты – проверим немного позже.

Несколько отличается здесь AORUS ELITE. У нее питание обеспечивается по схеме 8+2, то есть на две больше, что должно обеспечить более высокие частоты – проверим немного позже.

В основном карты отличаются системами охлаждения, к ним и переходим.

Самая молодая и доступная карта из протестированных – GIGABYTE GeForce RTX 3060 EAGLE OC 12G (rev.2.0). И только она несет на себе два вентилятора. Они имеют диаметр 100 мм и вращаются в разные стороны для создания более сильного потока воздуха, а лопасти имеют рифления для его лучшего распределения.

Длина видеокарты небольшая – всего 242 мм. Она занимает два слота расширения. Дополнительное питание – 8 pin.

Самое интересное – заявленная Boost-частота – 1807 МГц, в то время как у эталонной карты – 1777 МГц. Три семерки запомнить легко – дальше будем сравнивать.

Есть даже немного подсветки RGB Fusion 2.0 – светящаяся надпись EAGLE, то есть «Орел» в переводе.

У GIGABYTE GeForce RTX 3060 Gaming OC 12G (rev. 2.0) также двухслотовая система охлаждения, но оснащена уже тремя вентиляторами по 80 мм каждый.

2.0) также двухслотовая система охлаждения, но оснащена уже тремя вентиляторами по 80 мм каждый.

Радиатор пронизывают три тепловые трубки, с таким же прямым контактом к чипу для лучшей съемки тепла. Требование к питанию аналогично предыдущей карте – блок на 550 Вт и один дополнительный разъем на 8 pin. Длина карты, конечно, больше – 282 мм.

Частота GPU на 30 МГц выше предыдущей – 1837 МГц. Немного подсветки также есть – светящийся логотип «GIGABYTE».

Расположение, кстати, лучше – на торце ее лучше видно через прозрачную боковую панель корпуса.

Далее практически полная копия Gaming – модель GIGABYTE GeForce RTX 3060 VISION OC 12G (rev.2.0). Также три 80 мм вертушки, три тепловые трубки и частота – 1837 МГц. Даже по размерам почти один в один. Разница – пара миллиметров.

Главная же фишка, как вы поняли – дизайн в светлом исполнении. Если собирается система в аналогичном оформлении, такая карточка впишется на ура.

И, в конце концов, AORUS GeForce RTX 3060 ELITE 12G (rev.2.0). Ее система охлаждения – самая большая из всех. Она более толстая, занимает примерно 3 слота расширения, а по длине достигает почти 30 см. К GPU прижимаются 5 тепловых трубок.

Главная фишка кулера – круговая подсветка вентиляторов. Возможно, поэтому производитель рекомендует использовать блок питания на 100 Вт более мощный – 650 Вт, а кроме 8-контактного дополнительного питания понадобится еще один 6-контактный разъем.

Заявленная частота GPU на 30 МГц выше чем у других карт – 1867 МГц.

Кроме того, стоит отметить, что у всех карточек частично продувается бэкплейт. Это окошко позволяет более эффективно выбрасывать горячий воздух за пределы радиатора.

Нагрев и частоты в стресс-тесте

А теперь сравним системы охлаждения в тяжелых условиях. Все карты прогревались под максимальной нагрузкой стресс-тестом FurMark.

Очевидно, тяжелее всего в данном сценарии оказалось 2-вентиляторный 3060 EAGLE. Температура GPU повышалась до 75.5°C, а самая горячая точка, которую поймали датчики, составила почти 91°C. Кулер при этом работал на 94% от своей максимальной скорости. Однако EAGLE на время взяла самую высокую частоту GPU – 1942 МГц. Сможет ли она приблизиться к ней в играх? Узнаем чуть позже.

Температура GPU повышалась до 75.5°C, а самая горячая точка, которую поймали датчики, составила почти 91°C. Кулер при этом работал на 94% от своей максимальной скорости. Однако EAGLE на время взяла самую высокую частоту GPU – 1942 МГц. Сможет ли она приблизиться к ней в играх? Узнаем чуть позже.

Версия VISION обдувается более эффективно. Температура – 71,2°C, а Hot Spot – 83,4°C. При этом у вертушек меньшего диаметра более высокая скорость, они разгонялись на дополнительные 460 об/мин по сравнению с EAGLE. И для них это всего 80% от максимума. Зафиксированный потолок частоты – 1890 МГц.

RTX 3060 Gaming OC показала оптимальное соотношение температуры и процентной нагрузки системы охлаждения среди 4-х модификаций. Разогрев GPU уже ниже психологической отметки в 70°C, а кулеры работают на 77% своих возможностей. Максимальная частота GPU – 1867 МГц.

И, наконец, AORUS RTX 3060 ELITE удалось показать самый холодный результат – 67,4°C, при Hot Spot – 77,6°C. Для этого система охлаждения в пике раскручивалась до 90% своих возможностей, что в цифрах — 2118 об/мин.

Для этого система охлаждения в пике раскручивалась до 90% своих возможностей, что в цифрах — 2118 об/мин.

|

|

GPU |

Hot Spot |

Fan (Max) |

GPU Clock (Max) |

Mem Clock |

|

AORUS RTX 3060 ELITE |

67,4℃ |

77,6℃ |

2118 RPM (90%) |

1875 MHz |

1875 MHz |

|

RTX 3060 Gaming OC |

68,9℃ |

79,7℃ |

2234 RPM (77%) |

1867 MHz |

1875 MHz |

|

RTX 3060 VISION OC |

71,2℃ |

83,4℃ |

2360 RPM (80%) |

1890 MHz |

1875 MHz |

|

RTX 3060 EAGLE OC |

75,5℃ |

90,8℃ |

1903 RPM (94%) |

1942 MHz |

1875 MHz |

Итого, финальная сводка результатов выглядит так. Можно сказать, что стрессовую нагрузку карты переносят одинаково хорошо, сохраняя температуры в норме, ведь потолок для RTX 3060 – 93°С. Если раздавать места – золото у AORUS ELITE, серебро у Gaming, а бронза достается Vision. EAGLE выигрывает в категории «компактность» – она лучше станет в маленький корпус. Что касается шума, то в нашей системе у всех он примерно одинаков – сравнительно невысокий. По субъективным ощущениям — EAGLE и Gaming немного тише остальных.

Можно сказать, что стрессовую нагрузку карты переносят одинаково хорошо, сохраняя температуры в норме, ведь потолок для RTX 3060 – 93°С. Если раздавать места – золото у AORUS ELITE, серебро у Gaming, а бронза достается Vision. EAGLE выигрывает в категории «компактность» – она лучше станет в маленький корпус. Что касается шума, то в нашей системе у всех он примерно одинаков – сравнительно невысокий. По субъективным ощущениям — EAGLE и Gaming немного тише остальных.

Сравним четыре RTX 3060

На что способны наши участницы под максимальной нагрузкой, мы уже узнали, теперь оценим, какую производительность они дают в рабочей и игровой нагрузке.

У Blender 3-вентиляторные модификации практически идентичны. Они обгоняют EAGLE в среднем на 3-4%.

А вот бенчмарк V-Ray построил более наглядную лесенку. AORUS обходит самую молодую модификацию уже на 7-12%. В свою очередь Gaming и VISION находятся посредине – с преимуществом 3-4% над EAGLE.

У 3DMark Time Spy 2-вентиляторная EAGLE вероятно не принимала настолько высокие частоты, как у стресс-теста, что и поставило ее чуть ниже версии Gaming. Понятно, что в общем-то здесь разница исчисляется плюс-минус одним процентом. Самый высокий результат у AORUS – она обошла младшую на 2,5% по показателю Graphics Score.

Понятно, что в общем-то здесь разница исчисляется плюс-минус одним процентом. Самый высокий результат у AORUS – она обошла младшую на 2,5% по показателю Graphics Score.

В целом понятно, что для рабочих задач принципиальной разницы нет – все RTX 3060 крутые и хорошо оптимизированные под популярные программы. Но если искать лучший вариант на этом GPU – выбор AORUS Elite. Оптимальными же будут VISION или Gaming, а замыкающий список – EAGLE.

А теперь основное блюдо этого обзора – сравнение в играх. Удастся ли нащупать между картами ощутимую разницу? Какие в реальных играх температуры и частоты? Узнаем на примере 9 сценариев с разным разрешением и настройками графики.

Начинаем с Cyberpunk 2077 в разрешении 1080p и на ультранастройках. Пока что без лучей и DLSS. У всех карт разница в пределах погрешности измерений. Все держат отличную частоту GPU в районе 1900 МГц с лихвой. Это высшее значение в стресс-тесте. Лучшей была Vision – ее частоты стабильно высокие, что и вылилось в 3-4% преимущества над 2-вентиляторным Eagle.

Обращая внимание на соотношение шума и температур к скорости, побеждает Gaming. Она на 5°C холоднее и немного тише, чем Vision.

Включение чудодейственной технологии DLSS в режиме «качество» увеличивает частоту кадров на 30 с лишним процентов! На треть! Без заметного проседания в детализации. Теперь карточки стабильно держат частоту выше 1950 МГц, только EAGLE зацепилась за 1920 МГц, что обеспечило ей на 4% меньшую среднюю частоту, чем у AORUS. Кстати, референсная Boost-частота для RTX 3060 – 1777 МГц.

Продолжаем нащупывать баланс картинки и производительности — включаем ультратрассировку лучей, а DLSS переводим в режим «Производительность». В таком сценарии лучше справилась модель AORUS – единственная взяла 2025 МГц, еще и при самой низкой температуре. На втором месте в этом плане оказалась Gaming, у нее тоже 66°C, хорошая частота в 1972 МГц и 60 fps в среднем.

За счет технологии DLSS в режиме «производительность» можно получить такой же плавный и стабильный геймплей в разрешении 1440p. Пока без Ray Tracing. На первом месте снова AORUS. Например, она на 7°C холоднее EAGLE и на 7% обходит ее по очень редким событиям. Снова золотой серединой выглядит Gaming – вторая по температуре и скорости, а в хвосте – двухвентиляторный EAGLE.

Пока без Ray Tracing. На первом месте снова AORUS. Например, она на 7°C холоднее EAGLE и на 7% обходит ее по очень редким событиям. Снова золотой серединой выглядит Gaming – вторая по температуре и скорости, а в хвосте – двухвентиляторный EAGLE.

И заканчиваем с Cyberpunk 2077 в разрешении 1440p, ультра-лучами и DLSS в режиме «Производительность». Планка средней частоты спускается до 43-45 к/с. Можно сказать, что такой режим вполне комфортен для прохождения. В этом сценарии побеждает VISION, поскольку почти железобетонно держит частоту 1965 МГц. Например, она на 5-9% обошла самую молодую карточку. Второе место между собой делят модели Gaming и Aorus, показывая чуть меньшую частоту, но зато более комфортные температуры.

Переходим ко второй игре – Dying Light 2. Первый этап в разрешении Full HD с максимальными настройками графики, которые называются High, и без технологии DLSS. Снова видим, что какой-то сакральной разницы нет, карточки отличаются на 1-2 к/с, что без мониторинга не почувствовать. По связке температура-частота GPU победила модель Gaming – 69°C и около 1935 МГц. Например, у компактной EAGLE – 77°C и частота чуть ниже 1900 МГц.

По связке температура-частота GPU победила модель Gaming – 69°C и около 1935 МГц. Например, у компактной EAGLE – 77°C и частота чуть ниже 1900 МГц.

С включением трассировки лучей высокого качества и DLSS в режиме Performance сохраняем практически такую же плавность геймплея с незначительной потерей резкости на отдельных текстурах. Градация между картами особо не изменилась. Только VISION выделилась более стабильной частотой, что дало ей 1-2 кадра преимущества над другими.

Переход к разрешению Quad HD. Настройки по-прежнему максимальны, кроме DLSS в режиме Качество и пока без лучей. По-видимому, здесь победителем можно назвать RTX 3060 Gaming OC, поскольку при минимальной температуре в 69°C она показала почти максимальный фреймрейт. Vision у нее обычно отгрызла 2% по средней частоте, но и на те же 2°C оказалась горячей.

И заканчиваем в 1440p с качественной трассировкой лучей. Частота просела примерно на 30%, но благодаря чудодейственной DLSS в режиме «производительности» все равно удалось сохранить достаточно плавный геймплей. По температурам и частотам все по-прежнему: Vision выигрывает 1 fps, а Gaming и AORUS холоднее на 3°C; EAGLE как обычно – на 8 пунктов горячее.

По температурам и частотам все по-прежнему: Vision выигрывает 1 fps, а Gaming и AORUS холоднее на 3°C; EAGLE как обычно – на 8 пунктов горячее.

Выводы

Все видеокарты показали отличную производительность за счет частот около 1900 МГц и выше для GPU RTX 3060, который сейчас едва ли не лучший для рабочих задач и игр с трассировкой лучей по своей стоимости. Даже в 1440p, если включить магическую технологию DLSS. Но за счет разных систем охлаждения – отличия все же есть.

2-вентиляторная GIGABYTE GeForce RTX 3060 EAGLE OC 12G (rev.2.0) временами на 7-9°C горячая чем самые холодные Gaming и AORUS. И до 4-9% слабее их по частоте кадров в некоторых сценариях. При плохом охлаждении корпуса эта разница может еще немного увеличиться. С другой стороны, EAGLE лучше совместима с тесными системными корпусами и самая дешевая.

С другой стороны, EAGLE лучше совместима с тесными системными корпусами и самая дешевая.

GIGABYTE GeForce RTX 3060 Gaming OC 12G (rev.2.0) – выглядит как золотая середина среди всех 4-х по показателям цена/возможности и скорость/температура. Сейчас она всего на 800-1000 грн дороже 2-вентиляторной. При этом под максимальной нагрузкой используется всего 77% скорости вентиляторов против 94% у младшей. Этот запас можно конвертировать в лучшую температуру или в небольшой разгон. Уровень шума у нее тоже ниже других, по субъективным ощущениям.

Модель GIGABYTE GeForce RTX 3060 VISION OC 12G (rev.2.0) в среднем на 1-2% быстрее Gaming, но на пару градусов горячее и немного громче. Цена плюс-минус такая же. Итак, ее сильная сторона – светлый дизайн под такие же компоненты системы.

Что касается AORUS GeForce RTX 3060 ELITE 12G (rev.2.0), то технически она холодная, выигрывает у Gaming 1-2°C. Благодаря этому держит немного выше частоты, иногда даже рубеж 2000 МГц пересекает, что обеспечивает стабильный бонус в 1-2 кадра. Но, по всей вероятности, большинство не захочет переплачивать именно за это. А вот за крутую подсветку, если в корпусе имеется прозрачная боковина – вполне вероятно.

Благодаря этому держит немного выше частоты, иногда даже рубеж 2000 МГц пересекает, что обеспечивает стабильный бонус в 1-2 кадра. Но, по всей вероятности, большинство не захочет переплачивать именно за это. А вот за крутую подсветку, если в корпусе имеется прозрачная боковина – вполне вероятно.

Автор: Денис Козиолек

2021 2020 Сравнение тестов глубокого обучения: NVIDIA RTX 3090 и NVIDIA A100 40 ГБ (PCIe)

NVIDIA RTX 3090 и NVIDIA A100 40 ГБ (PCIe)

- Тесты

- Технические характеристики

Лучшие графические процессоры для глубокого обучения, искусственного интеллекта и вычислений в 2022–2023 годах. Рекомендуемые графические процессоры. Рекомендуемое оборудование для глубокого обучения и исследований ИИ

Наши тесты GPU для глубокого обучения, искусственного интеллекта и 3D-рендеринга помогут вам решить, какие видеокарты NVIDIA RTX 4090, RTX 4080, RTX 3090, RTX 3080, A6000, A5000 или RTX 6000 ADA Lovelace — лучший графический процессор для ваших нужд. Мы проводим глубокий анализ производительности каждой графической карты, чтобы вы могли принять максимально обоснованное решение. Мы предлагаем тесты глубокого обучения и 3D-рендеринга, которые помогут вам получить максимальную отдачу от вашего оборудования.

Мы проводим глубокий анализ производительности каждой графической карты, чтобы вы могли принять максимально обоснованное решение. Мы предлагаем тесты глубокого обучения и 3D-рендеринга, которые помогут вам получить максимальную отдачу от вашего оборудования.- NVIDIA h200 против A100 против RTX 6000 Ада

- NVIDIA RTX 4090 против RTX 4080 против RTX 3090

- NVIDIA RTX 3080 против 3080 Ti против RTX 3090

- NVIDIA RTX 3090 против NVIDIA A6000

- Сравнение NVIDIA A6000 с A5000 и NVIDIA RTX 3090

- NVIDIA A100 против NVIDIA A6000

- NVIDIA RTX 2080 Ti против Titan RTX против Quadro RTX8000

- NVIDIA Titan RTX, Quadro RTX6000, Quadro RTX8000

- NVIDIA GTX 1080 Ti против RTX 2080 Ti

Тесты GPU для глубокого обучения, 2022-2023

Resnet50 (FP16)

1 GPU

NVIDIA RTX 3090

1071

NVIDIA A100 40 ГБ (PCIe)

2179

4 GPU

NVIDIA RTX 3090

2922

NVIDIA A100 40 ГБ (PCIe)

8561

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

16797

Resnet50 (FP16 XLA)

1 GPU

NVIDIA RTX 3090

9 0038 н/дNVIDIA A100 40 ГБ (PCIe)

н/ a

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

900 38 NVIDIA A100 40 ГБ (PCIe)н/д

Resnet50 (FP32)

1 GPU

NVIDIA RTX 3090

596

NVIDIA A100 40 ГБ (PCIe)

1001

4 GPU 9 0013

NVIDIA RTX 3090

1625

NVIDIA A100 40 ГБ (PCIe)

3849

8 GPU

NVIDIA RTX 3090

нет данных

NVIDIA A100 40 ГБ (PCIe)

7557

Resnet50 (FP32 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 ГП

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 ГП

90 038 NVIDIA RTX 3090н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Resnet152 (FP16)

1 GPU

NVIDIA RTX 3090

491

NVIDIA A100 40 ГБ (PCIe)

930

4 GPU

NVIDIA RTX 3090

1029

NVIDIA A100 40 ГБ (PCIe)

3557

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

6809

Resnet152 (FP16 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

нет

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA R TX 3090

н/д

NVIDIA A100 40 ГБ (PCIe )

н/д

Resnet152 (FP32)

1 GPU

NVIDIA RTX 3090

223

NVIDIA A100 40 ГБ (PCIe) 90 013

409

4 GPU

NVIDIA RTX 3090

434

NVIDIA A100 40 ГБ (PCIe)

1498

8 ГП

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

2851

Resnet152 (FP32 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

нет данных

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

нет данных

Inception V3 (FP16)

1 GPU

NVIDIA RTX 3090

715

NVIDIA A100 40 ГБ (PCIe)

9 0038 12834 GPU

NVIDIA RTX 3090

1720

NVIDIA A100 40 ГБ (PCIe)

5218

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

10122

Начальная версия V3 (FP16 XLA)

1 графический процессор

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 4 0 ГБ (PCIe)

н/д

8 графических процессоров

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Inception V3 (FP32)

1 GPU

NVIDIA RTX 3090

399

NVIDIA A100 40 ГБ ( PCIe)

658

4 GPU

NVIDIA RTX 3090

1267

NVIDIA A100 40 ГБ (PCIe)

2568

8 GPU

NVIDIA RTX 3090

н/д

9 0038 NVIDIA A100 40 ГБ (PCIe)5058

Inception V3 (FP32 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe )

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Inception V4 (FP16)

1 GPU

NVIDIA R TX 3090

383

NVIDIA A100 40 ГБ (PCIe )

616

4 GPU

NVIDIA RTX 3090

1022

NVIDIA A100 40 ГБ (PCIe)

2377

9 0038 8 GPUNVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe )

4532

Начало V4 (FP16 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA R TX 3090

н/д

NVIDIA A100 40 ГБ (PCIe )

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

900 36 Inception V4 (FP32)1 GPU

NVIDIA RTX 3090

156

NVIDIA A100 40 ГБ (PCIe)

290

4 GPU

NVIDIA RTX 3090

319

NVIDIA A100 40 ГБ (PCIe)

1031

8 GPU 90 013

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

1950

Inception V4 (FP32 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

900 38 н/д4 графических процессора

NVIDIA RTX 3090

н /a

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

V GG16 (FP16)

1 GPU

NVIDIA RTX 3090

577

NVIDIA A100 40 ГБ (PCIe)

1249

4 GPU

NVIDIA RTX 3090

1004

NVIDIA A100 40 ГБ (PCIe)

4989

8 GPU

NVIDIA RTX 3090

нет a

NVIDIA A100 40 ГБ (PCIe)

10733

VGG16 (FP16 XLA)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe) 90 013

нет

4 GPU

NVIDIA RTX 3090

нет /a

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe) )

н/д

VGG16 (FP32)

1 ГП

NVIDIA RTX 3090

341

NVIDIA A100 40 ГБ (PCIe)

529

4 GPU

NVIDIA RTX 3090

1077

NVIDIA A100 40 ГБ (PCIe)

2215

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

4278

VGG16 (FP32 XLA)

1 GPU

NVIDIA RTX 3090

н/д

90 038 NVIDIA A100 40 ГБ (PCIe)н/д

4 графических процессора

NVIDIA RTX 3090

нет

NVIDIA A100 40 ГБ (PCIe)

н/д

8 ГП

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe) 9 0013

н/д

Googlenet (FP16)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA RTX 3090 9001 3

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 ГП

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Googlenet (FP32)

1 GPU

NVIDIA RTX 3090

н/д

900 38 NVIDIA A100 40 ГБ (PCIe)н/д

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090 9001 3

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

3D, GPU-рендеринг: контрольные показатели, 2022–2023 гг.

V-Ray

1 GPU

NVIDIA RTX 3090

2185

NVIDIA A100 40 ГБ (PCIe)

1555

4 GPU 9 0013

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe )

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

900 36 Octane1 GPU

NVIDIA RTX 3090

769

NVIDIA A100 40 ГБ (PCIe)

498

4 ГП

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 ГП 900 13

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Redshift

1 GPU

NVIDIA RTX 3090

2.3

NVIDIA A100 40 ГБ (PCIe)

9 0038 н/д4 GPU

NVIDIA RTX 3090

н/ a

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Blender 9003 7

1 GPU

NVIDIA RTX 3090

6010. 36

36

NVIDIA A100 40 ГБ (PCIe)

3788

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/ a

NVIDIA A100 40 ГБ (PCIe)

н/д

Luxmark

1 GPU

NVIDIA RTX 3090

95123

NVIDIA A100 40 ГБ (PCIe)

н/д 9 0013

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н /a

Unreal Engine

1 GPU

NVIDIA RTX 3090

47,6

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

RELION Cryo-EM Benchmarks 2022-2023

Общее время работы

1 GPU

NVIDIA RTX 3090

9 0038 165,9NVIDIA A100 40 ГБ (PCIe)

178,9

4 GPU

NVIDIA RTX 3090

57,1

NVIDIA A100 40 ГБ (PCIe)

50,3

8 GPU

NVIDIA RTX 3090

н/д

9 0038 NVIDIA A100 40 ГБ (PCIe)н/д

BERT LARGE Обучение, Inference Benchmark 2022–2023

Время обучения (FP16)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

900 38 н/д4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Производительность (FP16)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 ГП

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (ПК То есть)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Время обучения (FP32)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

900 38 н/д4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Производительность ( FP32)

1 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

4 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe) 9 0013

нет данных

8 GPU

NVIDIA RTX 3090

н/д

NVIDIA A100 40 ГБ (PCIe)

н/д

Дизайн платы

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Длина | 336 мм | 267 мм |

| Выходы | 1x HDMI, 3x DisplayPort | Нет выходов |

| Разъемы питания | 1x 12-контактный | 8-контактный EPS |

| Ширина паза | Трехслотовый | Двойной слот |

| Расчетная мощность | 350 Вт | 250 Вт |

Тактовые частоты

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Повышенная частота | 1695 МГц | 1410 МГц |

| Тактовая частота графического процессора | 1395 МГц | 765 МГц |

| Часы памяти | 19500 МГц | 2400 МГц |

Видеокарта

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Шинный интерфейс | PCIe 4. 0 x16 0 x16 | PCIe 4.0 x16 |

| Поколение | GeForce 30 | Тесла (Ахх) |

Графические функции

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| DirectX | 12 Максимальная (12_2) | |

| OpenCL | 3,0 | 2.0 |

| OpenGL | 4,6 | |

| Модель шейдера | 6,6 | |

| КУДА | 8,6 | 8,0 |

Графический процессор

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Архитектура | Ампер | Ампер |

| Размер матрицы | 628 мм2 | 826 мм2 |

| Имя графического процессора | ГА102-300-А1 | GA100 |

| Размер процесса | 8 нм | 7 нм |

| Транзисторы | 28300 миллионов | 54200 миллионов |

Память

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Полоса пропускания | 936,2 ГБ/с | 1555 ГБ/с |

| Шина памяти | 384 бит | 5120 бит |

| Объем памяти | 24 ГБ | 40 ГБ |

| Тип памяти | GDDR6X | ХБМ2е |

Конфигурация визуализации

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| РОП | 112 | 160 |

| Сердечники RT | 82 | |

| Блоки затенения/ядра CUDA | 10496 | 6912 |

| TMU | 328 | 432 |

| Тензорные ядра | 328 | 432 |

Теоретическая производительность

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| FP16 (половина) производительность | 35,58 терафлопс | 77,97 терафлопс |

| FP32 (плавающая) производительность | 35,58 терафлопс | 19,49 терафлопс |

| FP64 (двойной) исполнение | 556 гигафлопс | 9746 гигафлопс |

| Частота пикселей | 189,8 гигапикселей/с | 225,6 гигапикселей/с |

| Скорость текстуры | 556 Гтексел/с | 609,1 Гтексел/с |

Цена

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Рекомендуемая производителем розничная цена | 1499 $ | $ |

| Дата выпуска | 1 сентября 2020 г. | 22 июня 2020 г. |

Конфигурация испытательного стенда

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Оборудование | BIZON X5000 Подробнее | BIZON X5000 Подробнее |

| Программное обеспечение | 3D-рендеринг: Драйвер Nvidia: 456.38 Тест VRay: 5 Контрольный показатель октана: 2020.1.5 Тест Redshift: демоверсия 3.0.28 Блендер: 2,90 Люксмарк: 3.1 | 3D-рендеринг: Драйвер Nvidia: 461.09 Тест VRay: 5 Контрольный показатель октана: 2020.1.5 Тест Redshift: демоверсия 3.0.28 Блендер: 2,90 Люксмарк: 3.1 |

Рекомендуемое оборудование

| NVIDIA RTX 3090 | NVIDIA A100 40 ГБ (PCIe) | |

|---|---|---|

| Лучшие рабочие станции с GPU | БИЗОН X5500 | БИЗОН X5500 |

| Лучшие серверы NVIDIA GPU | БИЗОН Х7000 |

AMD против Nvidia: полное сравнение

© Джимми Тудески / Shutterstock. com

com

Ключевые моменты

- AMD, несмотря на свою привлекательность для бюджетных сборщиков, является гораздо более зрелой компанией, чем Nvidia, поскольку она была основана почти на 25 лет раньше, чем Nvidia.

- Видеокарты обеих компаний очень близки по производительности, но серия Nvidia RTX гораздо лучше справляется с трассировкой лучей и сверхвысоким разрешением.

- Продукты Nvidia в основном представляют собой решения для обработки графики, в то время как AMD производит большую часть потребительских процессоров на компьютерном рынке вместе со своими популярными графическими процессорами.

- Графические процессоры Nvidia также используются для расширенных приложений в системах искусственного интеллекта и глубокого обучения с помощью технологии Nvidia CUDA.

- Помимо потребительских процессоров и графических процессоров, AMD также производит оперативную память и твердотельные жесткие диски.

AMD и Nvidia являются ведущими производителями графических продуктов. Однако, хотя оба они очень близки по производительности, между ними все же есть некоторые ключевые различия. Продукты Nvidia в основном представляют собой решения для обработки графики и используются для расширенных приложений в системах искусственного интеллекта и глубокого обучения.

Однако, хотя оба они очень близки по производительности, между ними все же есть некоторые ключевые различия. Продукты Nvidia в основном представляют собой решения для обработки графики и используются для расширенных приложений в системах искусственного интеллекта и глубокого обучения.

Advanced Micro Devices (AMD) производит широкий спектр микрочипов. Они также хорошо известны своими популярными линейками графических процессоров, системных процессоров, оперативной памяти и твердотельных жестких дисков. Хотя AMD часто считается бюджетным брендом, их продукты по-прежнему тесно связаны с высококлассными продуктами Nvidia.

Несмотря на это, обе компании производят широкий ассортимент продукции на любой бюджет. AMD имеет обширную линейку процессоров и гибридных процессоров, включая популярные линейки Radeon и Ryzen. Хотя Nvidia наиболее известна своими графическими процессорами GeForce (GPU), она также производит технологические продукты для множества других приложений.

AMD и Nvidia: сравнение бок о бок

| Nvidia | Advanced Micro Devices (AMD) | |

|---|---|---|

| 91 626 Дата основания общества | 5 апреля 1993 г. | 1 мая 1969 г. |

| Категории продуктов | Графические процессоры, мобильная графика, наборы микросхем материнских плат, суперкомпьютерные решения CUDA | Потребительские процессоры, графические процессоры, мобильные процессоры, профессиональные процессоры, серверные процессоры |

| Флагманский графический продукт | GeForce RTX 3090 | Radeon RX 6900 XT |

| Технология адаптивной синхронизации | G-Sync | FreeSync |

| Текущая серия GPU | Nvidia RTX line | Radeon серии 6000 |

| Основатель | Дженсен Хуанг | Джерри Сандерс |

| Графика драйвера карты | GeForce Experience, панель управления Nvidia | Radeon Adrenalin |

AMD и Nvidia: объяснение основных различий графика карточный рынок.

Двумя титанами, сражавшимися на протяжении десятилетий, были Nvidia и AMD, также называемые «Зеленой командой» и «Красной командой».

Двумя титанами, сражавшимися на протяжении десятилетий, были Nvidia и AMD, также называемые «Зеленой командой» и «Красной командой».Усовершенствованные микроустройства (AMD) обычно рассматривались как выбор для бюджетных сборок, но у AMD были моменты, когда выпуск новых продуктов временно опережал высококлассные предложения от Nvidia.

Если вы хотите выбрать новую видеокарту или узнать больше об этих двух компаниях, в следующем руководстве мы сравним их и продукты, которые они предлагают в настоящее время.

Линейки продуктов Nvidia

Nvidia наиболее известна на потребительском рынке своими популярными графическими процессорами GeForce (GPU), но они также производят технологические продукты для множества других приложений. Чип Nvidia Tegra — это вычислительное решение для мобильных устройств, а Tesla — их процессор для научных и инженерных приложений. Nvidia Drive — это серия технологий для автономных беспилотных транспортных средств, а nForce — технология набора микросхем, которая взаимодействует с системными процессорами на популярных потребительских материнских платах.

Графические процессоры Nvidia также используются в научных исследованиях и суперкомпьютерах. API CUDA (Compute Unified Device Architecture) — это технология, которая поддерживает большое количество ядер графического процессора для параллельной обработки. Лаборатории и исследовательские группы используют CUDA в обширных системах нейронных сетей для поддержки передовых проектов глубокого обучения и искусственного интеллекта.

Линейки продуктов AMD

AMD предлагает обширную линейку продуктов, включая популярную графическую карту Radeon.©Ralf Liebhold/Shutterstock.com

AMD (Advanced Micro Devices) — полупроводниковая компания, производящая широкий спектр микрочипов. Они хорошо известны своими популярными линейками графических процессоров и системных процессоров. AMD рассматривается потребителями как хороший вариант для обеспечения производительности при бюджете от низкого до среднего, но их высокопроизводительные видеокарты и процессоры иногда конкурируют с высокопроизводительными продуктами Nvidia.

AMD предлагает обширную линейку процессоров и гибридных процессоров, включая бренд Athlon для бюджетных ПК, серию A для ноутбуков, Ryzen для высокопроизводительных настольных компьютеров и Ryzen Threadripper для профессионального программного обеспечения и высококлассных сборщиков энтузиастов. Линейки продуктов для чипов AMD GPU включают популярные Radeon, Mobility Radeon, Radeon Pro для рабочих станций и Radeon Instinct для серверов и приложений машинного обучения. AMD также производит оперативную память и твердотельные жесткие диски.

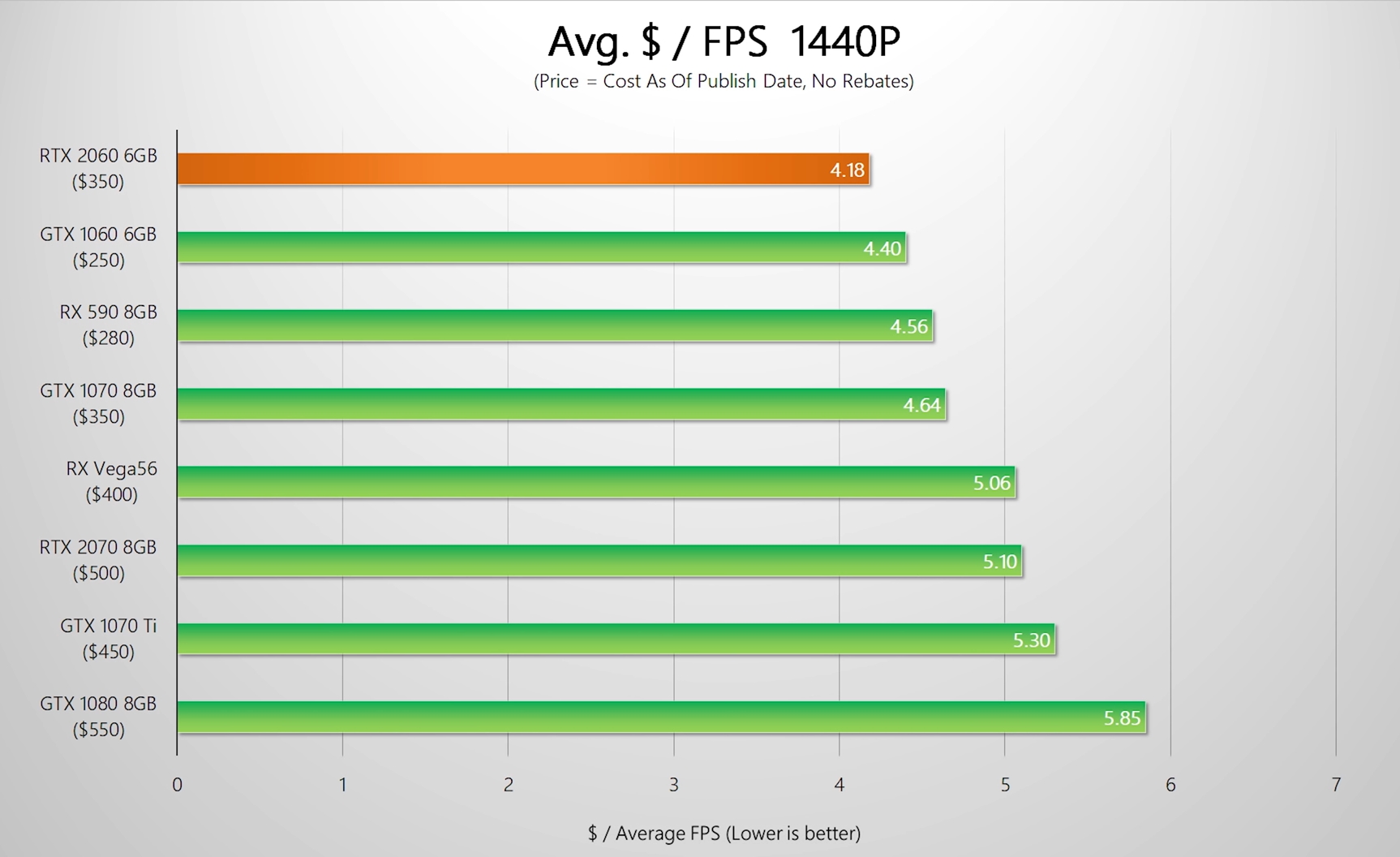

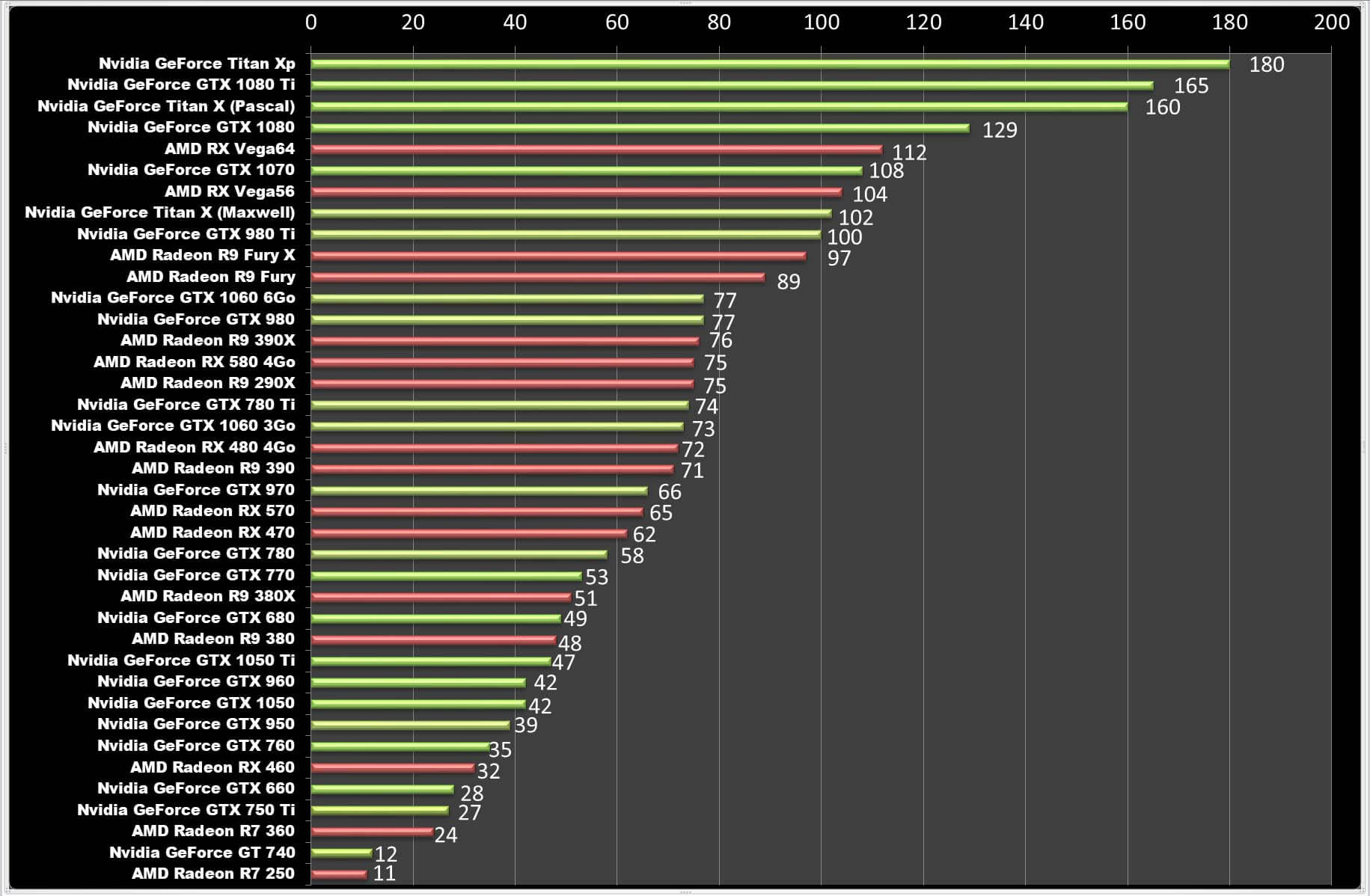

Сравнение игровой производительности в различных ценовых категориях

Обе компании выпускают графические продукты, предназначенные для трех основных ценовых диапазонов на рынке, которые делятся на категории «бюджетный», «средний» и «энтузиаст».

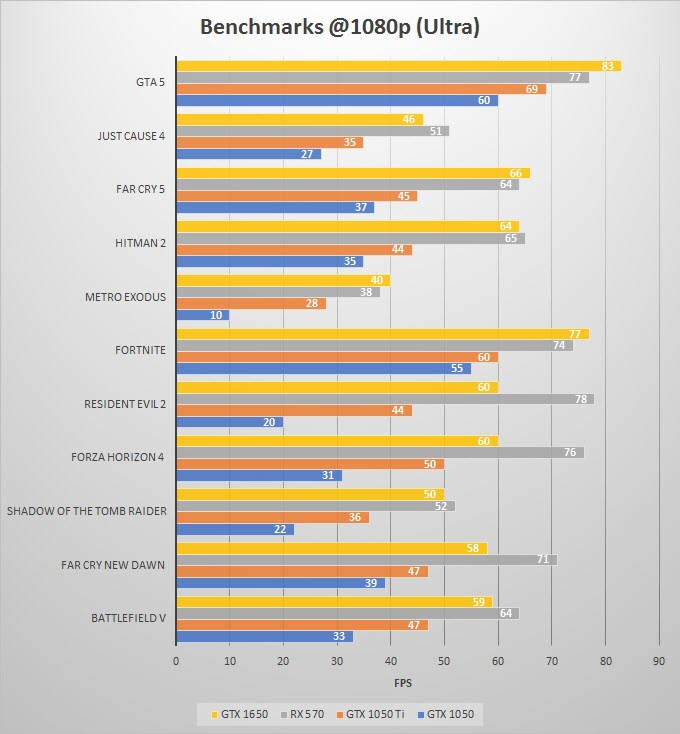

Для недорогих или «бюджетных» моделей ценовая категория в 200 долларов является целью для идеального соотношения цены и качества. Конкурирующими продуктами двух компаний в этом ценовом диапазоне являются GeForce GTX 1660 от Nvidia и RX 5500 XT от AMD. Графический процессор Nvidia повышает тактовую частоту памяти выше, чем у продукта AMD, но карта AMD имеет 8 ГБ видеопамяти по сравнению с 6 ГБ на GTX 1660 от Nvidia. В целом, с лучшими графическими драйверами GeForce GTX 1660 немного превосходит AMD RX 5500 XT.

Графический процессор Nvidia повышает тактовую частоту памяти выше, чем у продукта AMD, но карта AMD имеет 8 ГБ видеопамяти по сравнению с 6 ГБ на GTX 1660 от Nvidia. В целом, с лучшими графическими драйверами GeForce GTX 1660 немного превосходит AMD RX 5500 XT.

На среднем уровне, где большинство компьютерных геймеров хотят использовать свое развлекательное программное обеспечение, цена составляет около 400 долларов. Две конкурирующие карты на этом уровне — это RTX 3060 от Nvidia и RX 6700 XT от AMD. Карта от AMD работает лучше, чем продукт от Nvidia, но стоит немного дороже.

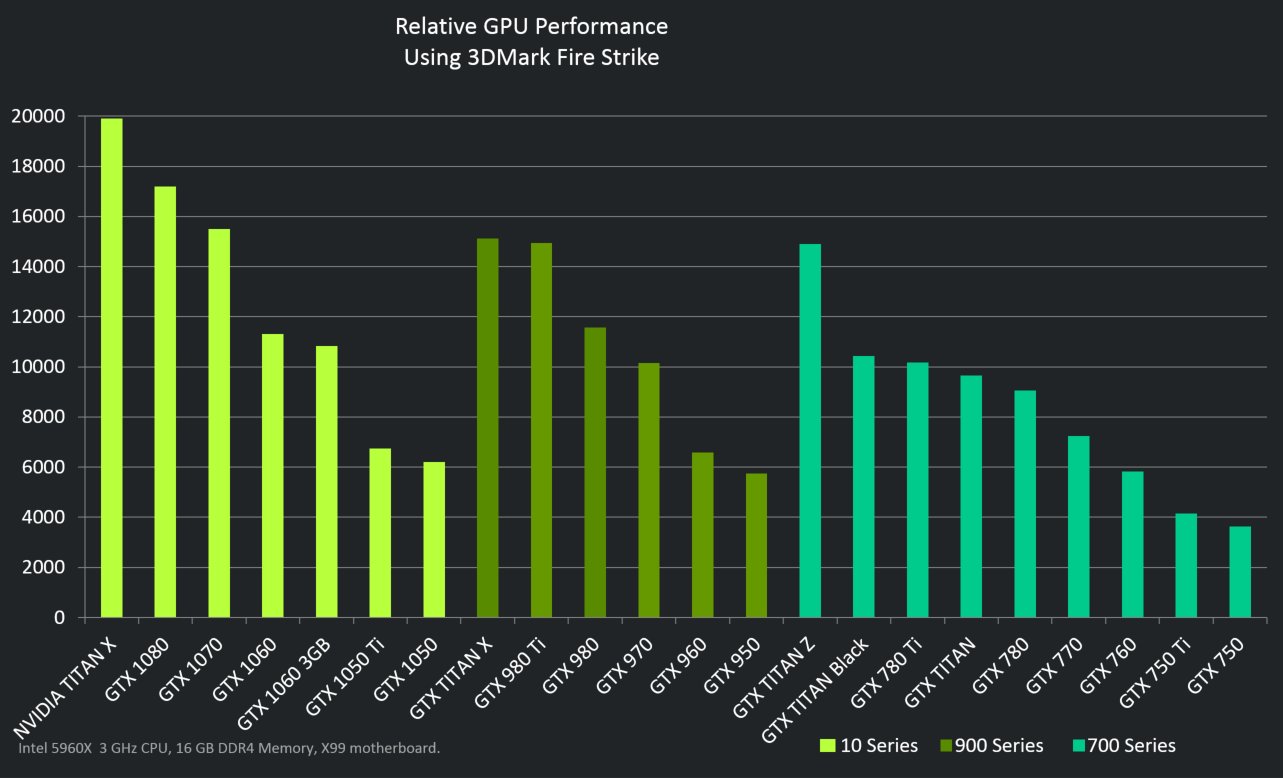

В высокопроизводительных продуктах стоимостью 700 долларов и выше основными конкурирующими картами для сравнения являются AMD RX 6800 XT и Nvidia RTX 3080. трассировка лучей включена и в сверхвысоком разрешении. Учитывая, что трассировка лучей широко не используется в современных играх, AMD, кажется, предлагает лучшую ценность на уровне энтузиастов. Однако выбор сильно зависит от вариантов использования, поэтому окончательный вердикт несколько равен.

Функции улучшения графики

Nvidia RTX 4090 и RTX 4080 16 ГБ — два самых мощных графических процессора в серии RTX.©Ralf Liebhold/Shutterstock.com

Обе компании, помимо базовой мощности рендеринга, обладают солидным набором технологий, повышающих реалистичность видеоконтента. Подход Nvidia в этом отношении является более проприетарным, часто создавая технологии, которые работают только с оборудованием Nvidia, тогда как AMD стремится создавать функции, которые могут использоваться продуктами других производителей оборудования, включая продукты Nvidia.

Одной из примечательных функций графических решений Nvidia является Ampere, функция, которая обеспечивает Nvidia Broadcast для потоковой передачи и другого видеоконтента. Используя искусственный интеллект, Nvidia Broadcast позволяет стримерам и вещателям заменять фон человека, который находится в камере, на пользовательскую среду. Эта функция также может отфильтровывать шумы из аудиоканала трансляции.

Функции улучшения игр, которые работают только с Nvidia, включают DLSS, что означает суперсэмплирование с глубоким обучением, которое использует ИИ для улучшения рендеринга в играх и повышения производительности. Основные графические карты Nvidia также поддерживают PhysX, технологию, которая увеличивает вычислительную мощность системы для имитации физики в игровом мире.

Последние функции AMD больше ориентированы на игры. Contrast Adaptive Sharpening (CAS) улучшает качество игр на мониторах с высоким разрешением. FidelityFX — это новая функция, которая позволяет большему количеству геймеров играть в разрешении 4K, тогда как их аппаратное обеспечение обычно не может адекватно работать в сверхвысоком разрешении. Затенение с переменной скоростью — это функция, которая интеллектуально выбирает, в каких областях видеоизображения сосредоточить больше энергии для детализации, обеспечивая более высокую эффективность производительности.

AMD против Nvidia: что выбрать?

Для большинства людей, читающих это, вопрос в основном актуален для выбора лучшей видеокарты для вашего бюджета и вычислительных потребностей. В настоящее время геймеры могут обнаружить, что высокопроизводительные карты Nvidia обеспечивают лучшую производительность при разрешении 4K, хотя графические процессоры AMD в целом работают немного лучше в других случаях использования.

В настоящее время геймеры могут обнаружить, что высокопроизводительные карты Nvidia обеспечивают лучшую производительность при разрешении 4K, хотя графические процессоры AMD в целом работают немного лучше в других случаях использования.

Если вы планируете играть во множество игр нового поколения с трассировкой лучей, Nvidia в настоящее время является лучшим вариантом. Для бюджетных сборок лучше всего подойдет GeForce GTX 1660 от Nvidia. Суть в том, что видеокарта является крупной покупкой для большинства потребителей, поэтому не принимайте решение, не изучив, какая карта лучше всего соответствует вашим потребностям и вашему бюджету.

Далее…

- 32-битная и 64-битная версии — полное сравнение

- FreeSync и G-Sync: полное сравнение

- x86 VS x64: полное сравнение

AMD и Nvidia: полное сравнение сын FAQs (часто задаваемые вопросы)

AMD против Nvidia: кто делает лучшие графические процессоры?

Ответ на этот извечный вопрос зависит от ваших потребностей. В настоящее время идет напряженная гонка между конкурирующими картами в разных ценовых категориях. В последние годы AMD потерпела некоторые неудачи из-за проблем с графическими драйверами, но текущие обновления устранили эти проблемы. Геймеры, которые играют со сверхвысоким разрешением на дисплеях 4K, получат лучшую производительность с картами Nvidia высокого класса. За исключением этих критериев, AMD, как правило, лучше подходит для графики среднего и высокого класса.

В настоящее время идет напряженная гонка между конкурирующими картами в разных ценовых категориях. В последние годы AMD потерпела некоторые неудачи из-за проблем с графическими драйверами, но текущие обновления устранили эти проблемы. Геймеры, которые играют со сверхвысоким разрешением на дисплеях 4K, получат лучшую производительность с картами Nvidia высокого класса. За исключением этих критериев, AMD, как правило, лучше подходит для графики среднего и высокого класса.

Что лучше, AMD или Nvidia?

Выбор компании по лояльности клиентов — дело вкуса. AMD — более старая компания, и они производят более широкий спектр продуктов. У Nvidia более привлекательный бренд высокого класса, и это может побудить некоторых энтузиастов отдать предпочтение этой компании.

AMD или Nvidia лучше для потоковой передачи?

Благодаря Nvidia Broadcast, программной функции, которая использует искусственный интеллект, чтобы позволить вещателям менять свой фон, Nvidia имеет преимущество для потребителей, использующих видеокарту для потоковой передачи.

Ваш комментарий будет первым