Скачивание сайтов целиком

Утилита FlashGet позволяет скачивать файлы с сайтов. А как быть, когда нужно скачать сам сайт, полностью, со всем его оформлением, содержимым, ссылками на определенную глубину, словом, сделать сайт доступным автономно? Программа Teleport Pro (http://www.tenmax.com/teleport/pro/home.htm) – позволяет создавать точные копии сайтов, доступных в автономном режиме. Скачаем, например, сайт издательства «Открытые системы» www.osp.ru. После запуска программы появляется мастер, предлагающий начать работу с выбора одной из возможностей (рис. 4.23):

Рис. 4.23. Программа Teleport Pro. Выбор типа проекта.

Предлагается выбрать одно из следующих действий:

Создать копию сайта на жестком диске, которую далее можно будет просматривать в браузере

Скопировать сайт, включая структуру его папок.

Найти файлы определенного типа на заданном сайте.

Просмотреть все сайты, связанные гиперссылками с данным сайтом.

Сохранить один или несколько файлов с известных адресов.

Осуществить поиск по ключевым словам.

Поскольку мы хотим скопировать все материалы сайта для последующего их просмотра, то мы оставляем первое значение и нажимаем на кнопку «Далее». В следующем шаге мастера вводим адрес сайта (http://www.osp.ru/), который мы собираемся сохранять, отмечаем уровень вложенных ссылок, страницы которых будут загружаться и переходим к следующему шагу мастера (рис. 4.24):

Рис. 4.24. Ввод адреса сайта и уровня глубины ссылок.

В очередном шаге мастера следует выбрать,

какие объекты страницы будут сохраняться

– текст, текст и графика, текст, графика

и звуки или же все объекты полностью

(включая, например, таблицы стилей

страницы).

Рис. 4.25. Выбор объектов для сохранения.

В последнем шаге мастера сообщается о том, что проект успешно создан, а скачивание файлов начнется после нажатия кнопки «Start» (рис. 4.26):

Рис. 4.26. Завершение работы мастера.

Нажимаем эту самую кнопку «Start» и ждем. Время работы зависит от множества параметров – нашего канала связи, размера закачиваемого сайта, размеров страниц, на которые ведут гиперссылки. В ходе работы выводится такая статистика, как скорость соединения, название текущего закачиваемого объекта (рис. 4.27):

Рис. 4.27. Окно программы в ходе закачки.

После того, как работа будет завершена,

мы переходим в директорию, куда сохранялись

файлы, открываем страницу «index. htm»

и можем работать с сайтом, вообще

отключившись от Интернета (рис. 4.28):

htm»

и можем работать с сайтом, вообще

отключившись от Интернета (рис. 4.28):

Рис. 4.28. Автономная работа с сайтом.

Установив фильтр поиска в папке с сохраненными файлами по заданному расширению, например, «*.gif», можно отобразить все изображения (рис. 4.29):

Рис. 4.29. Отображение файлов заданного типа.

Скачивание сайтов целиком должно применяться исключительно для некоммерческого использования. Например, сохранив с использованием быстрого канала связи весь сайт (например, на работе) можно не спеша просматривать его дома. Моделирование сайта также может использоваться в учебных целях – учителя могут продемонстрировать работу с сайтом в школах, где может не быть Интернета.

Следует понимать, что использование

Teleport Pro для

копирования структуры чужого сайта,

заимствования оформления и дизайна

(http://www.artlebedev. ru/everything/clones/),

а также размещение чужих графических

и других материалов на своем собственном

сайте, является нарушением авторских

прав.

ru/everything/clones/),

а также размещение чужих графических

и других материалов на своем собственном

сайте, является нарушением авторских

прав.

12

Подскажите: как это организовать скачивание?

← →vasIZmax © (2007-05-11 02:14) [0]

В общем такая вот затея (может быть она уже реализована?).

Путь к файлам выглядит таким образом:

Страница_список_файлов\Страница_файл_№*_с_описанием\файл_№*.zip

как можно не открывая «Страница_файл_№*_с_описанием» скачать файл_№*.zip?

Задача была бы простой если у бы файлы качались по id какому-нибудь (как у библиотеки Ихтика к примеру, номер просто меняешь и все), но «заморочка» в том что у зипиков названия уникальные в том плане цифирки поменяв все-равно не скачаешь файл:(.

Зачем это нужно? Да просто на «Страница_файл_№*_с_описанием» много всякой «ерунды», и мне надо ее всю загружать, ради одной только ссылки((.

Как можно реализовать такой вот обход?

ЗЫ. Надеюсь, это не посчитается взлом или чем то подобным, сейчас экономия просто суровая, а файлики надо:)

← →

Knight © ( 2007-05-11 08:14) [1]

Есть какая-то прога, что-то со словом Pump…

← →

db2admin (2007-05-11 11:19) [2]

прога getRight?

← →

ПЛОВ © (2007-05-11 13:54) [3]

Вроде есть проги для выкачки целиком сайтов, и там можно задавать какие именно файлы скачивать (хтмл, картинки, архивы).

← →

homm © (2007-05-11 13:58) [4]

> и там можно задавать какие именно файлы скачивать (хтмл,

> картинки, архивы).

Интересно, как ты закачаешь картинки, не закачав HTML? 🙂

← →

ПЛОВ © (2007-05-11 14:03) [5]

> homm © (11.05.07 13:58) [4]

Я имел в виду что можно качать только хтмл или вместе с другими файлами, или качать хтмл а сохранять только, например, архивы. Без хтмл-а конечно никуда 🙂

← →

StriderMan © (2007-05-11 15:53) [6]

давным давно была прога для закачки сайтов целиком, TELEPORT кажись называлась.

← →

vasIZmax © (2007-05-12 23:50) [7]

По пробовал целиком скачать сайт….

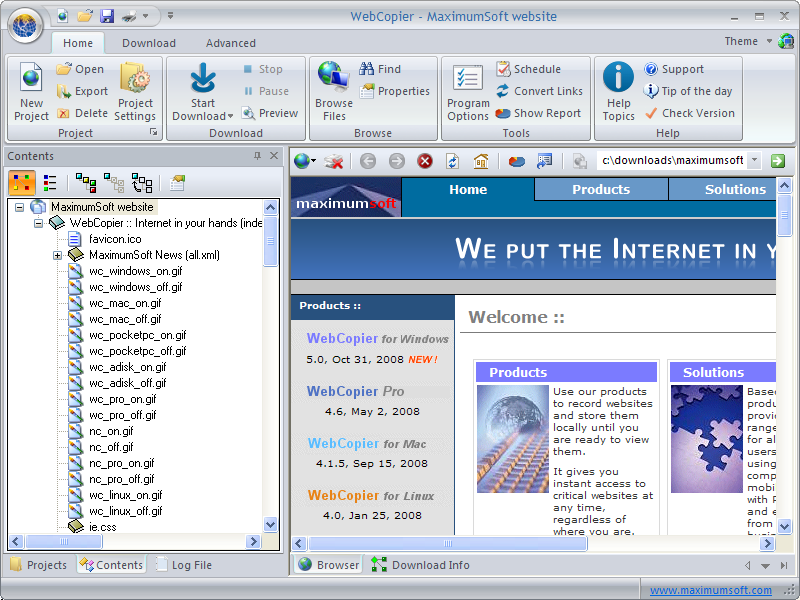

Использовал WebCopier(этим пользовался, вполне нормально всегда проходило скачивание) и MetaProducts Offline Explorer Enterprise (эту первый раз юзал).

Ошибка (HTTP код 503) - "http://www.*****.***/books.htm"

Загрузка завершена (23:40:42, Май 12, 2007)

Может какой еще может быть способ?

Вот полный путь к файлу1)http://www.********.***/?books_best&group=11

2)http://www.********.***/?getbook&id=4309&type=txt

3)http://files.ru.********.***/data/bookcatalog/Tolstoy_Lev/L.Tolstoy%20-%20Ispoved".zip

Вот как попасть с 1 ссылки на 3, или хотя бы ограничить загрузку 2 (т.е. получить только ссылку на 3 и все).

Может просто это не решаемая задачка(в настоящее время)?

ЗЫ. Звезды стоят что бы ветка не носила рекламного характера!

← →

Vendict © (2007-05-13 13:49) [8]

в одной из страниц(а может и в обоих) наверняка стоит редирект посредством html:

<META http-equiv="refresh" content="4;URL=http://длинный_путь_к_файлу. zip">

zip">так вот можно до этого редиректа и подгружать а потом смотреть ссылку, на какую он ссылается и скачивать файл.

← →

isasa © (2007-05-13 15:11) [9]

Скорее всего, страница, и, соответственно, ссылки, формируются динамически. (http:_//www.********.***/?books_best&group=11)

Так же динамически формируентся и ссылочный контент, соответствующий высылаемому пользователю образу html страницы.

Нада писать парсер страницы, высылаемой по запросу http:_//www.********.***/?books_best&group=11

с закачкой ссылок.

+ У ссылочного контента, скорее всего, ограниченое «время жизни»

← →

isasa © (2007-05-13 15:14) [10]

Не видно …/?… — выделил жирным. Там или *.dll, или *.aspx в общем, что-то из серии Server Side.

← →

homm © (2007-05-13 15:18) [11]

>Там или *. dll, или *.aspx

dll, или *.aspx

> в общем, что-то из серии Server Side.

Что в общем случае ниска не влияет на то, откуда ты вызываешь этот адресс. Дело может быть либо в куках, либо в какой-то защите «от дурака» вот для таково скачивания.

← →

Сатир (2007-05-13 15:23) [12]

TPro.exe

← →

isasa © (

homm © (13.05.07 15:18) [11]

Что в общем случае ниска не влияет на то, откуда ты вызываешь этот адресс.

Да ради Бога. Новый сеанс — новые ссылки …

← →

isasa © (2007-05-13 15:27) [14]

Да, вопрос. А файлы

http:_//files.ru.********.***/data/bookcatalog/Tolstoy_Lev/L.Tolstoy%20-%20Ispoved». zip

zip

качаются без проблем?

← →

vasIZmax © (2007-05-13 17:39) [15]

> isasa © (13.05.07 15:27) [14]

Да, качается без проблем.

Хоть я их и скачал «по одиночке» файлы, но все же интересно как можно выйти из ситуации на будующее, мало ли чего прийдется качать.

Порекомендовали wget. Сейчас разбираюсь вот.

> Сатир (13.05.07 15:23) [12]

> TPro.exe

Чего-то поисковики всякую ахинею выдают по запросу.

← →

VirEx © (2007-05-13 18:12) [16]

offline explorer,русский интерфейс, бесплатный, качай хоть весь сайт, хоть по фильтрам

← →

Сатир (2007-05-13 18:53) [17]

> TPro. exe

exe

Так это же приблуда для скачивания сайтов, называется TeleportPro, задаёшь начальную страницу, глубину скачивания, какие файлы скачивать, фильтры на линки и т.д. и т.п.

Оч. удобно.

← →

vasIZmax © (2007-05-13 19:23) [18]

> Сатир (13.05.07 18:53) [17]

… TeleportPro…. (хотя и говорилось о ней в [6])

В самом деле начал чего-то качать))), а потом появилось сообщение:

Ваш IP адрес заблокирован. Страницы сайта для Вас отдаваться не будут.

Доступ к сайту для программ рекурсивной закачки закрыт,

либо ваш компьютер запросил чрезвычайно большое количество

страниц с нашего сервера за короткое время.

Если это ошибочно - возвращайтесь на сайт через пару часов, ситуацию поправим.

Что ж подождем пару часиков:).

Всем спасибо за оказанную помощь)))

Загрузите весь веб-сайт для автономного использования с помощью wget.

Внутренние чернила будут исправлены, чтобы весь загруженный сайт работал так же, как и онлайн. · GitHub

Внутренние чернила будут исправлены, чтобы весь загруженный сайт работал так же, как и онлайн. · GitHubЗагрузите весь веб-сайт для автономного использования с помощью wget. Внутренние чернила будут исправлены, чтобы весь загруженный сайт работал так же, как и онлайн.

Есть два пути — первый способ — это всего лишь одна команда, запущенная прямо перед вами; второй работает в фоновом режиме и в другом экземпляре, поэтому вы можете выйти из сеанса ssh, и он продолжится.

Сначала создайте папку для загрузки веб-сайтов и начните загрузку: (обратите внимание, что при загрузке www.SOME_WEBSITE.com вы получите такую папку: /websitedl/www.SOME_WEBSITE.com/ )

ШАГ 1:

mkdir ~/websitedl/ cd ~/websitel/

Теперь выберите для Шага 2, хотите ли вы загрузить его просто (1-й способ) или хотите получить фантазию (2-й способ).

ШАГ 2:

1-й способ:

wget --limit-rate=200k --no-clobber --convert-links --random-wait -r -p -E -e robots=off -U mozilla http://www.SOME_WEBSITE.com

2-й способ:

ДЛЯ ЗАПУСКА В ФОНЕ:

nohup wget --limit-rate=200k --no-clobber --convert-links --random-wait -r -p -E -e robots=off -U mozilla http://www.SOME_WEBSITE.com &

ЗАТЕМ ДЛЯ ПРОСМОТРА ВЫВОДА (в любом каталоге, из которого вы запускали команду, будет файл nohup.out):

хвост -f nohup.out

ЧТО ОЗНАЧАЮТ ВСЕ ПЕРЕКЛЮЧАТЕЛИ:

--limit-rate=200k ограничить загрузку до 200 КБ/с

--no-clobber не перезаписывать существующие файлы (используется в случае прерывания загрузки и

возобновлено).

--convert-links конвертировать ссылки так, чтобы они работали локально, в автономном режиме, а не указывали на веб-сайт онлайн

--random-wait случайные ожидания между загрузками — веб-сайты не любят, когда их загружают

-r рекурсивный — скачать полный сайт

-p загружает все, даже картинки (так же, как —page-requsites, загружает изображения, элементы css и т. д.)

д.)

-E получает правильное расширение файла, без большинства html и других файлов не имеет расширения

-e robots=off вести себя так, как будто мы не роботы — не как поисковые роботы — веб-сайты не любят роботов/краулеров, если они не являются Google/или другой известной поисковой системой

-U mozilla притворяется, что браузер Mozilla просматривает страницу, а не поисковый робот, такой как wget

НАМЕРЕННО

НЕ ВКЛЮЧАЕТ СЛЕДУЮЩЕЕ: -o=/websitedl/wget1.txt записывать все в wget_log.txt — не делал этого, потому что это не выводит на экран, и мне это не нравится.

-b запускает его в фоновом режиме, и я не вижу прогресса… Мне больше нравится «nohup &»

--domain=steviehoward.com не включен, потому что он размещен в Google, поэтому может потребоваться войти в домены Google

--restrict-file-names=windows изменить имена файлов, чтобы они работали и в Windows. Вроде и без этого нормально работает.

Вроде и без этого нормально работает.

протестировано с zsh 5.0.5 (x86_64-apple-darwin14.0) на Apple MacBook Pro (конец 2011 г.) под управлением OS X 10.10.3

кредит

Как загрузить весь веб-сайт для чтения в автономном режиме

Распространите любовь

В сегодняшнюю цифровую эпоху Интернет стал незаменимым инструментом для доступа к информации. Однако бывают обстоятельства, когда нам необходимо получить доступ к веб-сайту без подключения к Интернету. Это может быть связано с ограниченным подключением или его отсутствием, поездками в отдаленные места или районы, где интернет дорогой или недоступен, или просто необходимостью хранить весь веб-сайт для последующего использования. Здесь может пригодиться загрузка всего веб-сайта для чтения в автономном режиме. В этой статье мы обсудим, как загрузить весь веб-сайт для чтения в автономном режиме.

Шаг 1: Выберите правильный инструмент

В Интернете доступно несколько инструментов, позволяющих загрузить весь веб-сайт. Однако выбор правильного инструмента зависит от типа веб-сайта, который вы пытаетесь загрузить. Если вы пытаетесь сохранить простой веб-сайт без многих динамических функций, таких как CSS, JavaScript или мультимедиа HTML5, вы можете использовать расширение для браузера, например HTTrack или WebCopy. Эти инструменты совместимы с популярными веб-браузерами, такими как Chrome или Firefox, и используют аналогичный интерфейс для сохранения и просмотра загруженного веб-сайта.

Однако выбор правильного инструмента зависит от типа веб-сайта, который вы пытаетесь загрузить. Если вы пытаетесь сохранить простой веб-сайт без многих динамических функций, таких как CSS, JavaScript или мультимедиа HTML5, вы можете использовать расширение для браузера, например HTTrack или WebCopy. Эти инструменты совместимы с популярными веб-браузерами, такими как Chrome или Firefox, и используют аналогичный интерфейс для сохранения и просмотра загруженного веб-сайта.

Если вы хотите сохранить сложный веб-сайт с динамическим содержимым или мультимедиа, вы можете использовать такие инструменты, как wget, SiteSucker или Cyotek WebCopy. Эти инструменты позволяют загружать все файлы и содержимое веб-сайта, включая динамические сценарии, мультимедиа и файлы CSS.

Шаг 2. Определите объем загрузки

После того, как вы выбрали подходящий инструмент для своего веб-сайта, следующим шагом будет определение объема загрузки. Вам нужно решить, хотите ли вы загрузить весь веб-сайт, включая все страницы и подстраницы, или только определенное подмножество страниц.

Чтобы загрузить весь веб-сайт, вы можете использовать URL-адрес веб-сайта в качестве отправной точки и позволить инструменту просмотреть все страницы и подстраницы. Кроме того, вы можете указать URL-адрес определенных страниц, которые хотите загрузить, если вам нужны только определенные страницы.

Шаг 3: Настройка инструмента

После того, как вы определили объем загрузки, вы можете настроить инструмент. Для HTTrack или WebCopy вам необходимо установить расширение для браузера, запустить инструмент и следовать инструкциям на экране, чтобы сохранить веб-сайт.

Для более сложных инструментов, таких как wget, необходимо настроить командную строку в соответствии с объемом загрузки. Вам необходимо указать URL-адрес веб-сайта, каталог для сохранения и параметры, которые вы хотите применить к загрузке.

Шаг 4. Отслеживание процесса загрузки

После настройки инструмента можно начинать процесс загрузки. В зависимости от размера веб-сайта и скорости вашего интернет-соединения процесс загрузки может занять несколько часов или дней.

zip">

zip"> SOME_WEBSITE.com

SOME_WEBSITE.com

Ваш комментарий будет первым