CPU и GPU: в чем разница?

Строение любого сервера во многом похоже на системный компьютерный блок. Внутри корпуса помещена материнская плата, на которой установлены комплектующие. Основную функцию выполняет CPU — центральный процессор, который отвечает за обработку всех данных. Но в последнее время востребованы сервера с GPU — графическим процессором, который способен не только одновременно работать с большим массивом данных, но и обрабатывать графические материалы. И здесь назревает вопрос: а с каким процессором нужно выбрать сервер для тех или иных задач? Для ответа нужно разобрать в чем их разница.

Для начала нужно отметить, что компьютерные процессоры (ЦП и видеокарта) отличаются от серверных архитектурой. Так как к CPU, установленных на серверах, выдвигают особые требования в надежности, безотказности и наличии самокорректирующейся системы. Небольшое изменение в архитектуре, заточенное под работу 24/7 и высокую нагрузку, является единственным отличием серверного процессора от компьютерного.

Графические процессоры в серверах тоже имеют несколько иную архитектуру, заточенную под задачи обработки больших массивов данных в режиме non stop. Видеокарты в системных блоках и в серверах внешне могут быть похожи, но они отличаются технически. У Nvidia для серверного оборудования есть специальные линейки GPU с названием TESLA и QUADRO. Видеокарты из серии QUADRO имеют архитектуру, ориентированную под машинное обучение и видеоаналитику, без ограничений по числу входных видеопотоков (у игровой серии Geforce максимум 3 потока). А GPU в линейке TESLA поддерживает виртуализацию, что позволяет выполнять еще более сложные задачи. А у AMD есть особое решение для серверов под названием FirePro или Radeon & Vega.

Для работы приложений с математическим модулем видеокарты на серверах используются две технологии — CUDA и OpenCL.

Зачем в серверах используют GPU

А теперь перейдем к непосредственной разнице возможностей CPU и GPU в серверах. Еще несколько лет назад в СХД использовались только CPU, которые отвечали за обработку всех данных, включая графику и видео. Любой центральный процессор способен обрабатывать графические материалы, но только когда речь идет о простых задачах. Например, вывести изображение на экран или предоставить к графике удаленный доступ. По такому принципу работали первые компьютеры, на которых можно было играть в 2D-игры, но в них не было дискретных видеокарт.

Сейчас же стала востребованной обработка графической информации, что невозможно именно без GPU — графического процессора. Только благодаря видеокарте в сервере можно работать со сложными массивами данных, касающихся графики. Например, удаленно работать с программами по обработке фото (тот же Photoshop), предоставить облачный доступ к геймингу, управлять видео с системы видеонаблюдения (например, использовать систему распознавания лиц или автомобильных номеров).

Разница в CPU и GPU в серверном оборудовании

С технической стороны разница между CPU и GPU заключается в принципах потоковой обработки информации. Ядра CPU выполняют задачи последовательно.

Если появляются приоритетные задачи высокой важности, то они обрабатываются тоже в порядке общей очереди. Если на каком-то этапе происходит сбой, то возникает ошибка и весь процесс сбивается. За счет нескольких ядер достигается многозадачность, но по-прежнему все данные обрабатываются в едином потоке на каждом ядре отдельно.

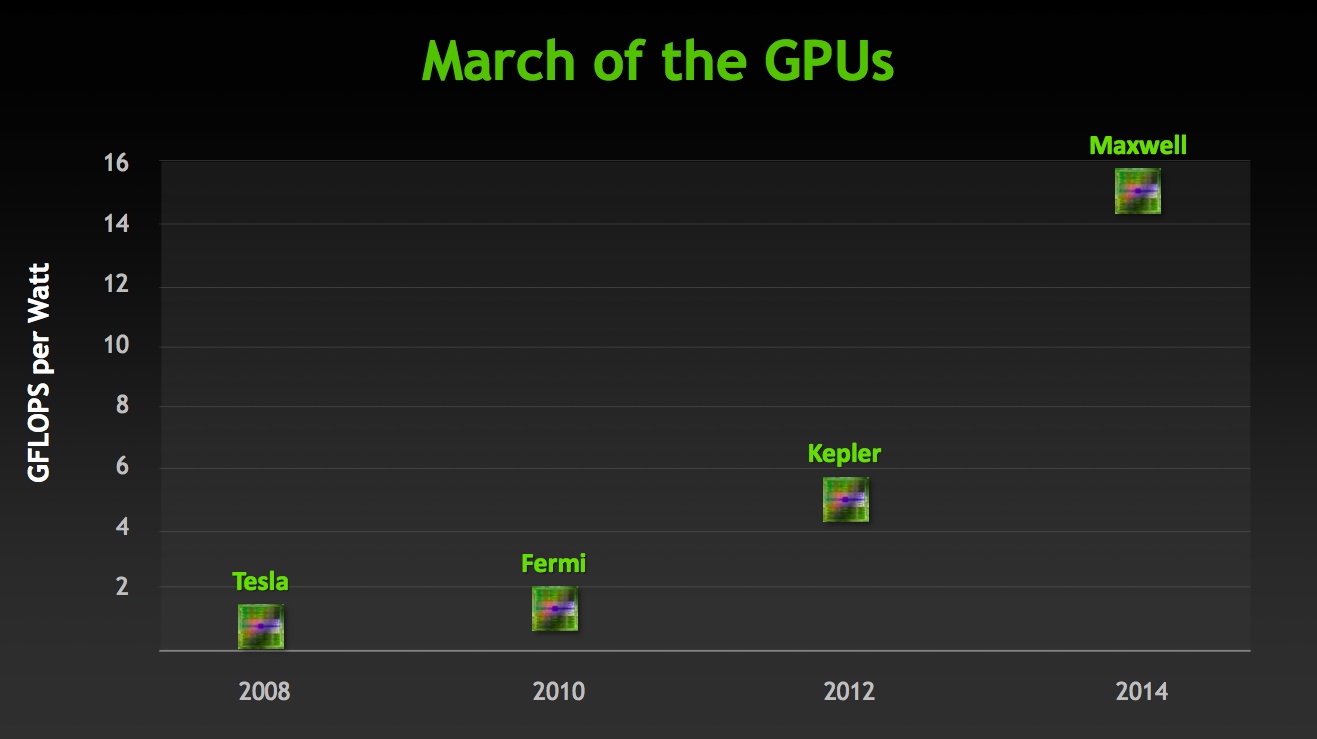

Архитектура GPU построена несколько иначе. Там все задачи выполняются параллельно. За счет этого достигается высокая многозадачность и устойчивость. Именно поэтому для майнинга криптовалюты при очень больших объемах обрабатываемых данных используются GPU, а не CPU. Видеокарты поэтому и называют еще графическим ускорителем.

Видеокарты поэтому и называют еще графическим ускорителем.

А еще разница заключается в доступе к памяти каждого из видов процессоров. GPU попросту не нужно много кэша, чтобы обрабатывать массивы данных. Даже при работе с графикой достаточно пары сотен килобайт кэша. В современных графических процессорах используется 2048 и более исполнительных блоков, а у центральных процессоров — от 2 до 48.

Заключение

Исходя из особенностей GPU, их стали использовать на многих серверах, которые задействуются в обработке больших массивов данных и работе с графикой/видео. Многие компании выбирают именно такие сервера с GPU при работе с Big Data и Artificial Intelligence, 3D-моделированием и криптографией. Но даже современные системы видеонаблюдения с системой анализа и корпоративные облачные сети трудно представить без серверов с GPU.

Осталось только определить, для каких целей вам нужен сервер, и действительно ли нельзя обойтись только CPU? В этом вам помогут специалисты ittelo, которые не только подберут оптимальную конфигурацию, но и проведут развернутую консультацию по выбору серверного оборудования под конкретные цели.

Как и зачем производить дедупликацию данных на предприятии

29 Ноября 2019

Читать О жидкостном охлаждении16 Октября 2018

ЧитатьНесколько причин пересмотреть свой план на случай ЧС в серверной

16 Декабря 2018

ЧитатьПроцессор Intel® Pentium® G630 (3 МБ кэш-памяти, тактовая частота 2,70 ГГц) Спецификации продукции

Дата выпуска

Дата выпуска продукта.

Ожидается задержка

Ожидается снятие с производства — это оценка времени, когда для продукции начнется процесс снятия с производства. Уведомление о снятии продукции с производства (PDN), опубликованное в начале процесса, будет включать в себя все сведения об основных этапах снятия с производства. Некоторые подразделения могут сообщать сведения о сроках снятия с производства до публикации PDN. Обратитесь к представителю Intel для получения информации о сроках снятия с производства и вариантах продления сроков.

Некоторые подразделения могут сообщать сведения о сроках снятия с производства до публикации PDN. Обратитесь к представителю Intel для получения информации о сроках снятия с производства и вариантах продления сроков.

Литография

Литография указывает на полупроводниковую технологию, используемую для производства интегрированных наборов микросхем и отчет показывается в нанометре (нм), что указывает на размер функций, встроенных в полупроводник.

Количество ядер

Количество ядер — это термин аппаратного обеспечения, описывающий число независимых центральных модулей обработки в одном вычислительном компоненте (кристалл).

Количество потоков

Поток или поток выполнения — это термин программного обеспечения, обозначающий базовую упорядоченную последовательность инструкций, которые могут быть переданы или обработаны одним ядром ЦП.

Базовая тактовая частота процессора

Базовая частота процессора — это скорость открытия/закрытия транзисторов процессора. Базовая частота процессора является рабочей точкой, где задается расчетная мощность (TDP). Частота измеряется в гигагерцах (ГГц) или миллиардах вычислительных циклов в секунду.

Кэш-память

Кэш-память процессора — это область быстродействующей памяти, расположенная в процессоре. Интеллектуальная кэш-память Intel® Smart Cache указывает на архитектуру, которая позволяет всем ядрам совместно динамически использовать доступ к кэшу последнего уровня.

Частота системной шины

Шина — это подсистема, передающая данные между компонентами компьютера или между компьютерами. В качестве примера можно назвать системную шину (FSB), по которой происходит обмен данными между процессором и блоком контроллеров памяти; интерфейс DMI, который представляет собой соединение «точка-точка» между встроенным контроллером памяти Intel и блоком контроллеров ввода/вывода Intel на системной плате; и интерфейс Quick Path Interconnect (QPI), соединяющий процессор и интегрированный контроллер памяти.

В качестве примера можно назвать системную шину (FSB), по которой происходит обмен данными между процессором и блоком контроллеров памяти; интерфейс DMI, который представляет собой соединение «точка-точка» между встроенным контроллером памяти Intel и блоком контроллеров ввода/вывода Intel на системной плате; и интерфейс Quick Path Interconnect (QPI), соединяющий процессор и интегрированный контроллер памяти.

Расчетная мощность

Расчетная тепловая мощность (TDP) указывает на среднее значение производительности в ваттах, когда мощность процессора рассеивается (при работе с базовой частотой, когда все ядра задействованы) в условиях сложной нагрузки, определенной Intel. Ознакомьтесь с требованиями к системам терморегуляции, представленными в техническом описании.Доступные варианты для встраиваемых систем

Доступные варианты для встраиваемых систем указывают на продукты, обеспечивающие продленную возможность приобретения для интеллектуальных систем и встроенных решений. Спецификация продукции и условия использования представлены в отчете Production Release Qualification (PRQ). Обратитесь к представителю Intel для получения подробной информации.

Спецификация продукции и условия использования представлены в отчете Production Release Qualification (PRQ). Обратитесь к представителю Intel для получения подробной информации.

Поиск продукции с Доступные варианты для встраиваемых систем

Макс. объем памяти (зависит от типа памяти)

Макс. объем памяти означает максимальный объем памяти, поддерживаемый процессором.

Типы памяти

Процессоры Intel® поддерживают четыре разных типа памяти: одноканальная, двухканальная, трехканальная и Flex.

Макс.

число каналов памяти

число каналов памятиОт количества каналов памяти зависит пропускная способность приложений.

Макс. пропускная способность памяти

Макс. пропускная способность памяти означает максимальную скорость, с которой данные могут быть считаны из памяти или сохранены в памяти процессором (в ГБ/с).

Встроенная в процессор графическая система

‡Графическая система процессора представляет собой интегрированную в процессор схему обработки графических данных, которая формирует работу функций видеосистемы, вычислительных процессов, мультимедиа и отображения информации. Системы HD-графики Intel®, Iris™ Graphics, Iris Plus Graphics и Iris Pro Graphics обеспечивают расширенное преобразование медиа-данных, высокие частоты кадров и возможность демонстрации видео в формате 4K Ultra HD (UHD). Для получения дополнительной информации см. страницу Технология Intel® Graphics.

Для получения дополнительной информации см. страницу Технология Intel® Graphics.

Базовая частота графической системы

Базовая частота графической системы — это номинальная/гарантированная тактовая частота рендеринга графики (МГц).

Макс. динамическая частота графической системы

Макс. динамическая частота графической системы — это максимальная условная частота рендеринга (МГц), поддерживаемая HD-графикой Intel® с функцией Dynamic Frequency.

Intel® Quick Sync Video

Технология Intel® Quick Sync Video обеспечивает быструю конвертацию видео для портативных медиапроигрывателей, размещения в сети, а также редактирования и создания видео.

Поиск продукции с Intel® Quick Sync Video

Технология InTru 3D

Технология Intel InTru 3D позволяет воспроизводить трехмерные стереоскопические видеоматериалы в формате Blu-ray* с разрешением 1080p, используя интерфейс HDMI* 1.4 и высококачественный звук.

Интерфейс Intel® Flexible Display (Intel® FDI)

Intel® Flexible Display — это инновационный интерфейс, позволяющий выводить независимые изображения на два канала с помощью интегрированной графической системы.

Технология Intel® Clear Video HD

Технология Intel® Clear Video HD, как и предшествующая ее появлению технология Intel® Clear Video, представляет собой набор технологий кодирования и обработки видео, встроенный в интегрированную графическую систему процессора. Эти технологии делают воспроизведение видео более стабильным, а графику — более четкой, яркой и реалистичной. Технология Intel® Clear Video HD обеспечивает более яркие цвета и более реалистичное отображение кожи благодаря улучшениям качества видео.

Эти технологии делают воспроизведение видео более стабильным, а графику — более четкой, яркой и реалистичной. Технология Intel® Clear Video HD обеспечивает более яркие цвета и более реалистичное отображение кожи благодаря улучшениям качества видео.

Редакция PCI Express

Редакция PCI Express — это версия, поддерживаемая процессором. PCIe (Peripheral Component Interconnect Express) представляет собой стандарт высокоскоростной последовательной шины расширения для компьютеров для подключения к нему аппаратных устройств. Различные версии PCI Express поддерживают различные скорости передачи данных.

Поддерживаемые разъемы

Разъемом называется компонент, которые обеспечивает механические и электрические соединения между процессором и материнской платой.

T

CASEКритическая температура — это максимальная температура, допустимая в интегрированном теплораспределителе (IHS) процессора.

Поддержка памяти Intel® Optane™

‡Память Intel® Optane™ представляет собой новый революционный класс энергонезависимой памяти, работающей между системной памятью и устройствами хранения данных для повышения системной производительности и оперативности. В сочетании с драйвером технологии хранения Intel® Rapid она эффективно управляет несколькими уровнями систем хранения данных, предоставляя один виртуальный диск для нужд ОС, обеспечивая тем самым хранение наиболее часто используемой информации на самом быстродействующем уровне хранения данных. Для работы памяти Intel® Optane™ необходимы специальная аппаратная и программная конфигурации. Чтобы узнать о требованиях к конфигурации, посетите сайт https://www.intel.com/content/www/ru/ru/architecture-and-technology/optane-memory.html.

Для работы памяти Intel® Optane™ необходимы специальная аппаратная и программная конфигурации. Чтобы узнать о требованиях к конфигурации, посетите сайт https://www.intel.com/content/www/ru/ru/architecture-and-technology/optane-memory.html.

Технология Intel® Turbo Boost

‡Технология Intel® Turbo Boost динамически увеличивает частоту процессора до необходимого уровня, используя разницу между номинальным и максимальным значениями параметров температуры и энергопотребления, что позволяет увеличить эффективность энергопотребления или при необходимости «разогнать» процессор.

Технология Intel® Hyper-Threading

‡Intel® Hyper-Threading Technology (Intel® HT Technology) обеспечивает два потока обработки для каждого физического ядра. Многопоточные приложения могут выполнять больше задач параллельно, что значительно ускоряет выполнение работы.

Многопоточные приложения могут выполнять больше задач параллельно, что значительно ускоряет выполнение работы.

Поиск продукции с Технология Intel® Hyper-Threading ‡

Технология виртуализации Intel® (VT-x)

‡Технология Intel® Virtualization для направленного ввода/вывода (VT-x) позволяет одной аппаратной платформе функционировать в качестве нескольких «виртуальных» платформ. Технология улучшает возможности управления, снижая время простоев и поддерживая продуктивность работы за счет выделения отдельных разделов для вычислительных операций.

Поиск продукции с Технология виртуализации Intel® (VT-x) ‡

Технология виртуализации Intel® для направленного ввода/вывода (VT-d)

‡Технология Intel® Virtualization Technology для направленного ввода/вывода дополняет поддержку виртуализации в процессорах на базе архитектуры IA-32 (VT-x) и в процессорах Itanium® (VT-i) функциями виртуализации устройств ввода/вывода. Технология Intel® Virtualization для направленного ввода/вывода помогает пользователям увеличить безопасность и надежность систем, а также повысить производительность устройств ввода/вывода в виртуальных средах.

Технология Intel® Virtualization для направленного ввода/вывода помогает пользователям увеличить безопасность и надежность систем, а также повысить производительность устройств ввода/вывода в виртуальных средах.

Поиск продукции с Технология виртуализации Intel® для направленного ввода/вывода (VT-d) ‡

Intel® VT-x с таблицами Extended Page Tables (EPT)

‡Intel® VT-x с технологией Extended Page Tables, известной также как технология Second Level Address Translation (SLAT), обеспечивает ускорение работы виртуализованных приложений с интенсивным использованием памяти. Технология Extended Page Tables на платформах с поддержкой технологии виртуализации Intel® сокращает непроизводительные затраты памяти и энергопотребления и увеличивает время автономной работы благодаря аппаратной оптимизации управления таблицей переадресации страниц.

Архитектура Intel® 64

‡Архитектура Intel® 64 в сочетании с соответствующим программным обеспечением поддерживает работу 64-разрядных приложений на серверах, рабочих станциях, настольных ПК и ноутбуках.¹ Архитектура Intel® 64 обеспечивает повышение производительности, за счет чего вычислительные системы могут использовать более 4 ГБ виртуальной и физической памяти.

Поиск продукции с Архитектура Intel® 64 ‡

Набор команд

Набор команд содержит базовые команды и инструкции, которые микропроцессор понимает и может выполнять. Показанное значение указывает, с каким набором команд Intel совместим данный процессор.

Расширения набора команд

Расширения набора команд — это дополнительные инструкции, с помощью которых можно повысить производительность при выполнении операций с несколькими объектами данных. К ним относятся SSE (Поддержка расширений SIMD) и AVX (Векторные расширения).

Состояния простоя

Режим состояния простоя (или C-состояния) используется для энергосбережения, когда процессор бездействует. C0 означает рабочее состояние, то есть ЦПУ в данный момент выполняет полезную работу. C1 — это первое состояние бездействия, С2 — второе состояние бездействия и т.д. Чем выше численный показатель С-состояния, тем больше действий по энергосбережению выполняет программа.

Enhanced Intel SpeedStep® Technology (Усовершенствованная технология Intel SpeedStep®)

Усовершенствованная технология Intel SpeedStep® позволяет обеспечить высокую производительность, а также соответствие требованиям мобильных систем к энергосбережению. Стандартная технология Intel SpeedStep® позволяет переключать уровень напряжения и частоты в зависимости от нагрузки на процессор. Усовершенствованная технология Intel SpeedStep® построена на той же архитектуре и использует такие стратегии разработки, как разделение изменений напряжения и частоты, а также распределение и восстановление тактового сигнала.

Стандартная технология Intel SpeedStep® позволяет переключать уровень напряжения и частоты в зависимости от нагрузки на процессор. Усовершенствованная технология Intel SpeedStep® построена на той же архитектуре и использует такие стратегии разработки, как разделение изменений напряжения и частоты, а также распределение и восстановление тактового сигнала.

Технологии термоконтроля

Технологии термоконтроля защищают корпус процессора и систему от сбоя в результате перегрева с помощью нескольких функций управления температурным режимом. Внутрикристаллический цифровой термодатчик температуры (Digital Thermal Sensor — DTS) определяет температуру ядра, а функции управления температурным режимом при необходимости снижают энергопотребление корпусом процессора, тем самым уменьшая температуру, для обеспечения работы в пределах нормальных эксплуатационных характеристик.

Технология Intel® Fast Memory Access

Технология Intel® Fast Memory Access представляет собой усовершенствованную магистральную архитектуру блока контроллеров видеопамяти (GMCH), повышающую производительность системы благодаря оптимизации использования доступной пропускной способности и сокращению времени задержки при доступе к памяти.

Технология Intel® Flex Memory Access

Intel® Flex Memory Access обеспечивает простоту модернизации благодаря поддержке модулей памяти различного объёма, работающих в двухканальном режиме.

Новые команды Intel® AES

Команды Intel® AES-NI (Intel® AES New Instructions) представляют собой набор команд, позволяющий быстро и безопасно обеспечить шифрование и расшифровку данных. Команды AES-NI могут применяться для решения широкого спектра криптографических задач, например, в приложениях, обеспечивающих групповое шифрование, расшифровку, аутентификацию, генерацию случайных чисел и аутентифицированное шифрование.

Команды AES-NI могут применяться для решения широкого спектра криптографических задач, например, в приложениях, обеспечивающих групповое шифрование, расшифровку, аутентификацию, генерацию случайных чисел и аутентифицированное шифрование.

Поиск продукции с Новые команды Intel® AES

Технология Intel® Trusted Execution

‡Технология Intel® Trusted Execution расширяет возможности безопасного исполнения команд посредством аппаратного расширения возможностей процессоров и наборов микросхем Intel®. Эта технология обеспечивает для платформ цифрового офиса такие функции защиты, как измеряемый запуск приложений и защищенное выполнение команд. Это достигается за счет создания среды, где приложения выполняются изолированно от других приложений системы.

Поиск продукции с Технология Intel® Trusted Execution ‡

Функция Бит отмены выполнения

‡Бит отмены выполнения — это аппаратная функция безопасности, которая позволяет уменьшить уязвимость к вирусам и вредоносному коду, а также предотвратить выполнение вредоносного ПО и его распространение на сервере или в сети.

Слияние NVIDIA и ARM изменит расстановку сил на мировом рынке процессоров

РынокТренды

Наталья Соловьева | 20.09.2020Компания-разработчик графических процессоров NVIDIA заключила с японской холдинговой компанией SoftBank соглашение о приобретении компании ARM. Эксперты назвали данное приобретение вестником грядущего перераспределения рынка – сделка позволит нишевому поставщику графических процессоров взять под контроль самую распространенную в мире электронную технологию, поставки которой намного превышают совокупный объем процессоров, поставляемых лидерами рынка AMD и Intel.

Компания-разработчик графических процессоров NVIDIA заключила с японской холдинговой компанией SoftBank соглашение о приобретении одного из ведущих в мире поставщиков полупроводниковых компонентов разработчика чипов для мобильных устройств компанию ARM. Эксперты назвали данное приобретение самым смелым шагом в истории NVIDIA и грядущим перераспределением рынка – сделка, которой предстоит еще получить окончательное одобрение регулирующих органов ряда стран, позволит нишевому поставщику графических процессоров взять под контроль самую распространенную в мире электронную технологию, поставки которой намного превышают совокупный объем процессоров, поставляемых лидерами рынка AMD и Intel.

Сумма, которую SoftBank получит от NVIDIA за компанию ARM, составит $40 млрд. Из них $21,5 млрд будут представлены акциями, $12 млрд — денежными средствами. Еще порядка $5 млрд в виде акций NVIDIA

либо деньгами SoftBank получит в том случае, если прибыль ARM достигнет определенных показателей, и $1,5 млрд в виде акций NVIDIA получат от сотрудники самой компании ARM. В результате сделки

холдингу SoftBank и его инвестиционному фонду Vision Fund будет принадлежать 6,7-8,1% акций NVIDIA.

В результате сделки

холдингу SoftBank и его инвестиционному фонду Vision Fund будет принадлежать 6,7-8,1% акций NVIDIA.

ARM: 180 млрд чипов и уникальная бизнес-модель

Архитектура ARM повсеместно распространена во всем мире. Чипы и компоненты ARM присутствуют практически в каждом электронном устройстве всех основных категорий коммуникационного и сетевого оборудования, от заводского оборудования до домашней электроники, от смартфонов до большинства умных часов, в телевизионных приставках и большинстве устройств Интернета вещей (IoT). Исключение составляют персональные компьютеры и облачные/data-центры. К настоящему моменту на рынок было поставлено более 180 млрд чипов, использующих технологии компании ARM.

Бизнес-модель ARM связана с проектированием микросхем и выпуском лицензий на интеллектуальную собственность для сети партнеров. Партнеры компании, в числе которых — ведущие поставщики

полупроводниковых компонентов, используют интеллектуальную собственность ARM для создания и производства систем на основе конструкции микрочипов. ARM получает лицензионный сбор за оригинальную ИС и

роялти за каждый чип или произведенную кристаллическую пластину.

ARM получает лицензионный сбор за оригинальную ИС и

роялти за каждый чип или произведенную кристаллическую пластину.

Планы на будущее

ARM будет преобразована в подразделение NVIDIA, и самой главной задачей, которую предстоит решить после окончательного утверждения покупки, станет интеграция технологий NVIDIA в обширную сеть ARM. Такое заявление в своем интервью журналу Forbes заявил главный исполнительный директор NVIDIA Дженсен Хуанг (Jensen Huang). При этом головной офис ARM, расположенный в Великобритании, ее бизнес-модель, связанная с проектированием и открытым лицензированием микросхем, как и сложившиеся отношения с обширнейшей сетью партнеров и клиентов по всему миру, будут сохранены.

«Мы объединим ведущие вычисления NVIDIA в сфере искусственного интеллекта с обширной экосистемой ARM, которая не похожа ни на одну компанию в истории технологий, — комментирует Дженсен Хуанг. —

Приобретение ARM подпитывается стремлением привнести ИИ во все, что имеет выключатель. Преуспев в продаже графических чипов NVIDIA владельцам центров обработки данных для ускорения распознавания

изображений и обработки языка, мы хотим убедиться, что технология ARM поможет распространить это на все, от автомобилей-беспилотников до интеллектуальных счетчиков».

Преуспев в продаже графических чипов NVIDIA владельцам центров обработки данных для ускорения распознавания

изображений и обработки языка, мы хотим убедиться, что технология ARM поможет распространить это на все, от автомобилей-беспилотников до интеллектуальных счетчиков».

Кроме того, после покупки ARM компания NVIDIA может заняться созданием собственной серверной платформы на архитектуре ARM. В приоритете, по заявлению Дженсена Хуанга- инвестиции в усилия ARM по разработке чипов для вычислений в центрах обработки данных (ЦОДах), что позволит отвоевать у Intel, доминирующей в данном сегменте с долей около 90%, часть прибыльного рынка. Сегодня руководство компании рассматривает три возможных варианта: лицензирование CPU под собственной маркой, выпуск референсных продуктов и разработку кастомных решений на базе готовых ядер.

«Мы знаем, что центры хранения и обработки данных, а также облака остро нуждаются в микропроцессорах ARM. Энергоэффективность напрямую влияет на вычислительные мощности, объемы вычислений и

стоимость предоставления этих услуг», — продолжил он.

Напряженность между КНР и США и недовольство конкурентов

Окончательное завершение сделки ожидается до конца марта 2022 г. — регулирующим органам Великобритании, Китая, Евросоюза и США предстоит провести проверку на предмет нарушения антимонопольного законодательства. Получение одобрения от регуляторов КНР может стать особенно трудным, учитывая растущую напряженность в отношениях с США.

«ARM станет американской фирмой, и конфликт вокруг полупроводников между США и Китаем станет ожесточенным, поскольку Китай все еще контролирует ARM China», — считает Кодзи Хираи (Kazuo Hirai), глава консалтинговой фирмы M&A Kachitas в Токио.

Cделка неизбежно вызовет недовольство со стороны конкурентов NVIDIA – компаний Samsung, Apple, Qualcomm, Broadcom, Intel и Huawei, использующих архитектуру ARM в своих продуктах, полагают аналитики — от них посыпятся претензии.

Сделка по слиянию NVIDIA и ARM подверглась жесткой критике со стороны Херманна Хаузера (Hermann Hauser), одного из основателей ARM. В своем интервью агентству Reuters он называет ее катастрофой для

Кембриджа, Британии и Европы.

В своем интервью агентству Reuters он называет ее катастрофой для

Кембриджа, Британии и Европы.

«Это последняя европейская технологическая компания, имеющая мировое значение, и ее продают американцам», — цитируют слова Хаузера СМИ.

Продажа ARM в одночасье разрушит ее уникальную бизнес-модель, также, как это уже было со швейцарской полупроводниковой отраслью, считает он, и призывает Правительство Великобритании выдвинуть к проводимой сделке ряд дополнительных требований. В их числе — гарантия сохранности рабочих мест в Британии и открытой бизнес-модели ARM, а также исключение отношений с клиентами из проверок безопасности в США.

Самый смелый шаг за всю историю NVIDIA

Softbank купил ARM в 2016 г., вложив в сделку $31,4 млрд – она также стала крупнейшей сделкой в полупроводниковой отрасли. Холдинг намеревался развивать технологии Интернета вещей (IoT), и к 2035

г., по его планам, собирался довести число интеллектуальных устройств, подключенных к Интернету, до 1 трлн. Однако нереалистичный оптимизм в отношении развитии технологии IoT, как и ряд просчетов в

инвестиционной стратегии, говорят эксперты, вынудила Softbank продать компанию ARM.

Однако нереалистичный оптимизм в отношении развитии технологии IoT, как и ряд просчетов в

инвестиционной стратегии, говорят эксперты, вынудила Softbank продать компанию ARM.

NVIDIA была самым заинтересованным в таком приобретении рыночным игроком. Компания только недавно завершила сделку по покупке израильского производителя чипов Mellanox Technologies, вложив в нее $6,9 млрд. Очередное приобретение — поглощение компании ARM – эксперты уже окрестили самым смелым шагом в истории NVIDIA.

На новостях о сделке акции SoftBank выросли примерно на 9%, акции NVIDIA — на 5%.

Nvidia Процессоры Слияния и поглощения

Журнал: Журнал IT-News, Журнал IT-Expert [№ 09/2020], Подписка на журналы

AMD и NVIDIA решают проблему нехватки графических процессоров

Введение

Мы стремимся уважать информацию личного характера, касающуюся посетителей нашего сайта. В настоящей Политике конфиденциальности разъясняются некоторые из мер, которые мы предпринимаем для защиты Вашей частной жизни.

Конфиденциальность информации личного характера

«Информация личного характера» обозначает любую информацию, которая может быть использована для идентификации личности, например, фамилия или адрес электронной почты.

Использование информации частного характера.

Информация личного характера, полученная через наш сайт, используется нами, среди прочего, для целей регистрирования пользователей, для поддержки работы и совершенствования нашего сайта, отслеживания политики и статистики пользования сайтом, а также в целях, разрешенных вами.

Раскрытие информации частного характера.

Мы нанимаем другие компании или связаны с компаниями, которые по нашему поручению предоставляют услуги, такие как обработка и доставка информации, размещение информации на данном сайте, доставка содержания и услуг, предоставляемых настоящим сайтом, выполнение статистического анализа. Чтобы эти компании могли предоставлять эти услуги, мы можем сообщать им информацию личного характера, однако им будет разрешено получать только ту информацию личного характера, которая необходима им для предоставления услуг. Они обязаны соблюдать конфиденциальность этой информации, и им запрещено использовать ее в иных целях.

Они обязаны соблюдать конфиденциальность этой информации, и им запрещено использовать ее в иных целях.

Мы можем использовать или раскрывать Ваши личные данные и по иным причинам, в том числе, если мы считаем, что это необходимо в целях выполнения требований закона или решений суда, для защиты наших прав или собственности, защиты личной безопасности пользователей нашего сайта или представителей широкой общественности, в целях расследования или принятия мер в отношении незаконной или предполагаемой незаконной деятельности, в связи с корпоративными сделками, такими как разукрупнение, слияние, консолидация, продажа активов или в маловероятном случае банкротства, или в иных целях в соответствии с Вашим согласием.

Мы не будем продавать, предоставлять на правах аренды или лизинга наши списки пользователей с адресами электронной почты третьим сторонам.

Доступ к информации личного характера.

Если после предоставления информации на данный сайт, Вы решите, что Вы не хотите, чтобы Ваша персональная информация использовалась в каких-либо целях, связавшись с нами по следующему адресу: info@oakbarrel. ru.ru.

ru.ru.

Наша практика в отношении информации неличного характера.

Мы можем собирать информацию неличного характера о Вашем посещении сайта, в том числе просматриваемые вами страницы, выбираемые вами ссылки, а также другие действия в связи с Вашим использованием нашего сайта. Кроме того, мы можем собирать определенную стандартную информацию, которую Ваш браузер направляет на любой посещаемый вами сайт, такую как Ваш IP-адрес, тип браузера и язык, время, проведенное на сайте, и адрес соответствующего веб-сайта.

Использование закладок (cookies).

Файл cookie — это небольшой текстовый файл, размещаемый на Вашем твердом диске нашим сервером. Cookies содержат информацию, которая позже может быть нами прочитана. Никакие данные, собранные нами таким путем, не могут быть использованы для идентификации посетителя сайта. Не могут cookies использоваться и для запуска программ или для заражения Вашего компьютера вирусами. Мы используем cookies в целях контроля использования нашего сайта, сбора информации неличного характера о наших пользователях, сохранения Ваших предпочтений и другой информации на Вашем компьютере с тем, чтобы сэкономить Ваше время за счет снятия необходимости многократно вводить одну и ту же информацию, а также в целях отображения Вашего персонализированного содержания в ходе Ваших последующих посещений нашего сайта. Эта информация также используется для статистических исследований, направленных на корректировку содержания в соответствии с предпочтениями пользователей.

Эта информация также используется для статистических исследований, направленных на корректировку содержания в соответствии с предпочтениями пользователей.

Агрегированная информация.

Мы можем объединять в неидентифицируемом формате предоставляемую вами личную информацию и личную информацию, предоставляемую другими пользователями, создавая таким образом агрегированные данные. Мы планируем анализировать данные агрегированного характера в основном в целях отслеживания групповых тенденций. Мы не увязываем агрегированные данные о пользователях с информацией личного характера, поэтому агрегированные данные не могут использоваться для установления связи с вами или Вашей идентификации. Вместо фактических имен в процессе создания агрегированных данных и анализа мы будем использовать имена пользователей. В статистических целях и в целях отслеживания групповых тенденций анонимные агрегированные данные могут предоставляться другим компаниям, с которыми мы взаимодействуем.

Изменения, вносимые в настоящее Заявление о конфиденциальности.

Мы сохраняeм за собой право время от времени вносить изменения или дополнения в настоящую Политику конфиденциальности — частично или полностью. Мы призываем Вас периодически перечитывать нашу Политику конфиденциальности с тем, чтобы быть информированными относительно того, как мы защищаем Вашу личную информацию. С последним вариантом Политики конфиденциальности можно ознакомиться путем нажатия на гипертекстовую ссылку «Политика конфиденциальности», находящуюся в нижней части домашней страницы данного сайта. Во многих случаях, при внесении изменений в Политику конфиденциальности, мы также изменяем и дату, проставленную в начале текста Политики конфиденциальности, однако других уведомлений об изменениях мы можем вам не направлять. Однако, если речь идет о существенных изменениях, мы уведомим Вас, либо разместив предварительное заметное объявление о таких изменениях, либо непосредственно направив вам уведомление по электронной почте. Продолжение использования вами данного сайта и выход на него означает Ваше согласие с такими изменениями.

Связь с нами. Если у Вас возникли какие-либо вопросы или предложения по поводу нашего положения о конфиденциальности, пожалуйста, свяжитесь с нами по следующему адресу: [email protected].

ЗакрытьОбзор Gigabyte GeForce GTX 1660

Что такое Gigabyte GTX 1660?Gigabyte GTX 1660 – это новая видеокарта Nvidia среднего класса. В то время как высокопроизводительные графические процессоры теперь преодолели цену в 1000 фунтов стерлингов, GTX 1660 предлагает впечатляющую производительность Full HD всего за 199 фунтов.

Как и его чуть более мощный брат GTX 1660 Ti, GTX 1660 использует новую архитектуру Nvidia TU116 вместо старого дизайна Pascal, используемого для карт GTX 1050 и GTX 1060.

Nvidia разработала эту архитектуру для достижения расчетного баланса между производительностью, мощностью и стоимостью. Примите участие в захватывающих инновациях шейдеров Turing, которые интеллектуально оптимизируют производительность графического процессора, добавьте обещание поддержки трассировки лучей в будущем, и вы получите отличную производительность графики за очень хорошую цену.

У GTX 1660 есть очень важная проблема – более мощный 1660 Ti бросает в центр внимания. С разницей в два с лишним £ 70 цена GTX 1660 находится под большим давлением, чтобы обеспечить сопоставимую производительность, чтобы считаться достойной альтернативой.

Похожие: Лучшие видеокарты 2019

Gigabyte GTX 1660 – Технические характеристики и технологииВ следующей таблице приведены все характеристики GTX 1660 и их сравнение с видеокартами Nvidia GTX 1050 Ti, GTX 1060 6 ГБ, GTX 1660 Ti, GTX 1070 и RTX 2060. Я выбрал эти карты, потому что они являются наиболее сопоставимыми графическими процессорами Nvidia с точки зрения как цены, так и технических характеристик.

| GTX 1660 | GTX 1050 Ti | GTX 1060 6GB | GTX 1660 Ti | RTX 2060 | |

| Архитектура | TU116 | паскаль | паскаль | TU116 | Тьюринг |

| CUDA Cores | 1408 | 768 | 1280 | 1536 | 1920 |

| Базовая тактовая частота | 1530 МГц | 1290 МГц | 1506 МГц | 1500 МГц | 1365 МГц |

| Увеличенная тактовая частота | 1785 МГц | 1392 МГц | 1708 МГц | 1770 МГц | 1680 МГц |

| VRAM | 6 ГБ GDDR5 | 4 ГБ GDDR5 | 6 ГБ GDDR5 | 6 ГБ GDDR6 | 6 ГБ GDDR6 |

| Пропускная способность памяти | 192 Гбит / с | 112 Гбит / с | 192 Гбит / с | 288 Гбит / с | 336 Гбит / с |

| TDP | 120w | 75w | 120w | 120w | 160w |

Хотя GTX 1660 является картой Тьюринга, как и RTX 2060, в ней отсутствуют специальные функции последней, такие как трассировка лучей и DLSS. Это не удивительно, учитывая бюджетную цену здесь. Так чем же отличается новая архитектура TU116 от Pascal?

Это не удивительно, учитывая бюджетную цену здесь. Так чем же отличается новая архитектура TU116 от Pascal?

Во-первых, архитектура TU116 может похвастаться возможностью большей емкости, более настраиваемых кэшей и улучшенной пропускной способности. Но в отличие от GTX 1660, Nvidia не в полной мере использовала потенциал архитектуры здесь, поддерживая большинство характеристик в соответствии с Pascal GTX 1060, чтобы снизить затраты. GTX 1660 и GTX 1060 имеют одинаковую пропускную способность памяти, VRAM и даже тепловую мощность.

Nvidia нашла место для удара в ядрах CUDA, хотя GTX 1660 выставил напоказ в общей сложности 1408 по сравнению с GTX 1060’s 1280. Это увеличение ядер CUDA, по-видимому, также является основным фактором для увеличения тактовых частот с повышением. GTX 1660 достигает пика на разумных 1785 МГц. Для сравнения, GTX 1060 способен только на 1708 МГц.

Давайте будем честными, на бумаге GTX 1660 не кажется значительным обновлением GTX 1060. Правда, однако, большинство преимуществ новой архитектуры TU116 не видны в спецификации. Одним из примеров этого является увеличение в 1,5 раза инструкций за такт. Это означает, что, хотя увеличение тактовой частоты не является массовым, повышение эффективности все же должно привести к значительно более высокой производительности.

Одним из примеров этого является увеличение в 1,5 раза инструкций за такт. Это означает, что, хотя увеличение тактовой частоты не является массовым, повышение эффективности все же должно привести к значительно более высокой производительности.

В архитектуре TU116 также представлено множество интеллектуальных технологий затенения, которые повышают эффективность графической карты за счет снижения рабочей нагрузки графического процессора без ущерба для качества изображения.

Один из этих методов называется Motion Adaptive Shading. Эта функция изменяет скорость затенения в зависимости от уровня движения на дисплее. Подумайте о том, чтобы поиграть в игру, подобную Forza Horizon 4, где вы ускоряете гоночный курс – нет смысла затенять подобные дорожные знаки и дорожную разметку во всех деталях, когда они не более чем размытые невооруженным глазом, когда вы гудите. от. И жертвуя такими ненужными деталями, графический процессор получает взамен вкусное повышение производительности. Это так умно, что почти похоже на обман.

Это так умно, что почти похоже на обман.

Контент-адаптивное затенение является аналогичной техникой, которая также обеспечивает повышение производительности за счет снижения нагрузки на графический процессор. Однако в этот раз повышенная эффективность достигается благодаря алгоритму, который определяет скорость затенения в соответствии с «пространственной и цветовой когерентностью между кадрами». Говоря простым языком, это фактически означает, что если какой-либо объект или часть пейзажа неподвижны и не меняются по внешнему виду в течение длительных периодов времени – например, стены или неба – графический процессор прилагает меньше усилий, затеняя его каждый Рамка. Это значит без потери качества изображения.

Я большой поклонник этих технологий адаптивного затенения, и, хотя они могут быть не такими захватывающими, как функции RTX, они, безусловно, более полезны, чем трассировка лучей для обычного геймера. Однако есть предостережение: не каждая видеоигра использует новую технологию Adaptive Shading с Wolfenstein II: New Colossus как раз и поддерживает технологию.

Как ни странно, это означает, что современные игры с большей вероятностью получат больший прирост производительности, чем выпуски игр, выпущенные несколько лет назад, поскольку первые используют более продвинутые и сложные методы затенения. Nvidia продемонстрировала это на графике: Shadow of the Tomb Raider и Call of Duty Black Ops 4 увидели больший скачок в производительности, чем Fallout 4, по сравнению с видеокартами, использующими архитектуру Pascal.

Последней особой силой, которую архитектура TU116 наделила GTX 1660, является возможность потоковой передачи видеоигр в 4K независимо от того, какой процессор вы используете. GTX 1660 может даже транслировать и транслировать одновременно из одной системы, что станет большим благом для тех одержимых Twitch.

Связанный: Обзор PNY GeForce GTX 1660 Ti

Gigabyte GTX 1660 – Дизайн и разъемыЧестно говоря, Gigabyte GTX 1660 имеет довольно скучный дизайн. У этого есть черный пластиковый слой, который едва покрывает всю проводку и компоненты, набитые вместо этого. И хотя надпись «Gigabyte» написана ярким серебряным шрифтом как на задней, так и на передней панели фанатов, здесь немного другой личности. Но поскольку видеокарта, вероятно, будет спрятана в вашем оборудовании, это не так уж сложно.

И хотя надпись «Gigabyte» написана ярким серебряным шрифтом как на задней, так и на передней панели фанатов, здесь немного другой личности. Но поскольку видеокарта, вероятно, будет спрятана в вашем оборудовании, это не так уж сложно.

Как и его производительность, дизайн эффективен, хотя. Установка с двумя вентиляторами гарантирует, что карта никогда не станет слишком горячей, с рекордно низкой температурой записи 62 ° C.

Здесь также имеется достаточное количество подключений, с тремя предложениями для DisplayPort и одним для HDMI. Здесь нет порта DVI, но это не должно быть проблемой для большинства людей. GTX 1660 нуждается в восьмиконтактном разъеме питания PCle, чтобы получить все соки, поэтому он не так требователен, как, например, его более дорогой брат RTX 2080 Ti.

Похожие: Лучшие игровые мониторы 2019 года

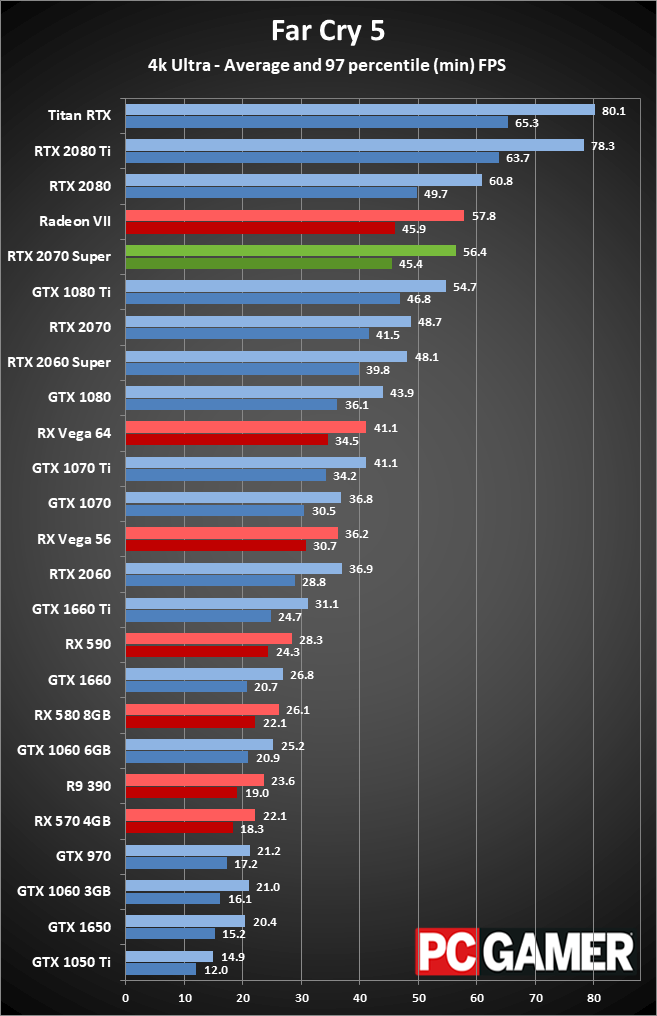

Gigabyte GTX 1660 – производительность и тестыGigabyte GTX 1660 предлагает фантастическую производительность Full HD, учитывая его доступную цену. В каждом тесте, который мы запускали, он показывал лучшие результаты кадра, чем GTX 1060, и даже приближался к тому, чтобы время от времени толкать GTX 1070.

В каждом тесте, который мы запускали, он показывал лучшие результаты кадра, чем GTX 1060, и даже приближался к тому, чтобы время от времени толкать GTX 1070.

Во всех играх, кроме самых печально известных GPU, GTX 1660 способен воспроизводить игры со скоростью 60 кадров в секунду в Full HD. Эта производительность достаточно высока для всех, кроме самых конкурентоспособных киберспортсменов. Здесь есть только одна проблема: GTX 1660 Ti предлагает лучшую производительность и не стоит так дорого.

Я также протестировал видеокарты GTX 1060 (Founders Edition), GTX 1660 Ti (PNY) и GTX 1070 (MSI), чтобы лучше понять, как GTX 1660 выдерживает конкуренцию.

Методология тестирования

Таким образом, вы точно знаете, какую систему я использовал при тестировании Gigabyte GTX 1660, ниже я перечислил компоненты. Это тоже самое Надежные Отзывы оснастка, которую я использую для всех наших последних обзоров видеокарт:

* Примечание редактора: Я не включал карты AMD Vega, RX590 и RX580, потому что в настоящее время у меня нет сэмплов. Я обновлю этот обзор, как только получу их обратно.

Тень Расхитительницы Гробниц

Я использовал Shadow of the Tomb Raider для наших тестов, так как это одна из самых потрясающих игр AAA, доступных на данный момент. Поскольку Nvidia утверждает, что любой из ее графических процессоров, использующих архитектуру TU116, может получить повышение производительности благодаря передовой технологии затенения, еще более важно использовать современные видеоигры для тестирования здесь.

Gigabyte GTX 1660 обеспечивает производительность 69 кадров в секунду с предустановкой графики «Высочайшее» и разрешением Full HD. Он находится почти посередине между GTX 1060 и GTX 1660 Ti, что имеет смысл, учитывая названия и характеристики. Вероятно, улучшения недостаточно для того, чтобы заставить владельцев GTX 1060 перейти на модернизацию, но сейчас это, безусловно, лучший вариант для тех, кому еще предстоит сделать прыжок на видеокарты 10-й серии.

Результаты для Quad HD и 4K не настолько убедительны. Это не удивительно – GTX 1660 позиционируется как бюджетный Full HD GPU. Вам нужно будет заплатить немного больше, чтобы запустить современные игры с превосходным разрешением.

Ghost Recon Wildlands

Ghost Recon Wildlands – одна из самых требовательных к видеоиграм видеокарт, и она не оптимизирована для аппаратного обеспечения Nvidia, так что не слишком шокирует тот факт, что Gigabyte GTX 1660 борется с ней. Он, безусловно, по-прежнему воспроизводится в Full HD со скоростью 44 кадра в секунду, но производительность, безусловно, не идеальна.

Это ничем не отличается от других видеокарт по этой цене: GTX 1660 Ti управляет только дополнительными 5 кадр / с в среднем, в то время как GTX 1070 ограничен увеличением на 6 кадр / с. Положительным моментом здесь является то, что немногие другие игры будут такими же интенсивными, как этот шутер с открытым миром, и тот факт, что GTX 1660 способен на все это, по-прежнему является большим плюсом.

Даже не думайте о том, чтобы играть в Wildlands в Quad HD или 4K с GTX 1660, хотя производительность при такой низкой средней частоте кадров выглядит нестабильной. Если вы собираетесь часто играть в Wildlands, я рекомендую выбрать более дорогую видеокарту.

Грязное ралли

Я всегда включаю Dirt Rally в наши тесты, так как это отличный пример игры AAA, выпущенной несколько лет назад. Это означает, что высокий результат теста должен указывать на то, что рассматриваемый графический процессор является хорошим вариантом для игры через ваше отставание.

GTX 1660 показал среднюю производительность 96 кадров в секунду в тесте производительности в игре. Это отличный результат, с разницей всего в 2 кадра в секунду, отделяющей его от более дорогого GTX 1660 Ti. С этими результатами я ожидаю, что GTX 1660 пробьет любую видеоигру, выпущенную более 4 лет назад.

Результаты в Quad HD также были впечатляющими при скорости 71 кадр / с, достигнув скорости 60 кадров в секунду по золотому стандарту. Единственным недостатком здесь является то, что производительность все еще невелика в 4K, но просить бюджетную видеокарту преуспеть в Ultra HD немного несправедливо.

Apex Legends

Nvidia очень стремилась донести свою точку зрения по этой видеокарте, используя архитектуру TU116, чтобы оптимизировать ее для игр типа «битва-рояль», таких как Fortnite, PlayerUnknown’s Battlegrounds и Apex Legends. Я выбрал последний из трех, так как это самая последняя выпущенная игра.

GTX 1660 Ti был способен на невероятную производительность 120 кадров в секунду при воспроизведении Apex Legends в Full HD при максимальных настройках графики. GTX 1660 довольно далеко от этого замечательного достижения со средней частотой кадров 100 кадров в секунду, но все же способен превзойти результат GTX 1070 на 5 кадров в секунду, что очень впечатляет. GTX 1660 также способен работать в Quad HD с производительностью 65 кадров в секунду.

Обратите внимание, что, поскольку у Apex нет собственного теста в игре, мне пришлось вычислять среднее значение с помощью наложенного счетчика частоты кадров. Этот метод не является самым надежным решением, но, по крайней мере, он предоставляет фигуру из реальной игры, а не симулированную программу.

3DMark Fire Strike Ultra

Результаты тестов, найденные в игре, безусловно, лучший способ оценить производительность видеокарты, но также полезно посмотреть, какие цифры получаются с помощью специального программного обеспечения для тестирования производительности. Fire Strike Ultra от 3DMark моделирует видеоигру, а затем видит конечный результат, который можно сравнить с другими картами.

Результат GTX 1660 – 2842 – выглядит довольно скромно, даже GTX 1060 может похвастаться более высоким показателем 3021, который не совпадает со всеми результатами тестов в игре. Вероятно, это связано с тем, что архитектура TU116 значительно повышает производительность благодаря технологиям интеллектуального шейдинга, что, вероятно, не учитывается в этих смоделированных тестах. В конце концов, GTX 1660 – это эффективность, а не чистая мощность.

Эта эффективность дополнительно подтверждается результатом пиковой потребляемой мощности GTX 1660 в 171,9 Вт. Это самый низкий показатель в тесте, что является отличной новостью для снижения затрат при покупке блока питания.

Пиковая температура, тем временем, достигает 62 ° C, что соответствует всем другим видеокартам Nvidia в этом тесте. При такой низкой пиковой температуре вам не нужно беспокоиться о выжигании этого графического процессора – если, конечно, вы не начнете заниматься разгоном.

Связанный: Лучший игровой компьютер 2019

Gigabyte GeForce GTX 1660 – разгонРанее я обнаружил, что видеокарты с архитектурой Turing не очень открыты для разгона, а Nvidia уже выжимает как можно больше производительности. GTX 1660, похоже, отражает эту тенденцию, поскольку мне удалось увеличить тактовые частоты на 200 МГц. Когда я попытался разогнать его дальше, программа Unigine стала нестабильной и даже зависала.

Интересно, что разгон на 200 МГц привел только к увеличению производительности на 4 к / с. Это разочаровывает, до такой степени, что я лично не думаю, что это стоит того, чтобы пройти через это усилие. Тем не менее, у меня были временные ограничения при попытке разогнать GTX 1660, поэтому более профессиональные оверклокеры, скорее всего, увидят улучшенные результаты, хотя я сомневаюсь со значительным отрывом.

Зачем покупать Gigabyte GTX 1660?Gigabyte GTX 1660 – это еще один большой триумф архитектуры TU116, который является фантастической видеокартой для HD-игр. Благодаря своей высокой производительности и конкурентоспособной цене, GTX 1660 делает GTX 1060 избыточным.

Предлагает ли GTX 1660 достаточный скачок производительности, чтобы владельцы GTX 1060 стоили его обновить? На самом деле, нет. Но это превосходная новая возможность для начинающих покупателей или для тех, кто еще не перешел на карту серии 900.

Эта карта особенно хороша для поклонников Battle Royale: GTX 1660 обеспечивает производительность, аналогичную GTX 1070, несмотря на то, что последняя значительно дороже.

Единственное, что я сомневаюсь в GTX 1660, это то, что он может быть оценен слишком близко к GTX 1660 Ti. Я по-прежнему считаю, что последний предлагает лучшее соотношение цены и качества Full HD, поэтому невероятно заманчиво потратить дополнительные 60 фунтов стерлингов на лучшую производительность. Но если вы рассчитываете быть безжалостными с вашим бюджетом при создании новой системы, то GTX 1660 по-прежнему является безусловно фантастическим вариантом.

решение судаGigabyte GTX 1660 предлагает превосходную ценность для игр Full HD, но вы можете испытать соблазн потратить немного больше на чуть более мощный GTX 1660 Ti.

Nvidia NVLink против SLI — различия и сравнение

С тех пор, как стало возможным использовать несколько видеокарт в системе, мы видели, как энтузиасты жаждут чудовищных машин с двумя, тремя или даже четырьмя видеокартами, установленными в них одновременно. ПК с несколькими видеокартами считались самым лучшим, что могла предложить отрасль. Мы даже видели, как несколько графических процессоров были втиснуты в одни и те же видеокарты с такими картами, как Nvidia GeForce GTX 690 и AMD R9 295 × 2. Но при всей этой шумихе и славе системы с несколькими графическими процессорами, похоже, никогда не получили успеха. Их популярность быстро и резко упала вскоре после пика популярности систем с несколькими графическими процессорами. Это снижение было связано с несколькими факторами, и одним из них была ненадежность мостовой системы, которая использовалась для соединения видеокарт друг с другом.

Две видеокарты Nvidia GeForce GTX 1080 в SLI – Изображение: NvidiaТехника Nvidia для соединения двух или более видеокарт друг с другом была известна как SLI, что означает Scalable Link Interface. Это была технология, которую Nvidia купила у 3dfx Interactive, которая представила ее в 1998 году. По сути, SLI – это торговая марка технологии Nvidia с несколькими графическими процессорами, созданная для соединения двух или более видеокарт в один выход с использованием алгоритма параллельной обработки. AMD, конкурент Nvidia, также представила свою версию технологии, известную как Crossfire.

Как работает SLI?

Видеокарты в системе SLI работают в конфигурации главный-подчиненный, что означает, что одной из карт назначается роль «мастера», несмотря на то, что нагрузка равномерно распределяется между всеми картами. Когда «подчиненная» карта завершает рендеринг, она отправляет свои выходные данные мастеру, который затем объединяет два рендеринга и доставляет выходное изображение на монитор. В конфигурации с двумя картами главная карта обычно обрабатывает верхнюю половину изображения, а подчиненная карта обрабатывает нижнюю половину.

Как работает SLI – Изображение: Linus Tech TipsДве (или более) карты подключаются через мост SLI или коннектор SLI. Основное назначение моста SLI – установить соединение между картами и позволить картам установить канал связи между ними. Несмотря на то, что без SLI Bridge можно запускать несколько карт, есть несоответствие спецификаций, и обычно результаты очень плохие. SLI Bridge снижает ограничения полосы пропускания и может отправлять данные напрямую между картами. Три типа мостов SLI:

- Стандартный мост (частота пикселей 400 МГц, пропускная способность 1 ГБ / с): это стандартный мост, входящий в комплект поставки материнских плат, поддерживающих SLI до 1920 × 1080 и 2560 × 1440 при 60 Гц.

- Светодиодный мост (частота пикселей 540 МГц): рекомендуется для мониторов с разрешением до 2560 × 1440 при 120 Гц + и 4K. Он может работать только с увеличенной частотой пикселей, если графический процессор поддерживает эту частоту. Он продается Nvidia, а также рядом партнеров AIB.

- Мост с высокой пропускной способностью или мост SLI HB (тактовая частота пикселей 650 МГц и пропускная способность 2 ГБ / с): это самый быстрый мост, который продается исключительно Nvidia. Рекомендуется для мониторов до 5K и объемного звучания. Мосты SLI HB доступны только в двухполосных конфигурациях, поэтому установка с более чем двумя картами здесь не удалась.

Механизм действия SLI

SLI работает двумя основными способами. Один из них – это SFR или рендеринг с разделением кадров, при котором система анализирует визуализированное изображение, чтобы разделить нагрузку между графическими процессорами, подключенными в SLI. Рамка разделена на две части горизонтальной линией. Размещение линии зависит от геометрии сцены. Основным решающим фактором при размещении линии будет сложность нагрузки, которую сцена требует в различных областях. Если одна из карт визуализирует верхнюю часть сцены, на которой есть небо, тогда линия будет ниже на изображении, чтобы компенсировать разницу в загрузке между двумя картами.

Другой способ работы SLI – это AFR или рендеринг альтернативного кадра, который довольно прост. В этом методе каждый второй кадр обрабатывается другим графическим процессором. Одна из карточек отображает все нечетные кадры, а другая – все четные. Доказано, что AFR имеет лучшую частоту кадров, чем SFR, однако он вводит новую форму артефактов, известную как микро заикание. Даже если частота кадров достаточно высока, микрорельефы могут повлиять на воспринимаемую гладкость изображения из-за небольших заиканий между кадрами из-за переменного темпа, с которым карты работают в AFR.

Взлет и падение SLI

Популярность SLI резко возросла во время серии видеокарт Kepler, Maxwell и Pascal, но с тех пор она постоянно и резко снижается. Даже в эпоху серии видеокарт GTX 1000 от Nvidia популярность SLI падала. Конечно, видеокарты SLI могут обеспечить лучшую производительность, чем одиночный графический процессор, и даже выглядят фантастически при установке в корпус, но в первую очередь у SLI было больше проблем, чем преимуществ.

Прежде всего, вам нужно было проверить, поддерживает ли ваша материнская плата SLI. Это был жизненно важный шаг, поскольку некоторые материнские платы поддерживали SLI, некоторые поддерживали Crossfire, а некоторые поддерживали и то, и другое, а другие не поддерживали ни одного. После этого у вас должны были быть идентичные видеокарты. Это было непросто, так как это сделало ценовое предложение действительно искаженным по сравнению с более производительной одиночной видеокартой. Видеокарты должны были быть одной и той же модели и серии и даже одного производителя ранее, однако позже это было несколько облегчено. Для работы с несколькими видеокартами также требовался мощный и дорогой блок питания (о котором вы можете узнать больше прямо здесь), а также необходимо было отслеживать и контролировать термические характеристики из-за того, что несколько энергоемких карт работали в непосредственной близости друг от друга.

Для запуска такой установки SLI требуется много энергии – Изображение: GPUMagНастоящей ахиллесовой пятой всей экосистемы SLI была игровая поддержка. Не все игры поддерживали SLI, и даже те, которые поддерживали, дали не впечатляющий прирост производительности, если учесть дополнительные вложения. В большинстве случаев вам было бы намного лучше купить более мощную одиночную видеокарту, чем две более слабые и установить их в SLI. С годами поддержка SLI стала еще хуже, и разработчики редко задумываются об этом в современных играх. Наконец, смертельный удар был нанесен не кем иным, как самой Nvidia, которая прекратила поддержку SLI большинством своих графических карт. Что касается линейки графических процессоров Turing, только лучшая из лучших, RTX 3090, поддерживает SLI. Это означает, что SLI для обычных потребителей практически мертв в том, что касается игр.

Что такое NVLink?

В линейке видеокарт Turing Nvidia представила новую технологию для подключения нескольких видеокарт, известную как NVLink. Это интерфейс, пропускная способность которого во много раз превышает пропускную способность старого интерфейса SLI, а также имеет множество дополнительных особенностей и функций. С технической точки зрения, это последовательный многополосный канал связи ближнего действия с протоколом проводной связи. Непросто, не правда ли? В более общем плане, это улучшенный интерфейс связи между несколькими видеокартами Nvidia, который обещает больше преимуществ и функций, чем старый SLI.

NVLink обещает значительный скачок пропускной способности – Изображение: NvidiaNVLink можно рассматривать как попытку Nvidia вернуть себе долю рынка мульти-графических процессоров, которая сократилась в 2020 году. Эта технология обещает сделать игры с использованием нескольких видеокарт желательным и высокоэффективным методом в ближайшем будущем. NVLink по сути является гораздо более быстрым мостом, чем SLI, и призван сократить разрыв в задержках между двумя видеокартами. Директор по техническому маркетингу Nvidia Том Петерсон говорит по этому поводу следующее:

«Этот мост виден играм, а это значит, что, возможно, будет приложение, которое смотрит на один графический процессор, а смотрит на другой и делает что-то еще», – объясняет Петерсен. «Проблема с вычислениями с несколькими графическими процессорами заключается в том, что задержка от одного графического процессора к другому очень велика. Он должен проходить через PCIe, он должен проходить через память, это очень большое расстояние с точки зрения транзакции »…» NVLink все это исправляет. Таким образом, NVLink значительно снижает задержку передачи данных от графического процессора к графическому процессору. Так что дело не только в пропускной способности, а в том, насколько мне близка память этого графического процессора. Этот графический процессор, который находится по ссылке … Я могу думать об этом как о своем брате, а не как о дальнем родственнике ».

Он также добавил, что NVLink был скорее планом на будущее, чем текущим решением:

«Думайте о мосте больше, поскольку мы хотим заложить фундамент для будущего»… »И как только это сработает, и мы развернем мосты, и люди поймут, что это мост со скоростью 100 ГБ / с, разработчики игр будут видеть, что.”

Похоже, что Nvidia на самом деле делает ставку на будущее NVLink, а не на настоящее. Nvidia знает, что поддержка нескольких графических процессоров на данный момент довольно разочаровывает, поэтому они хотят представить технологию, которая будет пытаться не только изменить точку зрения разработчиков игр, но и взгляды обычных потребителей на использование нескольких графических процессоров. поддерживать.

Как работает NVLink?

В отличие от SLI, NVLink использует ячеистую сеть, которая представляет собой топологию сети, в которой узлы инфраструктуры подключаются напрямую неиерархическим способом. Это позволяет ретранслировать информацию каждым узлом индивидуально, а не маршрутизировать через один конкретный узел. Это также позволяет узлам динамически самоорганизовываться, что позволяет динамически распределять рабочие нагрузки. NVLink черпает свою главную силу в этом механизме, а именно в его скорости.

NVLink также покончил с отношением «главный-подчиненный» в реализации SLI, вместо этого он обрабатывает каждый узел одинаково, что значительно улучшает скорость рендеринга. В отличие от SLI, NVLink имеет то преимущество, что память обеих видеокарт всегда доступна. Это связано с невероятной реализацией NVLink в ячеистой сети. По сути, связь карт NVLink является двунаправленной, и две подключенные карты действуют как одна.

Как работает NVLink – Изображение: Linus Tech TipsСкорость интерфейса NVLink отражается на пропускной способности его мостов. В то время как даже лучшие мосты SLI имели пропускную способность в лучшем случае 2 ГБ / с, мост NVLink в некоторых случаях обещает ошеломляющие 200 ГБ / с. Конечно, мосты NVLink на 160 и 200 ГБ / с ограничены графическими процессорами профессионального уровня Nvidia Quadro GP100 и GV100 соответственно, но эти цифры по-прежнему свидетельствуют о невероятном скачке пропускной способности интерфейса NVLink по сравнению с SLI. Графические процессоры для энтузиастов высшего уровня, такие как TITAN RTX или 2080Tis, в большинстве случаев могут рассчитывать на потенциальную пропускную способность колоссальных 100 ГБ / с.

Стоит ли NVLink?

Итак, NVLink от Nvidia наконец-то устранил проблемы рендеринга на нескольких GPU в играх? Что ж, ответ по-прежнему отрицательный. Хотя NVLink добилась некоторых положительных успехов в правильном направлении, особенно в методе, в котором обе карты используются по сравнению с SLI, проблема SLI никогда не заключалась в методологии. Настоящая проблема экосистемы с несколькими GPU – поддержка игр. Даже с NVLink большинству современных игр сложно использовать более одного графического процессора. Принимая во внимание стоимость двух видеокарт и незначительное улучшение производительности в большинстве сценариев, было бы неразумно инвестировать в NVLink для потребительских приложений, таких как игры.

NVLink против SLI Bridge – Изображение: NvidiaДля профессиональной работы NVLink может быть просто необходимостью обновления. Для людей, работающих с графическими процессорами Nvidia Quadro или такими картами, как RTX A6000, NVLink может быть большим подспорьем не только в повышении производительности рендеринга, но и благодаря тому факту, что NVLink позволяет получить доступ к общей памяти обеих карт, что может быть огромная помощь в профессиональных нагрузках.

Однако для большинства геймеров выбор одной видеокарты, которая предлагает более высокую производительность, является лучшей идеей, чем покупка двух более слабых карт и подключение их через NVLink или SLI, если на то пошло.

Заключительные слова

SLI от Nvidia была интересной и привлекательной технологией, когда она была впервые запущена и вскоре приобрела популярность благодаря своему потенциалу и довольно приличной поддержке со стороны разработчиков в эпоху Максвелла и Паскаля. Однако пик популярности SLI был недолгим, поскольку индустрия быстро двигалась вперед, а SLI остался в прошлом, и как разработчики, так и геймеры отказались от технологии в пользу более мощных графических процессоров.

Nvidia попыталась заново изобрести рынок нескольких графических процессоров, запустив NVLink, который представляет собой значительно улучшенное соединение по сравнению с SLI, но, тем не менее, он не может решить многие проблемы, которые в первую очередь мешают SLI. Это делает его жесткой рекомендацией для геймеров в 2020 году, когда более мощные одиночные видеокарты могут обеспечить лучший опыт надежно и по более низкой цене.

Обзор видеокарты NVIDIA Geforce GTX 880M

| GeForce 800M Series | |

| Кодовое имя | Kepler (GK) или Maxwell (GM) |

| Дата релиза | 12 марта 2014[1] |

| GPU начального уровня | GeForce 800M, GeForce 820M, GeForce 830M, GeForce 840M |

| GPU среднего диапазона | GeForce GTX 850M, GeForce GTX 860M |

| Топовые GPU | GeForce GTX 870M, GeForce GTX 880M |

| Версия Direct3D и шейдеров | полная поддержка Direct3D 11.0 и частичная Direct3D 12.0[2][3] |

| Версия OpenGL | OpenGL 4.5[4] |

| Версия OpenCL | OpenCL 1.1 |

| Вариант | GeForce 700 Series |

| Преемник | GeForce 900 Series |

GeForce 800M Series

— семейство графических процессоров Nvidia, используемых в ноутбуках. Название серии GeForce 800 изначально планировалось использовать как мобильных чипов, так и для настольных. Планировалось использовать микроархитектуру Maxwell, которая была ранее использована в некоторых GPU GeForce 700 Series, а именно в GTX 750 и GTX 750 Ti, выпущенных 8 февраля 2014 года. Тем не менее, поскольку мобильные графические процессоры GeForce 800M Series уже были выпущены с использованием архитектуры Kepler, Nvidia решила переименовать свои графические процессоры GeForce 800 для настольных компьютеров в GeForce 900 Series.

Краткие характеристики

Этот видеочип, получивший кодовое название N15V-GM, с самого начала позиционировался как бюджетный вариант, не рассчитанный на игровые программы. Однако, несмотря на это, он получил вполне неплохие характеристики, позволяющие справляться и с довольно трудоемкими задачами.

Так, его основой служит ядро GF117, выполненное по 28-нанометровому техпроцессу. Это обеспечивает низкий уровень нагрева, что положительно сказывается при использовании в ноутбуках и неттопах ввиду потребности в компактной системе охлаждения, неспособной рассеивать большое количество выделяемого тепла.

Ядро GF117 представляет из себя комбайн, состоящий из 96 шейдеров, которые, говоря профессиональным языком, называются CUDA-ядрами. Они принимают на себя основной удар, когда речь идет о работе с трехмерной графикой. В дополнение к ним задействуются 16 текстурных ядер, а также 8 растровых, что в общем дает приемлемую по бюджетным меркам производительность.

Все ядра работают на общей частоте в 775 МГц, что, к сожалению, явно не вписывается в современные стандарты производительности. Дополняет картину 64-битная шина памяти, которая сразу дает понять, что с последними играми видеокарта может и не справиться, однако, в данном случае стоит экспериментировать, ведь все зависит от конкретной ситуации и остальных компонентов ноутбука. Доукомплектовывается чип 1 Гб памяти стандарта DDR3.

Радует наличие поддержки таких распространенных протоколов, как DirectX 11, Optimus, OpenCL 1.1, OpenGL 4.4 и Pixel Shader 5.0. Графическое ядро может обмениваться данными с памятью на скорости до 14,4 Гб в секунду. Максимальная мощность графического ускорителя составляет 15 Вт.

Отрывок, характеризующий GeForce 800M

– Они! Нет, это не Мытищи, это дале. – Глянь ка, точно в Москве. Двое из людей сошли с крыльца, зашли за карету и присели на подножку. – Это левей! Как же, Мытищи вон где, а это вовсе в другой стороне. Несколько людей присоединились к первым. – Вишь, полыхает, – сказал один, – это, господа, в Москве пожар: либо в Сущевской, либо в Рогожской. Никто не ответил на это замечание. И довольно долго все эти люди молча смотрели на далекое разгоравшееся пламя нового пожара. Старик, графский камердинер (как его называли), Данило Терентьич подошел к толпе и крикнул Мишку. – Ты чего не видал, шалава… Граф спросит, а никого нет; иди платье собери. – Да я только за водой бежал, – сказал Мишка. – А вы как думаете, Данило Терентьич, ведь это будто в Москве зарево? – сказал один из лакеев. Данило Терентьич ничего не отвечал, и долго опять все молчали. Зарево расходилось и колыхалось дальше и дальше. – Помилуй бог!.. ветер да сушь… – опять сказал голос. – Глянь ко, как пошло. О господи! аж галки видно. Господи, помилуй нас грешных! – Потушат небось. – Кому тушить то? – послышался голос Данилы Терентьича, молчавшего до сих пор. Голос его был спокоен и медлителен. – Москва и есть, братцы, – сказал он, – она матушка белока… – Голос его оборвался, и он вдруг старчески всхлипнул. И как будто только этого ждали все, чтобы понять то значение, которое имело для них это видневшееся зарево. Послышались вздохи, слова молитвы и всхлипывание старого графского камердинера. Камердинер, вернувшись, доложил графу, что горит Москва. Граф надел халат и вышел посмотреть. С ним вместе вышла и не раздевавшаяся еще Соня, и madame Schoss. Наташа и графиня одни оставались в комнате. (Пети не было больше с семейством; он пошел вперед с своим полком, шедшим к Троице.) Графиня заплакала, услыхавши весть о пожаре Москвы. Наташа, бледная, с остановившимися глазами, сидевшая под образами на лавке (на том самом месте, на которое она села приехавши), не обратила никакого внимания на слова отца. Она прислушивалась к неумолкаемому стону адъютанта, слышному через три дома. – Ах, какой ужас! – сказала, со двора возвративись, иззябшая и испуганная Соня. – Я думаю, вся Москва сгорит, ужасное зарево! Наташа, посмотри теперь, отсюда из окошка видно, – сказала она сестре, видимо, желая чем нибудь развлечь ее. Но Наташа посмотрела на нее, как бы не понимая того, что у ней спрашивали, и опять уставилась глазами в угол печи. Наташа находилась в этом состоянии столбняка с нынешнего утра, с того самого времени, как Соня, к удивлению и досаде графини, непонятно для чего, нашла нужным объявить Наташе о ране князя Андрея и о его присутствии с ними в поезде. Графиня рассердилась на Соню, как она редко сердилась. Соня плакала и просила прощенья и теперь, как бы стараясь загладить свою вину, не переставая ухаживала за сестрой. – Посмотри, Наташа, как ужасно горит, – сказала Соня. – Что горит? – спросила Наташа. – Ах, да, Москва. И как бы для того, чтобы не обидеть Сони отказом и отделаться от нее, она подвинула голову к окну, поглядела так, что, очевидно, не могла ничего видеть, и опять села в свое прежнее положение. – Да ты не видела? – Нет, право, я видела, – умоляющим о спокойствии голосом сказала она. И графине и Соне понятно было, что Москва, пожар Москвы, что бы то ни было, конечно, не могло иметь значения для Наташи. Граф опять пошел за перегородку и лег. Графиня подошла к Наташе, дотронулась перевернутой рукой до ее головы, как это она делала, когда дочь ее бывала больна, потом дотронулась до ее лба губами, как бы для того, чтобы узнать, есть ли жар, и поцеловала ее. – Ты озябла. Ты вся дрожишь. Ты бы ложилась, – сказала она. – Ложиться? Да, хорошо, я лягу. Я сейчас лягу, – сказала Наташа. С тех пор как Наташе в нынешнее утро сказали о том, что князь Андрей тяжело ранен и едет с ними, она только в первую минуту много спрашивала о том, куда? как? опасно ли он ранен? и можно ли ей видеть его? Но после того как ей сказали, что видеть его ей нельзя, что он ранен тяжело, но что жизнь его не в опасности, она, очевидно, не поверив тому, что ей говорили, но убедившись, что сколько бы она ни говорила, ей будут отвечать одно и то же, перестала спрашивать и говорить. Всю дорогу с большими глазами, которые так знала и которых выражения так боялась графиня, Наташа сидела неподвижно в углу кареты и так же сидела теперь на лавке, на которую села. Что то она задумывала, что то она решала или уже решила в своем уме теперь, – это знала графиня, но что это такое было, она не знала, и это то страшило и мучило ее.

Применение видеочипа

Производители ноутбуков активно используют данную видеокарту в своих разработках. Так, сейчас довольно сложно найти марку, которая бы не выпускала ноутбуки или неттопы с такими популярными мобильными процессорами, как Intel 3700, Intel 1900 и другими. Именно для них и предназначался этот дискретный видеочип. Хотя процессоры и оснащены графикой Intel HD, ее производительность значительно ниже, и в случае с игровыми программами необходимость дополнительного мощного графического чипа просто очевидна.

Преимущества

Чем GeForce GTX 760M лучше?

| Лучше оценка PassMark | 1,394 | vs | 573 | Приблизительно в 2.5x раз лучше оценка PassMark |

| Выше эффективная тактовая частота памяти | 4,008 MHz | vs | 1,800 MHz | Приблизительно в 2.2x раз выше эффективная тактовая частота памяти |

| Гораздо лучше тест T-Rex | 3,356.92 | vs | 1,601.66 | Больше чем в 2x раз лучше тест T-Rex |

| Выше пропускная способность памяти | 64.1 GB/s | vs | 14.4 GB/s | Приблизительно в 4.5x раз выше пропускная способность памяти |

| Больше памяти | 2,048 MB | vs | 1,024 MB | В 2x раз больше памяти |

| Лучше производительность с плавающей запятой | 964.6 GFLOPS | vs | 141.7 GFLOPS | Больше чем в 6.8x раз лучше производительность с плавающей запятой |

| Существенно больше блоков текстурирования | 64 | vs | 8 | На 56 больше блоков текстурирования |

| Выше скорость проработки текстур | 40.2 GTexel/s | vs | 5.9 GTexel/s | Больше чем в 6.8x раз выше скорость проработки текстур |

| Существенно лучше рейтинг построения видео | 30.42 frames/s | vs | 7.25 frames/s | Приблизительно в 4.2x раз лучше рейтинг построения видео |

| Больше шейдерных блоков | 768 | vs | 48 | На 720 больше шейдерных блоков |

| Выше скорость пиксельного заполнения | 10.05 GPixel/s | vs | 1.48 GPixel/s | Больше чем в 6.8x раз выше скорость пиксельного заполнения |

| Больше блоков растровых операций | 16 | vs | 8 | В два раза больше блоков растровых операций |

| Шире шина памяти | 128 bit | vs | 64 bit | В 2x раз шире шина памяти |

| Выше тактовая частота памяти | 1,002 MHz | vs | 900 MHz | Больше чем на 10% выше тактовая частота памяти |

Чем GeForce 800M лучше?

| Выше тактовая частота | 738 MHz | vs | 628 MHz | Приблизительно на 20% выше тактовая частота |

| Ниже энергопотребление | 15W | vs | 55W | В 3.7x раз ниже энергопотребление |

Прямые конкуренты

Сложно сказать, какие именно видеочипы будут прямыми конкурентами этой модели, поскольку большинство бюджетников обладают подобными характеристиками. Все же, постаравшись выбрать некоторые из них, можно составить небольшой список.

Так, среди решений производства компании AMD таковым можно считать чип R7 M265, получивший подобные данные. Однако, по количеству шейдеров он значительно превосходит разбираемую модель GeForce 810M. Среди вариантов прошлых лет выделяются такие чипы, как Intel Iris Pro Graphics, причем почти весь их модельный ряд.

Относительно цен сделать вывод сложно, поскольку данные чипы не являются самостоятельным продуктом, а применяются только в готовых мобильных компьютерах, в которых основой ценообразования является политика компании-производителя. Здесь уже следует полагаться на собственные предпочтения относительно как фирмы-производителя самого ноутбука, так и разработчика графического чипа и процессора.

Разгон этого поколения видеочипов не предусмотрен, и, по сути, попросту невозможен, поскольку потенциала для данной операции нет как у самого чипа, так и у системы охлаждения. Стоит отметить, что в некоторых случаях может быть установлена даже пассивная СО, которая рассчитана впритык на базовое тепловыделение. Поэтому, даже если бы возможность разгона предусматривалась производителем, она была бы крайне нежелательной.

Сравнительные бенчмарки (benchmarks)

PassMark

| GeForce GTX 760M | 1,394 |

| GeForce 800M | 573 |

Майнинг Биткоина

| GeForce GTX 760M | 53.99 mHash/s |

| GeForce 800M | 15.22 mHash/s |

Распознавание лиц

| GeForce GTX 760M | 15.67 mPixels/s |

| GeForce 800M | 4.91 mPixels/s |

Моделирование поверхности океана

| GeForce GTX 760M | 510 frames/s |

| GeForce 800M | 109.13 frames/s |

Моделирование частиц

| GeForce GTX 760M | 167.8 mInteraction/s |

| GeForce 800M | 31.67 mInteraction/s |

Построение видео

| GeForce GTX 760M | 30.42 frames/s |

| GeForce 800M | 7.25 frames/s |

T-Rex (GFXBench 3.0)

| GeForce GTX 760M | 3,356.92 |

| GeForce 800M | 1,601.66 |

Тестирование видеочипа